電子發燒友網報道(文/周凱揚)從最近英偉達公布的財報中就可以看出,AI應用的火熱使其賺得盆滿缽滿,原本就在AI軟硬件生態稱王的英偉達,現今更是如日中天。而這樣的處境也讓不少AI芯片初創公司不好過,他們的產品有的還沒落地,有的則難以與A100、H100這樣的產品匹敵。這幾年沉寂下去的AI芯片初創公司著實不少,但還是有的廠商敢于繼續往這個市場里鉆。

水平擴展性的限制

隨著AI/ML的模型越來越大,甚至是以5年內翻4萬倍的速度提升,要想在硬件上跟上軟件進度已經越來越難了。可即便如此,從16nm到4nm,從低精度到脈動陣列,都給了我們巨大的優勢去追隨這些大模型。

但運行這些大模型終究不是靠單個芯片的力量,而是整個規模集群需要面臨的問題,所以這就牽扯到了水平擴展性。工藝制程的提高帶來了5倍的性能提升,芯片架構帶來了14倍的性能提升,而水平擴展則要實現600倍的性能提升,才能滿足未來的AI/ML計算要求。這也就是目前AI計算存在的問題,大模型往往需要更大的內存、更高的算力和更大的帶寬,隨著設備數量越多,這三大硬件要求的分配復雜程度就變得越來越高。

比如在GPU上就已經嘗試了不少并行擴展方案,比如數據并行、流水線模型并行或張量模型并行等,但以上方案往往都會受到內存、帶寬和參數量的限制,并沒有單一通用的解決方案,大模型往往需要同時結合這三種方案,所以擴展效率不高。AI芯片公司Cerebras則想出了一個在大規模集群下提高水平擴展性的解決方案。

Cerebras的WSE

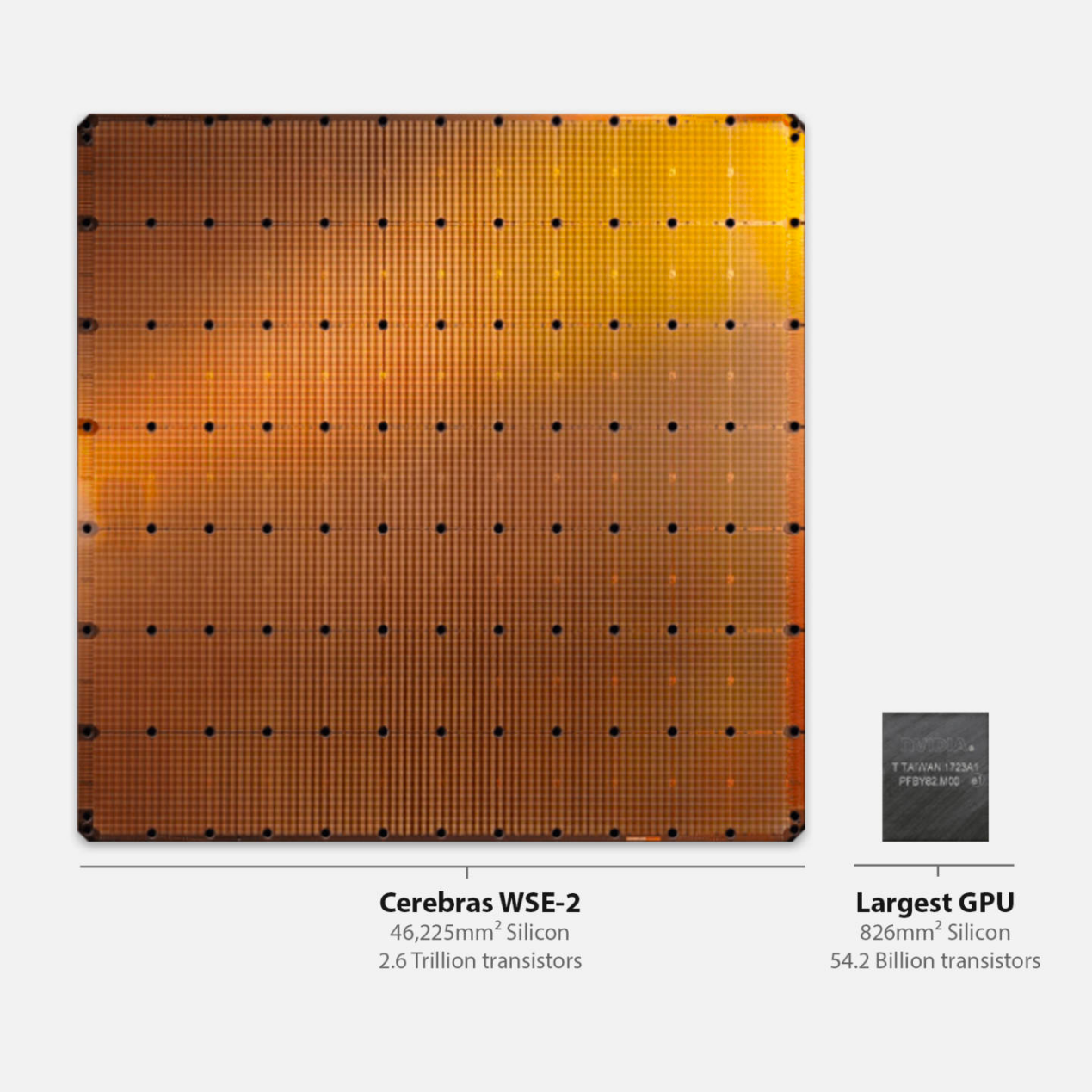

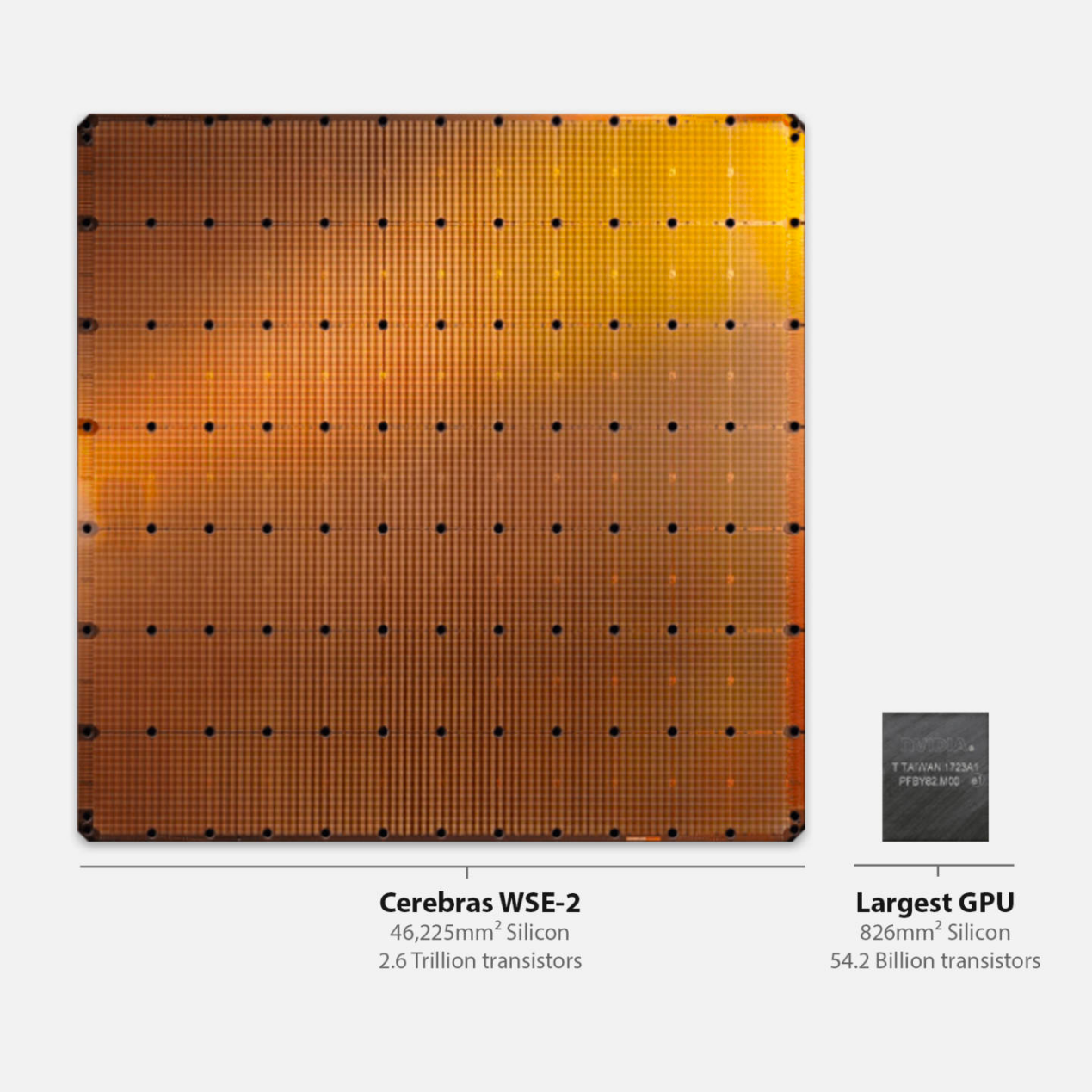

要說在AI芯片的初創公司里,走著獨立無二路線的公司,Cerebras絕對能排得上名號。2019年,他們推出了WSE,一個晶圓大小的AI處理器,到了2021年,他們又推出了第二代的WSE-2,采用更先進的工藝將單個處理器的核心數推進至85萬核。而這次Hot Chips上,他們則展示了用于對抗英偉達的解決方案。

WSE-2與GPU大小對比 / Cerebras

Cerebras選擇了將內存和計算解耦的方案,利用內存擴展技術MemoryX,將模型權重存儲在外部,然后將權重傳輸給WSE-2組成的CS-2系統,CS-2再將梯度傳給外部存儲。Cerebras還打造了一個互聯方案SwarmX,用于連接多個CS-2系統,從而提高擴展性。

以Cerebras搭建的Andromeda超算為例,該超算由16個CS-2系統組成,擁有1350萬個AI優化核心,稀疏算力高達1ExaFLOPs,稠密算力高達120PetaFLOPs。在這樣強大的算力下,訓練大模型只要幾周的時間。而且在Cerebras不同規模的集群上,不同參數的大模型可以共享同樣的代碼,以同樣的方式訓練,省去了不少開發時間。

除了Andromeda以外,Cerebras也已經開始了下一個AI超算的部署,由64個CS-2系統組成的Condor Galaxy 1,該超算的算力將擴展至4ExaFLOPs的稀疏算力。而Condor Galaxy 1名字后的1,也意味著這僅僅是單個超算中心所用的系統而已,未來他們計劃在2024年底之前擴展為9個超算中心,分布在美國各地,構建最大的分布式超算網絡,總算力高達36ExaFLOPs,是英偉達Israel-1超算的9倍,是谷歌最大TPUv4集群的4倍。

寫在最后

單從擴展性和性能的角度來看,Cerebras確實已經做到了一個新的高度。但對于購置這些GPU或AI芯片的云服務或互聯網公司來說,GPU或許是一個更加通用的資源,在AI技術日新月異的當下,GPU總能憑借自己的軟硬件生態快速找到自己的一席之地,并在高性能的王座上穩坐一段時間。這也就是AI爆款應用的市場導向決定的了,性能固然重要,但搶占先機才是最關鍵的一環。

水平擴展性的限制

隨著AI/ML的模型越來越大,甚至是以5年內翻4萬倍的速度提升,要想在硬件上跟上軟件進度已經越來越難了。可即便如此,從16nm到4nm,從低精度到脈動陣列,都給了我們巨大的優勢去追隨這些大模型。

但運行這些大模型終究不是靠單個芯片的力量,而是整個規模集群需要面臨的問題,所以這就牽扯到了水平擴展性。工藝制程的提高帶來了5倍的性能提升,芯片架構帶來了14倍的性能提升,而水平擴展則要實現600倍的性能提升,才能滿足未來的AI/ML計算要求。這也就是目前AI計算存在的問題,大模型往往需要更大的內存、更高的算力和更大的帶寬,隨著設備數量越多,這三大硬件要求的分配復雜程度就變得越來越高。

比如在GPU上就已經嘗試了不少并行擴展方案,比如數據并行、流水線模型并行或張量模型并行等,但以上方案往往都會受到內存、帶寬和參數量的限制,并沒有單一通用的解決方案,大模型往往需要同時結合這三種方案,所以擴展效率不高。AI芯片公司Cerebras則想出了一個在大規模集群下提高水平擴展性的解決方案。

Cerebras的WSE

要說在AI芯片的初創公司里,走著獨立無二路線的公司,Cerebras絕對能排得上名號。2019年,他們推出了WSE,一個晶圓大小的AI處理器,到了2021年,他們又推出了第二代的WSE-2,采用更先進的工藝將單個處理器的核心數推進至85萬核。而這次Hot Chips上,他們則展示了用于對抗英偉達的解決方案。

WSE-2與GPU大小對比 / Cerebras

Cerebras選擇了將內存和計算解耦的方案,利用內存擴展技術MemoryX,將模型權重存儲在外部,然后將權重傳輸給WSE-2組成的CS-2系統,CS-2再將梯度傳給外部存儲。Cerebras還打造了一個互聯方案SwarmX,用于連接多個CS-2系統,從而提高擴展性。

以Cerebras搭建的Andromeda超算為例,該超算由16個CS-2系統組成,擁有1350萬個AI優化核心,稀疏算力高達1ExaFLOPs,稠密算力高達120PetaFLOPs。在這樣強大的算力下,訓練大模型只要幾周的時間。而且在Cerebras不同規模的集群上,不同參數的大模型可以共享同樣的代碼,以同樣的方式訓練,省去了不少開發時間。

除了Andromeda以外,Cerebras也已經開始了下一個AI超算的部署,由64個CS-2系統組成的Condor Galaxy 1,該超算的算力將擴展至4ExaFLOPs的稀疏算力。而Condor Galaxy 1名字后的1,也意味著這僅僅是單個超算中心所用的系統而已,未來他們計劃在2024年底之前擴展為9個超算中心,分布在美國各地,構建最大的分布式超算網絡,總算力高達36ExaFLOPs,是英偉達Israel-1超算的9倍,是谷歌最大TPUv4集群的4倍。

寫在最后

單從擴展性和性能的角度來看,Cerebras確實已經做到了一個新的高度。但對于購置這些GPU或AI芯片的云服務或互聯網公司來說,GPU或許是一個更加通用的資源,在AI技術日新月異的當下,GPU總能憑借自己的軟硬件生態快速找到自己的一席之地,并在高性能的王座上穩坐一段時間。這也就是AI爆款應用的市場導向決定的了,性能固然重要,但搶占先機才是最關鍵的一環。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

AI

+關注

關注

87文章

31097瀏覽量

269430 -

英偉達

+關注

關注

22文章

3791瀏覽量

91313

發布評論請先 登錄

相關推薦

英偉達超越蘋果成為市值最高 英偉達取代英特爾加入道指

蘋果公司的市值,重新成為全球市值最高的公司。 在AI領域,英偉達正瘋狂奔跑,我們看到有外媒報道英偉

AI芯片巨頭英偉達漲超4% 英偉達市值暴增7500億

誰是美股最靚的仔?在人工智能浪潮之下AI芯片巨頭英偉達肯定有一席之地,特別是現在全球資本市場動蕩之際,業界分析師多認為英偉

英偉達收購軟件初創公司Shoreline

近日,全球知名的圖形處理器制造商英偉達(NVIDIA)宣布了一項重要的收購計劃,將以約1億美元的價格收購軟件初創公司Shoreline。這次收購不僅體現了

英偉達擬收購軟件初創公司Shoreline,強化AI軟件生態

近日,據知情人士透露,全球領先的圖形處理器制造商英偉達已達成協議,將收購面向軟件開發人員的初創公司Shoreline.io。這次收購對Shoreline的估值達到了約1億美元,標志著

英偉達Blackwell芯片已投產,預告未來AI芯片發展

英偉達創始人兼CEO黃仁勛近日宣布,公司旗下的Blackwell芯片已正式投入生產。這款芯片是英偉

英偉達首席執行官黃仁勛:AI模型推動英偉達AI芯片需求

近來,以ChatGPT為代表的AI聊天機器人已經導致英偉達AI芯片供應緊張。然而,隨著能夠創造視頻并進行近似人類交流的新型

英偉達涉足定制芯片,聚焦云計算與AI市場

作為全球高端AI芯片市場80%份額的霸主,英偉達自2023以來股價上漲超過兩倍,2024年市值高達1.73萬億美元。知名公司如微軟、Ope

英偉達向聊天機器人初創公司Kore.ai注資1.5億美元

據報道,英偉達向聊天機器人制造商Kore.ai注資1.5億美元。這一投資是英偉達在人工智能領域的最新布局,顯示出其對人工智能技術的堅定信心和

今日看點丨英偉達1.5億美元注資聊天機器人初創公司Kore.ai;知名上市公司涉嫌重大財務造假

變得越來越依賴其高端芯片。Kore.ai 周二表示,FTV Capital領投了該輪融資,這家總部位于奧蘭多的初創公司的企業客戶包括可口可樂公司

發表于 01-31 09:53

?888次閱讀

英偉達愈發強勢,AI芯片初創公司仍不服輸

英偉達愈發強勢,AI芯片初創公司仍不服輸

評論