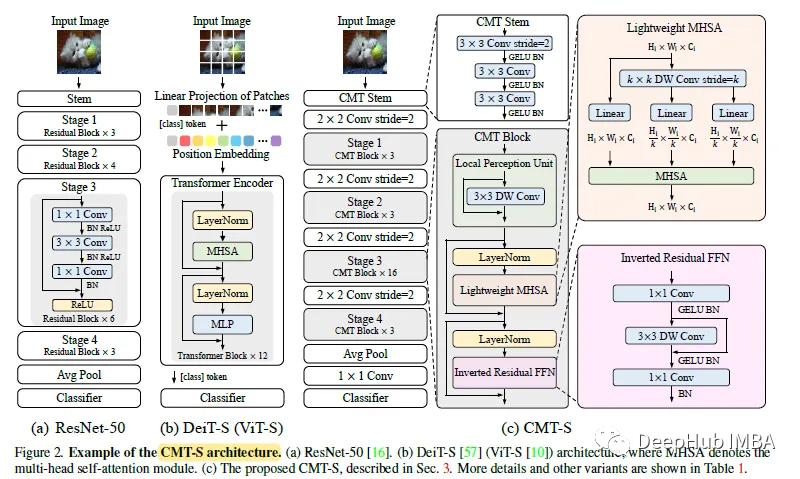

論文提出了一種基于卷積和VIT的混合網絡,利用Transformers捕獲遠程依賴關系,利用cnn提取局部信息。構建了一系列模型cmt,它在準確性和效率方面有更好的權衡。

CMT:體系結構

CMT塊由一個局部感知單元(LPU)、一個輕量級多頭自注意模塊(LMHSA)和一個反向殘差前饋網絡(IRFFN)組成。

1、局部感知單元(LPU)

在以前的transformer中使用的絕對位置編碼是為了利用標記的順序而設計的,它破壞了平移不變性。

為了緩解局限性,LPU使用卷積(MobileNetV1)提取局部信息,其定義為:

2、輕量級多頭自我注意(LMHSA)

在原注意力模塊中,自注意力模塊為:

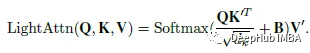

為了減少計算開銷,在注意力操作之前,使用k × k步長為k的深度卷積(MobileNetV1)來減小k和V的空間大小。在每個自注意力模塊中添加一個相對位置偏差B(類似于Shaw NAACL ' 18):

這里的h個是與ViT類似的注意力頭。

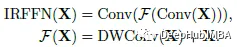

3、反向殘差前饋網絡(IRFFN)

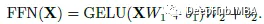

原始FFN使用兩個線性層,中間是GELU:

IRFFN由擴展層(MobileNetV1)和卷積(投影層)組成。為了更好的性能,還修改了殘差連接的位置:

使用深度卷積(MobileNetV1)提取局部信息,而額外的計算成本可以忽略不計。

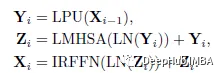

4、CMT塊

有了上述三個組成部分,CMT塊可以表述為:

上式中,Yi和Zi分別表示LPU和LMHSA模塊對第i塊的輸出特征。LN表示層歸一化。

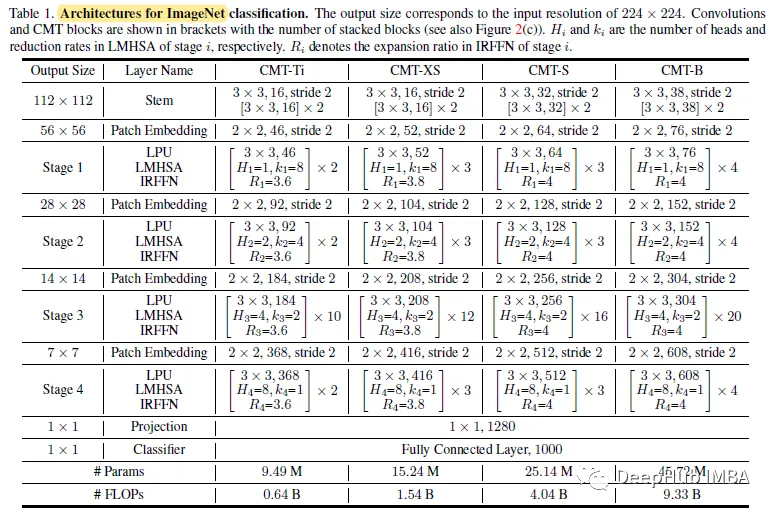

CMT變體

1、模型的復雜性

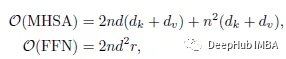

Transformer 的計算復雜度(FLOPs)可計算為:

式中,r為FFN的展開比,dk和dv分別為key和value的維度。ViT設d = dk = dv, r = 4,則計算可簡化為:

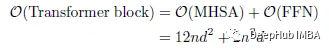

CMT塊的FLOPs:

其中k≥1為LMHSA的還原比。

可以看到,與標準Transformer塊相比,CMT塊對計算成本更友好,并且在更高分辨率(較大n)下更容易處理特征映射。

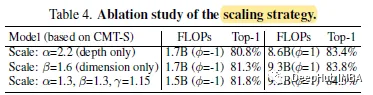

2、擴展策略

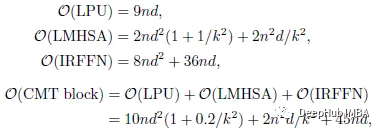

受EfficientNet的啟發,使用復合系數φ來均勻縮放層數(深度)、維度和輸入分辨率:

增加了α·β^(1.5) ·γ2≈2.5的約束,因此對于給定的新φ,總FLOPS將大約增加2.5^ φ。根據測試,默認為α=1.2, β=1.3, γ=1.15。

3、CMT變體

在CMT-S的基礎上,根據提出的縮放策略構建了CMT-Ti、CMT-XS和CMT-B。四種模型的輸入分辨率分別為160、192、224和256。

結果

1、消融研究

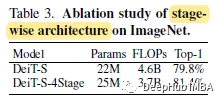

ViT/DeiT只能生成單尺度的特征圖,丟失了大量的多尺度信息,但是這部分信息對密集預測至關重要。

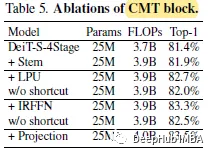

DeiT與CMT-S一樣具有4級stage,即DeiT- s - 4stage,可以實現改進。

所有的增量改進都表明,stem、LPU和IRFFN對性能的提高也有重要的貢獻。CMT在LMHSA和IRFFN之前使用LN,在卷積層之后插入BN。如果將所有的LN都替換為BN,則模型在訓練過程中無法收斂。

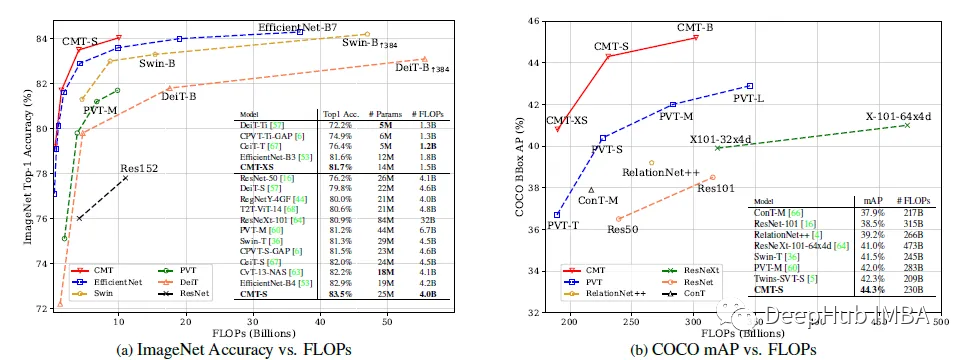

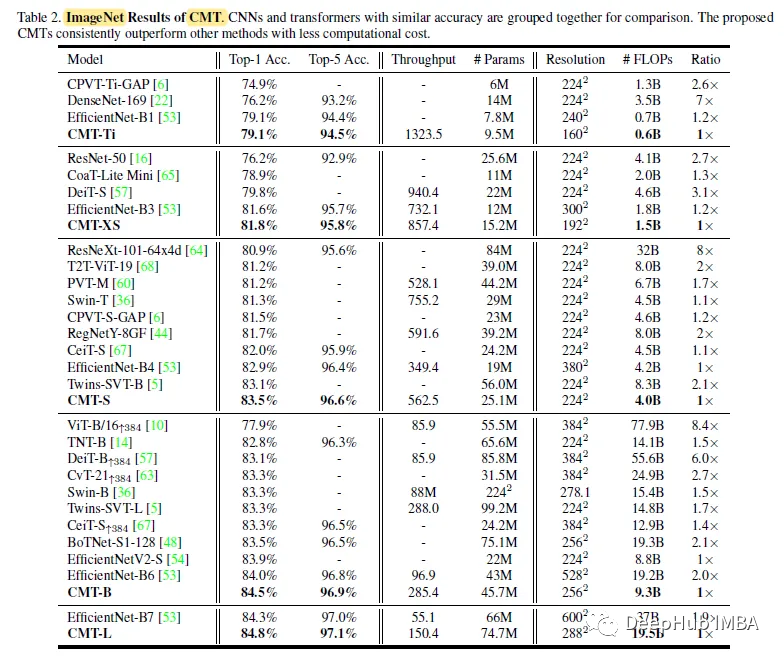

2、ImageNet

CMTS以4.0B FLOPs達到83.5%的top-1精度,比基線模型DeiT-S高3.7%,比CPVT高2.0%,表明CMT塊在捕獲局部和全局信息方面的優勢。

值得注意的是,之前所有基于transformer的模型仍然不如通過徹底的架構搜索獲得的EfficientNet,但是CMT-S比EfficientNet- b4高0.6%,計算成本更低,這也證明了所提出的混合結構的有效性。

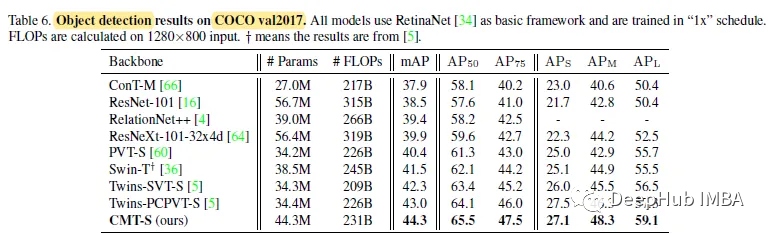

3、下游任務

對于以RetinaNet為基本框架的目標檢測,CMT-S優于twin - pcpvt - s (mAP為1.3%)和twin - svt - s (mAP為2.0%)。

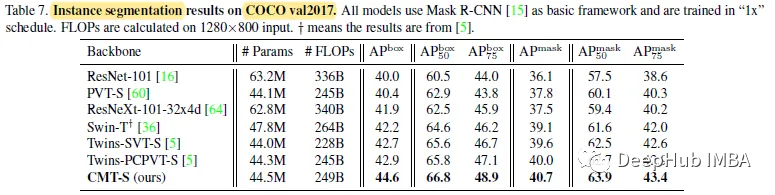

以Mask R-CNN為基本框架的分割,CMT-S以1.7%的AP超過了Twins-PCPVTS,以1.9%的AP超過了Twins-SVT-S。

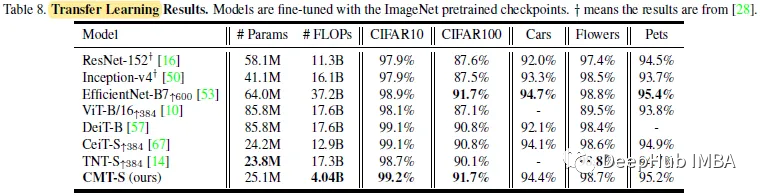

CMT- s在所有數據集中以更少的FLOPs優于其他基于transformer的模型,并在FLOPs減少9倍的情況下與EfficientNet-B7達到相當的性能,這證明了CMT架構的優越性。

-

CMT

+關注

關注

0文章

15瀏覽量

10814 -

位置編碼器

+關注

關注

1文章

18瀏覽量

5562 -

卷積網絡

+關注

關注

0文章

42瀏覽量

2163

發布評論請先 登錄

相關推薦

探索一種降低ViT模型訓練成本的方法

利用卷積調制構建一種新的ConvNet架構Conv2Former

一種混合卷積窗及其在諧波分析中的應用

一種用于圖像分類的卷積神經網絡

一種多層級特征融合就的深度卷積網絡

一種輕量級時間卷積網絡設計方案

介紹一種基于卷積和VIT的混合網絡

介紹一種基于卷積和VIT的混合網絡

評論