本文介紹了一篇由國防科技大學劉煜教授團隊和浙江大學 - 商湯聯合實驗室周曉巍教授團隊聯合撰寫的論文《Deep Active Contours for Real-time 6-DoF Object Tracking》,該論文已被計算機視覺與人工智能頂尖國際會議 ICCV 2023 錄用。僅需要提供 CAD 框架模型,就可以在多種光照條件和局部遮擋情況下實現對立體物體的實時跟蹤。傳統的基于優化的方法根據手工特征將物體 CAD 模型的投影與查詢圖像對齊來求解位姿,容易陷入局部最優解;最近的基于學習的方法使用深度網絡來預測位姿,但其要么預測精度有限,要么需要提供 CAD 紋理模型。

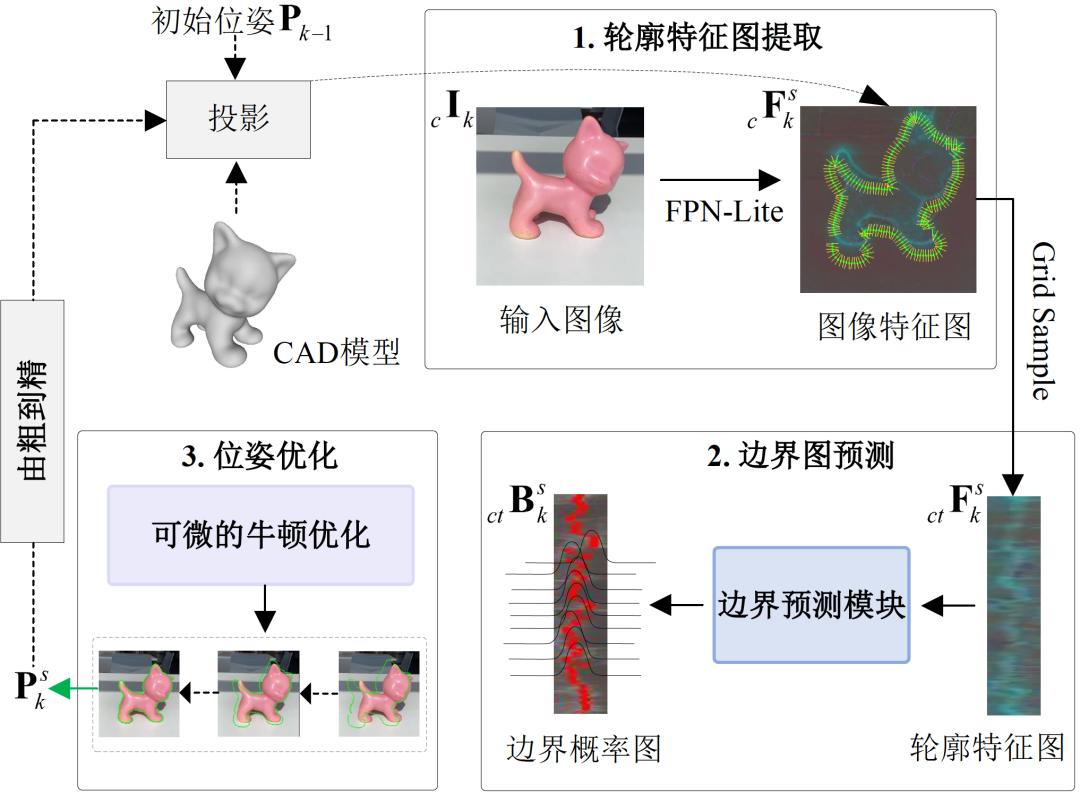

為此,研究員王龍和博士生顏深創新性地提出一種解決方案 DeepAC。DeepAC 結合了傳統方法和深度學習方法的優勢,提出了一個深度主動輪廓模型,以解決六自由度物體跟蹤的問題。給定初始位姿,首先物體 CAD 模型會投影到圖像平面上以獲得初始輪廓,然后一個輕量級網絡用于預測該輪廓應如何移動,以匹配圖像中物體的真實邊界,從而為物體位姿優化提供梯度。最后,提出了一種可微的優化算法,可以使用物體位姿真值端到端監督訓練所提模型。在半合成和真實六自由度物體跟蹤數據集上的實驗結果表明,所提模型在定位精度方面大幅超過了當前最先進方法,并在移動端達到了實時性能。

論文地址:https://openaccess.thecvf.com/content/ICCV2023/papers/Wang_Deep_Active_Contours_for_Real-time_6-DoF_Object_Tracking_ICCV_2023_paper.pdf

項目主頁:https://zju3dv.github.io/deep_ac/

背景

目前主流的六自由度物體跟蹤方法分為基于關鍵點、基于邊緣和基于區域三類。基于關鍵點的方法通過在二維圖像和三維物體模型之間匹配關鍵點特征,來求解物體位姿;基于邊緣的方法利用邊緣信息 (顯式或隱式) 計算兩幅連續圖像之間的相對位姿;基于區域的方法利用物體區域與背景區域在顏色統計上的區別,來求解物體位姿。然而,上述基于優化的方法存在一個共同缺點:它們需要手工設計特征和細致調整超參數,使其不能穩健地應用于各類真實場景。

近年來,一些端到端學習方法被提出以增強六自由度物體定位的魯棒性,包括:直接回歸幾何參數;采用渲染 - 比對來迭代地優化位姿。盡管基于學習的方法具有潛力,但是直接回歸法精度有限、泛化能力差;而渲染 - 比對法計算量大、不適用于實時應用,且需要提供帶紋理的 CAD 模型。如何結合了傳統優化方法和基于學習方法的優勢,能夠僅在 CAD 網格模型引導下,準確、魯棒、實時地求解物體位姿,是一個亟待解決的問題。

六自由度物體跟蹤的相關工作

1 基于優化的六自由度物體跟蹤方法

基于優化的方法常用于解決六自由度物體跟蹤問題,具體可以分為三種不同的類別:基于關鍵點 (Keypoint)、基于邊緣 (Edge) 和基于區域 (Region)。基于關鍵點的方法利用局部特征匹配或光流技術建立 2D-3D 對應關系。雖然這種方法表現出了出色的性能,但它需要提供物體的紋理模型。為了解決這個問題,研究人員提出了基于邊緣的方法,通過隱式或顯示地分析物體邊緣位移,判斷物體六自由度位姿變化。例如,RAPiD 通過在投影邊緣的正交方向上搜索最大梯度,來估計連續幀之間的相對位姿。然而,基于邊緣的方法處理不好背景有雜物和運動模糊的情況。

這幾年,基于區域的方法在復雜環境的跟蹤任務中取得了顯著進展。該研究最早可以追溯到 PWP3D 的工作,其有效地結合了前背景分割的統計模型和物體投影的邊界距離場來優化物體位姿。近年來,RBGT 引入了多視角預計算的稀疏對應線 (Correspondence lines),建立符合了高斯分布的概率模型,并使用牛頓法快速收斂到物體位姿。SRT3D 引入了平滑的階躍函數,考慮到全局和局部不確定性,相較于現有方法有明顯改進。然而,基于區域的物體連續位姿估計算法會受到人工定義的特征和超參數限制。

2 基于學習的六自由度物體跟蹤方法

近年來,深度學習方法在六自由度物體姿態估計領域取得了顯著進展。其中一種方法是直接預測旋轉和平移參數。另一種方法則是通過檢測或回歸物體坐標生成 2D-3D 對應關系,進而使用 PnP 求解器估計六自由度位姿。然而,僅通過單個網絡預測物體位姿,其輸出往往不準確。

為了克服這個問題,一些研究采用迭代優化的技術以取得更精確的結果。這類方法的關鍵是迭代的 “渲染 - 比對” 思想。在每次迭代中,利用當前估計的物體位姿渲染三維紋理模型,然后將渲染圖像與實際圖像進行比較,并用神經網絡更新位姿,從而使兩者逐漸對齊。目前,基于學習的方法的主要不足是需要使用 GPU,這使得它們不適合在移動應用程序中部署,例如虛擬現實、增強現實應用。此外,這類方法需要提供物體的紋理模型,但在實際任務中,用戶預先獲取的往往是一個三維掃描或者人工設計的 CAD 網格模型。

方法

針對上述背景和相關工作,論文提出了提出了一種傳統方法和學習方法結合的方案。給定一個視頻序列 和初始時刻的物體位姿,所提方法使用當前幀的單個 RGB 圖像

和初始時刻的物體位姿,所提方法使用當前幀的單個 RGB 圖像 和前一幀該物體位姿

和前一幀該物體位姿 來求解當前幀的物體位姿

來求解當前幀的物體位姿 。

。

1 輪廓特征圖提取

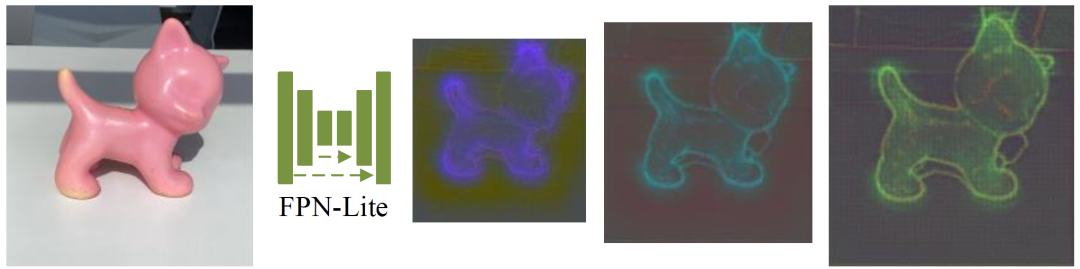

利用上一幀的物體位姿,在 RGB 圖像上裁剪出一個包含目標物體的矩陣區域

,并使用以 MobileNetV2 為基礎的 FPN-Lite 網絡,對圖像

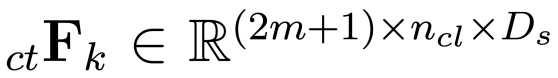

提取多層特征。提取的多尺度特征圖表示為

,包含一系列由粗到細的特征信息。其中,

, ,

,

,

分別表示尺度為 s 的特征圖寬度、高度和維度,

為提取特征的層數。這種由粗到細的網絡設計可以使得神經網絡編碼到更廣的空間信息,從而提高在物體大幅度運動情況下的定位精度。下圖可視化了一組 FPN-Lite 網絡提取的多層次特征圖,先用 PCA 對特征圖

進行降維,再表示成 RGB 圖像。

受到 RBGT 的啟發,論文使用對應線模型 (Correspondence Line Model) 描述二維輪廓的局部區域。具體來說,對應線模型在二維輪廓上均勻采樣若干個二維點,并建立相應的對應線 。每條對應線由一個中心點

。每條對應線由一個中心點

和一個單位法向量

組成,它們通過三維輪廓點 及其相關的三維法向量

及其相關的三維法向量 投影到二維圖像平面上得到。通過在特征圖

投影到二維圖像平面上得到。通過在特征圖

上插值采樣這些二維點集 (使用 PyTorch 的 grid_sample 函數),可生成輪廓特征圖

, 是采樣的二維輪廓點的數量。

是采樣的二維輪廓點的數量。

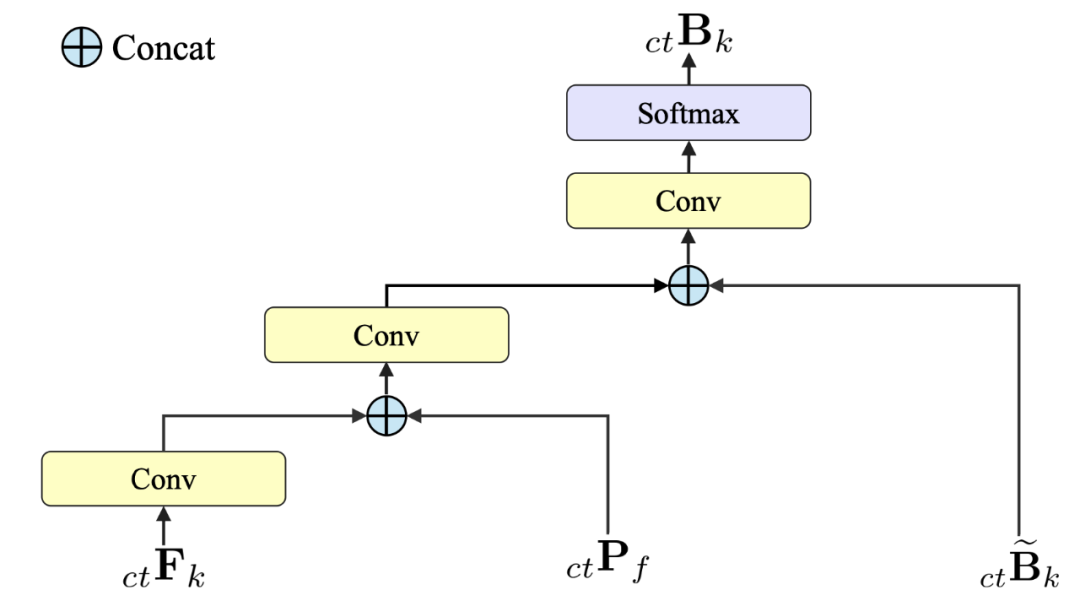

2 邊界圖預測

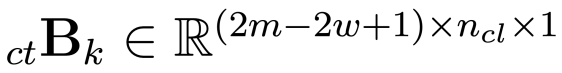

論文設計了一個輕量化網絡,用于預測邊界概率圖

, 動態設定,以移除圖像邊緣外的區域。在邊界概率圖

動態設定,以移除圖像邊緣外的區域。在邊界概率圖 中,位于

中,位于

坐標處的值表示二維點 作為第

作為第

條對應線邊界的概率。為了提高網絡的泛化能力,論文將基于傳統統計方法所得到的前景概率圖 和邊界概率圖

和邊界概率圖 與輪廓特征圖

與輪廓特征圖 融合,作為輕量化網絡的輸入。

融合,作為輕量化網絡的輸入。

上圖詳細介紹了邊界預測模塊的前向傳播過程。其使用了三種不同的輸入,分別是前景概率圖

和邊界概率圖

與輪廓特征圖

。通過在不同階段使用拼接 (Concat) 操作,將這些信息融入到神經網絡中,來預測邊界概率圖 。實驗表明,將傳統統計信息和深度特征進行融合并作為網絡的輸入,能夠顯著的提高定位算法的性能指標。

。實驗表明,將傳統統計信息和深度特征進行融合并作為網絡的輸入,能夠顯著的提高定位算法的性能指標。

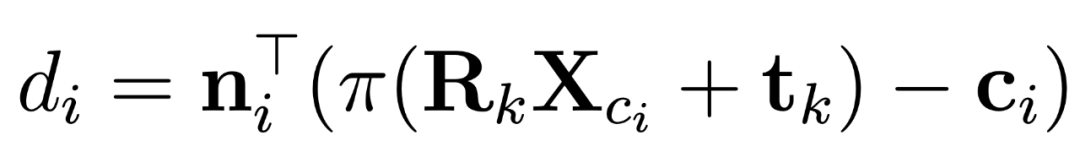

3 位姿優化

本小節基于輕量化網絡學習得到的邊界概率圖

,采用迭代優化方法恢復當前幀物體的位姿

。在位姿

每一輪迭代更新時,二維輪廓點

和三維輪廓點 之間重投影誤差

之間重投影誤差 計算如下:

計算如下:

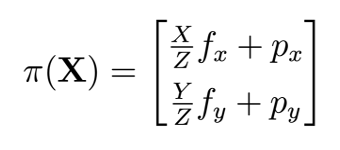

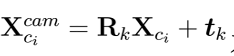

其中,

為投影輪廓法向向量,

和

分別為物體在第 k 幀的旋轉和平移,π 表示針孔相機模型的投影函數:

其中, 分別為x,y圖像空間方向焦距及光心。給定位姿

分別為x,y圖像空間方向焦距及光心。給定位姿 后,重投影

后,重投影 距離刻畫了三維輪廓點

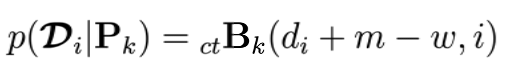

距離刻畫了三維輪廓點 的投影在第i條的對應線上的位置。該位置作為邊界點的似然估計是:

的投影在第i條的對應線上的位置。該位置作為邊界點的似然估計是:

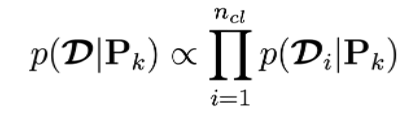

每條對應線上邊界點似然估計相互獨立,則所有對應線整體似然估計為:

本小節的目標為尋找使得似然估計最大化的位姿 。

。

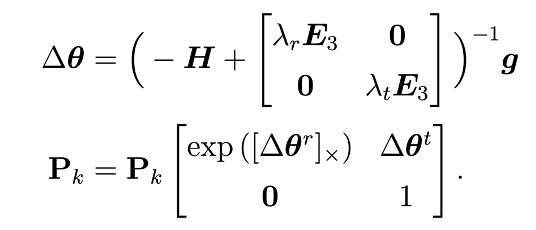

為了最大化該似然估計,本小節采用了迭代牛頓法和 Tikhonov 正則化來優化位姿求解。具體的位姿更新方式如下:

式中H為海森矩陣,g是梯度向量, 為 3×3 的單位矩陣。

為 3×3 的單位矩陣。 和

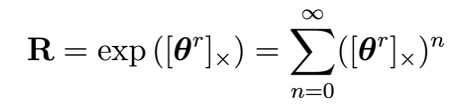

和 分別表示三維旋轉和三維平移的正則化參數。由于三維旋轉R屬于一個李群,所以它可用一個李代數的指數映射表示:

分別表示三維旋轉和三維平移的正則化參數。由于三維旋轉R屬于一個李群,所以它可用一個李代數的指數映射表示:

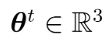

式中,三維向量 是李代數空間 so (3) 的元素,

是李代數空間 so (3) 的元素, 為

為 的斜對稱矩陣。因此一個位姿

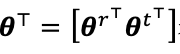

的斜對稱矩陣。因此一個位姿 能夠被一個六自由度的變量表示

能夠被一個六自由度的變量表示 ,

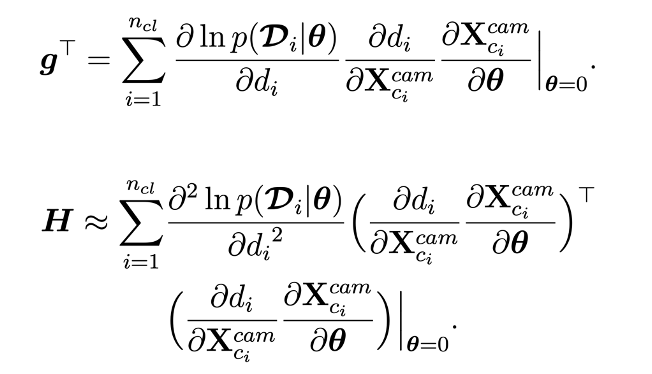

, 。根據鏈式求導法則,海森矩陣H和梯度向量g的計算如下:

。根據鏈式求導法則,海森矩陣H和梯度向量g的計算如下:

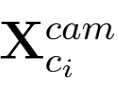

式中

為三維輪廓點 在相機坐標空間的位置。

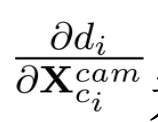

在相機坐標空間的位置。 為重投影誤差相對于相機坐標空間點

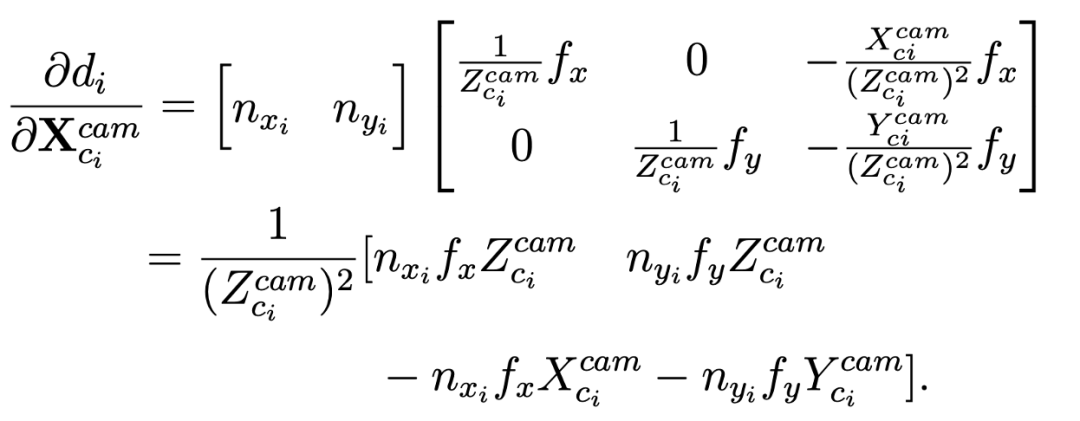

為重投影誤差相對于相機坐標空間點 的一階偏導數,它的計算公式如下:

的一階偏導數,它的計算公式如下:

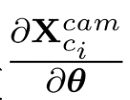

對于相機坐標空間下的三維點相對于六自由度位姿的一階偏導數 的計算,本小節采用經典的擾動模型推導得到如下公式:

的計算,本小節采用經典的擾動模型推導得到如下公式:

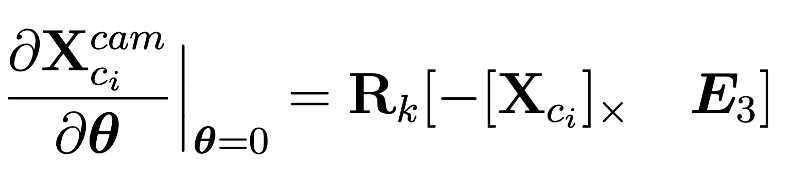

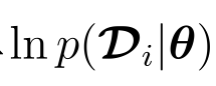

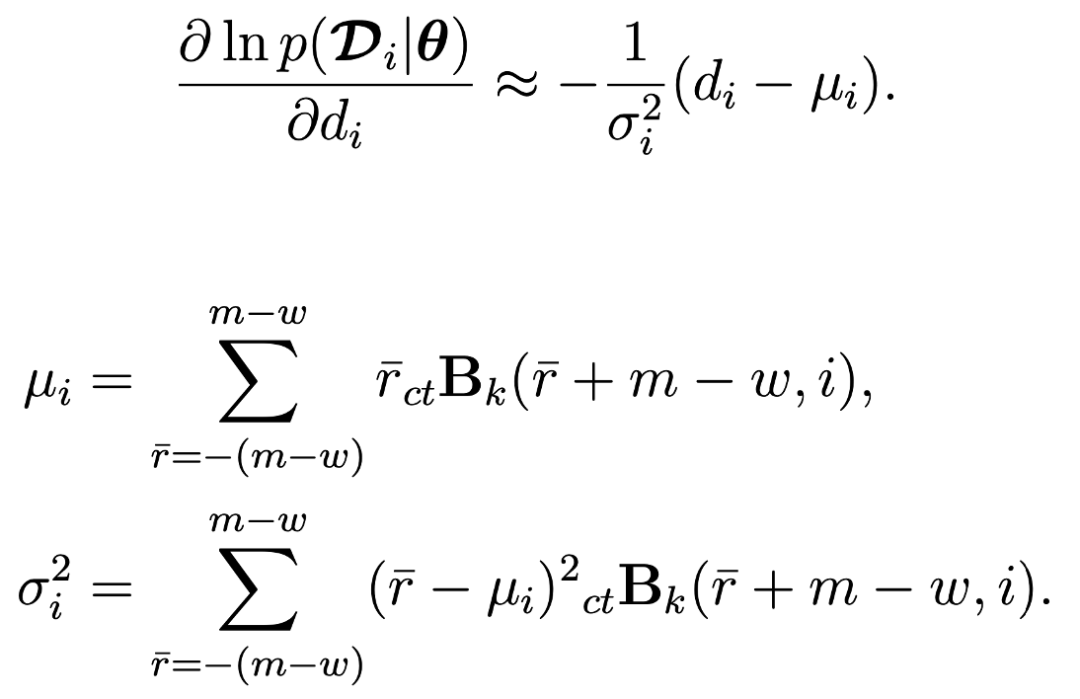

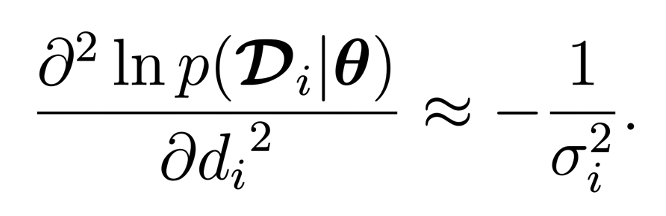

為了端到端訓練之前所提出的網絡模型,本小節采用兩種近似方法來估計

關于 的一階導數。第一種近似方法直接使用每條對應線的均值

的一階導數。第一種近似方法直接使用每條對應線的均值 和方差

和方差 計算導數,具體計算方式如下:

計算導數,具體計算方式如下:

第二種近似方法利用了三維輪廓投影點附近區域的邊界概率,具體計算公式如下:

這兩種近似方法具有不同的特性:第一種近似用于直接學習每條對應線上的邊界位置 ,從而實現快速收斂。第二種近似用于學習局部邊界概率,從而細致優化位姿。此外,方差

,從而實現快速收斂。第二種近似用于學習局部邊界概率,從而細致優化位姿。此外,方差 用于刻畫每條對應線的不確定性,在位姿求解過程中起到了增強魯棒性的作用。為了分析邊界不確定性對于物體姿態預測的影響,論文采用了一種基于顏色漸變的可視化方法,使用用較暖 (紅色) 的顏色來表示邊界不確 定性值 (即

用于刻畫每條對應線的不確定性,在位姿求解過程中起到了增強魯棒性的作用。為了分析邊界不確定性對于物體姿態預測的影響,論文采用了一種基于顏色漸變的可視化方法,使用用較暖 (紅色) 的顏色來表示邊界不確 定性值 (即 ) 較小的區域。從下圖中可以看出,物體沒有被遮擋的邊界對于位姿預測更有幫助,而被遮擋的邊界則相對無關緊要。

) 較小的區域。從下圖中可以看出,物體沒有被遮擋的邊界對于位姿預測更有幫助,而被遮擋的邊界則相對無關緊要。

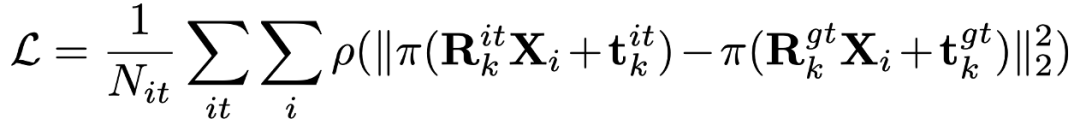

4 網絡監督

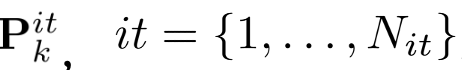

論文提出的方法以每次迭代優化后所得的位姿

與真實位姿 間的差異為依據:

間的差異為依據:

其中,P是 Huber 魯棒核函數。為了避免困難樣例對模型訓練產生不利影響,論文采用了條件損失函數:只有在前一次迭代優化后所得的位姿在真實解附近時,才將其納入損失函數的計算中;如果某次迭代優化后所得的位姿偏離真實解過大,則忽略其對應的損失項。這樣可以保證模型只使用可信度高的訓練樣本。

結果

1 與基于優化的方法比較

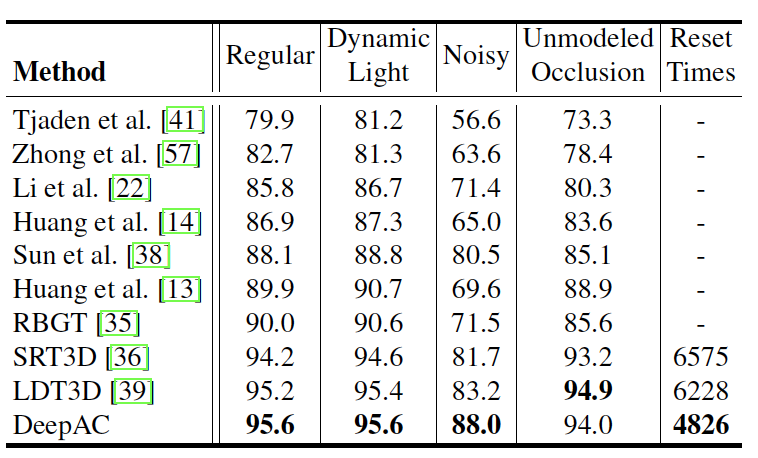

(1)RBOT 數據集

在 RBOT 數據集上,論文采用 5cm?5?召回率,來評估定位的精度。具體而言,每一幀圖像是否被成功定位取決于其平移誤差是否小于 5cm 且旋轉誤差是否小于5?。

實驗結果表明,在常規、動態光照和場景遮擋下,現有的基于優化的方法已經非常接近性能上限,SRT3D 和 LDT3D 的 5cm?5?召回率已接近或超過 95%。在這三種情況下,DeepAC 表現出了相似的性能,在常規和動態光照情況下小幅領先,在場景遮擋情況下略微落后。但是,在噪聲情況下,所提方法顯著優于其他基于優化的方法,5cm?5?召回率從 83.2% 提高到 88.0%,這一結果證明了 DeepAC 對圖像噪聲具有較強的魯棒性。

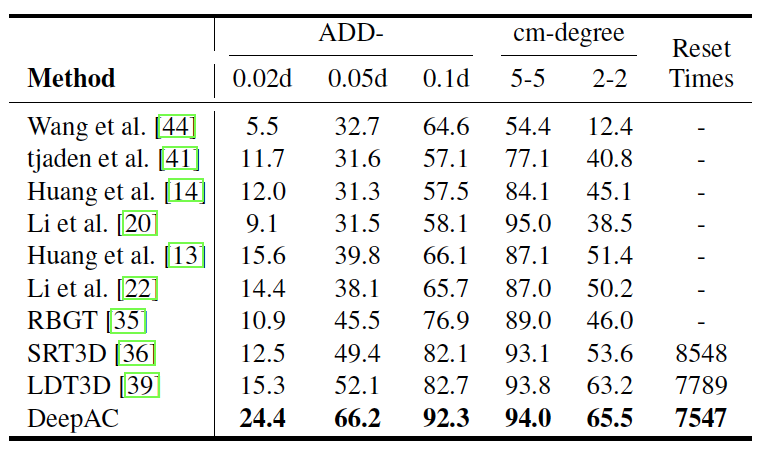

(2)BCOT 數據集

論文在 BCOT 數據集上對所提方法進行了實驗驗證,并采用 ADD-(s) d 和厘米 - 度召回率來評估位姿估計的精度。與在 RBOT 數據集上進行的實驗不同,在 BCOT 數據集上,增加了一些更嚴格的評價指標,即 ADD-0.02d、ADD-0.05d、 ADD-0.1d 以及 2cm?2?召回率,以評估算法的高精度定位能力。其中,d 表示物體模型 3D 包圍盒的最大長度。

實驗結果表明,DeepAC 在所有閾值下的 ADD-(s) d 和厘米 - 度召回率均優于其他基于優化的基線方法。特別是,在非常嚴格的 ADD-(s) d 標準下,所提方法表現出顯著的優勢,相比于排名第二的 LDT3D,在 ADD-0.02d、ADD-0.05d 和 ADD-0.1d 上分別提高了 9.1 個百分點、14.1 個百分點和 9.6 個百分點。這些結果充分表明了 DeepAC 具有高精度定位的能力。

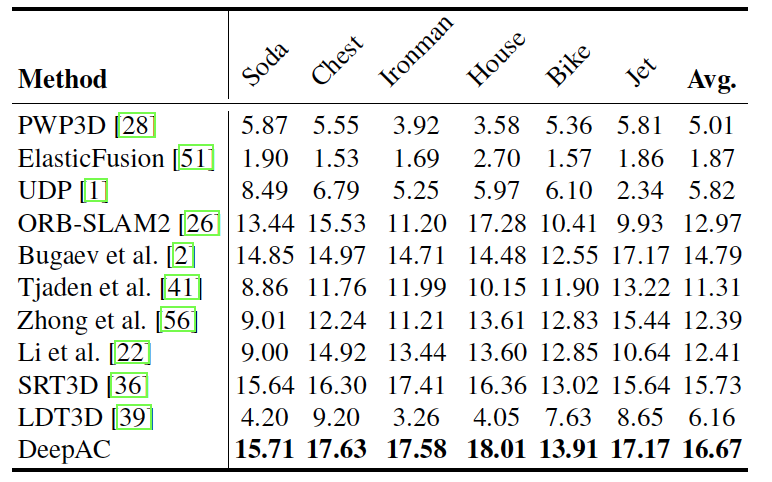

(3) OPT 數據集

在 OPT 數據集上,論文先計算不同誤差閾值 s 下的 ADD-(s) d 得分,再通過計算曲線下面積 (AUC) 得分來衡量視頻序列中物體位姿估計的質量。其中,誤差閾值 s 的范圍設定為 [0, 0.2]。

下表顯示了 DeepAC 在六個物體上均優于當前最先進的基于優化的方法,在 AUC 分數上取得了明顯提升。在平均 AUC 分數方面,DeepAC 達到 16.69,比排名第二的方法 SRT3D 高出 6.10%。這些結果表明 DeepAC 在真實場景下具有優異的跟蹤能力。

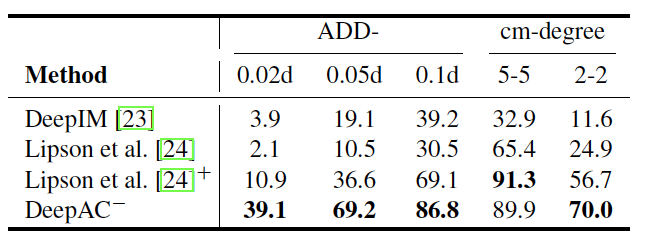

2 與基于學習的方法比較

為了驗證 DeepAC 模型在不同數據集上具有很好的泛化能力,論文在 RBOT 數據集上與當前最先進的基于學習的方法進行了對比實驗。論文選取了除 “Clown” 物體外 (因為其紋理圖有誤) 所有序列作為測試集,并使用平均 ADD-(s) d 和厘米 - 度召回率作為評估指標。為了與其他基于學習的方法公平比較,所提方法 DeepAC 使用相同的訓練數據和方式,并記作 DeepAC?。

實驗結果顯示,其他典型的基于學習的方法定位精度遠低于 DeepAC,這充分說明了 DeepAC 在不同數據集上具有很強大且穩定的泛化能力。

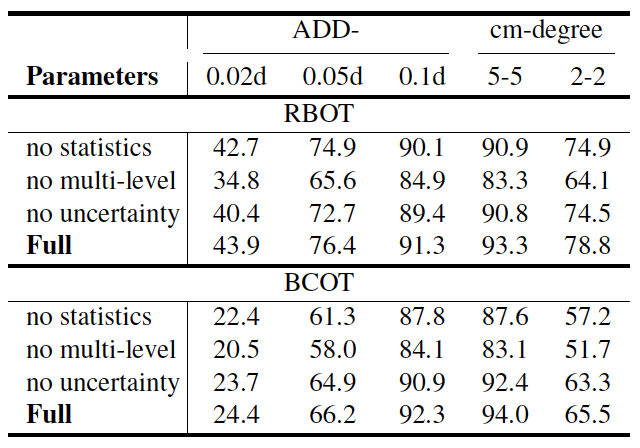

3 消融分析

論文通過消融實驗分析 DeepAC 中三個主要的設計對物體六自由度定位性能的影響,分別是:1) 統計信息融入;2) 多層特征提取;3) 邊界不確定性估計。實驗在 RBOT 和 BCOT 數據集上進行,并將結果展示在下表。

應用前景

該研究成果在民用和軍事領域都有廣泛的應用。在民用領域,該研究可用于強現實、機器人操作和人機交互等眾多應用。在軍事領域,該研究可用于支持空中無人裝備與巡飛彈在復雜光照條件下對目標的多角度實時跟蹤與打擊。

-

人機交互

+關注

關注

12文章

1206瀏覽量

55382 -

機器人

+關注

關注

211文章

28380瀏覽量

206918 -

計算機視覺

+關注

關注

8文章

1698瀏覽量

45976 -

深度學習

+關注

關注

73文章

5500瀏覽量

121113

原文標題:ICCV 2023 | 實現實時六自由度物體跟蹤

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

DSP在六自由度電磁跟蹤系統中的應用

基于FPGA EtherCAT的六自由度機器人視覺伺服控制設計

基于STM32、以太網、Labview的六自由度Stewart并聯運動平臺模型

基于Matlab的開源六自由度協作機器人實驗平臺

專家點贊!國家重點研發計劃“六自由度激光自動精準跟蹤測量關鍵技術”項目通過驗收

一文讀懂六自由度激光跟蹤儀

ICCV 2023:實現實時六自由度物體跟蹤

ICCV 2023:實現實時六自由度物體跟蹤

評論