在多模態(tài)(視覺語言)大模型領(lǐng)域,拼參數(shù)贏性能的同時(shí),追求參數(shù)更小、速度更快、性能更強(qiáng)是另一條研究路徑。

在大模型時(shí)代,視覺語言模型(VLM)的參數(shù)已經(jīng)擴(kuò)展到了數(shù)百甚至數(shù)千億,使得性能持續(xù)增加。與此同時(shí),更小規(guī)模的模型仍然很重要,它們更易于訓(xùn)練和服務(wù),更加環(huán)境友好,并為模型設(shè)計(jì)提供更快的研究周期。

在該領(lǐng)域,谷歌研究院在去年推出了一個(gè)名為 PaLI(Pathways Language and Image)的模型。作為一個(gè)多模態(tài)大模型,PaLI 的關(guān)鍵結(jié)構(gòu)之一是復(fù)用大型單模態(tài)基干進(jìn)行語言和視覺建模,在語言方面復(fù)用 13B 參數(shù)的 mT5-XXL,在視覺方面復(fù)用 2B 參數(shù)的 ViT-G 和 4B 參數(shù)的 ViT-e。當(dāng)時(shí) PaLI 實(shí)現(xiàn)了優(yōu)于多數(shù)新舊模型的性能。

此后谷歌繼續(xù)專注于更小規(guī)模的建模,并于近日提出 PaLI-3,這是 PaLI 系列的第三代模型。通過一個(gè)僅有 5B 參數(shù)的預(yù)訓(xùn)練基線模型,他們優(yōu)化了訓(xùn)練方法,并在多個(gè) VLM 基準(zhǔn)上實(shí)現(xiàn)了有競爭力以及新的 SOTA 結(jié)果。

該方法主要由三部分組成,分別是在 web 規(guī)模的圖像文本數(shù)據(jù)上對圖像編碼器的對比預(yù)訓(xùn)練、用于 PaLI 多模態(tài)訓(xùn)練的改進(jìn)后的混合數(shù)據(jù)集,以及更高分辨率的訓(xùn)練。

作者來自谷歌研究院、谷歌DeepMind和谷歌云。

論文地址:https://arxiv.org/abs/2310.09199

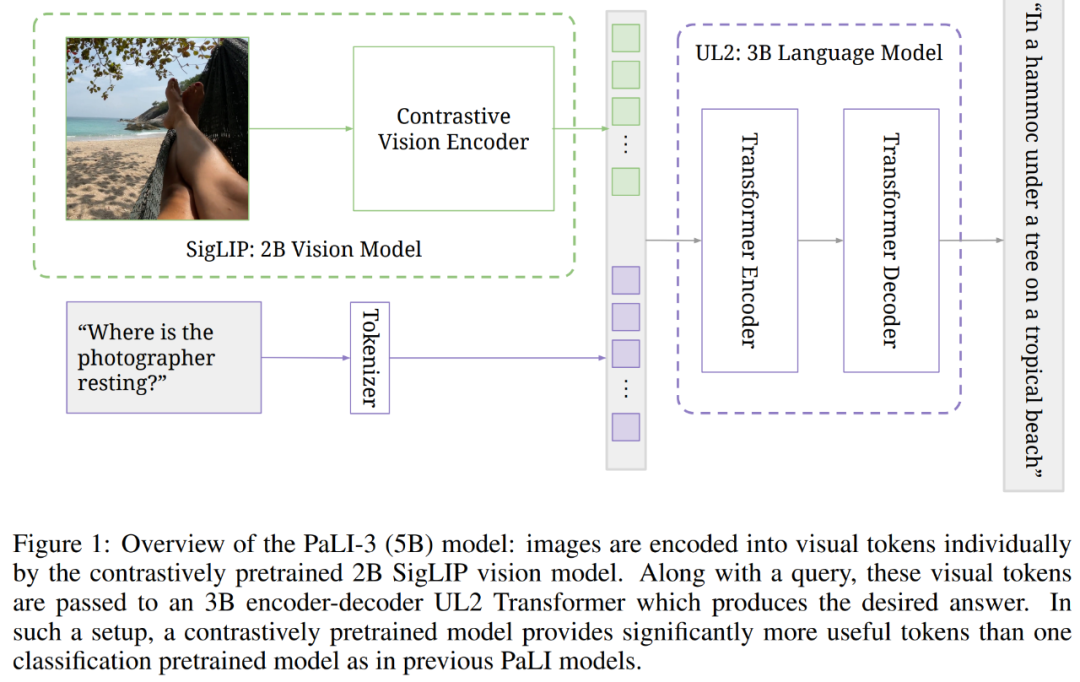

下圖為 5B PaLI-3 模型概覽,其中通過對比預(yù)訓(xùn)練的 2B SigLIP 視覺模型,圖像被單獨(dú)地編碼成了視覺 token。接著與 query 一起,這些視覺 token 被傳遞給了 3B 編碼器 - 解碼器結(jié)構(gòu)的 UL2 Transformer,它生成了預(yù)期答案。在這樣的設(shè)置下,與之前 PaLI 模型中單個(gè)分類預(yù)訓(xùn)練的模型,對比預(yù)訓(xùn)練的模型提供了明顯更有用的 token。

效果怎么樣呢?PaLI-3 在需要視覺定位文本理解和目標(biāo)定位的任務(wù)上實(shí)現(xiàn)了新的 SOTA,包括 RefCOCO 數(shù)據(jù)集上的 8 個(gè)視覺定位文本理解任務(wù)和參考表達(dá)分割任務(wù)。PaLI-3 也在一系列分類視覺任務(wù)上有出色的表現(xiàn)。

此外研究者還專門做了消融實(shí)驗(yàn)以與分類預(yù)訓(xùn)練的 ViT 基線模型比較,并進(jìn)一步確認(rèn)了預(yù)訓(xùn)練視覺編碼器在有噪聲 web 規(guī)模的圖像文本數(shù)據(jù)上的可行性,從而成為在分類數(shù)據(jù)上進(jìn)行訓(xùn)練的優(yōu)先替代方案。

除了 5B PaLI-3 模型之外,研究者還利用最近提出的 SigLIP 方法,構(gòu)建了一個(gè)參數(shù)擴(kuò)展到 2B 的 SOTA 多語言對比視覺模型。

模型介紹

架構(gòu)

在更高的層面,PaLI-3 的架構(gòu)遵循了 Chen et al. (2023b;a):ViT 模型將圖像編碼為 token,并與問題、提示和指令等文本輸入一起被傳遞到編碼器 - 解碼器結(jié)構(gòu)的 transformer,從而生成文本輸出。

先看視覺組件。研究者使用 SigLIP 訓(xùn)練方法,從對比預(yù)訓(xùn)練的 ViT-G/14 模型(參數(shù)約為 2B)初始化出 PaLI-3 的視覺基干。簡而言之,他們訓(xùn)練了圖像嵌入 ViT-G/14 模型和文本嵌入 transformer 模型來分別嵌入圖像和文本,這樣一來,使用圖像和文本嵌入點(diǎn)積的 sigmoid 交叉熵的二元分類器,能夠準(zhǔn)確地分類各自的圖像和文本是否相互對應(yīng)。

這類似于 CLIP 和 ALIGN,但更加高效、可擴(kuò)展和穩(wěn)健。同時(shí)這種方法是為了預(yù)訓(xùn)練 ViT 圖像嵌入組件,因此當(dāng)將 ViT 插入到 PaLI 時(shí),文本嵌入 transformer 會被丟棄。

再來看完整的 PaLI 模型。ViT 圖像編碼器的輸出在池化之前形成了視覺 token,并線性地映射和添加到嵌入的輸入文本 token。接著這些 token 被傳遞到了預(yù)訓(xùn)練的 3B UL2 編碼器 - 解碼器模型,從而生成文本輸出。該模型的文本輸入通常包含有描述任務(wù)類型的提示,并為該任務(wù)編碼必要的文本輸入。

訓(xùn)練

訓(xùn)練過程包含多個(gè)階段。

階段 0:單峰預(yù)訓(xùn)練。圖像編碼器按照 SigLIP 訓(xùn)練協(xié)議,圖像編碼器的訓(xùn)練分辨率為 224×224 ;文本編碼器 - 解碼器是一個(gè) 3B UL2 模型,按照 Tay 等人描述的混合降噪程序進(jìn)行訓(xùn)練。

階段 1:多模態(tài)訓(xùn)練。將圖像編碼器與文本編碼器 - 解碼器相結(jié)合,然后,將這個(gè)組合得到的 PaLI 模型在多模態(tài)任務(wù)和數(shù)據(jù)上進(jìn)行訓(xùn)練,此時(shí),圖像編碼器保持凍結(jié),分辨率還是 224×224。通過對文本質(zhì)量進(jìn)行啟發(fā)式過濾,并使用 SplitCap 訓(xùn)練目標(biāo),再次從 WebLI 數(shù)據(jù)集派生出主要的混合組件。

階段 2:提升分辨率。高分辨率輸入是一種被廣泛接受的提高性能的方法,這既是因?yàn)榭梢愿兄獔D像中的更多細(xì)節(jié),也是因?yàn)橥ㄟ^增加序列長度來提高模型能力。本文通過解凍圖像編碼器來提高 PaLI-3 的分辨率,將檢查點(diǎn)保持在 812×812 和 1064×1064 分辨率。

任務(wù)遷移。最后,對于每個(gè)單獨(dú)的任務(wù)(基準(zhǔn)),本文使用凍結(jié)的 ViT 圖像編碼器在任務(wù)的訓(xùn)練數(shù)據(jù)上微調(diào) PaLI-3 模型;對于大多數(shù)任務(wù),本文微調(diào) 812×812 分辨率檢查點(diǎn),但對于兩個(gè)文檔理解任務(wù),本文將分辨率提高到 1064×1064。

實(shí)驗(yàn)及結(jié)果

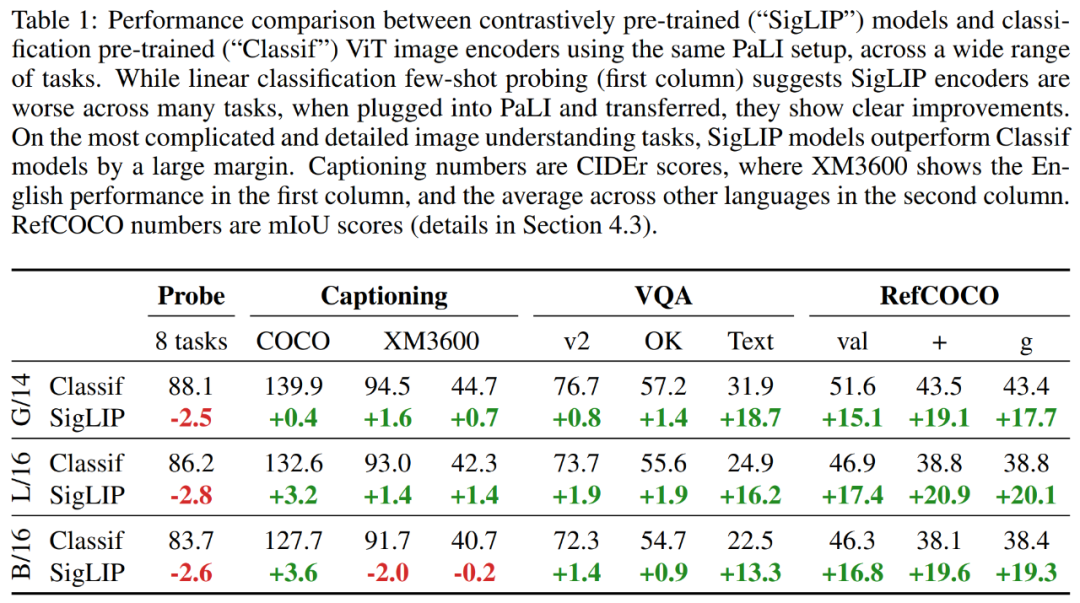

實(shí)驗(yàn)首先比較了在 PaLI 框架下不同 ViT 模型的結(jié)果對比,研究者考慮了兩種 ViT 模型:Classif 和 SigLIP。

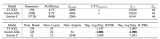

結(jié)果如表 1 所示,表明雖然 SigLIP 模型的少樣本線性分類有些落后,但通過使用 PaLI-3,SigLIP 模型在更簡單的任務(wù)上(例如字幕和問答)提供了適度的增益,并且在更復(fù)雜的場景即文本和空間理解任務(wù)上取得了巨大增益。

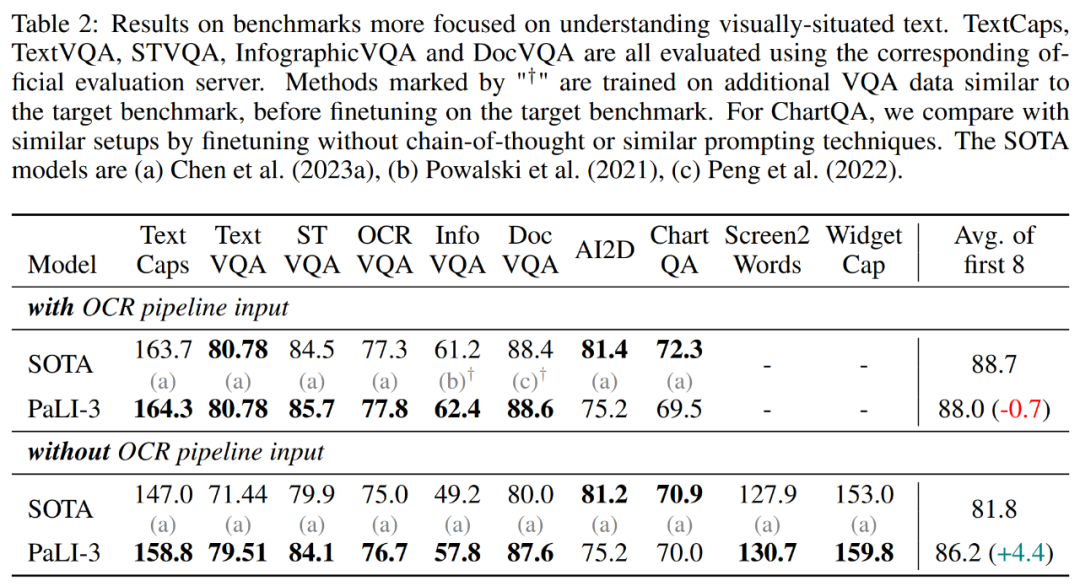

此外,研究者還在 TextCaps、TextVQA、STVQA、OCRVQA、InfographicVQA、DocVQA、ChartQA、Scree2Words、 WidgetCap 數(shù)據(jù)集上評估了 PaLI-3。結(jié)果如表 2 所示,在使用外部 OCR 系統(tǒng)的情況下,PaLI-3 僅比 SOTA 方法低 0.7 分。然而,在沒有這種外部系統(tǒng)的情況下,PaLI-3 比所有 SOTA 方法的組合高出 4.4 分。對于 TextCaps、TextVQA、InfographicVQA 和 DocVQA,PaLI-3 的優(yōu)勢超多 8 分甚至更多。

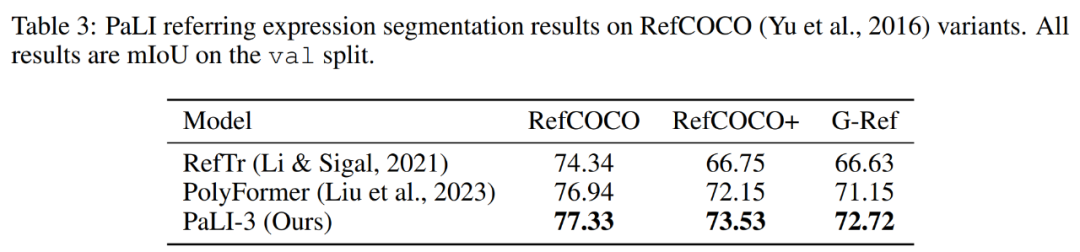

參考表達(dá)分割

研究者擴(kuò)展了 PaLI-3,使其能夠通過類語言輸出來預(yù)測分割掩碼。為此,他們利用了 Ning et al. (2023) 的向量量化變分自編碼器(VQ-VAE)。VQ-VAE 經(jīng)過訓(xùn)練可以學(xué)習(xí) 128 個(gè)掩碼 token,其編碼器可以將 64 × 64 像素的分割掩碼標(biāo)記為 16 個(gè)掩碼 token,解碼器可以轉(zhuǎn)換回來。

研究者訓(xùn)練 PaLI-3 來預(yù)測單個(gè)分割掩碼,首先輸出 4 個(gè)坐標(biāo)作為文本,并表示為邊界框。接著是 16 個(gè)掩碼 token,表示邊界框內(nèi)的掩碼。

表 1 表明對于此類定位任務(wù),對比預(yù)訓(xùn)練比分類預(yù)訓(xùn)練更有效。下表 3 顯示,完整的 PaLI-3 模型在參考表達(dá)分割方面略微優(yōu)于現(xiàn)有技術(shù)。

圖像理解

接下來研究者在一般視覺語言理解任務(wù)上評估了 PaLI-3。與之前的工作一樣,他們沒有使用外部 OCR 模塊,因?yàn)檫@些基準(zhǔn)測試很少涉及圖像中的文本。

結(jié)果表明,與最近的 SOTA 模型相比,PaLI-3 的尺寸要小得多,但它在這些基準(zhǔn)測試中表現(xiàn)出了非常強(qiáng)大的性能。對于 COCO,PaLI-3 優(yōu)于除 BEiT-3 以及 17B 和 55B PaLI 之外的所有模型。在 VQAv2 和 TallyQA 上,PaLI-3 超過了除 PaLI-X 之外的所有先前模型。對于 OKVQA 任務(wù),PaLI-3 僅落后于 PaLM-E (562B) 和 PaLI-X (55B),但仍然優(yōu)于 32-shot Flamingo (80B) 模型。

視頻字幕和問答

該研究在 4 個(gè)視頻字幕基準(zhǔn)上對 PaLI-3 模型進(jìn)行了微調(diào)和評估:MSR-VTT、VATEX、ActivityNet Captions 和 Spoken Moments in Time。此外,該研究在 3 個(gè)視頻問答基準(zhǔn)上進(jìn)行了同樣的操作:NExT-QA、MSR-VTT-QA 和 ActivityNet-QA。

盡管沒有使用視頻數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,PaLI-3 仍以較小的模型尺寸實(shí)現(xiàn)了出色的視頻 QA 結(jié)果:在 MSR-VTT-QA 和 ActivityNet-QA 上實(shí)現(xiàn)了最先進(jìn)的性能,并在 NextQA 上取得了具有競爭力的結(jié)果。在圖像和視頻 QA 上的持續(xù)改進(jìn)凸顯了采用對比 ViT 的好處。

此外,PaLI-3 還取得了非常好的視頻字幕結(jié)果,平均僅比 SOTA 結(jié)果低 3 個(gè) CIDEr 點(diǎn)。考慮到模型尺寸,PaLI-3 在性能和實(shí)用性方面似乎都是一個(gè)絕佳的選擇。

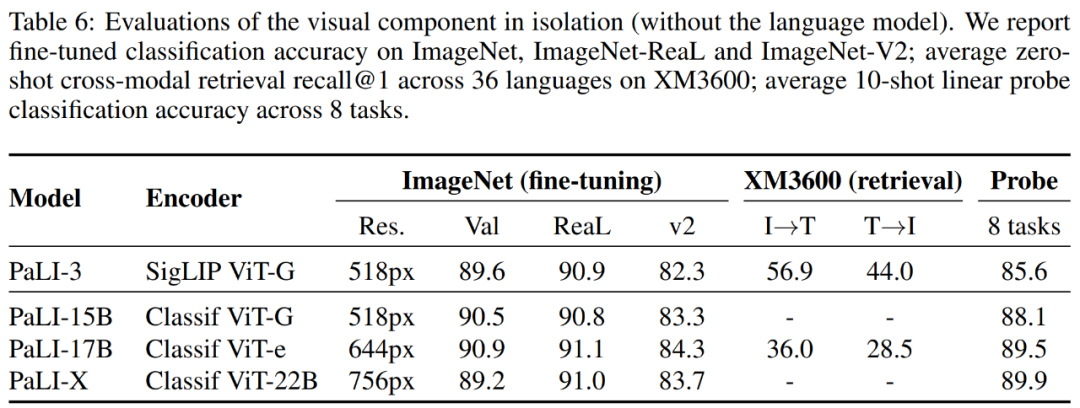

直接圖像編碼器評估

研究者還評估了 ViT-G 模型,ViT-G 可以理解為不是完整的 PaLI-3,結(jié)果如表 6 所示。

首先,該研究使用標(biāo)準(zhǔn)的 ImageNet 基準(zhǔn)測試及其兩個(gè)最流行的變體來測試圖像分類功能。結(jié)果表明,SigLIP 在 top-1 和 v2 準(zhǔn)確率方面略有落后,但在 ReaL 方面結(jié)果相當(dāng)。

其次,該研究報(bào)告了不同模型在 Crossmodal-3600 基準(zhǔn)上的結(jié)果。結(jié)果表明 SigLIP ViT-G 模型明顯優(yōu)于較大的 ViT-e 模型。

最后,該研究還報(bào)告了線性 probing 結(jié)果,結(jié)果表明 SigLIP 不及其他模型。

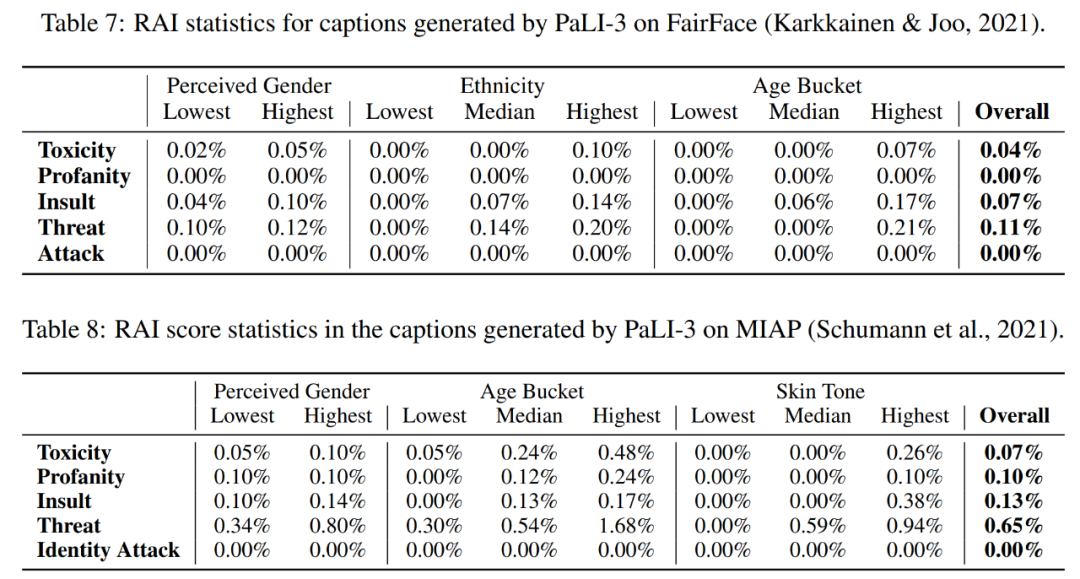

表 7 和表 8 評估了模型的公平性、偏差和其他潛在問題。

-

編碼器

+關(guān)注

關(guān)注

45文章

3639瀏覽量

134428 -

語言模型

+關(guān)注

關(guān)注

0文章

520瀏覽量

10268 -

大模型

+關(guān)注

關(guān)注

2文章

2423瀏覽量

2645

原文標(biāo)題:谷歌重磅新作PaLI-3:視覺語言新模型!更小、更快、更強(qiáng)

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

如何利用Transformers了解視覺語言模型

【大語言模型:原理與工程實(shí)踐】大語言模型的基礎(chǔ)技術(shù)

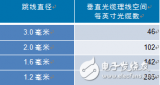

微型光纜的發(fā)展趨勢:更小、更快、更強(qiáng)韌

谷歌提出MorphNet:網(wǎng)絡(luò)規(guī)模更小、速度更快!

谷歌推出1.6萬億參數(shù)的人工智能語言模型,打破GPT-3記錄

谷歌開發(fā)出超過一萬億參數(shù)的語言模型,秒殺GPT-3

谷歌多模態(tài)大模型PaLI研究神經(jīng)網(wǎng)絡(luò)

谷歌提出PaLI:一種多模態(tài)大模型,刷新多個(gè)任務(wù)SOTA!

【機(jī)器視覺】歡創(chuàng)播報(bào) | 谷歌發(fā)布人工智能語言模型PaLM 2

機(jī)器人基于開源的多模態(tài)語言視覺大模型

谷歌重磅新作PaLI-3:視覺語言新模型!更小、更快、更強(qiáng)

谷歌重磅新作PaLI-3:視覺語言新模型!更小、更快、更強(qiáng)

評論