圖中體現(xiàn)了兩種幻覺,紅色部分錯(cuò)誤地描述了狗的顏色(屬性幻覺),藍(lán)色部分描述了圖中實(shí)際不存在的事物(目標(biāo)幻覺)。幻覺對(duì)模型的可靠性產(chǎn)生了顯著的負(fù)面影響,因此引起了許多研究者的重視。

以往的方法主要集中在 MLLM 本身,通過在訓(xùn)練數(shù)據(jù)以及架構(gòu)上進(jìn)行改進(jìn),以重新微調(diào)的方式訓(xùn)練一個(gè)新的 MLLM。這種方式會(huì)造成較大的數(shù)據(jù)構(gòu)建和訓(xùn)練開銷,且較難推廣到各種已有的 MLLMs。

近日,來自中科大等機(jī)構(gòu)的研究者們提出了一種免訓(xùn)練的即插即用的通用架構(gòu)“啄木鳥(Woodpecker)”,通過修正的方式解決 MLLM 輸出幻覺的問題。

論文鏈接:

https://arxiv.org/pdf/2310.16045.pdf

代碼鏈接:

https://github.com/BradyFU/Woodpecker

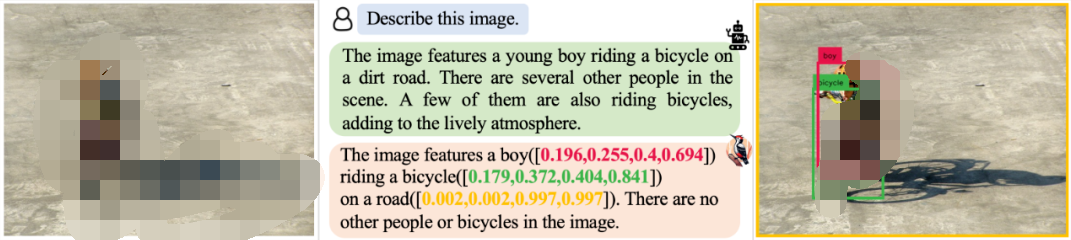

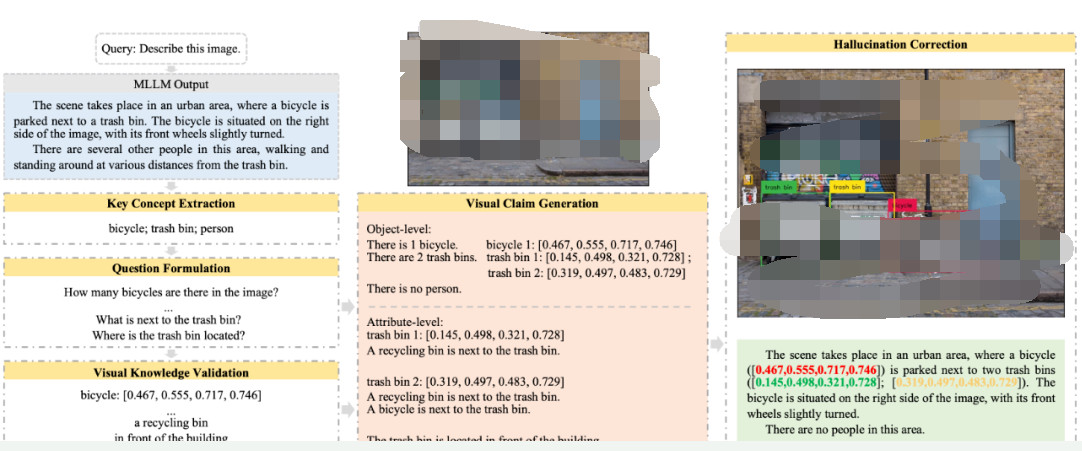

Woodpecker 可以修正各種場(chǎng)景下模型輸出的幻覺,并輸出檢測(cè)框作為引證,表明相應(yīng)的目標(biāo)確實(shí)存在。例如,面對(duì)描述任務(wù),Woodpecker 可以修正其中帶有幻覺的部分。

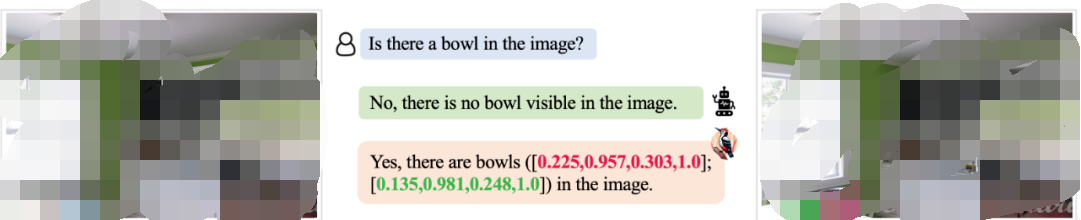

對(duì)于 MLLM 難以檢測(cè)到的小對(duì)象,Woodpecker 也可以精準(zhǔn)修正:

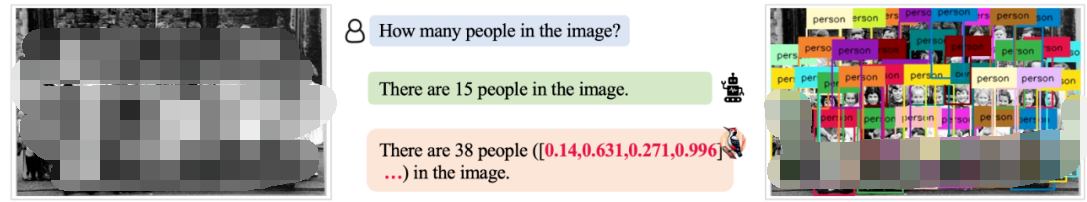

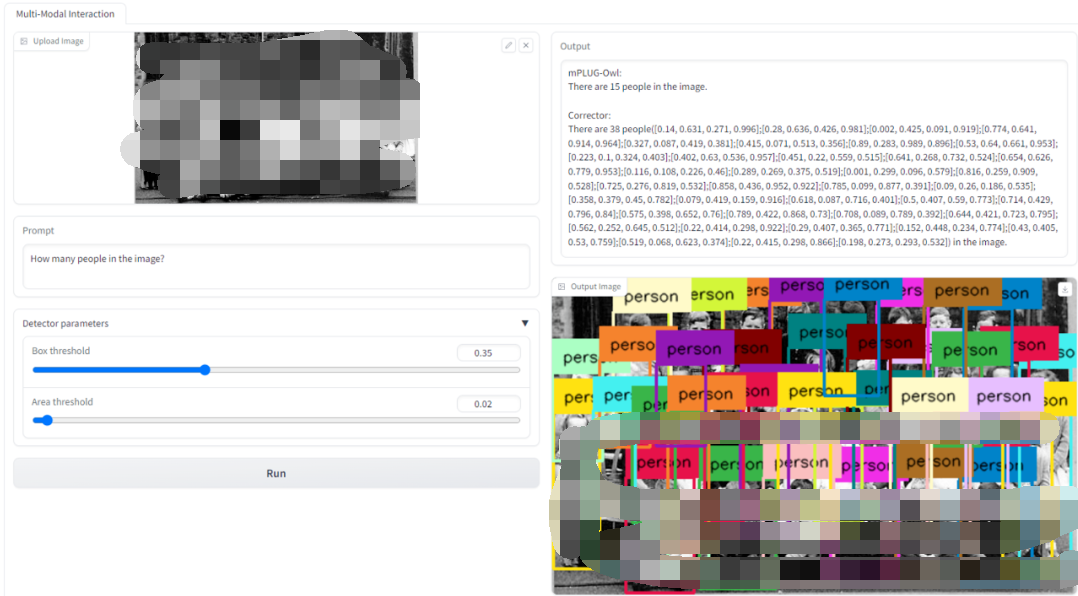

面對(duì) MLLM 難以解決的復(fù)雜的計(jì)數(shù)場(chǎng)景,Woodpecker 同樣可以進(jìn)行解決:

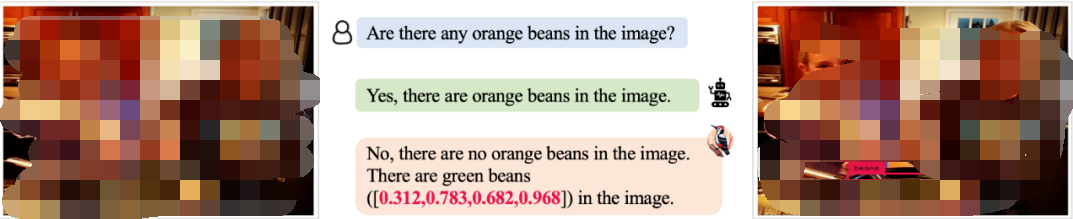

對(duì)于目標(biāo)屬性類的幻覺問題,Woopecker 處理地也很好:

我們還提供了 Demo 供讀者測(cè)試使用,如下圖所示,上傳圖片并輸入請(qǐng)求,就可以得到修正前以及修正后的模型答復(fù),以及供參考驗(yàn)證的新圖片。

方法

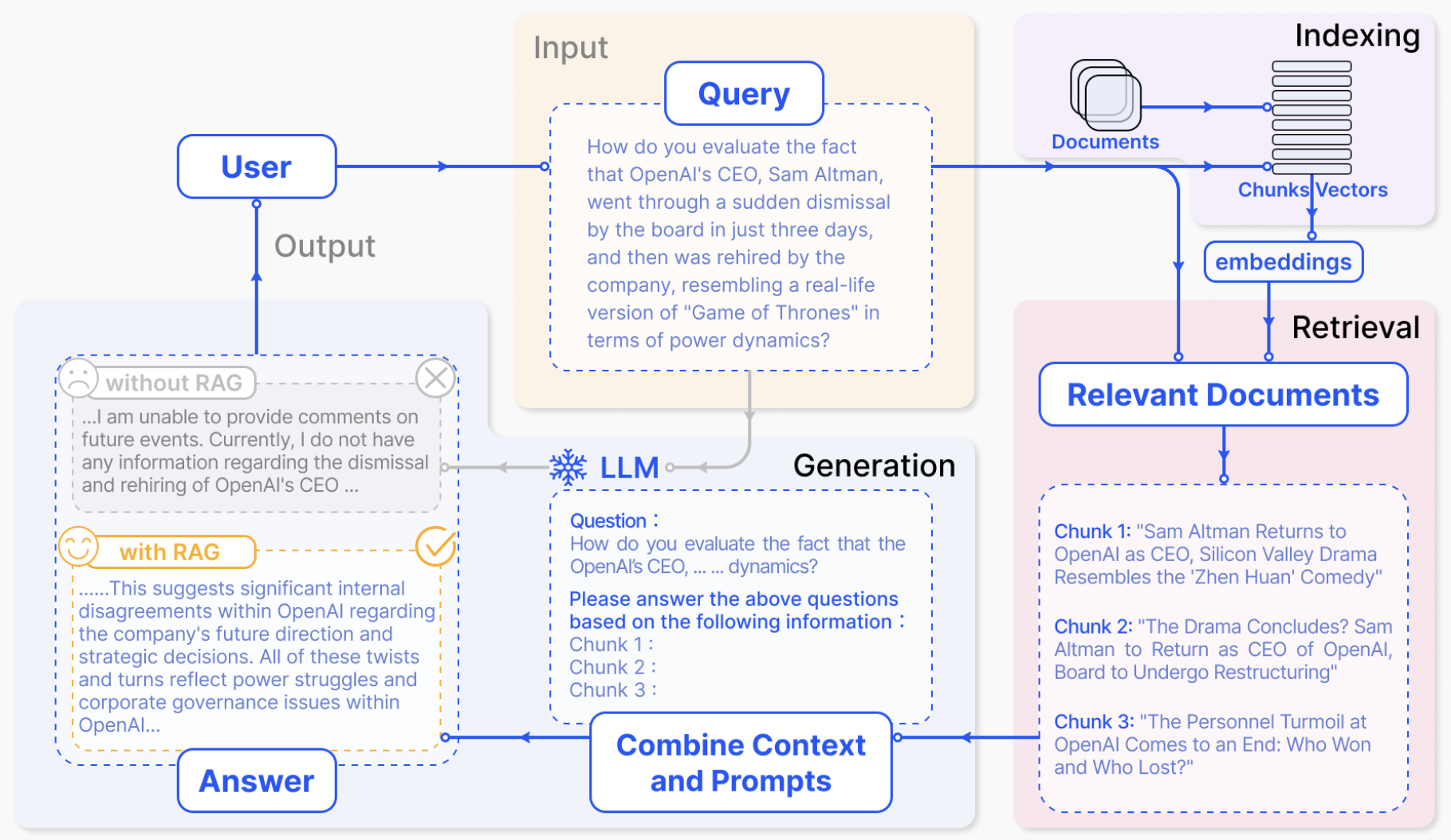

Woodpecker 的架構(gòu)如下,它包括五個(gè)主要步驟:關(guān)鍵概念提取、問題構(gòu)造、視覺知識(shí)檢驗(yàn)、視覺斷言生成以及幻覺修正。

關(guān)鍵概念提取:關(guān)鍵概念指的是 MLLM 的輸出中最可能存在幻覺的存在性目標(biāo),例如上圖描述中的“自行車;垃圾桶;人”。我們可以 Prompt 大語言模型來提取出這些關(guān)鍵概念,這些關(guān)鍵概念是后續(xù)步驟進(jìn)行的基礎(chǔ);

問題構(gòu)造:圍繞著前一步提取出的關(guān)鍵概念,Prompt 大語言模型來提出一些有助于檢驗(yàn)圖片描述真?zhèn)蔚膯栴},如“圖中有幾輛自行車?”、“垃圾桶邊上的是什么?”等等;

視覺知識(shí)檢驗(yàn):使用視覺基礎(chǔ)模型對(duì)提出的問題進(jìn)行檢驗(yàn),獲得與圖片以及描述文本相關(guān)的信息。例如,我們可以利用 GroundingDINO 來進(jìn)行目標(biāo)檢測(cè),確定關(guān)鍵目標(biāo)是否存在以及關(guān)鍵目標(biāo)的數(shù)量。這里我們認(rèn)為像 GroundingDINO 這類視覺基礎(chǔ)模型對(duì)圖片的感知能力比 MLLM 本身的感知能力更強(qiáng)。對(duì)于目標(biāo)顏色等這類屬性問題,我們可以利用 BLIP-2 來進(jìn)行回答。BLIP-2這類傳統(tǒng) VQA 模型輸出答案的長度有限,幻覺問題也更少;

視覺斷言生成:基于前兩步中獲得的問題以及對(duì)應(yīng)的視覺信息,合成結(jié)構(gòu)化的“視覺斷言”。這些視覺斷言可以看做與原有 MLLM 的回答以及輸入圖片相關(guān)的視覺知識(shí)庫;

幻覺修正:基于前面得到的,使用大語言模型對(duì) MLLM 的文本輸出進(jìn)行逐一修正,并提供目標(biāo)對(duì)應(yīng)的檢測(cè)框信息作為視覺檢驗(yàn)的參照。

?

?實(shí)驗(yàn)效果

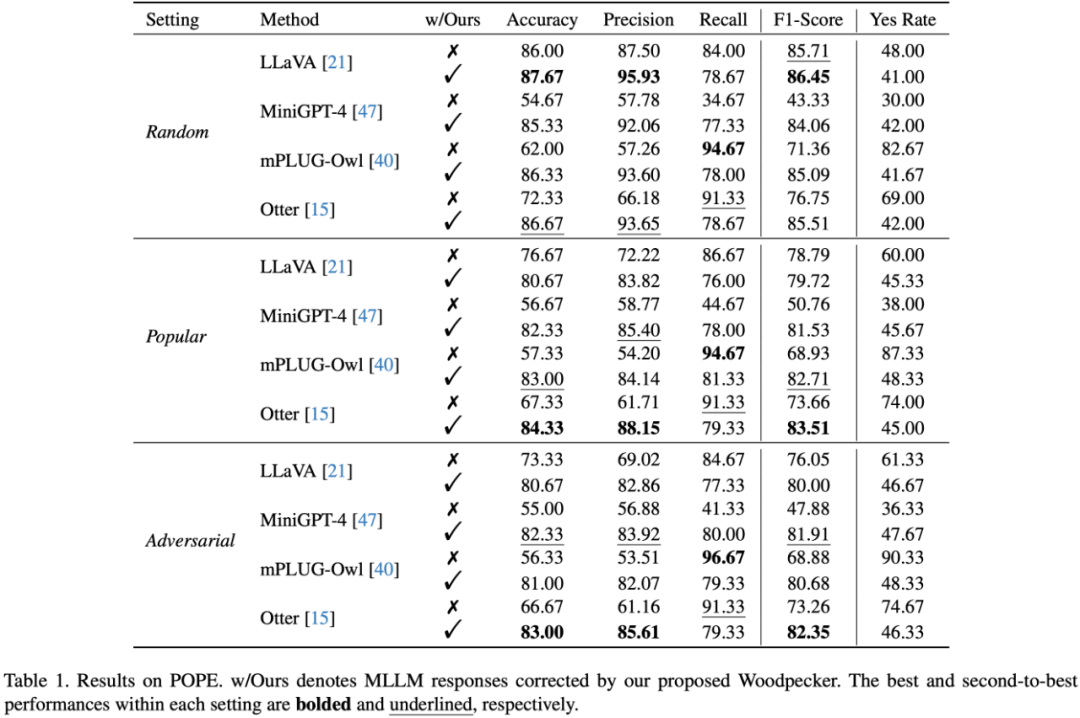

實(shí)驗(yàn)選取了幾個(gè)典型的 MLLM 作為基線,包括:LLaVA,mPLUG-Owl,Otter,MiniGPT-4 論文中首先測(cè)試了 Woodpecker 在面對(duì)目標(biāo)幻覺時(shí)的修正能力,在 POPE 驗(yàn)證集的實(shí)驗(yàn)結(jié)果如下表所示:

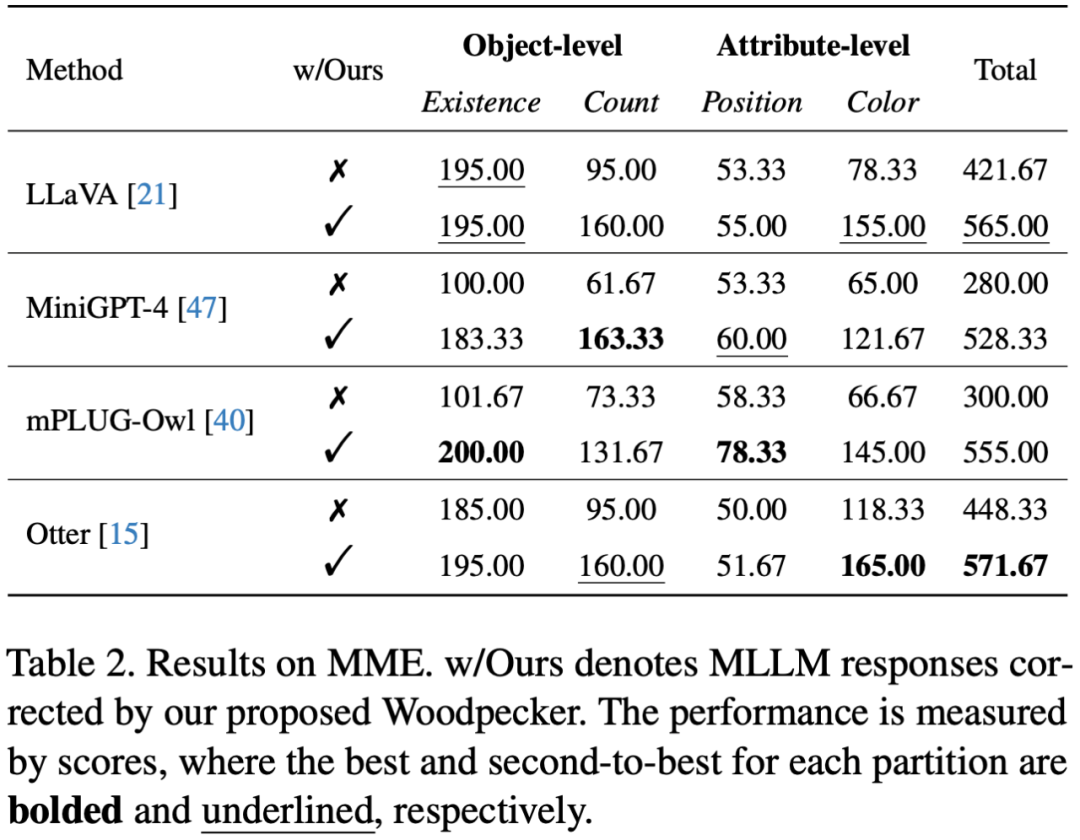

此外,研究者還應(yīng)用更全面的驗(yàn)證集 MME,進(jìn)一步測(cè)試 Woodpecker 在面對(duì)屬性幻覺時(shí)的修正能力,結(jié)果如下表所示:

從表中可見 Woodpecker 不僅在應(yīng)對(duì)目標(biāo)幻覺時(shí)有效,在修正顏色等屬性幻覺時(shí)也具有出色的表現(xiàn)。LLaVA 的顏色得分從 78.33 分大幅提升到 155 分!經(jīng)過 Woodpecker 修正后,四個(gè)基線模型在四個(gè)測(cè)試子集上的總分均超過 500 分,在總體感知能力上獲得了顯著提升。

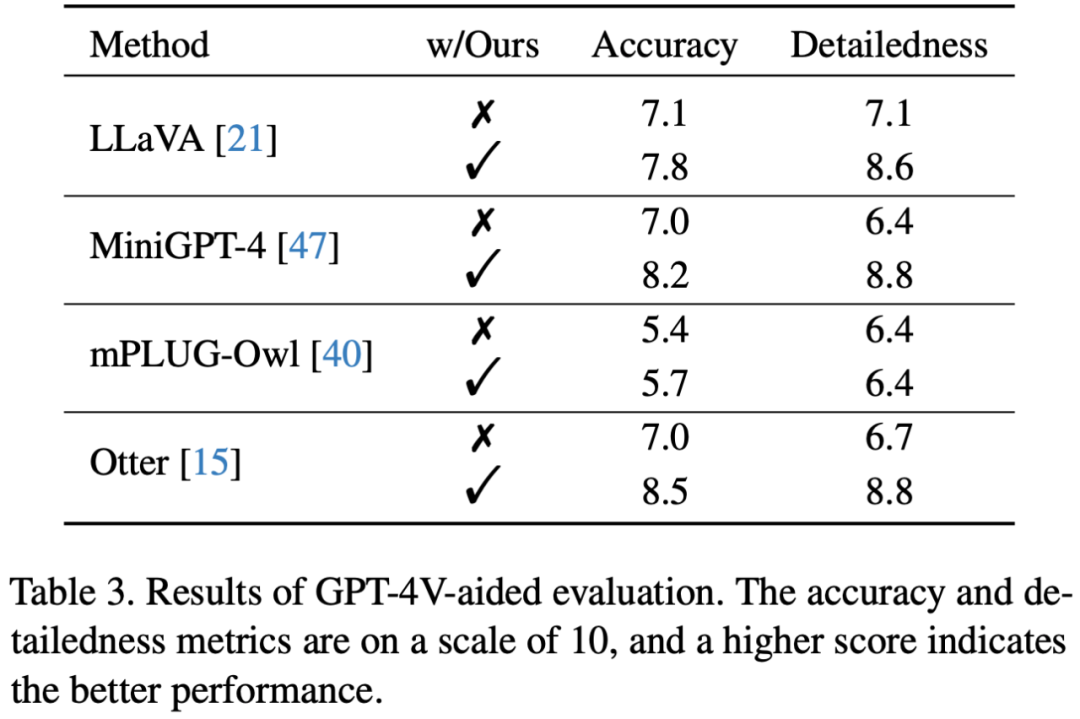

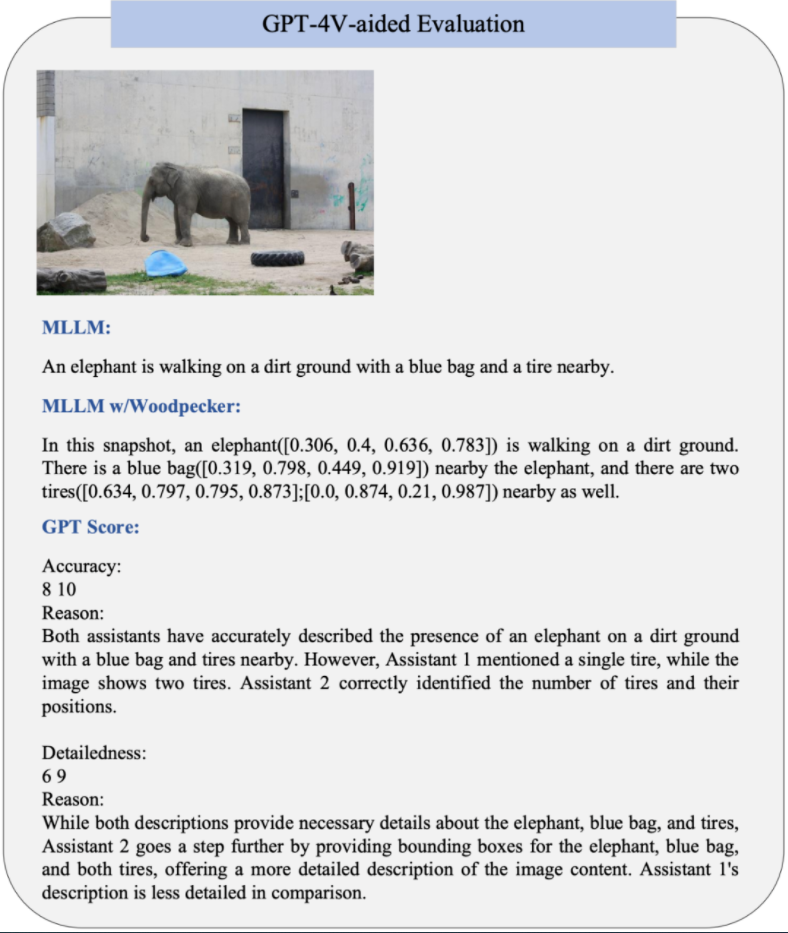

為了更直接地衡量修正表現(xiàn),更直接的方式是使用開放評(píng)測(cè)。不同于以往將圖片轉(zhuǎn)譯后送入純文本 GPT-4 的做法,文章利用 OpenAI 最近開放的視覺接口,提出使用 GPT-4 (Vision) 對(duì)修正前后的圖片描述直接對(duì)下列兩個(gè)維度進(jìn)行打分:- 準(zhǔn)確度:模型的答復(fù)相對(duì)于圖片內(nèi)容是否準(zhǔn)確

-

詳細(xì)程度:模型答復(fù)的細(xì)節(jié)豐富度

結(jié)果表明經(jīng)過 Woodpecker 修正后圖片描述的準(zhǔn)確性有一定的提升,這說明該框架可以有效修正描述中幻視的部分。另一方面,Woodpecker 修正后引入的定位信息豐富了文本描述,提供了進(jìn)一步的位置信息,從而提升了細(xì)節(jié)豐富度。GPT-4V 輔助的評(píng)測(cè)樣例如下圖所示:

·

原文標(biāo)題:幻覺降低30%!首個(gè)多模態(tài)大模型幻覺修正工作Woodpecker

文章出處:【微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2909文章

44557瀏覽量

372768

原文標(biāo)題:幻覺降低30%!首個(gè)多模態(tài)大模型幻覺修正工作Woodpecker

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

商湯日日新多模態(tài)大模型權(quán)威評(píng)測(cè)第一

李彥宏:大模型行業(yè)消除幻覺,iRAG技術(shù)引領(lǐng)文生圖新紀(jì)元

利用OpenVINO部署Qwen2多模態(tài)模型

TaD+RAG-緩解大模型“幻覺”的組合新療法

阿里達(dá)摩院提出“知識(shí)鏈”框架,降低大模型幻覺

商湯科技與海通證券攜手發(fā)布金融行業(yè)首個(gè)多模態(tài)全棧式大模型

人大系初創(chuàng)公司智子引擎發(fā)布全新多模態(tài)大模型Awaker 1.0

商湯科技聯(lián)合海通證券發(fā)布業(yè)內(nèi)首個(gè)面向金融行業(yè)的多模態(tài)全棧式大模型

商湯科技發(fā)布5.0多模態(tài)大模型,綜合能力全面對(duì)標(biāo)GPT-4 Turbo

微軟下架最新大語言模型WizardLM-2,緣因“幻覺測(cè)試疏忽”

利用知識(shí)圖譜與Llama-Index技術(shù)構(gòu)建大模型驅(qū)動(dòng)的RAG系統(tǒng)(下)

機(jī)器人基于開源的多模態(tài)語言視覺大模型

什么是多模態(tài)?多模態(tài)的難題是什么?

從Google多模態(tài)大模型看后續(xù)大模型應(yīng)該具備哪些能力

幻覺降低30%!首個(gè)多模態(tài)大模型幻覺修正工作Woodpecker

幻覺降低30%!首個(gè)多模態(tài)大模型幻覺修正工作Woodpecker

評(píng)論