概述

目標檢測是具有廣泛實際應用的計算機視覺任務,如自動駕駛和醫(yī)學影像。隨著DETR 的出現(xiàn),基于Transformer的檢測器的發(fā)展令人矚目,并且在最新的DETR系列方法在COCO挑戰(zhàn)中以明顯的優(yōu)勢擊敗了基于CNN的檢測器。

但是,現(xiàn)有DETR系列模型在非COCO數(shù)據(jù)集上表現(xiàn)較差,且預測框不夠準確。

本文提出了Cascade-DETR用于高質量通用目標檢測。我們通過提出Cascade Attention層同時解決不同域的泛化問題和定位精度問題,它通過限制注意力到先前的預測框,將以對象中心的信息直接輸入到檢測解碼器中。為進一步提高準確性,我們還重新訪問查詢分數(shù)。我們預測查詢期望的IoU,而不再依賴于分類分數(shù),從而大大提高了校準后的置信度。最后,我們引入了通用目標檢測基準UDB10,其中包含10個數(shù)據(jù)集。同時在COCO上也推進了最先進的技術,Cascade-DETR大大改進了UDB10中所有數(shù)據(jù)集上的基于DETR的檢測器的性能 ,在某些情況下甚至提高了超過10 mAP。在嚴格的質量要求下,提升甚至更加明顯。這里也推薦「3D視覺工坊」新課程《國內首個面向自動駕駛目標檢測領域的Transformer原理與實戰(zhàn)課程》。

背景簡述

現(xiàn)有的DETR系列模型在非COCO數(shù)據(jù)集上表現(xiàn)較差,且預測框不夠準確。其主要原因是:DETR在檢測頭中用全局交叉注意力替換了原來的卷積,刪除了以中心為中心的先驗知識;另一方面,DETR僅依賴分類分數(shù)評分查詢提議,忽略了定位質量。考慮到這些問題,我們主要進行了以下兩個方面創(chuàng)新:

方法:(1) 提出連續(xù)注意力機制,將交叉注意力逐層限制在先前預測框內,以聚焦對象區(qū)域并引入對象中心先驗知識。(2) 添加IoU預測分支,以感知每一個查詢建議的定位質量,用于重新標定查詢得分。

網(wǎng)絡:(1) 引入連續(xù)注意力的檢測Transformer解碼器,包含多個解碼層。(2) 每層連續(xù)注意力使用上一層的預測框約束其注意力區(qū)域。

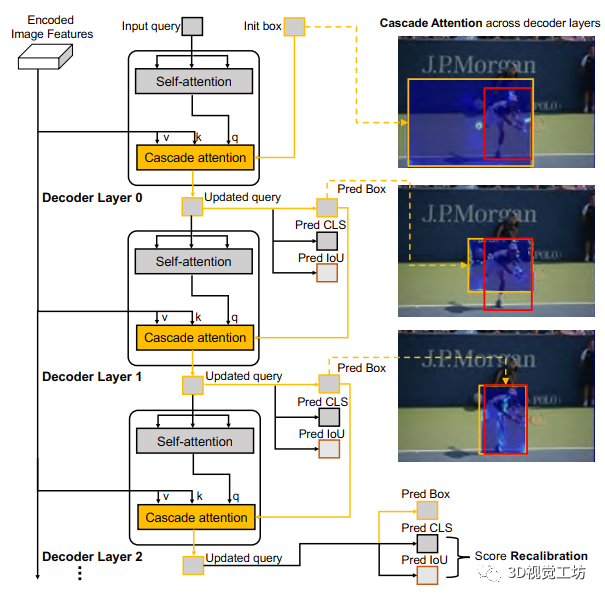

圖1 Cascade DETR 的transformer解碼器

方法解析

在本節(jié)中,首先介紹了標準DETR解碼器的設計。然后分析了Cascade-DETR整體架構,最后逐一解釋了連續(xù)注意力、IoU感知查詢、再標定訓練和推理細節(jié)。

1.標準DETR解碼器

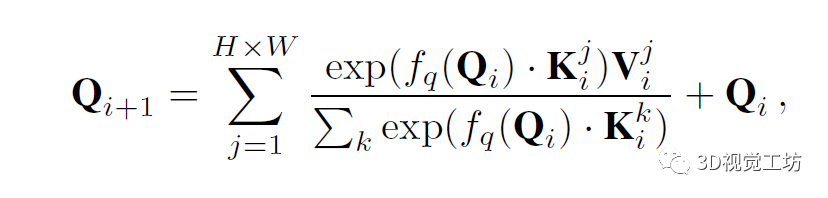

標準DETR解碼器是由一組交叉注意層和自注意層組成,這些層迭代更新一組查詢,初始化為可學習的常量。在第i層,查詢Q∈RN×D首先輸入到自注意模塊,接著進行圖像特征的交叉注意,其大小為H×W×D。交叉注意力計算為對整個特征圖的加權和,

其中K和V分別表示從圖像特征中提取的鍵和值圖。索引i表示交叉注意力層,j是圖像上的2D空間位置,fq表示查詢變換函數(shù)。

更新的查詢Qi+1然后分別通過兩個并行線性層fbox和fscore輸入到邊界框B(i+1)和查詢分數(shù)S(i+1)的預測中,即B(i+1)=fbox(Q(i+1))和S(i+1)=fcls(Q(i+1))。大小為N×(C+1)的查詢分數(shù)矩陣S(i+1)包含數(shù)據(jù)集所有C類的所有輸入查詢的類別概率。

2.Cascade-DETR架構

在這一節(jié)中,我們介紹Cascade-DETR的架構,其向標準轉換解碼器引入局部目標中心偏置。與現(xiàn)有的基于DETR的方法(如DAB-DETR和DN-DETR)類似,我們的架構包含transformer編碼器來提取圖像特征。編碼的特征與位置編碼一起輸入到transformer解碼器。可學習查詢也輸入到解碼器中,以通過交叉注意力進行目標定位和分類。Cascade-DETR中,連續(xù)注意力和IoU感知查詢重新標定是兩個新模塊,這兩個模塊幾乎不增加計算時間或模型參數(shù),但顯著提高了檢測質量和泛化能力。

3.連續(xù)注意力

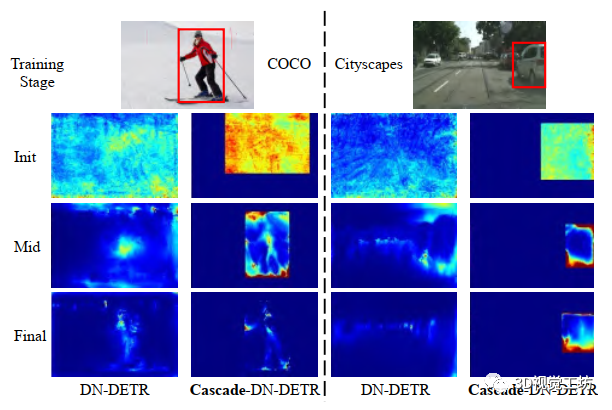

圖2 DNDETR和Cascade-DN-DETR在COCO和Cityscapes數(shù)據(jù)集上的交叉注意力圖的可視化比較

在標準DETR解碼器中,可學習查詢在整個圖像要素上全局參與,如式1所示。然而,為了準確實現(xiàn)目標分類和定位,我們認為對象周圍的局部信息最為關鍵。全局上下文可以通過查詢之間的自注意提取。在圖2中,我們觀察到在COCO訓練期間,交叉注意力分布趨于收斂到預測對象位置周圍的區(qū)域。盡管transformer模型可以端到端學習這種歸納偏置,但它需要大量的數(shù)據(jù)。當訓練數(shù)據(jù)集較小或圖像樣式與ImageNet中的樣式完全不同時,這個問題變得更加顯著。

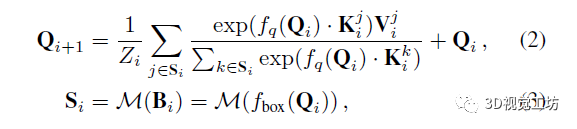

為解決上述問題,我們將對象中心先驗視為已知約束,以將其整合到初始化過程和訓練程序中,如圖1所示。我們在第i+1層設計連續(xù)注意力為:

其中Si是前一解碼層i中的預測邊界框Bi內的2D位置集合。連續(xù)結構利用DETR系列檢測器中每個解碼層后預測的Bi將更準確的屬性。因此,框約束的交叉注意力區(qū)域Si不僅帶來對象中心偏置,而且會逐層加強(參見圖1)。隨著每層可以獲得更準確的交叉注意特征,連續(xù)注意力反過來也可提升每層的檢測準確率。

我們通過圖2中的注意力圖驗證了我們的假設。我們同時展示了COCO和Cityscapes上DN-DETR模型的初始和最終注意力圖。在COCO上,我們觀察到無論使用DN-DETR還是Cascade-DN-DETR,隨機初始化查詢的交叉注意力最終都會收斂到語義明顯不同的位置。然而,在Cityscapes上,兩種方法之間存在明顯對比,對象中心知識的融合將注意力集中在圖像最相關的部分更為重要。

與其他方法相比,我們的Cascade-DETR設計更簡單。DETR解碼器中的每層預測框都直接用于約束下一層的交叉注意力范圍。這種歸納偏置使DETR能夠快速收斂,并且在特別是小型和多樣化數(shù)據(jù)集上擁有卓越的性能。

4.IoU感知查詢再標定

大多數(shù)基于DETR的檢測器將300甚至900個可學習查詢作為輸入提供給transformer解碼器,并為每個查詢預測一個框。在計算最終檢測結果時,采用分類置信度作為所有查詢提議的排序標準。然而,分類分數(shù)并沒有明確考慮預測邊界框的準確性,這對于選擇高質量提議至關重要。因此,我們引入了IoU感知查詢重新標定,通過添加IoU預測分支來重新標定查詢的置信度,以獲得更準確的校準置信度,這更好地反映了預測的質量。

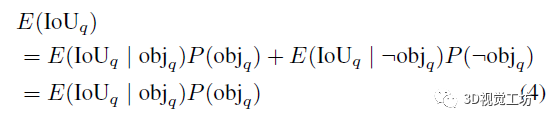

我們不再使用分類置信度對查詢進行評分,而是使用其與真值框的期望IoU進行評分。令E(IoUq)為查詢q的期望真值IoU。此外,令P(objq)表示從分類概率獲得的q指示對象的概率。查詢的期望IoU計算為

這里,?表示否定二值隨機變量。第二個等號遵循非對象的期望IoU為零:E(IoUq|?objq)=0。

為預測期望IoU(4),我們引入一個額外的分支來預測存在地面實況的期望IoU E(IoUq|objq),如圖1所示。具體而言,我們在平行于分類和框回歸分支之外簡單地再使用一個線性層。如式(4)中導出的,最后的查詢分數(shù)然后計算為預測IoU與原始分類置信度P(objq)的乘積。

我們用L2損失監(jiān)督IoU預測與地面真值IoUGTq之間的差異,

僅當查詢q具有分配的對應真值時才應用損失,因為我們在期望值中對對象的存在進行了條件化。注意,L2損失意味著學習高斯分布上IoU值的均值,即期望值。我們在實驗部分的表5中對這個損失選擇進行分析。這里也推薦「3D視覺工坊」新課程《國內首個面向自動駕駛目標檢測領域的Transformer原理與實戰(zhàn)課程》。

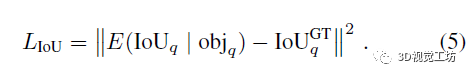

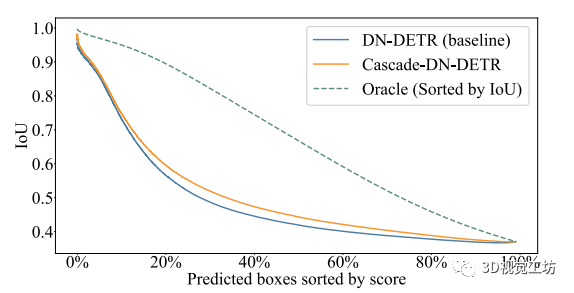

圖3 查詢定位質量(IoU到GT框)和查詢評分之間的稀疏圖

為分析我們的IoU感知查詢再標定的優(yōu)勢,我們在COCO上的所有預測上生成稀疏化圖,如圖3所示。根據(jù)置信度對所有預測進行排序。然后繪制擁有最高置信度的前N個預測的平均IoU,通過在x軸上變化N。Oracle表示上確界,通過考慮地面真值IoU獲得。與不進行查詢再標定的Cascade-DN-DETR(藍色曲線)相比,我們的再標定結果(橙色曲線)得出了明顯更好的結果排序,從而導致更高的IoU。

5.訓練和推理細節(jié)

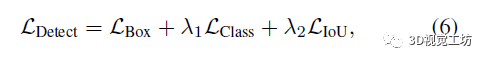

我們使用多任務損失函數(shù)端到端訓練我們的Cascade-DETR,

其中LDetect同時監(jiān)督位置預測和類別分類,源自DETR檢測器。超參數(shù)λ1和λ2平衡損失函數(shù)在驗證集上分別設置為{1.0,2.0}。在每個解碼層后采用FFN和匈牙利損失。FFN在每個預測層中共享模型參數(shù)。

在推理期間,我們一致使用連續(xù)注意力,因為它僅依賴于DETR解碼器中每層的預測框。對于查詢評分的校準方式,如第4節(jié)所述,我們僅將其應用于最終的transformer解碼器層。

實驗結果

我們在COCO、UVO、Cityscapes和構建的UDB10基準測試集上將Cascade-DETR與最新目標檢測方法進行了比較。我們將Cascade-DETR集成到三個代表性方法中,發(fā)現(xiàn)Cascade-DETR相對于強基線獲得了一致的大幅提升。

結論

我們提出了Cascade-DETR,是適用于高質量通用目標檢測的第一個基于DETR的檢測器。通過引入局部對象中心先驗知識,Cascade-DETR在通用檢測應用中實現(xiàn)顯著優(yōu)勢,特別是在更高的IoU閾值下。與其他基于DETR的檢測器相比,我們的方法不僅在COCO數(shù)據(jù)集表現(xiàn)優(yōu)異,也可以在更多的現(xiàn)實生活和實際應用場景中展現(xiàn)出良好的性能。

-

解碼器

+關注

關注

9文章

1143瀏覽量

40770 -

檢測器

+關注

關注

1文章

865瀏覽量

47705 -

目標檢測

+關注

關注

0文章

209瀏覽量

15619

原文標題:ICCV2023 | 第一個基于DETR的高質量通用目標檢測方法

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

第一個基于DETR的高質量通用目標檢測方法

第一個基于DETR的高質量通用目標檢測方法

評論