代碼鏈接:

https://github.com/ML-GSAI/Understanding-GDA

概述

生成式數(shù)據(jù)擴(kuò)增通過(guò)條件生成模型生成新樣本來(lái)擴(kuò)展數(shù)據(jù)集,從而提高各種學(xué)習(xí)任務(wù)的分類性能。然而,很少有人從理論上研究生成數(shù)據(jù)增強(qiáng)的效果。為了填補(bǔ)這一空白,我們?cè)谶@種非獨(dú)立同分布環(huán)境下構(gòu)建了基于穩(wěn)定性的通用泛化誤差界。基于通用的泛化界,我們進(jìn)一步了探究了高斯混合模型和生成對(duì)抗網(wǎng)絡(luò)的學(xué)習(xí)情況。

在這兩種情況下,我們證明了,雖然生成式數(shù)據(jù)增強(qiáng)并不能享受更快的學(xué)習(xí)率,但當(dāng)訓(xùn)練集較小時(shí),它可以在一個(gè)常數(shù)的水平上提高學(xué)習(xí)保證,這在發(fā)生過(guò)擬合時(shí)是非常重要的。最后,高斯混合模型的仿真結(jié)果和生成式對(duì)抗網(wǎng)絡(luò)的實(shí)驗(yàn)結(jié)果都支持我們的理論結(jié)論。

主要的理論結(jié)果

2.1 符號(hào)與定義

讓 作為數(shù)據(jù)輸入空間, 作為標(biāo)簽空間。定義 為 上的真實(shí)分布。給定集合 ,我們定義 為去掉第 個(gè)數(shù)據(jù)后剩下的集合, 為把第 個(gè)數(shù)據(jù)換成 后的集合。我們用 表示 total variation distance。

我們讓 為所有從 到 的所有可測(cè)函數(shù), 為學(xué)習(xí)算法,為從數(shù)據(jù)集 中學(xué)到的映射。對(duì)于一個(gè)學(xué)到的映射 和損失函數(shù),真實(shí)誤差 被定義為。相應(yīng)的經(jīng)驗(yàn)的誤差 被定義為。

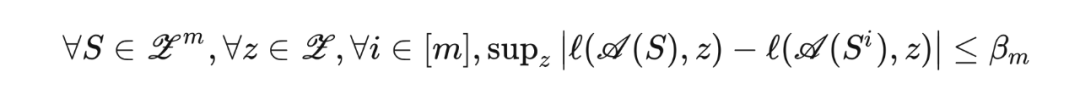

我們文章理論推導(dǎo)采用的是穩(wěn)定性框架,我們稱算法 相對(duì)于損失函數(shù) 是一致 穩(wěn)定的,如果

2.2 生成式數(shù)據(jù)增強(qiáng)

給定帶有 個(gè) i.i.d. 樣本的 數(shù)據(jù)集,我們能訓(xùn)練一個(gè)條件生成模型 ,并將學(xué)到的分布定義為 。基于訓(xùn)練得到的條件生成模型,我們能生成一個(gè)新的具有 個(gè) i.i.d. 樣本的數(shù)據(jù)集 。我們記增廣后的數(shù)據(jù)集 大小為 。我們可以在增廣后的數(shù)據(jù)集上學(xué)到映射 。為了理解生成式數(shù)據(jù)增強(qiáng),我們關(guān)心泛化誤差 。據(jù)我們所知,這是第一個(gè)理解生成式數(shù)據(jù)增強(qiáng)泛化誤差的工作。2.3 一般情況

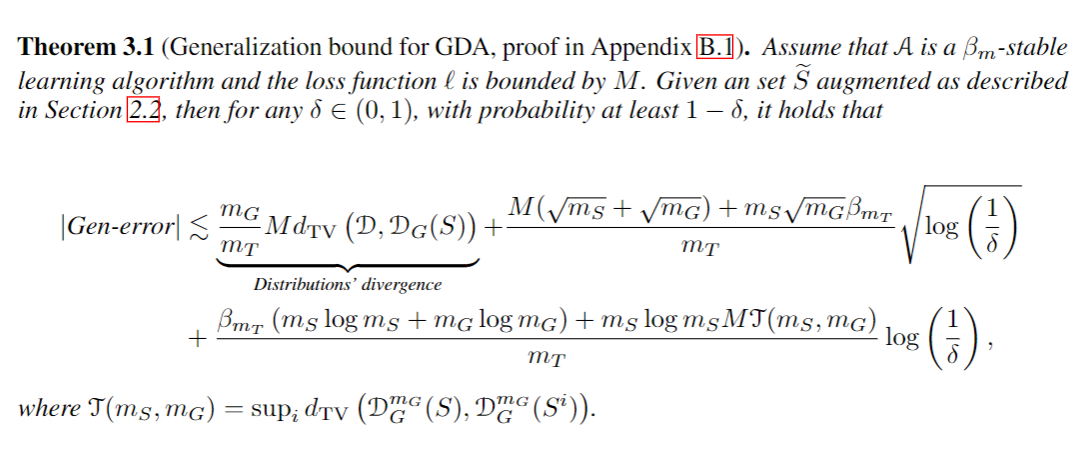

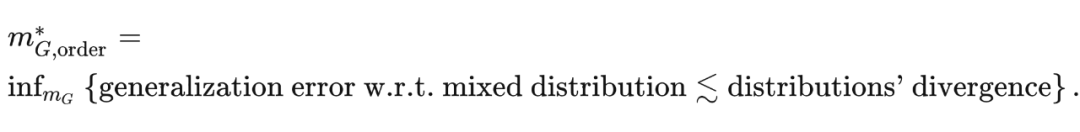

我們可以對(duì)于任意的生成器和一致 穩(wěn)定的分類器,推得如下的泛化誤差: ▲ general一般來(lái)說(shuō),我們比較關(guān)心泛化誤差界關(guān)于樣本數(shù) 的收斂率。將 看成超參數(shù),并將后面兩項(xiàng)記為 generalization error w.r.t. mixed distribution,我們可以定義如下的“最有效的增強(qiáng)數(shù)量”:

▲ general一般來(lái)說(shuō),我們比較關(guān)心泛化誤差界關(guān)于樣本數(shù) 的收斂率。將 看成超參數(shù),并將后面兩項(xiàng)記為 generalization error w.r.t. mixed distribution,我們可以定義如下的“最有效的增強(qiáng)數(shù)量”:

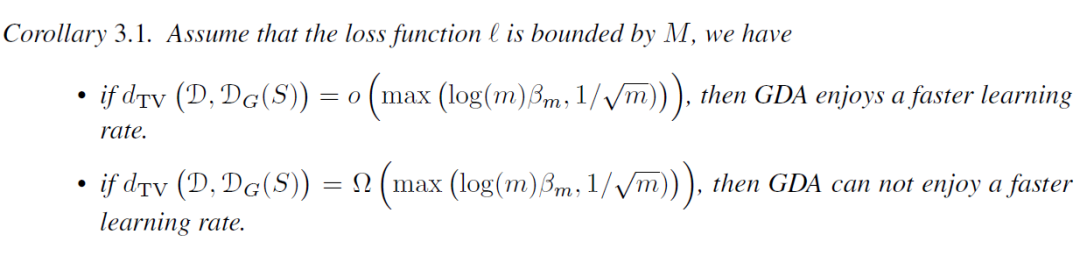

▲ corollary

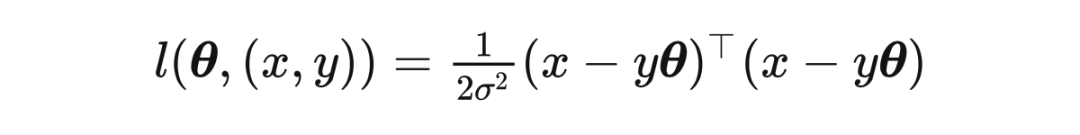

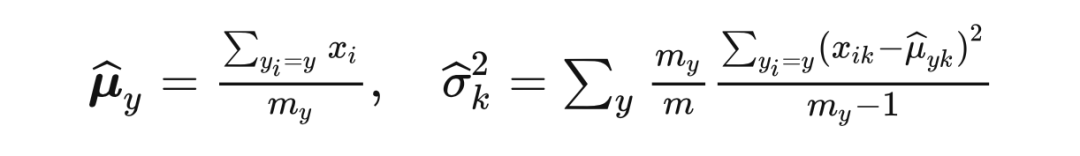

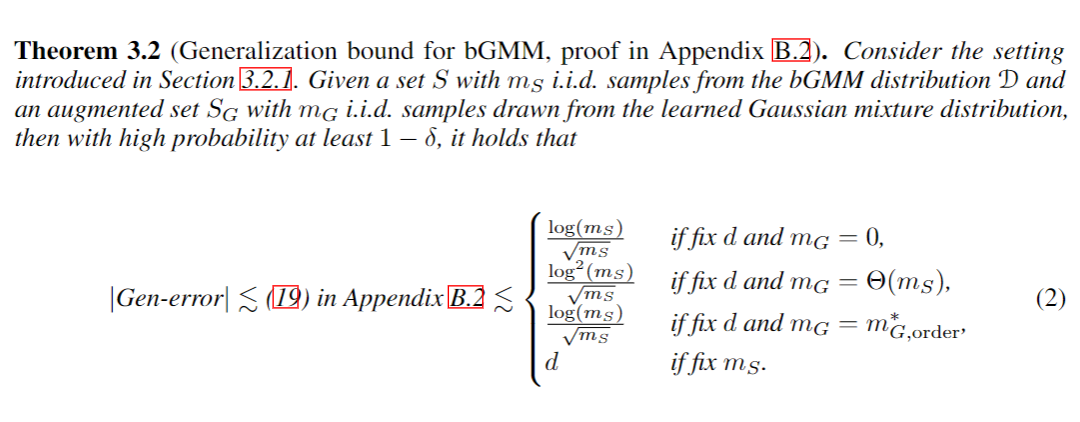

2.4 高斯混合模型為了驗(yàn)證我們理論的正確性,我們先考慮了一個(gè)簡(jiǎn)單的高斯混合模型的 setting。 混合高斯分布。我們考慮二分類任務(wù) 。我們假設(shè)真實(shí)分布滿足 and 。我們假設(shè) 的分布是已知的。 線性分類器。我們考慮一個(gè)被 參數(shù)化的分類器,預(yù)測(cè)函數(shù)為 。給定訓(xùn)練集, 通過(guò)最小化負(fù)對(duì)數(shù)似然損失函數(shù)得到,即最小化

- 當(dāng)數(shù)據(jù)量 足夠時(shí),即使我們采用“最有效的增強(qiáng)數(shù)量”,生成式數(shù)據(jù)增強(qiáng)也難以提高下游任務(wù)的分類性能。

- 當(dāng)數(shù)據(jù)量 較小的,此時(shí)主導(dǎo)泛化誤差的是維度等其他項(xiàng),此時(shí)進(jìn)行生成式數(shù)據(jù)增強(qiáng)可以常數(shù)級(jí)降低泛化誤差,這意味著在過(guò)擬合的場(chǎng)景下,生成式數(shù)據(jù)增強(qiáng)是很有必要的。

2.5 生成對(duì)抗網(wǎng)絡(luò)

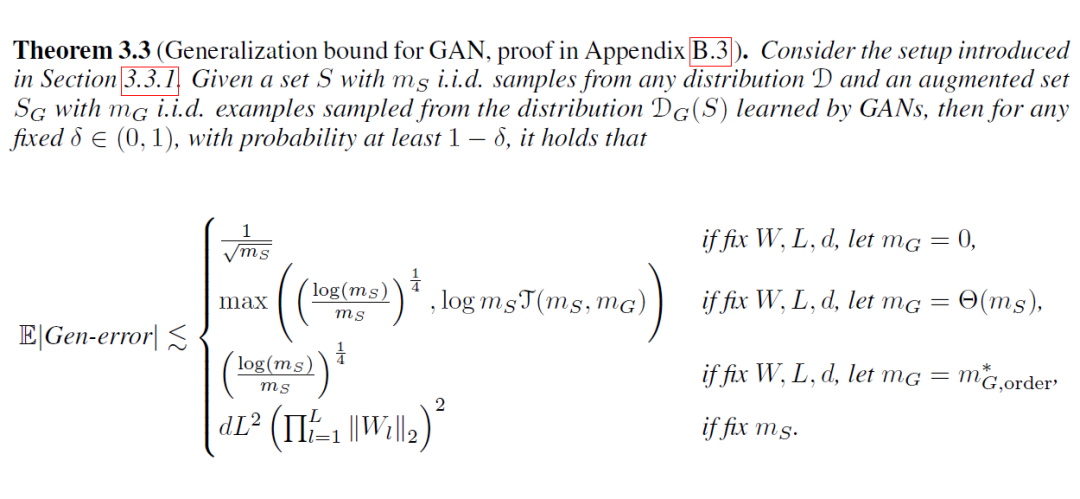

我們也考慮了深度學(xué)習(xí)的情況。我們假設(shè)生成模型為 MLP 生成對(duì)抗網(wǎng)絡(luò),分類器為 層 MLP 或者 CNN。損失函數(shù)為二元交叉熵,優(yōu)化算法為 SGD。我們假設(shè)損失函數(shù)平滑,并且第 層的神經(jīng)網(wǎng)絡(luò)參數(shù)可以被 控制。我們可以推得如下的結(jié)論:

- 當(dāng)數(shù)據(jù)量 足夠時(shí),生成式數(shù)據(jù)增強(qiáng)也難以提高下游任務(wù)的分類性能,甚至?xí)夯?/span>

- 當(dāng)數(shù)據(jù)量 較小的,此時(shí)主導(dǎo)泛化誤差的是維度等其他項(xiàng),此時(shí)進(jìn)行生成式數(shù)據(jù)增強(qiáng)可以常數(shù)級(jí)降低泛化誤差,同樣地,這意味著在過(guò)擬合的場(chǎng)景下,生成式數(shù)據(jù)增強(qiáng)是很有必要的。

實(shí)驗(yàn)

3.1 高斯混合模型模擬實(shí)驗(yàn)

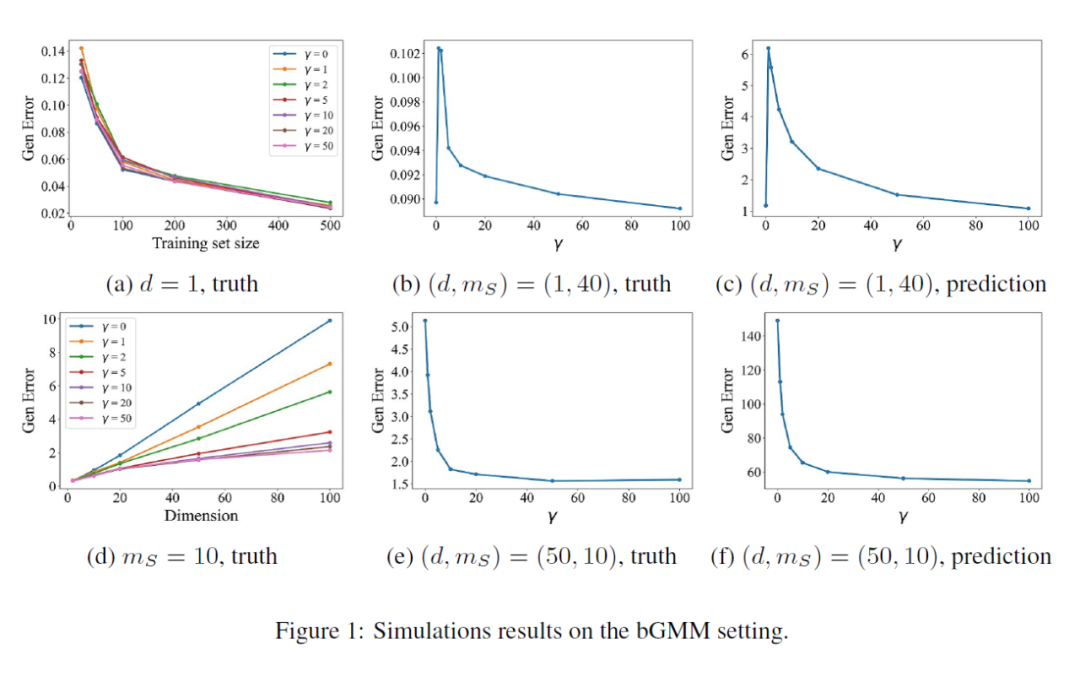

我們?cè)诨旌细咚狗植忌向?yàn)證我們的理論,我們調(diào)整數(shù)據(jù)量 ,數(shù)據(jù)維度 以及 。實(shí)驗(yàn)結(jié)果如下圖所示:

▲ simulation

- 觀察圖(a),我們可以發(fā)現(xiàn)當(dāng) 相對(duì)于 足夠大的時(shí)候,生成式數(shù)據(jù)增強(qiáng)的引入并不能明顯改變泛化誤差。

- 觀察圖(d),我們可以發(fā)現(xiàn)當(dāng) 固定時(shí),真實(shí)的泛化誤差確實(shí)是 階的,且隨著增強(qiáng)數(shù)量 的增大,泛化誤差呈現(xiàn)常數(shù)級(jí)的降低。

- 另外 4 張圖,我們選取了兩種情況,驗(yàn)證了我們的 bound 能在趨勢(shì)上一定程度上預(yù)測(cè)泛化誤差。

▲ deep

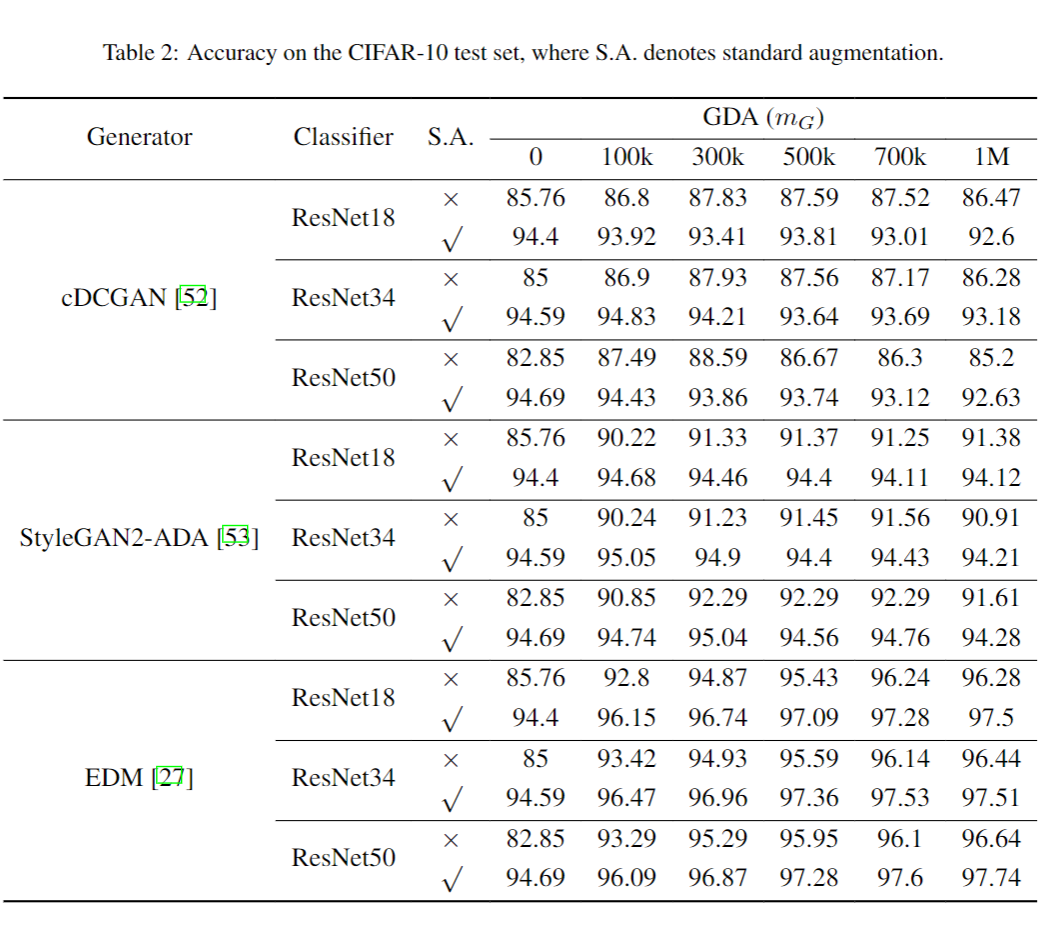

- 在沒(méi)有額外數(shù)據(jù)增強(qiáng)的時(shí)候, 較小,分類器陷入了嚴(yán)重的過(guò)擬合。此時(shí),即使選取的 cDCGAN 很古早(bad GAN),生成式數(shù)據(jù)增強(qiáng)都能帶來(lái)明顯的提升。

- 在有額外數(shù)據(jù)增強(qiáng)的時(shí)候, 充足。此時(shí),即使選取的 StyleGAN 很先進(jìn)(SOTA GAN),生成式數(shù)據(jù)增強(qiáng)都難以帶來(lái)明顯的提升,在 50k 和 100k 增強(qiáng)的情況下甚至都造成了一致的損害。

-

我們也測(cè)試了一個(gè) SOTA 的擴(kuò)散模型 EDM,發(fā)現(xiàn)即使在有額外數(shù)據(jù)增強(qiáng)的時(shí)候,生成式數(shù)據(jù)增強(qiáng)也能提升分類效果。這意味著擴(kuò)散模型學(xué)習(xí)分布的能力可能會(huì)優(yōu)于 GAN。

原文標(biāo)題:NeurIPS 2023 | 如何從理論上研究生成式數(shù)據(jù)增強(qiáng)的效果?

文章出處:【微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2909文章

44578瀏覽量

372847

原文標(biāo)題:NeurIPS 2023 | 如何從理論上研究生成式數(shù)據(jù)增強(qiáng)的效果?

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

ADS9234R的采樣速率理論上是多少,在正常設(shè)計(jì)中是否還會(huì)降低?

生成式AI工具作用

運(yùn)放THS4551理論上輸入是線性的,DC掃描,輸出也是線性的,為什么我們的輸出不是線性的?

如何用C++創(chuàng)建簡(jiǎn)單的生成式AI模型

請(qǐng)問(wèn)移動(dòng)端生成式AI如何在Arm CPU上運(yùn)行呢?

美日聯(lián)手研究生成式AI,將建立合作框架

Bria利用NVIDIA NeMo和Picasso為企業(yè)打造負(fù)責(zé)任的生成式AI

檢索增強(qiáng)生成(RAG)如何助力企業(yè)為各種企業(yè)用例創(chuàng)建高質(zhì)量的內(nèi)容?

商湯科技2023年生成式AI收入增至12億元

NVIDIA生成式AI研究實(shí)現(xiàn)在1秒內(nèi)生成3D形狀

商湯集團(tuán)2023全年業(yè)績(jī)亮眼,生成式AI業(yè)務(wù)爆發(fā)式增長(zhǎng)

生成式 AI 制作動(dòng)畫(huà):周期短、成本低!

NeurIPS 2023 | 如何從理論上研究生成式數(shù)據(jù)增強(qiáng)的效果?

NeurIPS 2023 | 如何從理論上研究生成式數(shù)據(jù)增強(qiáng)的效果?

評(píng)論