嵌入式 AI

AI 簡報 20231110期

1. 短短 45 分鐘發布會,OpenAI 如何再次讓 AI 圈一夜未眠

原文:https://www.geekpark.net/news/327126

對于 AI 行業從業者來說,剛剛可能是一夜未眠。

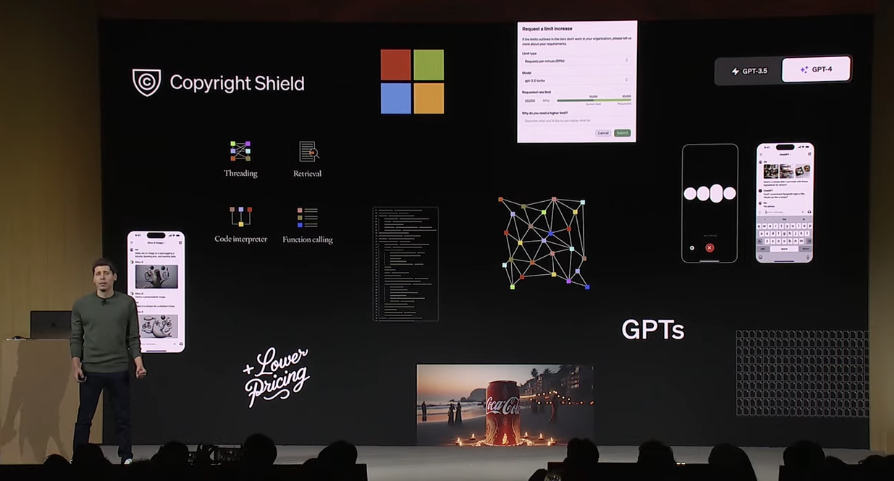

北京時間 11 月 7 日凌晨,美國人工智能公司 OpenAI 的開發者大會正式開啟,創始人 Sam Altman 在臺上和同事,只用 45 分鐘時間,就「轟」出了團隊最新的成果 GPT-4 Turbo,后者不僅更快、有更長的上下文、而且更好的控制。

同時,OpenAI 下調 API 的價格近 3 倍,降到了 1000 輸入/美分,讓在場開發者歡呼不已。

當然,更重要的是,OpenAI 推出了「GPTs」——讓人們能用自然語言構建定制化 GPT,然后,你猜到了——可以把 GPT 上傳到即將發布的「GPT Store」!

如果說 GPT-4 Turbo 是更好用的「iPhone」,GPT Store 則可能是讓 OpenAI 成為「蘋果」一樣的巨頭的重要一步。

當競爭對手們依然在「AI 煉丹」時,OpenAI 已經開始構建起一個看起來相當宏偉的生態了。

GPT-4 Turbo,更快,更省錢

發布會一開始,Sam Altman 就宣布了 GPT-4 的一次大升級,推出了 GPT-4 Turbo,同步在 ChatGPT 和 API 版本推出。

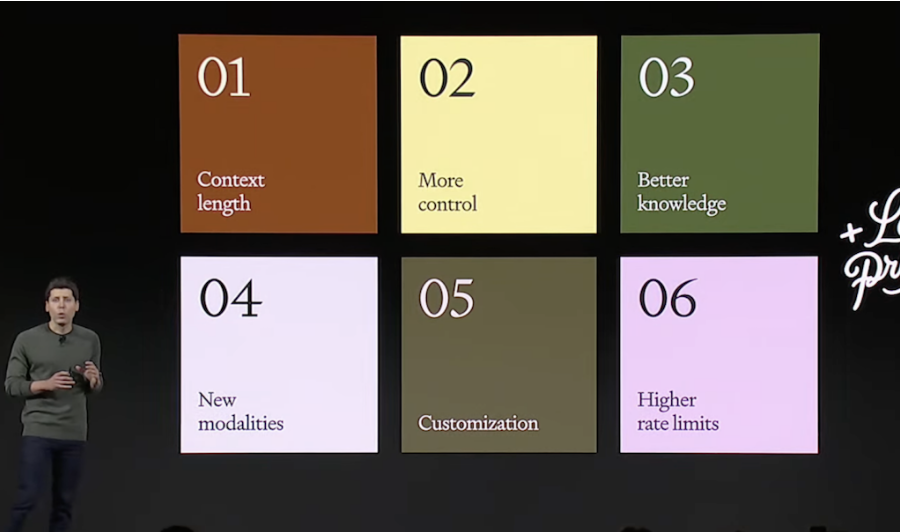

Sam Altman 表示團隊一直在征求開發者的建議,對開發者關注的問題做了六大升級,分別是更長的上下文長度、更強的控制、模型的知識升級、多模態、模型微調定制和更高的速率限制。

其中前四條主要關于新模型的性能的提升,而后兩點則主要針對企業開發者的痛點。在提升性能的同時,OpenAI 還宣布了 API 價格的下調,可謂「加量不加價」了。

六大升級中,第一,就是上下文長度。

OpenAI 原本提供的最長的上下文長度為 32k,而此次,GPT-4 Turbo 直接將上下文長度提升至 128k,一舉超過了競爭對手 Anthropic 的 100k 上下文長度。

128k 的上下文大概是什么概念?大概約等于 300 頁標準大小的書所涵蓋的文字量。除了能夠容納更長上下文外,Sam 還表示,新模型還能夠在更長的上下文中,保持更連貫和準確。

第二,是為開發者提供了幾項更強的控制手段,以更好地進行 API 和函數調用。

首先,新模型提供了一個 JSON Mode,可以保證模型以特定 JSON 方式提供回答,調用 API 時也更加方便。

另外,新模型還允許同時調用多個函數,同時引入了 seed parameter,在需要的時候,可以確保模型能夠返回固定輸出。接下來幾周,模型還將增加新功能,讓開發者能看到 log probs。

第三,則是模型內部和外部知識庫的升級。

ChatGPT 橫空出世大概一年后,GPT 的知識庫終于更新到了 2023 年 4 月。Sam Altman 承諾未來還將繼續更新其知識庫,不使其落伍。「對于 GPT 的知識停留在 2021 年,我們和你們一樣,甚至比你們更惱火。」Sam Altman 表示。

除了內部知識庫的升級,GPT-4 Turbo 也升級了外部知識庫的更新方式,現在可以上傳外部數據庫或文件,來為 GPT-4 Turbo 提供外部知識庫的支持。

第四,或許是最不讓人意外的,多模態。

新模型支持了 OpenAI 的視覺模型 DALL·E 3,還支持了新的文本到語音模型——開發者可以從六種預設聲音中選擇所需的聲音。

GPT-4 Turbo 現在可以以圖生圖了。同時,在圖像問題上,目前 OpenAI 推出了防止濫用的安全系統。OpenAI 還表示,它將為所有客戶提供牽涉到的版權問題的法律費用。

在語音系統中,OpenAI 表示,目前的語音模型遠超市場上的同類,并宣布了開源語音識別模型 Whisper V3。

第五,模型微調與定制。

8 月,OpenAI 曾經發布過 GPT-3.5 Turbo 的微調服務。當時,有早期測試表明,經過微調的 GPT-3.5 Turbo 版本在某些任務中甚至可以超越 GPT-4,不過定價相對較高。

而此次,Sam 宣布 GPT-3.5 Turbo 16k 的版本目前也可以進行微調的定制了,且價格將比前一代更低。GPT-4 的微調定制也在申請中了。

同時,OpenAI 也開始接受單個企業的模型定制了。「包括修改模型訓練過程的每一步,進行額外的特定領域的預訓練,針對特定領域的后訓練等等。」Sam 表示。同時他表示,OpenAI 沒有辦法做很多這樣的模型定制,而且價格不會便宜。

第六,也是最后一點,是更高的速率限制。

GPT-4 用戶,發布會后馬上可以享受到每分鐘的速率限制翻倍的體驗。同時,如果不夠滿意,還可以進一步通過 API 賬戶,申請進一步提升速率限制。

六大升級以外,是 API 體系的全線降價。

此次新發布的 GPT-4 Turbo,輸入方面比 GPT-4 降價 3 倍,而輸出方面降價 2 倍,OpenAI 表示,總體使用上降價大概 2.75 倍。

新模型的價格是每千輸入 token 1 美分,而每千輸出 token 3 美分。降價的 API 迎來了現場開發者的歡呼。

Sam 還表示,在優先解決價格之后,下一個重點解決的問題將是速度問題,很快,開發者們就會發現 GPT-4 Turbo 將變快很多。

GPT Store 來了!

早在 5 月,OpenAI 就開放了插件系統,首批上線了 70 個大模型相關的應用,領域包括猜詞、翻譯、查找股票數據等等。

當時,該功能被寄予厚望,不少媒體將其類比于蘋果的 App Store 時刻,認為它將改變大模型應用的生態。不過雖然后期插件不斷增加,但插件系統卻遠遠沒有達到蘋果應用商店的影響力。

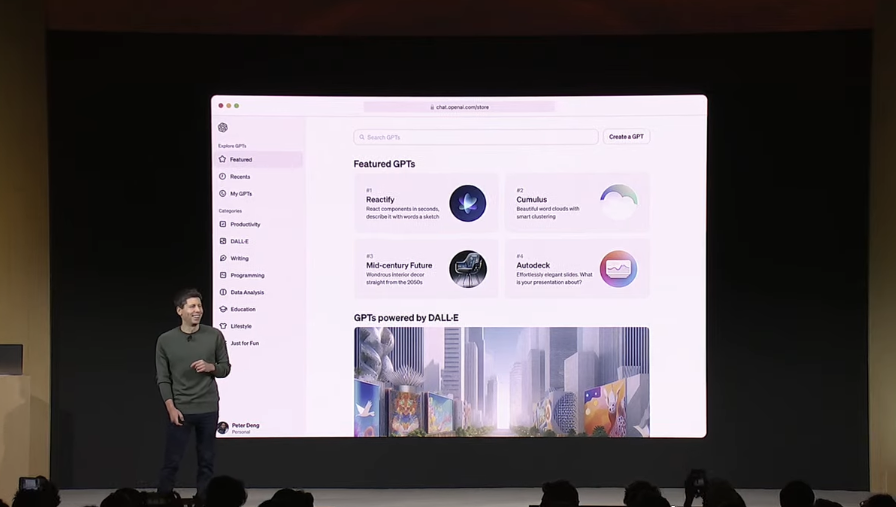

而此次發布會上,OpenAI 則重新梳理了其應用商店的體系,并將其擴大到了一個全新的范疇——人人都能通過自然語言創建基于自己的知識庫的 AI Agent,加入 OpenAI 的應用商店,并獲得分成。

OpenAI 此次發布的應用,不再稱為插件,而選擇了一個相對比較奇怪的名字,GPT。而整體的應用商店,名字叫做 GPT Store,將在本月后期正式推出。

按照 Sam Altman 的說法,每一個 GPT 像是 ChatGPT 的一個為了特殊目的而做出的定制版本。

為了突出新的 GPT 應用,ChatGPT 整個頁面將有小幅度的調整。左上角除了 ChatGPT,下面的應用,就是此次推出的 GPT 應用。

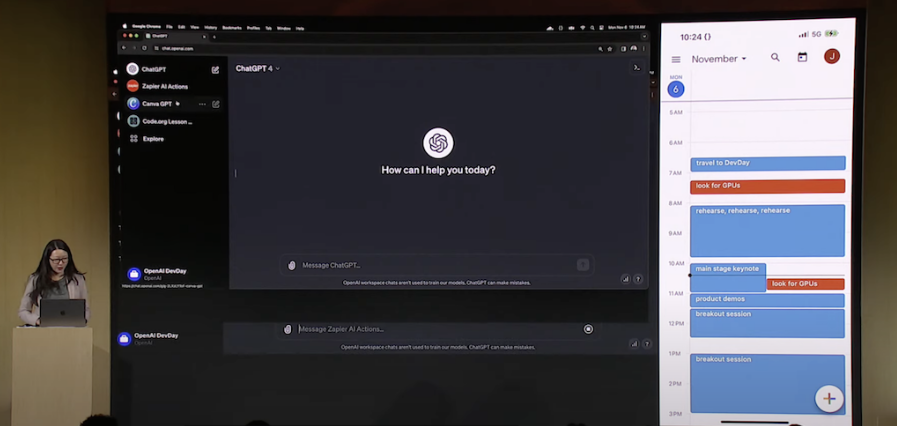

在演示中,可以看到,較為復雜的插件——比如曾經在 OpenAI 上線插件系統時第一批進入插件系統的 Zapier,仍然存在于目前的應用商店中,而且仍然可能是未來應用商店里很重要的一批應用。

演示中,OpenAI 的 Jessica Shay,就利用了 Zapier 鏈接了自己的日歷和手機短信,通過與 Zapier 這個應用聊天的方式,直接安排了自己的日程,并通知了同事。

不過,Zapier 的功能雖然強大,這樣的應用并不是此次發布的重點。據 Glassdoor 數據顯示,Zapier 公司擁有 500-1000 名員工,而財富網站報道,Zapier 估值已達 50 億美金。指望這樣的應用來填充 OpenAI 的羽翼未豐的應用商店,使其成為一個豐富的生態顯然不太現實。

因此,此次發布中,OpenAI 推出一個重磅發布:讓不懂代碼的人也能輕松定義一個 GPT。

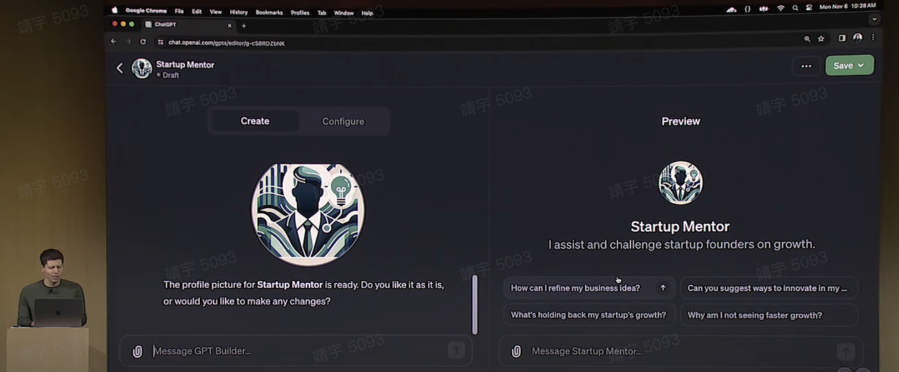

Sam Altman 為此進行了現場展示。

「在 YC 工作過很多年,我總是遇到開發者向我咨詢商業意見。」Sam Altman 講到,「我一直想,如果有一天有個機器人能幫我回答這些問題就好了。」

接著,Sam Altman 打開了 GPT Builder,先打上一段對這個 GPT 的定義,類似于幫助初創公司的創始人思考他們的業務創意并獲得建議,接著,在對話中,GPT Builder 自己生成了這個 GPT 的名字、圖標,并通過與 Sam 對話的形式,詢問 Sam 是否要對對生成的名字和圖標等進行調整。

接下來,GPT Builder 主動向他詢問這個應用該如何與用戶交互,Sam 表示可以從我的過往演講中選擇合適且有建設性的回答,然后上傳了一段自己過往的演講。

即使加上講解,整個應用也在三分鐘內就完成了。訪問這個 GPT 的人,會收到 GPT 自動生成的對話開頭,可以與這個 GPT 對話咨詢創業相關的內容,而得到的,將是一個類似于 Sam Altman 本人的回答。

Sam 表示,創建者還可以進一步為 GPT 增加 action(動作)。

創建一個這樣的 GPT,本質上,用戶能夠定制的功能其實并不多:指令(預設的 prompt),外設的知識庫和動作。但是,能把三者絲滑地結合起來,讓一個不懂代碼的人也能更簡單地創建應用,確實是此次 Open AI 的創舉。

GPT 發布后,應用可以選擇私有,專屬企業擁有和公開所有三種方式。而 Open AI 表示,將為受歡迎的應用提供利潤分享。

很明顯,OpenAI 在這里的發布,并沒有希望普通用戶能夠通過自然語言創建出多么復雜的應用,其中的想象空間,更重要的在于個人和企業能夠將自己的知識庫上傳到 OpenAI,一鍵構建專屬應用。

比如作為一個擁有貨運價格表的代理,可以將文件上傳到 OpenAI 后,一鍵部署出自己的詢價助理,這樣簡潔絲滑的應用部署,在之前還并不存在。而如果發布最終能夠得到用戶認可的話,類似的應用也將能夠填充 OpenAI 的應用商店,使其成為各種信息的寶庫。

零代碼創建 AI Agent

如果你覺得上述的 0 代碼的 GPT 很酷,此次 OpenAI 也推出了讓開發者更容易使用 OpenAI API 的開發方式——Assistants API。

Sam Altman 表示,市面上基于 API 構建 agent 的體驗很棒。比如,Shopify 的 Sidekick 可以讓用戶在平臺上采取行動,Discord 的 Clyde 可以讓管理員幫忙創建自定義人物,Snap 的 My AI 是一個自定義聊天機器人,可以添加到群聊中并提出建議。

但問題是,這些 agent 很難建立。有時需要幾個月的時間,由數十名工程師組成的團隊,處理很多事情才能使這種定制助手體驗。這些事情包括狀態管理(state management)、提示和上下文管理(prompt and context management)、擴展功能(extend capabilities)和檢索(retrievel)。

在 OpenAI 開發者大會上,這些事情被 API 化——OpenAI 推出 Assistants API,讓開發人員在他們的應用程序中構建「助手」。

使用 Assistants API,OpenAI 客戶可以構建一個具有特定指令、利用外部知識并可以調用 OpenAI 生成式 AI 模型和工具來執行任務的「助手」。像這樣的案例范圍包含,從基于自然語言的數據分析應用程序到編碼助手,甚至是人工智能驅動的假期規劃器。

Assistants API 封裝的能力包括:

持久的線程(persistent threads),人們不必弄清楚如何處理長的對話歷史;

內置的檢索(Retrieval),利用來自 OpenAI 模型外部的知識(例如公司員工提供的產品信息或文檔)來增強開發人員創建的助手;提供新的 Stateful API 管理上下文;

內置的代碼解釋器(Code Interpreter),可在沙盒執行環境中編寫和運行 Python 代碼。這一功能于 3 月份針對 ChatGPT 推出,可以生成圖形和圖表并處理文件,讓使用 Assistants API 創建的助手迭代運行代碼來解決代碼和數學問題;

改進的函數調用,使助手能夠調用開發人員定義的編程函數并將響應合并到他們的消息中。

Assistants API 處于測試階段,從今天開始可供所有開發人員使用。開發者可以前往 Assistants Playground 來嘗試 Assistants API 測試版,而無需編寫任何代碼。

Assistants API 被 OpenAI 視為幫助開發者在其應用程序中構建「類 agent 體驗」的第一步。有了 Assistants API,構建 agent 應用將變得更容易。OpenAI 表示,隨著時間的推移,將會持續提高它們的能力。并且,未來計劃允許客戶提供自己的 copilot 工具,以補充其平臺上的 Code Interpreter、檢索組件和函數調用。

OpenAI 開發者大會上的產品升級,再次告訴人們,距離每個人都能有一個甚至多個專屬私人助理、使用自然語言就能開發軟件、還能像瀏覽應用一樣,付費/免費購買流行的私人助理,這樣的一個未來,正在加速向人們走來。

從 GPT-4 到 GPT-4 Turbo 和 GPT Store,OpenAI 只用了半年多一點的時間。而在 6 個月之內,全球的科技和 AI 行業,已經是天上人間。

當多模態、長文本輸入、更便宜、個性化……這些旨在和 OpenAI 大模型錯位競爭的特點,都被 OpenAI 搶先拿來自我革命;當 OpenAI 的產品在 B 端和 C 端都體現出強大的吸引力、并且還將利用 GPT Store 率先籠絡住全球AI 開發者時,不知道全球的 AI 對手們的心情如何。

但 OpenAI 的技術進步是令人興奮的,而團隊所采用的商業策略,又有著超出一般創業公司的成熟——我們目睹著一個行業的潮起,也可能正在見證一個巨頭的誕生。

2. 聯發科翻身,同藍廠聯合研發「全大核」體系,vivo X100穩了

原文:https://mp.weixin.qq.com/s/RI1FYzmh7hcFnB5Dor5Eng

11月6號,聯發科的旗艦芯片天璣 9300 正式亮相,一舉完成了連續超車:性能超過高通和蘋果,站上了本世代移動芯片的頂端。

據介紹,天璣 9300 的 CPU、GPU 性能均超過了競品,另外能耗還有所降低,又率先實現了 70 億大語言模型在手機端側的落地。

與此同時,搭載頂級芯片的新手機也將開賣。在發布會上,vivo 第一時間宣布即將發布的年度旗艦機 vivo X100 系列將首發搭載天璣 9300,新機型與芯片進行了深度的定制化,發布會下周就開。

「我們認為在移動端,CPU 的使用方式將從低速持續轉變為快速集中的方式,」聯發科活動中,vivo 高級副總裁施玉堅表示:「在 vivo 與聯發科共同探索下,新的全大核架構可以快速完成任務,快速休眠,大幅降低功耗,做到冷靜低耗。」

看起來,連續兩年國內份額排名第一的藍廠,也對這塊芯片信心滿滿。

只用大核,性能超出預期

在手機 SoC 領域,今年安卓陣營正在全面超越蘋果,作為重要一極的天璣也是玩出了狠活。

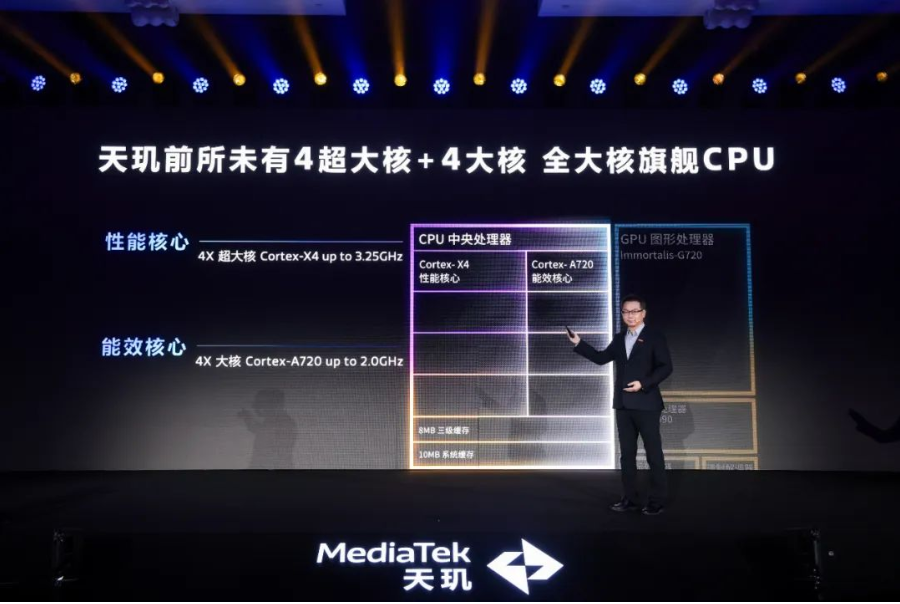

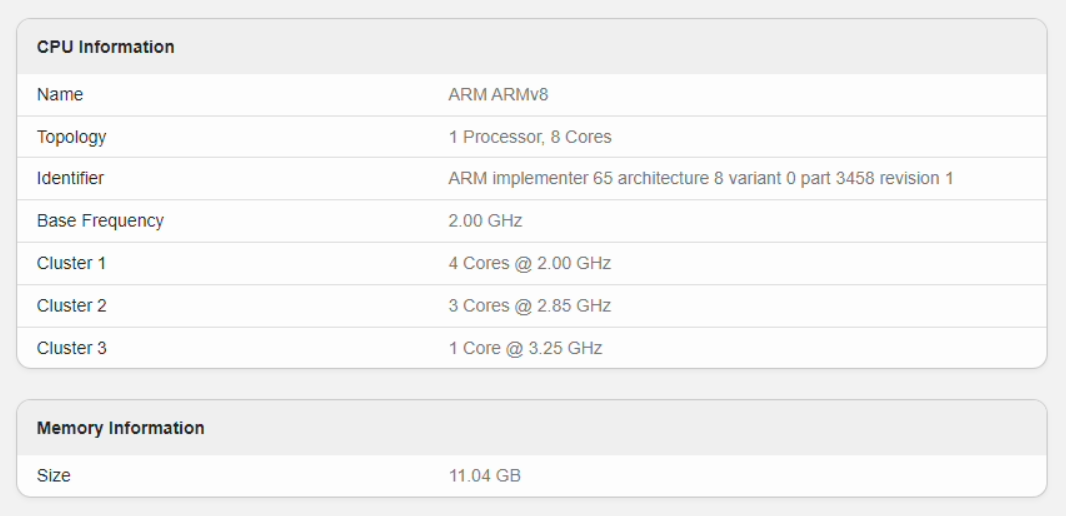

昨天正式發布的天璣 9300 在性能和功耗比上均實現了領先。這顆芯片的 CPU 部分使用了 4 顆 Cortex-X4 超大核與 4 顆 Cortex-A720 大核的設計,其中超大核頻率是 3.25GHz,大核 A720 的頻率是 2.0GHz。據聯發科介紹,「全大核」的設計從理念上領先于競品。相比上代,天璣 9300 峰值性能提升 40%,同性能的功耗則減少了 33%。

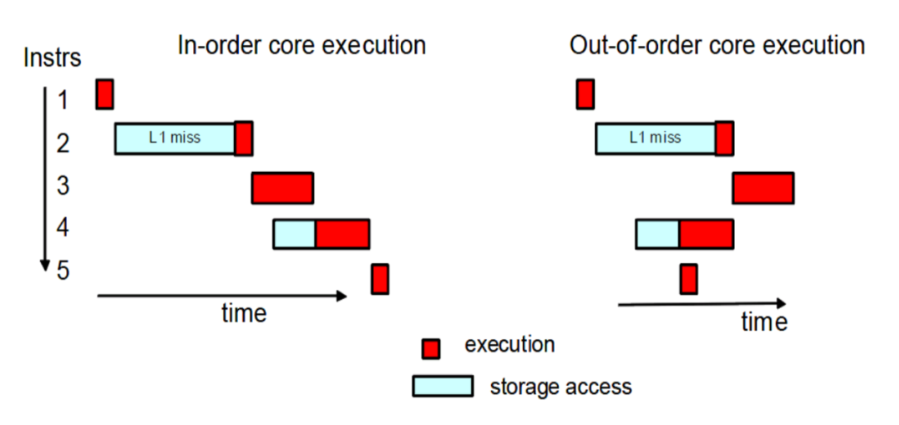

聯發科表示,全大核設計加上亂序執行(out-of-order)機制,在工作過程中可以快速處理任務,讓芯片在更長的時間內處于待機狀態,既提升了速度也降低了功耗。這種做法將會成為未來旗艦手機芯片的趨勢。

而在游戲等重負載任務關注的圖形處理能力上,與上代相比,天璣 9300 的峰值性能提升了 46%,相同性能下功耗可節省 40%。該芯片搭載的 GPU Immortalis-G720 引入了延遲頂點著色(DVS)技術,這是一種可以減少內存訪問和帶寬使用的方法,可以大幅節省功耗和提高幀率。

在 AI 性能方面,天璣 9300 的新一代 APU 內置了硬件級的生成式 AI 引擎,首次實現行業最高的 70 億 AI 大語言模型以及 10 億 AI 視覺大模型在手機上的落地,可帶來端側的 AI 畫圖、大模型推理等能力。

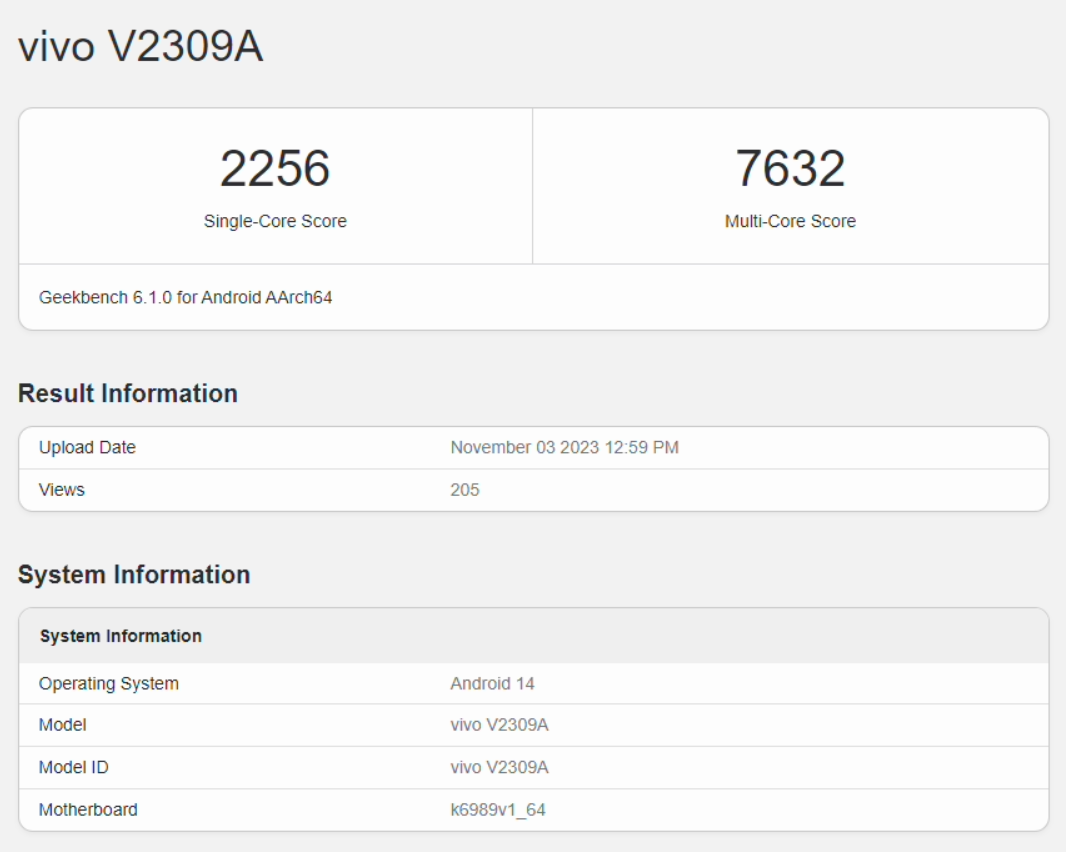

如果看跑分的話,天璣 9300 處于目前安卓處理器性能第一的位置。在 Geekbench 上,X100 的分數與驍龍競品非常接近,多核分數更高一些。

除此以外,不論是 CPU 多核性能還是 GPU 性能,天璣 9300 都超過了蘋果 A17 Pro 芯片。很多媒體第一時間發布的評測中,都給出了「超出預期」的評價。

總而言之,天璣 9300 可以在日常使用、游戲和拍攝眾多場景上以更快的速度、實現更好的效果,同時功耗還不會更高。這讓人不得不感嘆:安卓的性能真的變天了?

有趣的是,不論是在此前的技術展示,還是昨天的發布會上,聯發科均表示基于天璣 9300 芯片,vivo 與其進行了深度合作與聯調。至此,有關即將發售的 vivo X100 系列,我們已知的消息有:它將引入天璣 9300、vivo 6nm 自研影像芯片 V3、LPDDR5T 運存、UFS 4.0 閃存、全系使用潛望長焦鏡頭、1.5K 曲面屏,還有藍海電池等配置。

強大的芯片,再加上全方位的升級。下星期才發布的 X100 系列,可以說已經劇透了大部分配置。

聯動 V3 芯片,首次實現 4K 視頻拍攝 + 編輯

當然,不論還有哪些未透露的黑科技,vivo 新旗艦機的目標都非常明確:要確立高端影像旗艦的標桿。

最近幾年,X 系列已經通過獨立芯片把拍照能力卷成了藍廠的招牌。在 vivo X100 系列上,vivo 還要更進一步,即將搭載的是新一代自研影像芯片 V3。

這款芯片在今年 7 月首次被公布,它采用 6nm 制程工藝打造,能效比相比上代提升了 30%,通過與手機 SoC 高速聯通,V3 的影像處理耗時相較上代縮短了 20%。

V3 芯片的出現,讓移動影像領域此前一些「不可能」成為可能。比如配合蔡司鏡頭和 T* 鍍膜防眩光技術,讓手機可以直接拍攝太陽,同時解決色差和眩光問題,獲得漂亮的成片。

從技術層面上看,V3 能夠實現此前傳統算法難以達到的「4K 電影級視頻拍攝」和「拍后編輯」能力。其中 4K 電影人像視頻可以實現類似電影效果的實時背景虛化、HDR、降噪等功能,對于畫面主體也可以實現自動焦點檢測和切換,同時可以對皮膚和色彩進行「電影級」優化處理。

4K 級拍后編輯則可以讓用戶先拍攝,然后在相冊中無損調整畫面中的虛化和焦點位置,實現更好的切焦運鏡效果。

以上這些都是安卓平臺上,首次有手機能夠實現的功能。

X100 的影像能力,與芯片的聯合調教是分不開的。在 vivo 與聯發科針對天璣 9300 和 V3 芯片的聯動,設計了全新的多并發 AI 感知 ISP 架構和第二代 FIT 互聯系統,可以降低功耗,并顯著提升算法效果。此外,兩塊芯片能夠靈活切換算法部署方式,做到獨立芯片和 SoC 的無縫銜接。

可以說,V3 加上天璣 9300,兩顆芯片能夠跑出更多馬力,在各種場景下都可以滿足復雜人機交互的需求。

從 vivo 此前一些活動中公布的信息可知,即將發布的 vivo X100 系列將會在影像方面迎來重大升級,該系列新機將會在新一代處理器的加持下,配備 vivo 自研 V3 影像芯片,搭載全新的大底主攝以及「Vario-Apo-Sonnar」長焦鏡頭,以及全新的蔡司 T * 鍍膜技術。兩塊芯片與新一代光學元器件的配合,將為用戶帶來出眾的全焦段影像體驗。

我們知道,國內外的手機大廠多年以來都在不斷發力移動攝影,但 vivo 這樣從鏡片開始,深入芯片再到 AI 算法全面加碼的,可謂獨樹一幟。

「藍晶芯片技術棧」上線,以后更得看藍廠

近四年來,vivo X 系列旗艦手機的穩定表現讓人們已經逐漸形成了「天璣調教看藍廠」的印象。自從 vivo X80 系列開啟與天璣平臺首次合作以來,X 系列的名頭變得越來越響,天璣芯片也在朝著最強處理器的目標一步步邁進。

可以說,這幾年藍廠的步子走的又快又穩,而且還準。

vivo 的創新理念是回歸本原思考。在芯片方面,其致力于面向高頻使用場景進行創新,高強度不設限地自研影像芯片,在 SoC 上則選擇與芯片廠商展開深度合作。

vivo 與聯發科是戰略級技術合作伙伴,它們之間的合作可以從四年前成立聯合實驗室說起。如今,聯合實驗室的研究范圍已經覆蓋了 AI、功耗、性能、游戲、現實、通信、存儲 8 大賽道,以及很多面向全行業的先進技術。

這種長期的合作已經帶來了肉眼可見的成果:在 vivo X80 系列中,vivo 與天璣平臺首次進行了自研芯片的調通。雙方共投入 300 人,經過 350 天研發周期大幅革新了軟件通路架構,將 V1+ 芯片與天璣 9000 調通,使 vivo X80 系列成為了「表現最好的天璣 9000 旗艦」。

通過雙芯技術和對軟硬件架構的優化,X80 系列在影像方面帶來了微光手機「夜視儀」、實時黑光夜視 2.0 和極夜視頻,游戲方面也實現了超分辨率、獨顯超清、雙芯超幀以及低功耗等特性。

在去年底發布的 vivo X90 系列上,vivo 在天璣 9200 旗艦平臺的研發階段早期介入,通過與聯發科長達 20 個月的密切合作,帶來了 MCQ 多循環隊列、MAGT 自適應畫質、芯片護眼、APU 框架融合與 AI 機場模式等五大聯合研發技術。在游戲上提出了 vivo 專屬游戲調校、OriginOS 3 流暢智算中樞和旗艦影像體驗三大聯合調校。

vivo 與聯發科的合作,是基于用戶需求從芯片設計層面上開始的改進,真正深入了芯片底層,充分發揮了天璣芯片的潛力。隨著近年來在芯片技術的沉淀,vivo 已初步具備了面向行業需求定義芯片的能力。

X100 上的天璣 9300,已是 vivo 與聯發科在旗艦手機 SoC 上的第三代合作。這一次,vivo 的「造芯能力」上升到了新的高度 —— 昨天,vivo 還介紹了「藍晶芯片技術棧」。

在 vivo X100 系列產品上,大家將看到 vivo 在 SoC 芯片上的優化能力,從芯片核心賽道的聯合調優,到深入底層 ARM 指令集調用架構突破 GPU 帶寬瓶頸,vivo 正在以芯片設計者、引領者、實踐者的身份,拓寬技術發展的邊界。

沒錯,vivo 現在一定程度上已是引領者了,比如在天璣 9300 的全大核設計上。

據介紹,早在三年前,vivo 就與聯發科開始共同探索全大核架構設計的構想。隨著制程發展進入瓶頸期,大小核的功耗差距會變得不再明顯,想讓芯片更加省電,我們要更看重調度能力。因此,確定關鍵性進程后,快速處理完任務再休息的方式,不僅能讓芯片處理任務的速度更快,還能讓大核比小核更省能耗。或許在明年,其他芯片廠商就會陸續跟進這種思路。

而對于我們來說,算力充分釋放,可以期待的體驗自然就好了起來。在社交網絡上,有著天璣 9300、V3 芯片和藍晶芯片技術棧加持的 X100 系列,已經被冠上了「機圈滅霸」的名號。

11 月 13 日,vivo 今年的旗艦機型 X100 系列將正式在北京水立方發布。這款新機,我們還有哪些期待?

3. 重磅!百度知識增強大語言模型關鍵技術榮獲“2023世界互聯網大會領先科技獎”

原文:https://mp.weixin.qq.com/s/9TqP7yrxL8UbGQvvtabJ0Q

11月8日,2023年世界互聯網大會烏鎮峰會正式開幕,今年是烏鎮峰會舉辦的第十年,本次峰會的主題為“建設包容、普惠、有韌性的數字世界——攜手構建網絡空間命運共同體”。百度知識增強大語言模型關鍵技術榮獲“世界互聯網大會領先科技獎”,百度首席技術官、深度學習技術及應用國家工程研究中心主任王海峰現場發布了文心大模型的關鍵技術成果。

世界互聯網領先科技成果是由世界互聯網大會組織發布的,面向全球廣泛征集前沿科技申報成果,通過評審評出具有國際代表性的年度領先科技成果。世界互聯網領先科技成果發布活動自2016年起連續舉辦,旨在引領科技前沿創新,倡導技術交流合作,對世界互聯網科技發展發揮了積極影響。今年,這一活動全面升級為世界互聯網大會領先科技獎,并首次分為關鍵技術、基礎研究、工程研發三類,面向全球表彰年度領先互聯網科技成果。

本次大會共計征集到來自中國、美國、俄羅斯、英國、德國等國家的領先科技成果246項,涵蓋人工智能、大數據、5G、車聯網等領域,經過40名海內外專家評審,百度知識增強大語言模型關鍵技術成為唯一獲獎的大模型技術,這也是繼百度大腦、小度助手(DuerOS)、Apollo、飛槳之后,百度在世界互聯網大會烏鎮峰會第五次獲此榮譽。

王海峰發布知識增強大語言模型領先科技成果時表示,“人工智能正在引領新一輪科技革命和產業變革,大語言模型讓人們看到了通用人工智能的曙光。知識增強大語言模型關鍵技術,突破知識內化和外用技術,具備知識增強、檢索增強和對話增強的獨有技術優勢,并通過模型與框架聯合優化,突破了訓練規模,提高了訓練效率,提升了模型效果。”

百度在今年3月16日發布新一代知識增強大語言模型文心一言,目前其基礎模型已迭代到文心大模型4.0版本。文心大模型和飛槳深度學習平臺聯合優化,快速迭代升級,訓練效率提升到3月發布時的 3.6 倍,推理提升 50 多倍。

公開資料顯示,百度知識增強大語言模型相關技術曾獲國家技術發明二等獎、中國專利金獎、吳文俊人工智能科技進步特等獎、中國電子學會科技進步一等獎等。技術成果應用于智能搜索、通用對話等,并成功實踐“集約化生產,平臺化應用”的產業模式,與合作伙伴聯合研制10余個行業大模型,助力產業智能化升級。

據了解,8月31日文心一言面向全社會開放至今,用戶規模已經達到7000萬,場景4300個。

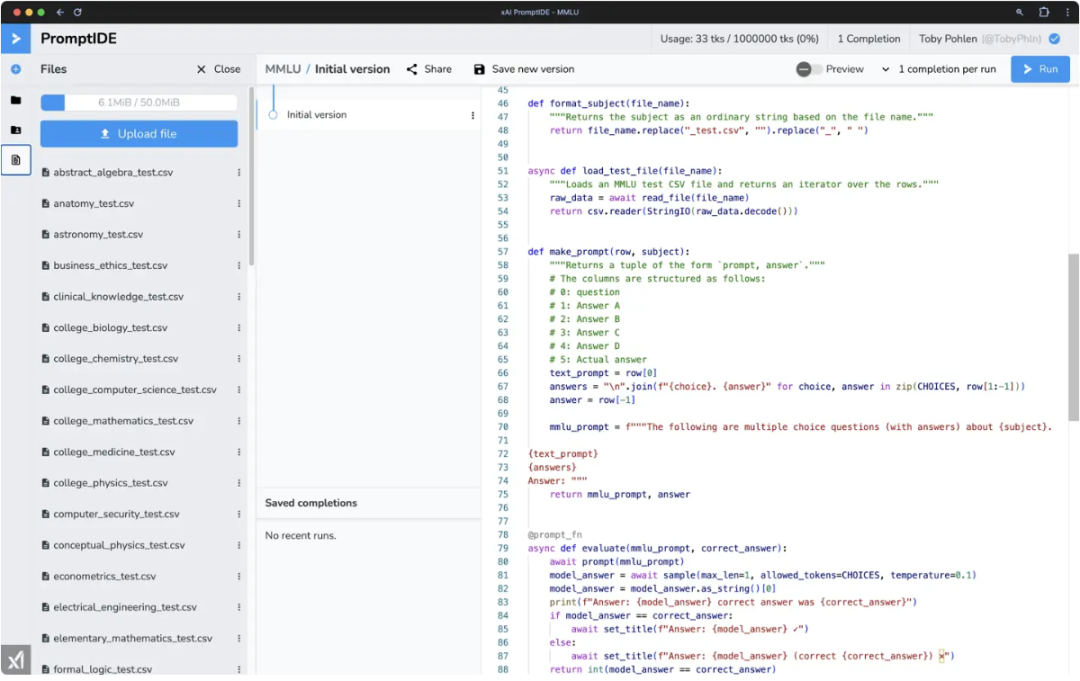

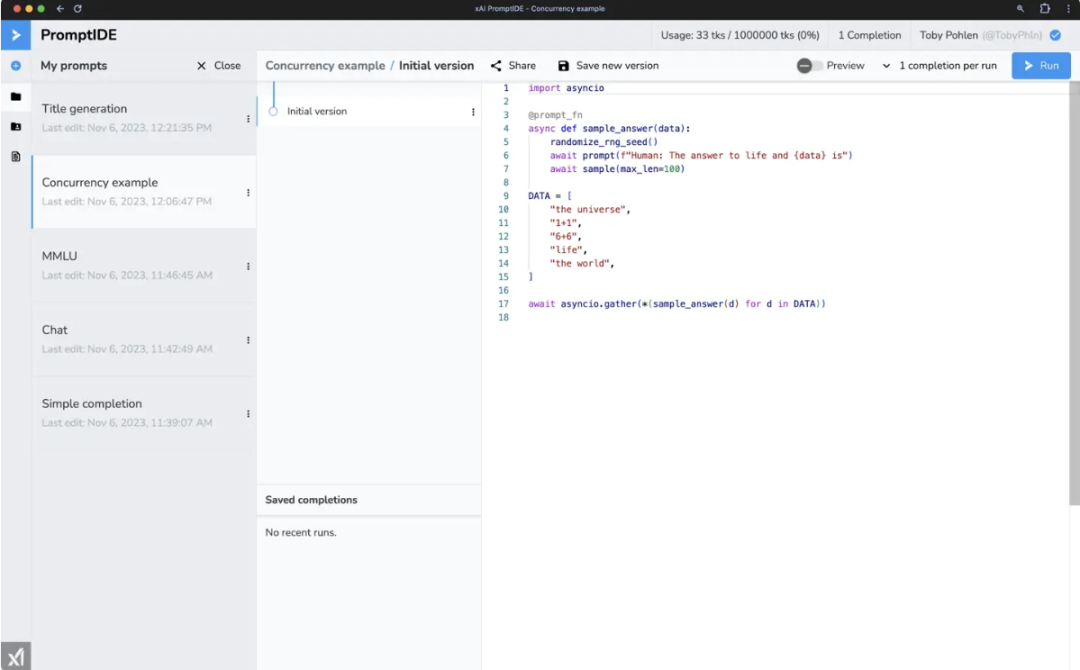

4. 馬斯克旗下 AI 公司推出 PromptIDE 工具

原文:https://www.oschina.net/news/265374

馬斯克旗下 AI 公司 xAI 宣布推出 PromptIDE 工具,需要使用 X 賬戶登錄。

https://x.ai/prompt-ide/

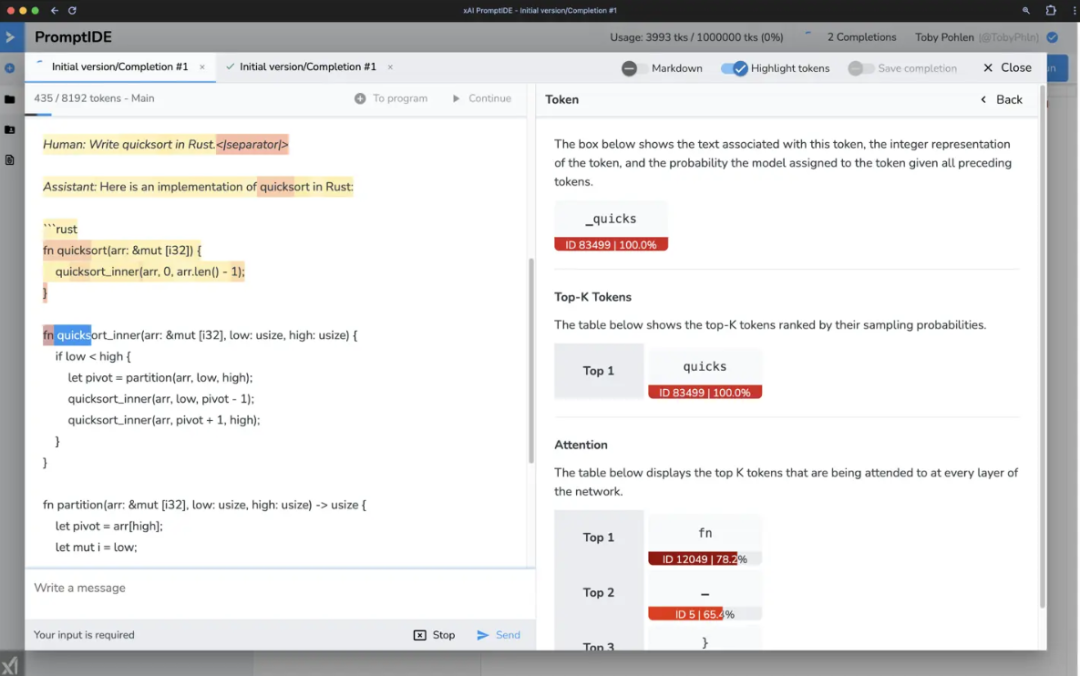

PromptIDE 是一個用于提示工程和可解釋性研究的集成開發環境。它通過 SDK 加速提示工程,該 SDK 允許實現復雜的提示技術和豐富的分析功能,從而實現網絡輸出可視化。

IDE 的核心是一個 Python 代碼編輯器,它可以與新的 SDK 結合實現復雜的提示。在 IDE 中執行提示時,用戶會看到一些有用的分析和建議,例如精確標記化等等。

xAI 官方表示,他們開發 PromptIDE 是為了向社區的工程師和研究人員透明地提供 Grok-1 的透明訪問權限。該 IDE 旨在賦予用戶權力,幫助他們快速探索大型語言模型(LLMs)的魅力。

5. 阿里巴巴即將開源國內規模最大的 AI 大模型,720 億參數

原文:https://www.ithome.com/0/731/189.htm

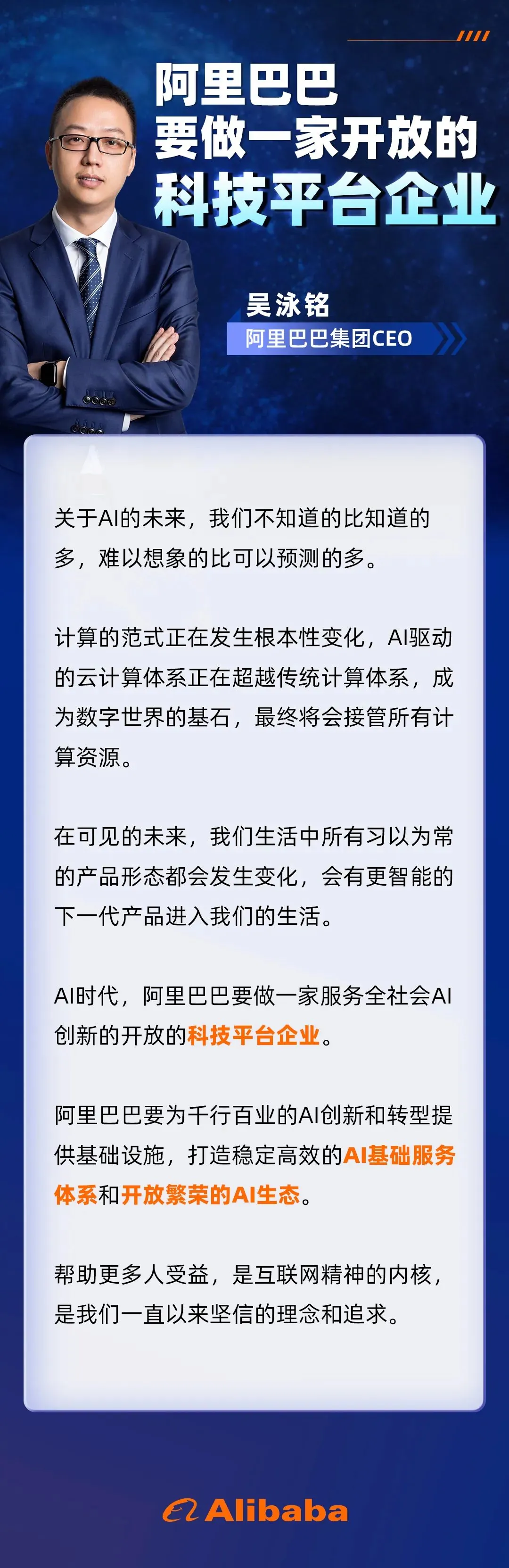

IT之家 11 月 9 日消息,阿里巴巴集團 CEO 吳泳銘今日在 2023 年世界互聯網大會烏鎮峰會上透露,阿里巴巴即將開源 720 億參數大模型,這將是國內參數規模最大的開源大模型。

IT之家查詢獲悉,阿里巴巴目前已經開源通義千問 140 億參數模型 Qwen-14B 和 70 億參數模型 Qwen-7B,而 720 億確實是目前國內開源大模型的參數新高。

吳泳銘昨日還在 2023 年世界互聯網大會烏鎮峰會上表示,AI 時代,阿里巴巴要成為一家服務全社會 AI 創新的、開放的科技平臺企業。

“回望這 20 年,我們打造了覆蓋交易、物流、支付、生產等環節的數字商業基礎服務,為電商行業發展提供了有力支撐。而隨著 AI 成為中國數字經濟創新突破的關鍵,阿里巴巴要做一家開放的科技平臺企業,為千行百業的 AI 創新和轉型提供基礎設施。”吳泳銘說。

6. 聯想首推大模型解決方案及服務 加速推動企業級應用落地

原文:http://finance.people.com.cn/n1/2023/1110/c1004-40115499.html

11月9日,在烏鎮舉辦的2023世界互聯網大會算力網絡協同創新分論壇上,聯想集團副總裁、中國區方案服務業務總經理戴煒以“算力時代一切皆服務”為主題進行演講,并首次對外推出聯想企業大模型服務。旨在以智算服務為基礎,通過AI平臺部署進行推理加速、分布式訓練&微調,幫助實現私有化大模型部署,全面賦能企業的業務系統,幫助客戶實現 AI轉型。

戴煒表示,“隨著人工智能技術的快速發展,算力網絡未來的發展方向將專注于實現大模型及人工智能在行業和企業中的實際落地和體現其業務價值。”

此次,聯想首次對外推出了企業專屬的私有化大模型解決方案及服務。該服務是聯想基于智能算力和AI大模型技術的全新方案服務,可以有效解決企業自建大模型進程中對算力擴展、數據安全以及部署與運維等諸多個性化需求。

戴煒表示,企業大模型服務的優勢在于可以幫助企業構建私有化的一體化大模型平臺,一站式交付,安全可控,基于領域知識的高效微調,打造專屬企業大腦。

而聯想推出的企業專屬的私有化大模型解決方案及服務,依托于一站式端到端的解決方案與陪伴式服務,讓更多的企業也能快速享有大模型的能力同時,不必考慮具體的部署細節,能夠把更多精力放在自身業務發展中。真正幫專注于探索大模型應用的企業更加經濟地、高效地實現大模型應用的落地。

作為一場引領數字技術創新趨勢的全球行業盛會,本次2023世界互聯網大會吸引了中國ICT領域的諸多頭部企業,包括以云網業務為核心的三大運營商,擁有全棧智能布局(包括AI內嵌的智能終端、AI導向的基礎設施、AI原生的方案服務)的聯想集團以及一家基礎設施和智能終端提供商。

據IDC的最新數據顯示,在IDC2022自然年對中國IT服務市場(非運營商)的排名中,聯想方案服務業務奪得市場第二,正式邁入中國IT服務市場的頭部核心梯隊。聯想正憑借AI原生的方案與服務,持續賦能中國企業智能化轉型,以實賦實,最終與合作伙伴一起加速推動實現中國數實融合新圖景。

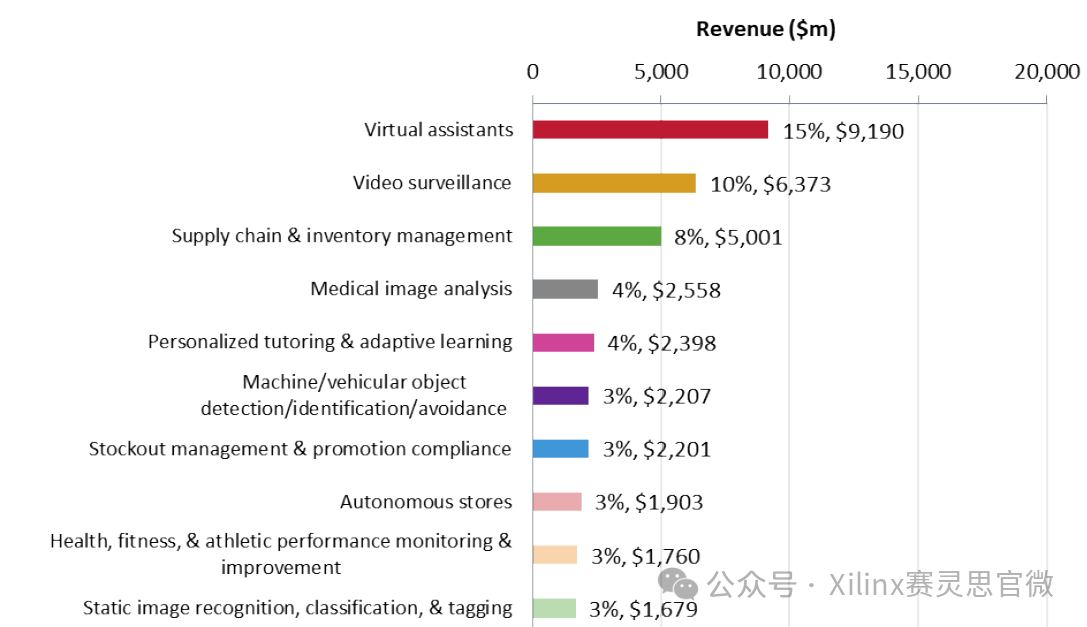

算力五年復合增長率達52.3%,企業搶灘大模型建設

從ChatGPT橫空出世,到國內外廠商紛紛入局大模型“百舸爭流”,僅用了一年時間。

關于各類生成式人工智能大模型的討論,已經從互聯網、科技領域的局內人,蔓延至全社會的各行各業。由大模型引發的創新浪潮,正在不斷“涌現”。

最新數據顯示,目前我國有至少130家公司研究大模型產品,其中通用大模型有78家。如今,科大訊飛的“星火”、騰訊的“混元”、百度的“文心一言”、百川智能等國產大模型開始陸續出實驗室,面向公眾進行開放測試。

伴隨大模型應用的不斷推出,國內對于智能算力的需求也將持續擴大。據IDC數據顯示,中國智能算力規模將持續高速增長,未來五年復合增長率達52.3%。

對于大眾而言,可以對話、寫詩、作畫,甚至是寫文章、編代碼的AI大模型應用開始變得更加親切和具體。但對于業內人士而言,大模型已經成為當前人工智能、乃至新一輪科技革命與產業變革的核心驅動力,成為各大國爭相搶占的科技制高點。

歷經數十年的發展,人工智能正在逐步從感知智能向認知智能轉化。掌握AI大模型工具,就是掌握了未來的生產力。

中國工程院院士、中國互聯網協會咨詢委員會主任鄔賀銓指出,“多數行業的大企業沒有自行開發大模型的能力,而互聯網大企業和科研機構的大模型不了解行業,因此難以直接應用到行業中。為解決以上困境,現在的一種趨勢是,互聯網企業和科研企業開發大模型與行業合作,加上行業和企業自身數據,再在原有基礎大模型上針對應用場景進行調優、量化、場景遷移等,幫助模型適應行業需要,變成一種小模型。”

企業正在轉變思路,從大模型的消費者變成共同的創造者,深入探索產業價值。聯想大模型服務的推出可以幫助正在探索大模型應用的企業搶占私有化大模型建設的先機,不斷深耕自身所在領域的專精數據與經驗積累,構建自身競爭力、形成智能、高效、可自行迭代的企業大腦。

聯想推出大模型服務,助力企業搶跑下一輪智能化變革

自建企業大模型已經大勢所趨,但在實踐過程中仍存在算力擴展、數據安全以及部署與運維的諸多難題。因此,B端企業客戶需要一個懂行業know—how、能幫助解決業務問題、真正賦能產業升級的大模型解決方案及服務商。

為幫助正在探索大模型應用的企業解決上述后顧之憂,聯想首次推出的企業專屬的私有化大模型解決方案及服務,通過強大的智能算力平臺、工具和服務為企業智能化轉型提供了堅實保障,更好地實現大模型在企業的落地。

在智能算力服務方面,不論是需要從0—1自建大模型的集團企業,還是選擇一個經過預訓練的大模型作為基礎并進行指令微調以滿足特定需求的中小企業,這些企業都需要能構造一個可擴展、能持續演進的算力發展架構。因此,聯想為客戶建設了以 AI計算虛擬化、GPU集群調度、異構計算等能力為核心的智算中心,可以滿足客戶對算力的個性化需求。

不僅如此,聯想還提供全方位的聯想智算中心解決方案和服務產品,包括了三大類解決方案:聯想大腦嵌入的解決方案、聯想混合云解決方案、聯想綠色低碳智算中心基礎設施;兩大類服務,端到端全周期聯想智算中心服務;按需訂閱、靈活付費的聯想臻算服務2.0。

在數據安全保障方面,為打造適合自己的專屬大模型,企業需要使用私有數據(企業的高價值數據資產)作為知識來源和訓練數據,對大模型進行再訓練和精調,因此無論在計算、存儲中都要保障數據資產的安全。聯想通過私有化的一體化大模型平臺保障了數據的安全可控,為客戶部署AI平臺,幫助客戶實現推理加速、分布式訓練&微調,任務編排等 AI基礎能力。

在部署與運維方面,一方面AI大模型帶來的大算力、大存儲需求更加復雜,且需要進行持續迭代;另一方面,新建大模型要與原有IT系統融合、互通,加快數據流通,這也進一步增加了IT部署與運維的難度。

對此,聯想將以服務的方式為客戶提供方案交付,并且整個服務過程將在聯想智能服務平臺 AI force上進行統一管理,實現一站式交付,并且安全可控,客戶也可以通過 AI force平臺進行企業助手(智能體)部署服務、企業知識庫部署服務、業務系統插件化服務以及企業模型微調及部署服務,更加安全、便捷的實現自身智能化管理。

在產業數字化的國家戰略下,將人工智能與產業結合,打造更多落地應用,賦能千行百業的企業,跟隨產業一同發展,“大模型+產業”則是一項更符合中國本土市場實際情況的發展戰略。企業應該做好重構產品和服務的準備,包括基礎設施層面,也包括思維方式、組織方式層面。戴煒表示,“聯想全棧式解決方案與陪伴式服務將幫助正在探索大模型應用的企業更加經濟地、高效地實現大模型應用的落地,搶跑下一輪智能化變革。”

聯想全棧智能布局,加速推動AI走深向實

據IDC報告顯示,隨著生成式AI應用的爆發,各行業對智算的需求首次超過通用算力,智能算力已成為算力發展的主要方向。

在為技術進步歡欣雀躍的同時,聯想也開始了更深層次的探求,即打造全景式的人工智能,“從口袋到云端”的計算能力,將公共大模型和個人大模型,以及企業級大模型相結合。

業內人士普遍認為,未來終端將嵌入超級算力,在端上完成用戶個性化模型的訓練和推理任務。智能終端作為人工智能觸達終端用戶的終極載體,成為了聯想打造全景式的人工智能的重要方向。

聯想早在6年前就已前瞻性地預見到了智能革命的大勢所趨,啟動了3S戰略。而今,依托“端邊云網智”新IT架構,聯想已經打造了包含AI內嵌的智能終端、AI導向的基礎設施和AI原生的方案服務的全棧智能布局。聯想也成功轉變為全棧智能的產品,方案和服務的提供商。

在剛結束的聯想創新科技大會上,聯想對外公布了首款AIPC產品,該設備搭載了聯想的大模型壓縮技術,從而具備運行個人大模型的能力,能夠基于本地運行不涉及云端操作,由此保證了個人隱私和數據安全。

在對智能終端不斷探索的同時,聯想也將AI導向的算力基礎設施推向了新的高度。聯想今年推出了兩款AI服務器——聯想問天WA7780 G3 AI大模型訓練服務器和聯想問天WA5480 G3 AI訓推一體服務器。作為全新的AI導向的算力基礎設施,其不僅性能領先,還全面覆蓋云端、邊緣算力場景,同時滿足AI大模型和傳統模型的訓練、推理需求。

值得一提的是,作為陪伴中國信息化、數字化發展歷程的高新制造企業,聯想已扎根實體長達39年。依托新IT架構,聯想“內生外化”打磨出了具有中臺化&云原生、AI智能和ESG三大特征的IT引擎——擎天,并構建出諸多數字化最佳實踐。可以幫助客戶打造專屬的企業大模型,全面賦能企業的業務系統。以實賦實,幫助客戶實現 AI轉型。

在生成式人工智能蓬勃發展的背后,算力尤其是AI算力已經成為驅動大模型進化的核心引擎。聯想積極響應國家“東數西算”戰略,目前已在寧夏等西部地區布局綠色數據中心資源,并與多方聯手打造多個行業標桿項目。

如今,聯想在甘肅參與打造了西北地區最大的智算和超算平臺—紫金云。據了解,紫金云算力平臺不僅承擔著西部與東部的協同樞紐功能,還面對西北地區計算和存儲資源需求,在端邊云網間輸送先進算力。

未來,AI的落地、普及與安全,不僅僅是智能設備的課題,更關乎全產品組合與全方位、全景式的能力布局。

戴煒表示,“在 AI大模型浪潮下,在新的智能算力需求下,聯想致力于成為“新IT”全棧解決方案提供商,為客戶提供 AI內嵌的智能終端,AI導向的基礎設施,以及 AI原生的方案服務,為政府、教育、制造、金融等行業客戶提供 AI大模型賦能的“端邊云網智”全棧解決方案,加速客戶的智能化轉型。”

-

RT-Thread

+關注

關注

31文章

1285瀏覽量

40089

原文標題:?【第20231110期嵌入式AI簡報】OpenAI 如何再次讓 AI 圈一夜未眠?

文章出處:【微信號:RTThread,微信公眾號:RTThread物聯網操作系統】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

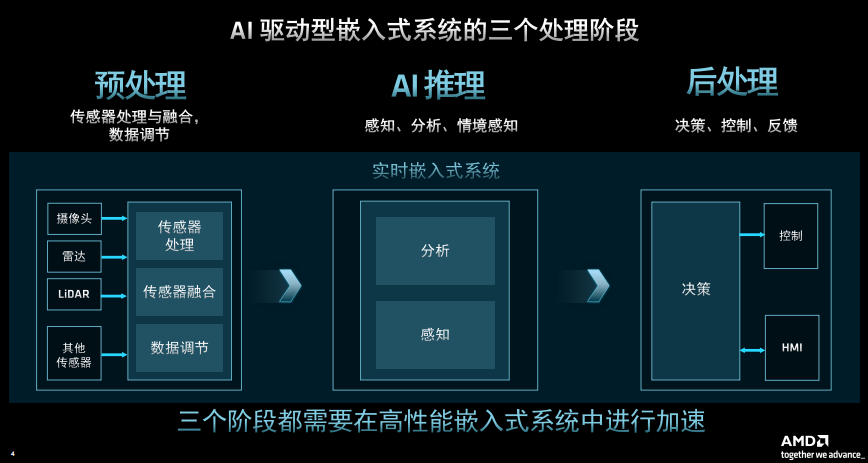

AMD分析嵌入式邊緣AI的發展

開啟全新AI時代 智能嵌入式系統快速發展——“第六屆國產嵌入式操作系統技術與產業發展論壇”圓滿結束

恩智浦加速嵌入式AI創新應用開發

AI普及給嵌入式設計人員帶來新挑戰

EVASH Ultra EEPROM:助力ChatGPT等AI應用的嵌入式存儲解決方案

openEuler 24.03 LTS Meetup:聚焦AI、嵌入式與分布式創新

AI引爆邊緣計算變革,塑造嵌入式產業新未來AI引爆邊緣計算變革,塑造嵌入式產業新未來——2024研華嵌入式

蘋果市值一夜大漲495億美元 蘋果搭上OpenAI的AI快車?

AI與開源力推嵌入式系統創新升級

英偉達市值一夜蒸發6116億元

嵌入式人工智能的就業方向有哪些?

新火種AI|扎克伯格力壓蓋茨!Meta一夜狂漲萬億,全憑AI逆天改命?

?【第20231110期嵌入式AI簡報】OpenAI 如何再次讓 AI 圈一夜未眠?

?【第20231110期嵌入式AI簡報】OpenAI 如何再次讓 AI 圈一夜未眠?

評論