Tensor Core GPU 掀起了一股生成式 AI 模型的淘金熱。無論是幫助學生完成數學作業、計劃假期,還是學習準備六道菜的飯菜,生成式 AI 都準備好了答案。但這只是人工智能的一個方面,并不是每個應用程序都需要它。

人工智能——現在是一個包羅萬象的術語,指的是使用算法來學習、預測和做出決策的過程——模仿人類智能。它可以承擔諸如識別面孔和模式以及解釋解決問題的數據等工作。許多任務可以通過人工智能實現自動化,以提高生產力,并將對人腦來說過于復雜或需要太多手動工作的數據鏈接在一起。

但是,利用 AI 所需的計算能力差異很大,具體取決于應用程序和 AI 的類型。3 級自動駕駛需要與使用 AI 監控客戶流量的零售應用程序截然不同的 AI。任務越復雜,結果越準確,對 AI 計算能力的需求就越大,訓練 AI 必須收集的數據就越多。

那么,開發人員應該如何做出正確的 AI 選擇呢?“人工智能需要從數據中學習,”西門子EDA集成電路設計驗證AI/ML解決方案產品經理Dan Yu說,“每個開發人員需要問的第一個問題是,‘我在哪里可以獲得數據來訓練我的人工智能和機器學習模型?第三方數據可能可用,但您必須對其進行驗證,以確保它是正確的數據,并且 AI/機器學習模型做出正確的預測。如果沒有數據,就沒有機器學習。

至少 70% 的 AI 訓練時間用于查找正確的數據、清理數據以及從數據中提取有用的信息,這是很常見的。大部分余額都花在了微調人工智能和機器學習模型上。

“當我們談論訓練、微調和將人工智能機器學習模型部署到應用程序中時,許多自動駕駛領域的領導者都在努力尋找足夠有意義的數據,”Yu 說。“他們可能有辦法從行車記錄儀和傳感器(如汽車周圍的激光雷達)收集大量數據,但大多數數據在訓練人工智能模型時沒有用。您希望模型能夠體驗所有難以想象的場景。例如,一棟建筑物剛剛倒塌在您的車輛前方。你的行動是什么?作為人類,我們知道我們想逃跑。它存在于人類基因中。但是,如果沒有遇到這種情況,它就不在AI基因中。如果你沒有數據來訓練人工智能做某事,人工智能只會假設什么都沒發生,自動駕駛汽車就會繼續行駛。數據是無處不在的人工智能的關鍵部分。

人工智能的好處是有代價

的 人工智能在制造業、汽車、金融、醫療保健、教育、農業、智慧城市、娛樂、國防、能源、零售和數據中心等領域的作用越來越大。人工智能芯片現在安裝在臺式機和筆記本電腦中。然而,人工智能為眾多行業帶來的所有好處都不是免費的。

NVIDIA 的 Tensor Core GPU 的成本高達 40,000 美元,功耗高達 700W。對于科學和語言建模等高端應用,需要高性能機器學習系統,例如 Cerebras 的機器學習系統。由2.2萬億個晶體管和6,850個AI優化計算內核組成的新的第二代晶圓級處理器(WSE-000)將耗資數百萬美元,并具有多個冗余4KW電源。

“每個人都在談論生成式人工智能可以為你做的一切,但有一個隱藏的成本,”Ampere首席產品官Jeff Wittich說。“如果我們只關心運行最大性能,人工智能將很快成為世界第一大能源用戶。如今,數據中心產生的一氧化碳已占全球的 3% 左右2——不僅僅是航空和航運。人工智能將需要更多倍的計算能力,而這很快就會失控。這可以比作擁有一輛賽車。當然,它可以跑得非常快,但它需要大量的燃料。對于比賽來說,這沒關系。對于每個人來說,每天駕駛其中之一將是災難性的。

優化模型和提高計算利用率是關鍵。“如今,許多 AI 推理模型都在耗電的 GPU 上運行,”Wittich 說。“這些 GPU 非常強大,可以快速運行模型,但我們越來越多地看到它們的功能沒有得到充分利用。許多公司不需要一直使用所有電源,而 GPU 在閑置時仍在使用電源。

AI的類型

生成式 AI 和預測性 AI 是兩種截然不同的 AI。前者需要高性能和密集計算,而后者可以使用低成本的SoC來實現。

瑞薩電子高級總監兼業務、加速和生態系統負責人Kaushal Vora表示:“當今的AI用例大致可分為兩個領域——生成式AI和預測性AI。“生成式人工智能的主要目標是生成新內容,而預測性人工智能的目標是分析數據以做出預測和業務決策。生成式 AI 利用基礎模型和轉換器來針對語言學、文本、圖像、視頻等領域的廣泛和大規模應用。這些模型往往非常大,通常消耗數百 GB 的內存,并且需要在云中以 GPU 和 CPU 的形式進行超大規模計算來訓練和運行推理。

相比之下,預測性 AI 在資源受限的網絡層上運行,例如網絡邊緣和物聯網端點。“這種類型的人工智能通常也被稱為邊緣人工智能或TinyML,”Vora說。“邊緣/端點的一些領域和用例正在迅速采用人工智能,包括語音作為人機通信、環境傳感和預測分析以及機器維護的用戶界面。我們看到廣泛的垂直行業采用。運行這種AI的計算引擎通常是具有幾個GOPS(每秒千兆操作)的微控制器,或者是性能低于1 TOPS的微處理器。

與此同時,生成式 AI 正在推動服務器級別對極高 AI 性能的需求。Synopsys AI/ML 處理器產品經理 Gordon Cooper 表示,該級別的關鍵性能指標 (KPI) 與性能有關,這意味著人們需要等待多長時間才能讓生成式 AI 給出答案,以及面積和功耗/熱成本。“唯一需要大量生成式人工智能(1,000+ TOPS)的實時應用是L3/L4自動駕駛。鑒于對生成式人工智能的興奮和炒作,關于如何最好地將這些功能轉移到邊緣設備,人們提出了許多問題。算法必須發展。像 ChatGPT 這樣的東西需要太多參數。實時人工智能的性能水平需要提高才能滿足需求。

選擇正確的 AI

在選擇正確的 AI設計時需要考慮許多因素,包括項目目標、準確性要求、靈活性、中央計算與邊緣計算以及設計權衡。

1) 項目目標

選擇合適的 AI 取決于應用程序要求。您需要生成式 AI 還是預測性 AI 就足夠了?復雜性、準確性、延遲、安全性、隱私性和安全性要求是什么?因為人工智能不是免費的,所以僅僅因為其他人都在做人工智能就包括人工智能是沒有意義的。遲早,人工智能的炒作會消失。

例如,在使用聊天機器人將客戶引導到正確部門的一般客戶服務應用程序中,自然語言處理能力和流暢性很重要,但延遲和安全性并不是主要問題。幾秒鐘的延遲并不重要。相反,在自動駕駛中,準確性、延遲、安全性和安全性都非常重要。制動時延遲幾秒鐘可能會導致碰撞。用于控制娛樂系統的車內語音控制助手則是另一回事。故障可能會造成不便,但不會造成緊急情況。

同樣重要的是要記住,每個決定都會影響整體預算。

2)什么才足夠好?

一些開發人員傾向于不惜一切代價追求完美,或者至少想要高性能和準確性。但對于許多 AI 應用程序來說,達到 90% 的準確率就足夠了。超過 95% 雖然可行,但成本可能非常高。因此,從最低要求開始。如果任務可以以 90% 的準確率得到滿足,請到此為止。

3) 準確性 在做出 AI 芯片設計決策時,需要考慮多種因素,例如準確性、性能、移動性、靈活性和預算。

Synopsys戰略營銷經理Ron Lowman認為,兩個簡單的問題決定了將哪種AI芯片用于哪些應用。“首先,成功所需的最低精度是多少?其次,你能花多少錢來達到這個精度?人工智能只是一種新的生產力工具,隨著時間的推移,非常聰明的工程師和企業家將對其進行迭代,以改進大量流程,類似于電力驅動電機而不是手動曲柄。如果您需要高精度和合理的預算,NVIDIA 的產品是合理的選擇。但是,如果您可以接受低精度且預算較低,則可以選擇成本低得多的 AI 芯片或 AI 加速有限甚至沒有 AI 加速的傳統 SoC。如果這些芯片需要移動且高效/低功耗,但預算較低,則可以接受更高效且精度較低的 SoC。如果你需要高精度和低功耗,這很昂貴,需要ASIC,或者你必須等到我們在新設計上迭代幾代人。

最昂貴的類別是具有大量 AI 加速的 SoC,可處理高度定制的壓縮算法。汽車需要高精度,并且需要移動和低功耗。“這意味著必須設計出比最高性能的 GPU/AI SoC 更高效的新 SoC,這需要大量投資。然后添加可靠性組件,“Lowman說。

人工智能設計標準中最重要的因素是準確性。

“精度通常受到位分辨率和/或算法選擇的影響,”Cooper說。“使用轉換器算法,其精度優于CNN,需要支持最新架構進步的神經網絡和足夠的位分辨率來實現精度 - 盡管在很大程度上依賴于算法。在準確性之后,性能至關重要。如果你不能達到每秒可用的幀數,世界上所有的準確性都無濟于事,即使它在很大程度上取決于用例。其他因素包括成本(通常與芯片面積有關)、功耗和開發工具的易用性。

4) 靈活性

對于需要靈活性和快速軟件升級的設計,可以考慮采用嵌入式 FPGA 方法。

Flex Logix 首席技術官 Cheng Wang 表示:“在實施 AI 時,無論是在芯片上還是在系統上,了解機器學習應用程序不斷變化的工作負載需求都很重要。“你需要設計靈活性,因為人工智能領域的發展太快了。您的芯片設計周期為三到五年,并且需要立即進行軟件升級。我們正在努力提高開發人員的意識。

集中式 AI 計算與邊緣 AI 計算 雖然云計算提供了需要強大計算

能力的 AI 解決方案,但許多其他實時應用(如智慧城市、零售、增強現實和預防性維護)可能會從邊緣 AI 中受益。

但是,這取決于正在構建的應用程序類型以及必須在其中工作的資源邊界。

“傳統上,從人工智能的角度來看,我們有一個以云為中心的智能模型,”瑞薩電子的Vora說。“如果我們真的想在網絡的極端邊緣和端點實現智能,就必須以一種高效、實時響應和具有成本效益的方式完成。”

這意味著在端點內的微型計算機上運行獨立于云的推理引擎。

“去中心化的智能模型具有巨大的技術和經濟效益,”Vora說。“作為設計師/架構師/產品開發人員,在定義階段的早期考慮 AI/ML 并了解您必須使用哪些資源和系統約束至關重要。有多種軟件和硬件架構可供選擇。在使用邊緣和端點應用程序時,請尋找一個合作伙伴/供應商,不僅提供芯片,還提供 AI/ML 工具、參考解決方案和軟件的整體生態系統。

AI/ML應該在產品的定義階段考慮,因為硬件選擇主要由系統級需求和資源限制驅動。

大多數基于傳感器的應用都可以使用植根于信號處理、數學和統計學的更簡單的經典機器學習算法來解決。機器視覺和語音識別等更復雜的應用需要深度學習方法。用例的復雜性將影響硬件選擇,包括在軟件中運行 AI 的純 CPU、與神經加速引擎相結合的 CPU、專用 AI SoC 和高性能 CPU/GPU。

展望未來:人工智能有兩條道路。一個提供非常高的性能,但會消耗大量能量。另一個則更注重能源效率和優化。兩者都有市場需求。

預計軟件和硬件的新人工智能創新將繼續發展。許多新的解決方案來自科技巨頭和初創企業,包括 Axelera、SiMa.ai、Flex Logix、Quadric、Expedera、NeuReality、Kneron、Hailo.ai 等。以下是一些來自初創公司的例子。

根據 MLCommons ML Perf 3.1 基準測試中的封閉邊緣功率類別,為 ML 邊緣計算設計的“拖放式”無代碼可視化編程據說優于該領域的一些當前領導者。

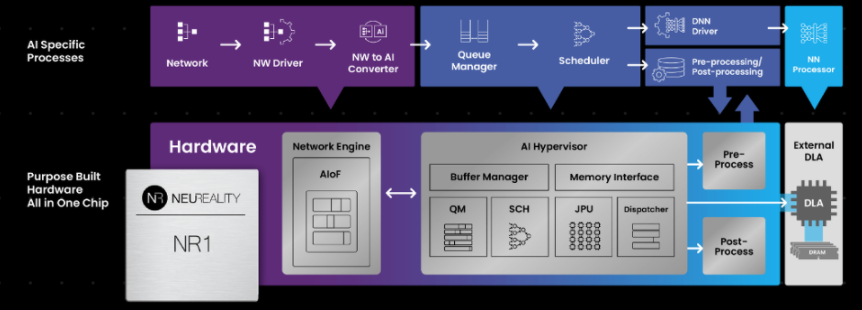

另一個進步是 AI 推理服務器架構試圖取代傳統的以 CPU 為中心的多用途 AI 解決方案。運行 ChatGPT 每天可能要花費數百萬美元。運營效率現在變得越來越重要。系統級解決方案可以優化和擴展 AI 工作流程,以降低網絡連接處理單元的整體運營成本。新的以人工智能為中心的方法更加基于硬件,可以更快地執行指令處理。

圖 1:基于硬件的以 AI 為中心的架構依賴于網絡連接的處理單元來執行大部分 AI 工作流。來源:NeuReality

最后,雖然 GPU 在 AI 應用中受到廣泛關注,但在軟件更新方面,嵌入式 FPGA 功耗更低、可擴展性更強且更靈活。這很重要,因為 AI 算法變化非常快,無論是為了提高性能和兼容性,還是出于安全原因。

結論

人工智能創新將繼續加速。從長遠來看,人工智能開發將更強大、更節能、更低成本,為開發者提供更多的人工智能選擇

-

傳感器

+關注

關注

2550文章

51038瀏覽量

753086 -

云計算

+關注

關注

39文章

7774瀏覽量

137355 -

gpu

+關注

關注

28文章

4729瀏覽量

128892 -

AI

+關注

關注

87文章

30738瀏覽量

268896 -

機器學習

+關注

關注

66文章

8407瀏覽量

132567

發布評論請先 登錄

相關推薦

如何選擇正確的AI?AI的類型有哪些?

如何選擇正確的AI?AI的類型有哪些?

評論