Meta 一直沒放棄元宇宙。

2021 年,Facebook 將「元宇宙(metaverse)」作為公司主營業務,并將公司名稱更改為 Meta。然而,這一年,隨著 ChatGPT 的橫空出世,生成式 AI 成為一個新的研究趨勢,很多科技公司都將生成式 AI 作為公司重要研發業務。但 Meta 一直沒有停止 VR/AR 的研究步伐。

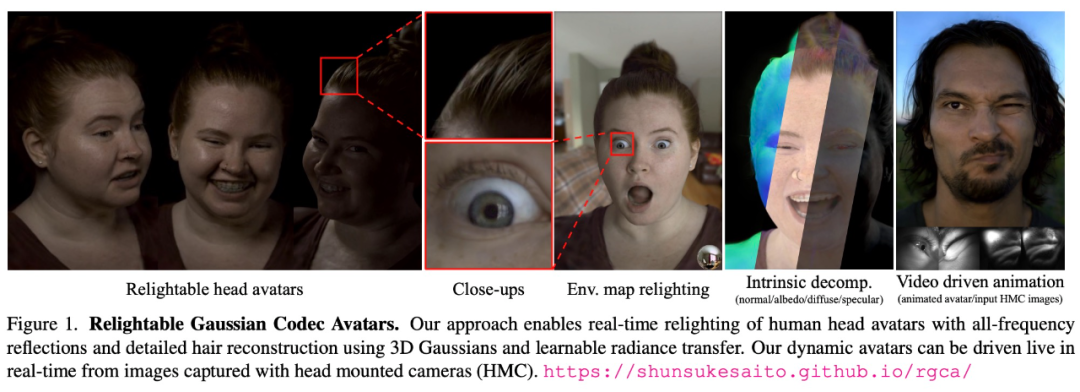

最近,Meta 的 Codec Avatars Lab 提出了一種高保真、光線可調節的虛擬頭像合成方法 ——Relightable Gaussian Codec Avatars。

論文地址:https://arxiv.org/pdf/2312.03704.pdf

項目主頁:https://shunsukesaito.github.io/rgca/

今年 9 月,Meta 首席執行官馬克?扎克伯格與麻省理工學院(MIT)科學家 Lex Fridman 在元宇宙里進行了一小時的對話。彼時,兩位的形象是使用掃描技術構建的用戶面部 3D 模型,逼真度已經很高。

現在,Relightable Gaussian Codec Avatars 能夠構建更加逼真、光線可調節的實時 3D 頭像,精細到連頭發絲都清晰可見:

下面我們來看下 Relightable Gaussian Codec Avatars 方法的核心內容和實驗結果。

方法簡介

我們知道,人類的視覺感知對人臉外觀高度敏感,因此合成 3D 頭像 / 虛擬化身(avatar)一直存在一些挑戰。

首先,人類頭部由高度復雜和多樣化的材料組成,這些材料表現出不同的散射和反射特性。例如,皮膚由于微觀幾何形狀以及顯著的次表面散射而產生復雜的反射,頭發由于其半透明纖維結構而表現出具有多次反射的面外散射,而眼睛有多個具有高反射膜的層。總的來說,沒有一種單一的材料表征可以準確地表示所有這些,尤其是實時的。

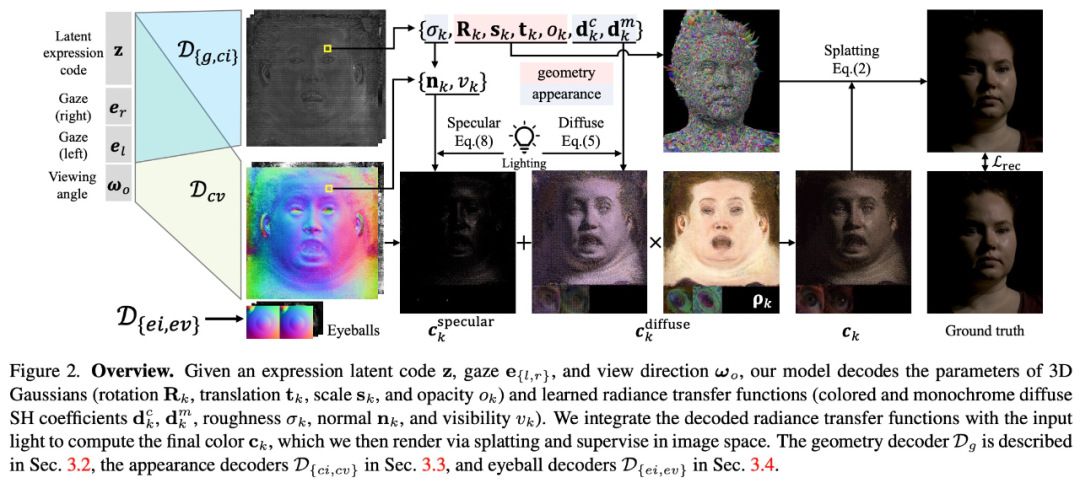

為了以統一的方式表征人體頭部的多種材質,該研究提出了一種基于可學習輻射傳輸(radiance transfer)的新型可重新照明外觀模型,使用球面高斯實現了全頻率反射的實時重新照明。

另一方面,對運動中的底層幾何體進行精確跟蹤和建模極具挑戰性。為此,該研究提出基于 3D 高斯的可驅動化身,使用 Gaussian Splatting 技術有效地渲染復雜的幾何細節。

此外,該研究還提出了可重新照明的顯式眼睛模型,首次以完全數據驅動的方式實現對其他面部運動以及全頻率眼部反射的注視控制,并進一步提高了眼睛反射的保真度。

最終,Relightable Gaussian Codec Avatars 可以捕獲 3D 一致的亞毫米細節,例如動態面部序列上的發絲和毛孔。

實驗及結果

上圖 1 顯示了重建的虛擬人物可以擁有新的表情、視圖以及光照,包括點光源和高分辨率環境圖。就連眼睛中的光反射,都忠實地再現了周圍環境,而不會丟失高頻細節。

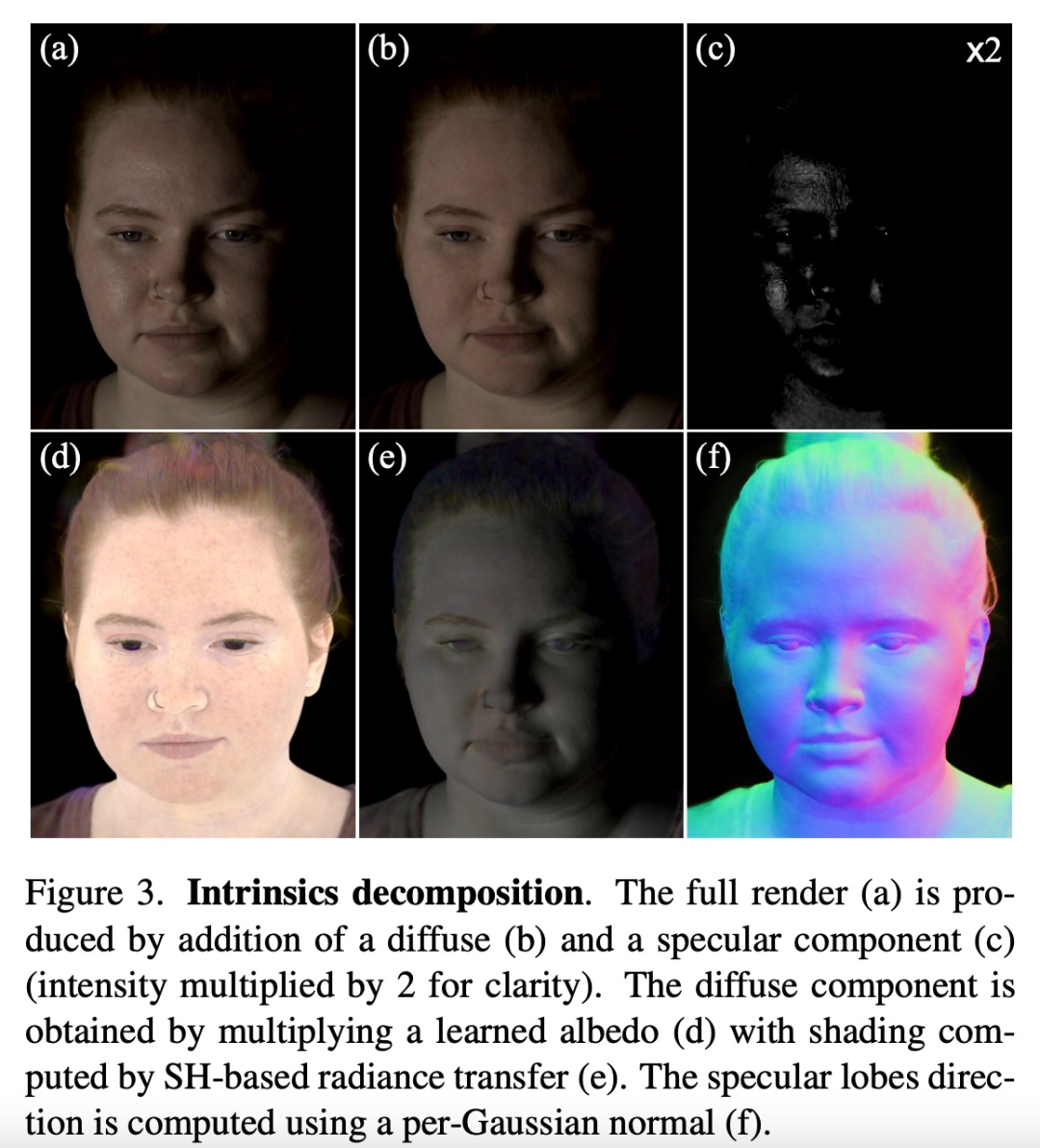

如圖 3 所示,Relightable Gaussian Codec Avatars方法能夠實現 3D 一致且高保真的內部分解。

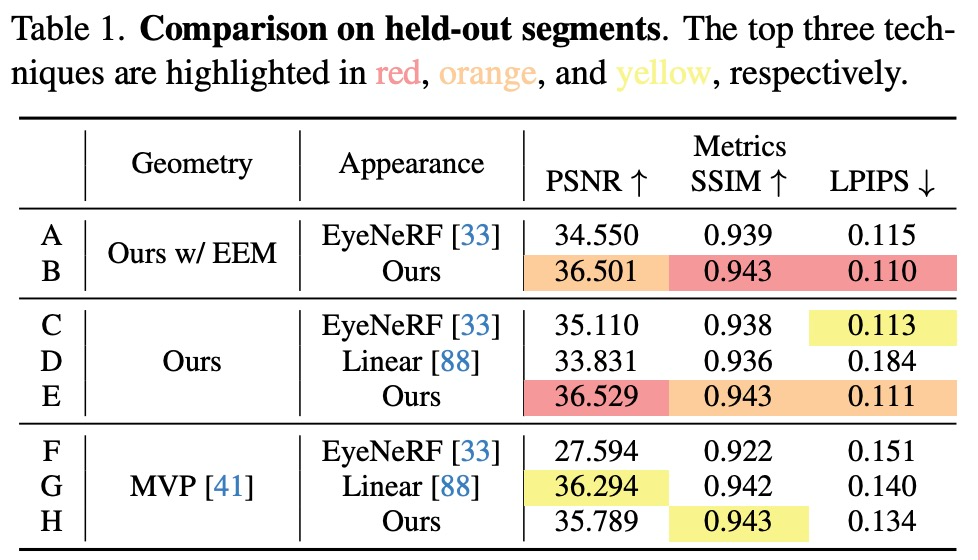

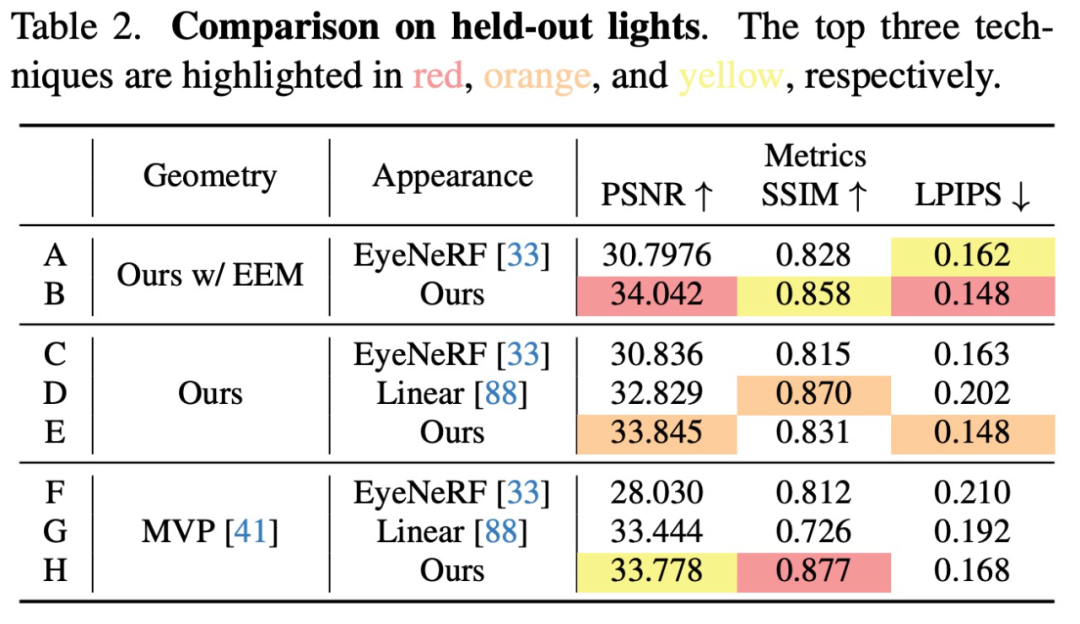

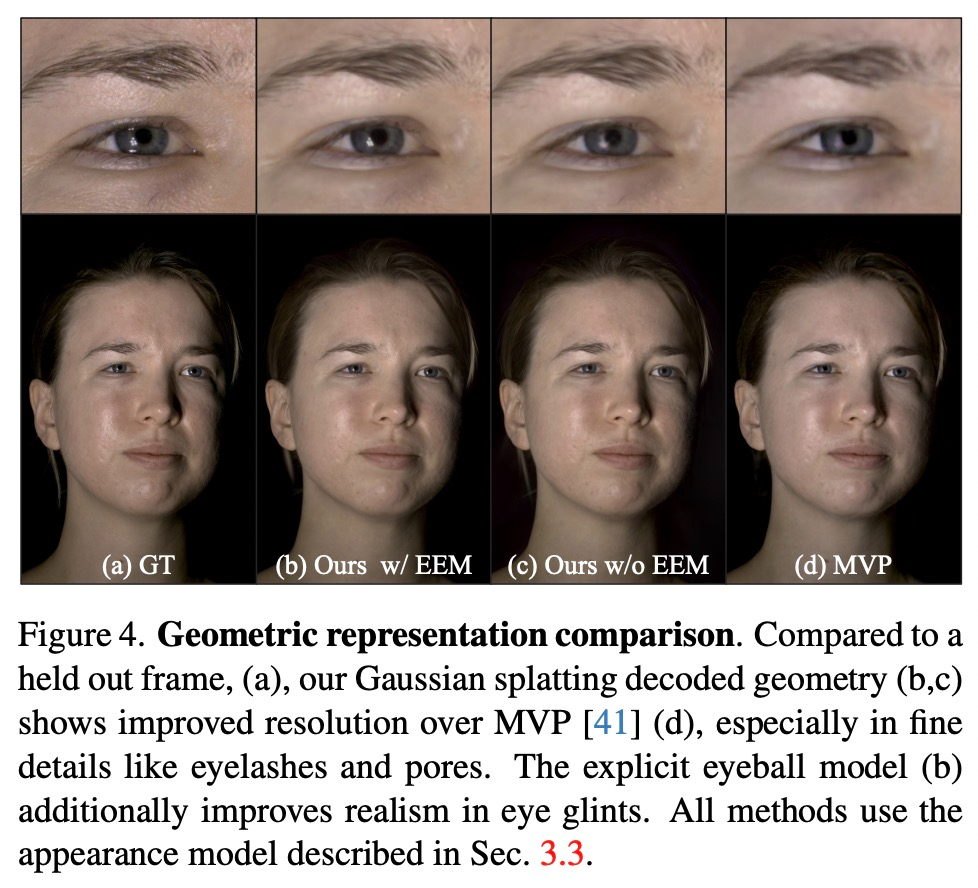

幾何表征。該研究通過比較三種變體來評估幾何組件:本文方法、本文方法但排除了顯式眼睛模型(EEM)和基于體素的原型。為了公平比較,該研究使用相同的外觀模型,僅改變幾何表征(表 1 和表 2 B、D、H)。

圖 4 清楚地表明,基于 3D 高斯的幾何體可以比 MVP 更好地建模皮膚細節和發絲。此外,完整的模型與 EEM 結合使用時,眼睛里的反光都非常令人折服。除了在強光下的 SSIM 指標外,高斯模型在所有指標中都取得了優異的性能。

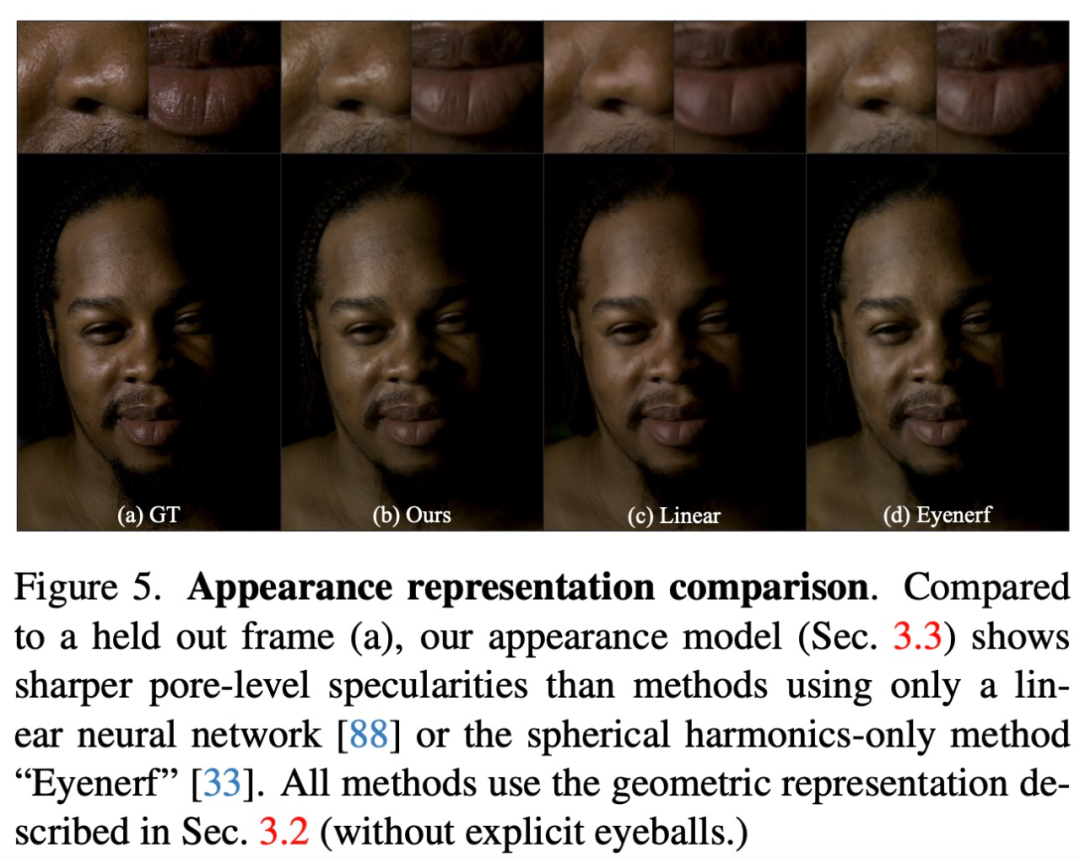

外觀表征。對于外觀表征,該研究將外觀模型與現有的 relightable 外觀表征進行了比較。如上表 1 和表 2 C、D、E 顯示,本文的外觀表征在大多數指標中優于現有的外觀模型。

如圖 5 所示,雖然線性模型可以產生正確的顏色,但 relighting 的結果模糊且缺乏高頻細節。EyeNeRF 中與視圖相關的球諧函數顯示出更詳細的反射,但由于使用球諧函數來實現鏡面反射,因此其表現力受到限制。此外,該研究觀察到依賴于視圖的球諧函數更容易過度擬合,從而導致動畫中出現閃爍偽影。相比之下,Relightable Gaussian Codec Avatars方法不受帶寬限制,因此實現了高頻反射。

-

3D

+關注

關注

9文章

2875瀏覽量

107486 -

Facebook

+關注

關注

3文章

1429瀏覽量

54722 -

Meta

+關注

關注

0文章

270瀏覽量

11378

原文標題:逼真到頭發絲,光線可調,Meta推出實時3D頭像合成方法

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

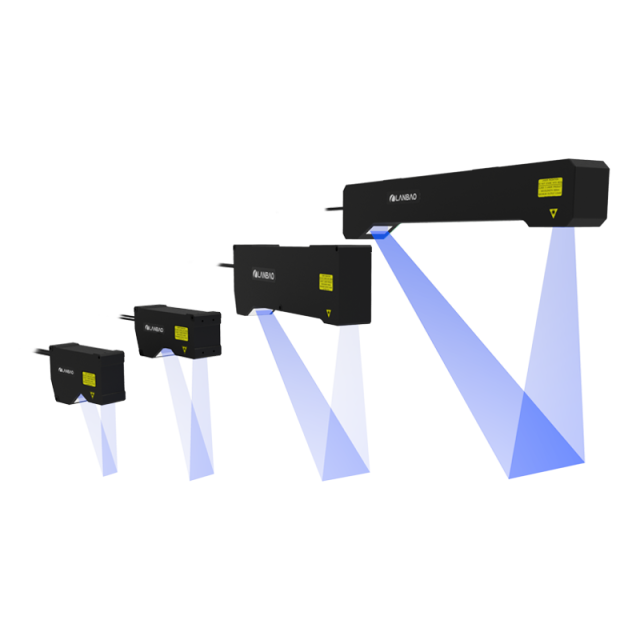

3D激光線掃輪廓傳感器在汽車行業的汽車車縫檢測的應用

裸眼3D筆記本電腦——先進的光場裸眼3D技術

Meta推出革命性3D Gen AI模型:1分鐘內生成高質量3D內容

奧比中光3D相機打造高質量、低成本的3D動作捕捉與3D動畫內容生成方案

VIVERSE 推行實時3D渲染: 探索Polygon Streaming技術力量與應用

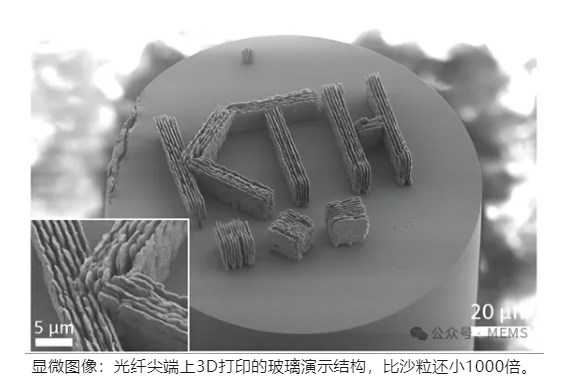

光纖尖端上3D打印的玻璃折射率傳感器,可測量有機溶劑的濃度

天馬微電子首發TIANMA META SIGHT光場3D解決方案

UltiMaker正式推出了工業級3D打印機—UltiMaker Factor 4

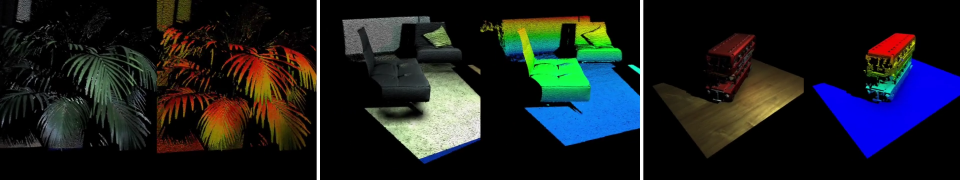

Meta發布SceneScript視覺模型,高效構建室內3D模型

Stability AI推出全新Stable Video 3D模型

谷歌模型合成軟件有哪些

Adobe提出DMV3D:3D生成只需30秒!讓文本、圖像都動起來的新方法!

逼真到頭發絲,光線可調,Meta推出實時3D頭像合成方法

逼真到頭發絲,光線可調,Meta推出實時3D頭像合成方法

評論