OpenAI 發布 GPT-4 Turbo 目前我們所知道的功能分析解答

在最近的OpenAI DevDay上,該組織發布了一項備受期待的公告:推出GPT-4 Turbo,這是對其突破性AI模型的改進。在這里,我們全面了解GPT-4 Turbo是什么、它的主要功能以及它如何使開發人員和用戶受益。

了解 OpenAI 的最新更新、具有視覺功能的 GPT-4 Turbo 及其主要功能,包括改進的知識截止、擴展的上下文窗口、預算友好的定價等。

什么是GPT-4 Turbo?

GPT-4 Turbo是現有GPT-4大語言模型的更新。它帶來了一些改進,包括大大增加的上下文窗口和對更多最新知識的訪問。OpenAI逐漸改進ChatGPT中GPT-4的功能,添加了自定義指令、ChatGPT插件、DALL-E 3和高級數據分析。此最新更新帶來了許多令人興奮的新功能。

什么是GPT-4 Turbo With Vision?

具有視覺功能的GPT-4 Turbo是GPT-4 Turbo的變體,包含光學字符識別(OCR)功能。也就是說,您可以向它提供圖像,它可以返回圖像中包含的任何文本。例如,您可以輸入菜單的照片,它將返回該照片中寫入的食物選擇。同樣,您可以提供發票照片并自動提取供應商名稱和商品詳細信息。

ChatGPT默認提供“with Vision”功能,開發人員可以通過在OpenAI API中選擇“gpt-4-vision”模型來使用。

GPT-4 Turbo主要特性

GPT-4 Turbo與之前的型號相比有多項改進,增強了其功能。以下是使其脫穎而出的一些關鍵功能:

改進知識截止

Sam Altman承諾確保ChatGPT保持最新狀態

Sam Altman承諾確保ChatGPT保持最新狀態

GPT-3.5和GPT-4的現有版本的知識截止日期為2021年9月。這意味著它們無法回答有關該時間之后發生的現實世界事件的問題,除非獲得外部數據源的訪問權限。

GPT-4將知識截止時間延長了19個月,至2023年4月。這意味著GPT-4 Turbo可以訪問截至該日期的信息和事件,使其成為更明智、更可靠的信息來源。此外,OpenAI的首席執行官Sam Altman承諾“[OpenAI]將努力永遠不會讓[GPT]再次過時。”

128K上下文窗口

大型語言模型(LLM)的上下文窗口是衡量其對話記憶持續時間的指標。如果模型的上下文窗口包含4,000個令牌(約3,000個單詞),則聊天中超過4,000個令牌之前的所有內容都會被忽略,并且響應可能會變得不太準確,甚至與之前的響應相矛盾。對于處理較長的文檔或進行長時間對話的聊天機器人來說,這是一個問題。

GPT-4的最大上下文長度為32k(32,000)個令牌。GPT-4 Turbo將其增加到128k令牌(大約240頁,每頁400個字)。這超過了Anthropic的Claude 2模型的100k最大上下文,并使其與Nous Research的YARN-MISTRAL-7b-128k模型保持一致。

較長的上下文窗口是否會導致整個窗口的響應性能令人滿意,還有待觀察。斯坦福大學最近的研究表明,現有的長上下文模型只能在從文檔開頭或結尾附近檢索信息時提供準確的響應。

還值得注意的是,128k似乎只是實現“無限上下文”夢想的墊腳石。微軟和西安交通大學的早期研究旨在將法學碩士規模擴大到十億個代幣的背景。

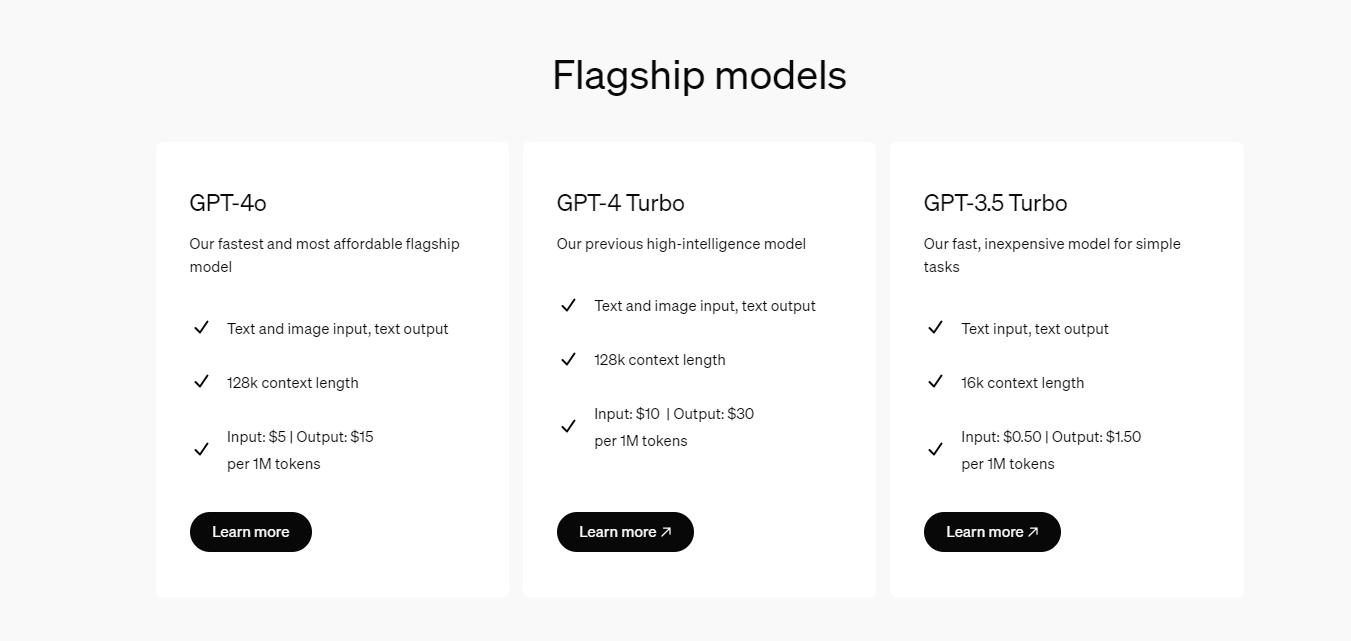

GPT開始發售

OpenAI響應了LLM市場日益激烈的競爭,并降低了GPT-4 Turbo的價格,以便為開發人員提供經濟實惠的價格。使用OpenAI API時,GPT-4 Turbo輸入代幣價格現在是之前價格的三分之一,從每1000個代幣3美分降至1美分。產出的代幣現在是半價,從每1000個代幣6美分降至3美分。

GPT-3.5 Turbo模型也延續了同樣的趨勢,以每1000個代幣0.1美分的價格提供了3倍便宜的輸入代幣,以每1000個代幣0.2美分的價格提供了2倍便宜的輸出代幣。

此外,經過微調的GPT-3.5 Turbo 4K模型輸入代幣現在價格便宜4倍,價格從每1000個代幣1.2美分降至0.3美分,輸出代幣便宜2.7倍,從每1.6美分降至0.6美分每1000個代幣為美分。培訓價格保持不變,為每1000個代幣0.8美分。

這些價格調整旨在使先進的人工智能模型對開發者來說更??具成本效益。

GPT走向多模式:圖像提示和文本轉語音

“GPT-4 Turbo with Vision”宣布即將推出。您很快就可以通過直接在聊天框中輸入圖像作為提示來提示GPT-4 Turbo。然后,該工具將能夠生成標題或提供圖像所描繪內容的描述。它還將處理文本到語音的請求。

函數調用更新

函數調用是開發人員將生成式人工智能融入其應用程序的一項功能。它使他們能夠向GPT-4 Turbo描述其應用程序的功能或外部API。由于能夠在一條消息中調用多個函數,此功能簡化了與模型的交互。例如,用戶可以發送一條請求多個操作的消息,從而無需與模型進行多次來回交互。

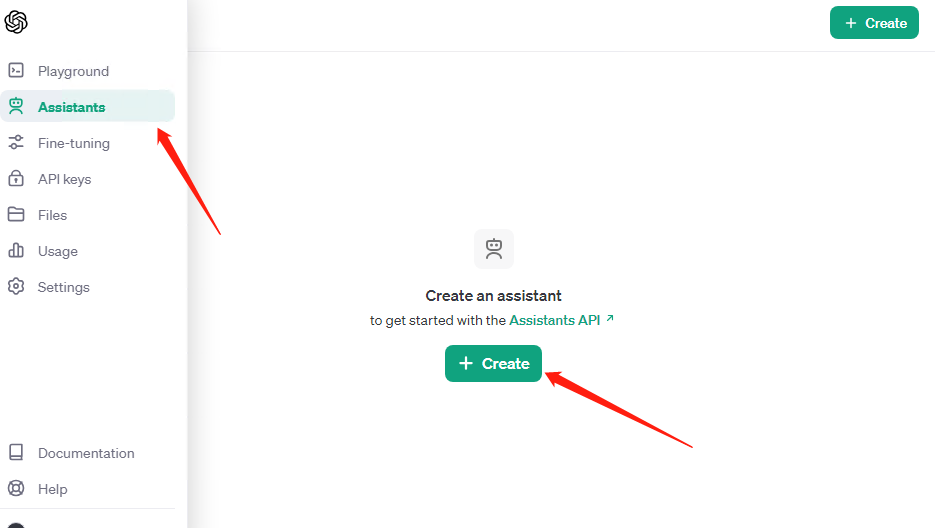

如何訪問GPT-4 Turbo

“所有付費開發人員”都可以訪問GPT-4 Turbo,這意味著如果您具有API訪問權限,則只需在OpenAI API中傳遞“gpt-4-1106-preview”作為模型名稱即可。同樣,對于具有視覺功能的GPT-4 Turbo,您可以傳遞“gpt-4-vision-preview”作為模型名稱。

請注意,這些預覽模型尚未被認為適合生產使用。然而,作為公告的一部分,Altman還承諾將在未來幾周內推出可投入生產的版本。

對于非開發人員來說,GPT-4 Turbo可能會在未來幾周內向ChatGPT Plus和ChatGPT Enterprise用戶提供。

速率限制

通過OpenAI API訪問GPt模型的速率受到限制。也就是說,您每月只能向API發出有限數量的請求。OpenAI現已發布關于速率限制如何運作的更清晰指南,因此您的應用程序不會意外被切斷。

此外,GPT-4的速率限制增加了一倍

由于GPT-4 Turbo目前處于預覽階段,因此GPT-4 Turbo的速率限制設置為每分鐘20個請求和每天100個請求。OpenAI已表示,他們目前不會適應此模型的速率限制增加。然而,一旦公開版本可用,他們很可能會這樣做。

最后的思考

GPT-4 Turbo的發布為生成式AI的未來提供了令人興奮的一瞥,我們迫不及待地想掌握它。對于那些尋求更深入了解的人,我們關于在OpenAI API使用GPT-3.5和GPT-4的教程有很多值得探索的地方。

審核編輯 黃宇

-

AI

+關注

關注

87文章

31155瀏覽量

269494 -

OpenAI

+關注

關注

9文章

1100瀏覽量

6583 -

ChatGPT

+關注

關注

29文章

1564瀏覽量

7823

發布評論請先 登錄

相關推薦

解鎖 GPT-4o!2024 ChatGPT Plus 代升級全攻略(附國內支付方法)

科大訊飛發布訊飛星火4.0 Turbo:七大能力超GPT-4 Turbo

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯

OpenAI API Key獲取:開發人員申請GPT-4 API Key教程

ChatGPT plus有什么功能?OpenAI 發布 GPT-4 Turbo 目前我們所知道的功能

ChatGPT plus有什么功能?OpenAI 發布 GPT-4 Turbo 目前我們所知道的功能

評論