電子發燒友網報道(文/周凱揚)今年對于存儲廠商而言,可謂是重新梳理市場需求的一年,不少企業對 NAND和DRAM 的業務進行了大幅調整,有的就選擇了將重心放在下一代 DRAM 上,尤其是在 AI 市場非常吃香的 HBM 內存。

AI 芯片帶來的 HBM 熱潮

在 AI 芯片的設計中,除了需要先進工藝和先進封裝在有限的面積下提供足夠的算力和擴展性外,被提及最多的一個問題就是內存墻。過去內存墻的問題在AI 計算還不盛行的時代并不突出,而且 HBM 當時還被視作高成本的方案。無論是 HBM IP 廠商還是存儲廠商,都還沒給到足夠吸引人的方案。

但隨著 AI 計算在GenAI 應用下一炮走紅,原有的硬件在指數增長的AI 計算需求下,尤其是推理任務下,內存帶寬上的瓶頸愈發明顯,也就成就了過去被視作“小眾需求”的 HBM。從今年各大廠商發布的最新 AI 芯片內存配置來看,基本上都配備了HBM 內存。以英偉達的 H100 為例,就配備了 80GB 的 HBM3 內存,由 5 個 16GB的 HBM3 堆疊在一起,為其提供了最高達 3.35TB/s 的內存帶寬。

而 AMD 剛發布的 MI300X在內存配置上更甚,總容量達到 192GB,采用8 個 24GB HBM3 內存堆疊在單芯片上,提供最高約 5.3TB/s 的理論峰值內存帶寬。不過考慮到出貨時間,與 MI300X 直接對標的屆時將是 2024 年 Q2 出貨的英偉達GH200。GH200將是業內首個配備 HBM3e 的處理器,雖然其 GPU與 H100 保持一致,但 GH200在雙芯片配置下擁有更大容量(282GB)更高速的 HBM3e 內存。

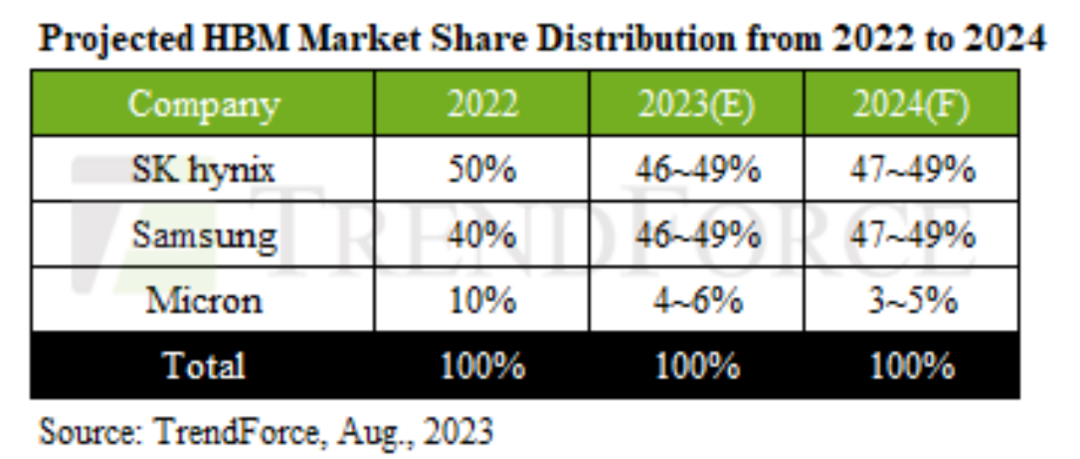

根據TrendForce的預測,今年的 HBM 需求相比去年增長了 58%,而明年將在此基礎上再迎來 30% 的增長。在這樣的市場需求下,HBM 內存供應商們都開啟了搶單大戰。

三家HBM供應商搶單大戰開啟

由于 HBM 需求大漲,為了滿足芯片設計廠商的需求,而不是選擇在有限供應下尋找別的供應商,SK 海力士選擇了加大產能投入。據爆料消息,其明年的計劃設施投入為 76 億美元,比今年的預期值要高 43%到 67%。不僅如此,投入的大部分將花在搭建制造先進 DRAM 芯片的設施上,尤其是 HBM3內存產能,不過 HBM的產能也與 TSV 封裝產能息息相關,考慮到 TSV 設備的交期要更長,所以這一波產能擴張預計要到下半年才會初見成效。

SK 海力士 HBM3e 內存 / SK 海力士

SK 海力士對 HBM的重視程度也不僅僅是加大投資和擴產而已,近期 SK 海力士甚至為其進行了組織架構的調整。12 月 7 日,SK 海力士宣布成立 AI Infra 組織,目的是在未來的 AI 基礎設施市場中繼續保持競爭優勢。

在 AI Infra 組織下,SK 海力士成立兩個部門,分別是 HBM 業務部門和 AI&Next 業務部門,前者負責整合分散的HBM 相關的人才與職能,后者負責探索新的 AI 市場,包括下一代 HBM 技術。而原先負責與 HBM 客戶溝通的 GSM 組織也將被并入 AI Infra組織。

但介于目前 SK 海力士的產能還是沒法滿足需求,且英偉達之類的廠商更樂意擁有靈活的供應鏈選擇,所以美光、三星兩家也在英偉達的 GPU 上找到了供應合作的機會。美光作為目前在 HBM 處于劣勢地位的廠商,其 HBM 市場份額只有 10% 左右。但憑借較快的產品導入速度,也在今年宣布英偉達正在下一代數據中心 GPU 上測試其 HBM3E 內存。

面臨三星和 SK 海力士這兩家已經在 HBM 市場站穩腳跟的廠商,或許從最新乃至下一代HBM技術上發力能給到美光異軍突起的機會,畢竟 HBM3e 相比 HBM3 和 HBM2 來說,附加價值更高,新的設計訂單數量也更多。為此美光在中國臺灣和日本積極擴產,除了繼續擴大已有的 1β與 TSV 產能外,也在繼續推進 1γ內存工藝節點的落成。

據傳三星也和美光一樣,在今年宣布通過了英偉達對 HBM 產品的質量測試,并與英偉達簽署了供應協議。雖然傳言并未得到證實,但從三星近期購置了數臺 2.5D封裝設備的動向來看,很可能就是針對英偉達下一代 GPU 所用HBM 的制造與封裝訂單的。考慮到三星自己也有 X-Cube 這樣針對 HBM 的2.5D/3D封裝工藝,Fabless 廠商選擇三星或許能進一步降低封裝制造的成本。

HBM3/3e與未來的 HBM4

除了擴產外,這場搶單大戰也延續到了相關產品的發布上,HBM 內存供應商在今年紛紛公開了自己的 HBM3e 產品,為的就是提前一步搶下 2023 下半年乃至明年的設計方案訂單。美光在今年7 月率先公布了自己的 HBM3E 產品,該公司也將其稱之為 HBM3 Gen2。

在業界領先的1β工藝和 8Hi 堆疊設計下,美光表示其HBM3 Gen2產品可以提供高達 1.2TB/s 的帶寬,以及同樣封裝尺寸下高出 50% 的單 die 密度,即最高 24GB的單 die 內存。

SK 海力士也于今年 8 月宣布 HBM3e 開始送樣,預計 2024 年上半年開始量產。不過,SK海力士并沒有透露較為具體的容量細節,但其應該和美光一樣,會率先推出的8Hi 的 24GB 版本。在速度上,SK 海力士則稍微落后,在公告中SK 海力士表示其 HBM3e 產品的帶寬為 1.15TB/s。

Shinebolt HBM3e 內存 / 三星

接著三星也在今年 10 月份宣布了全新的 “Shinebolt” HBM3e 內存,在使用D1a 工藝(EUV 10nm 級別)和最高級的 12Hi 堆疊設計后,單 die 容量可達 36GB,單引腳帶寬可達 9.8GB/s,單個堆棧最大帶寬可達 1.225TB/s,高于美光和 SK 海力士。

除了在 HBM 新品量產出貨先后上競爭外,就連下一代產品的開發,都已經成了HBM 內存供應商們搶單的途徑之一。盡管 HBM4的規范還未定稿,但這并不妨礙 HBM 內存供應商與設計廠商展開先行嘗試。以 SK 海力士為例,據報道他們正與英偉達合作,設計可以直接垂直堆疊至邏輯核心上的 HBM4 內存,這一結構類似于 AMD 的 3D V-Cache,只不過堆疊的是帶寬和容量都更大的 HBM 內存。

報道稱 SK 海力士正在與數家 Fabless 廠商商討這一全新的 HBM 集成設計,甚至可能會與英偉達從下一代AI 芯片設計之初就展開合作,最后交給臺積電利用先進封裝技術制造芯片成品。如果 Fabless 廠商與 HBM 內存供應商之間選擇了這種合作方式,那么這該芯片很可能發布之時只有單一內存供應商。

HBM 的需求能持續多久

從不少消息的預測看來,AI 芯片的訂單已經排到了 2024 年。SK 海力士在今年 Q3 季度的財報會議上表示,與客戶/合作伙伴的 HBM 銷售規劃已經排到 2025 年了。從各大廠商最新的財報預測中也能看出,明年服務器市場將迎來逐漸回暖的趨勢,特別是云服務廠商的投資相比今年還會逐步提升。

雖然我們今年看到了通用服務器市場需求的下滑,而 AI服務器在有限的預算控制下呈現飛速增長,但通用服務器也是開展 AI 應用服務的重要一環。因此在更大的迭代需求下,明年會有新的投資涌入通用服務器。

此外,近期也有傳言提到英偉達下修 2024 年下半年 AI 芯片的 CoWoS封裝需求、微軟也下修明年英偉達的 H100 需求。不少人猜測這或許與最新的禁令有一定關系,畢竟中國是 AI 芯片出口的最大市場之一。

不過即便傳言屬實,這也僅僅是英偉達一系列產品的需求變化,無論是 AMD,還是別的自研云服務商,又或是其他 AI 芯片初創企業,短時間內都不會拋棄 HBM 內存。而且SK 海力士等廠商作為上游廠商,對內存市場需求的敏感度更高,如果只是短期爆發的需求,是斷然不會選擇積極擴產的。

-

HBM

+關注

關注

0文章

379瀏覽量

14745

發布評論請先 登錄

相關推薦

特斯拉也在搶購HBM 4

與新工業革命同行,2024 NVIDIA 創業企業展示即將拉開帷幕

2020-2022-2024年TI杯全國大學生電子設計競賽官方推薦芯片對比分析比較

天合光能新一代柔性儲能電池艙Elementa 2真機首次亮相國內

芯海科技榮膺卓越伙伴殊榮,攜手鴻蒙智聯雙向賦能智選品牌創新

HBM、HBM2、HBM3和HBM3e技術對比

HBM搶單大戰,才剛剛拉開帷幕

HBM搶單大戰,才剛剛拉開帷幕

評論