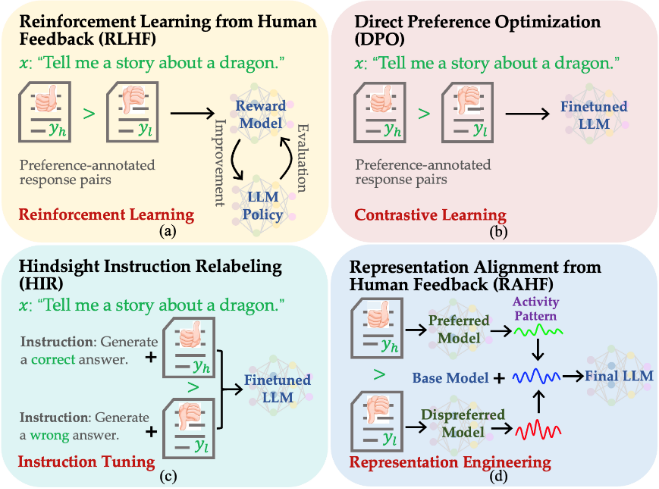

最近復(fù)旦大學(xué)自然語(yǔ)言處理組鄭驍慶和黃萱菁團(tuán)隊(duì)提出了基于表征工程(Representation Engineering)的生成式語(yǔ)言大模型人類偏好對(duì)齊方法RAHF(如圖1所示),作為基于人類反饋的強(qiáng)化學(xué)習(xí)算法RLHF[1]的代替方法之一,其性能上超過(guò)其他現(xiàn)有的替代方案,媲美RLHF。實(shí)現(xiàn)較為簡(jiǎn)單,訓(xùn)練時(shí)對(duì)于硬件資源要求也相對(duì)較低。

論 文 內(nèi)容

動(dòng)機(jī)

圖1.不同人類偏好對(duì)齊算法的對(duì)比。(a)人類反饋的強(qiáng)化學(xué)習(xí)算法RLHF;(b)基于對(duì)比學(xué)習(xí)的偏好優(yōu)化方法DPO;(c)基于提示工程的HIR;(d) 基于表征工程的RAHF。

構(gòu)建類似ChatGPT生成式語(yǔ)言大模型一般要經(jīng)過(guò)語(yǔ)言模型、提令精調(diào)和強(qiáng)化學(xué)習(xí)三個(gè)主要訓(xùn)練步驟,其中第三步使用強(qiáng)化學(xué)習(xí)來(lái)實(shí)現(xiàn)人類期望對(duì)齊既有一定的技術(shù)難度,又需要多次人工標(biāo)注反饋,因而實(shí)現(xiàn)上有一定挑戰(zhàn)。經(jīng)過(guò)前兩步語(yǔ)言模型和提令精調(diào)之后,語(yǔ)言大模型仍然會(huì)生成帶有偏見、歧視或者令人不適的回答。為了提升大模型的安全性、可用性和可信性,與人類期望對(duì)齊是必不可少的步驟。然而目前研究表明利用人類反饋的強(qiáng)化學(xué)習(xí)算法[1](RLHF)存在訓(xùn)練不穩(wěn)定、對(duì)超參數(shù)敏感和訓(xùn)練代價(jià)較高等問(wèn)題。

針對(duì)基于強(qiáng)化學(xué)習(xí)的人類偏好對(duì)齊方法的上述不足,最近提出了一些替代的方法,相關(guān)實(shí)現(xiàn)思路和方法包括:

(1)借助對(duì)比學(xué)習(xí)的方法[2-4],代表性工作為DPO(Direct preference optimization)[2],即提高符合人類偏好回復(fù)生成概率的同時(shí),降低人類滿意度較低回復(fù)的生成概率;

(2)基于提示工程的方法[5-6],代表性工作為HIR(Hindsight instruction relabeling)[5],即根據(jù)與人類偏好相符程度,設(shè)計(jì)不同的提示。在推理時(shí)使用匹配人類偏好較高的提示,從而引出更好的回答。

雖然上述方法都是Reward-free的方法(即不需要訓(xùn)練獎(jiǎng)勵(lì)評(píng)估模型),但實(shí)驗(yàn)表明這些替代強(qiáng)化學(xué)習(xí)方法存在容易受到訓(xùn)練集中噪聲樣本的影響(比如:錯(cuò)誤標(biāo)注、Dull Sentences和較短回復(fù)等)。主要原因是它們都是采用在樣本上直接精調(diào)的方式實(shí)現(xiàn)與人類偏好對(duì)齊,因而易受樣本質(zhì)量的影響,而基于人類反饋的強(qiáng)化學(xué)習(xí)算法先訓(xùn)練評(píng)估模型,然后采用評(píng)估模型的評(píng)分來(lái)引導(dǎo)模型的訓(xùn)練過(guò)程。即使訓(xùn)練樣本存在的噪聲,也通過(guò)評(píng)估模型的“過(guò)濾”,對(duì)最終模型不會(huì)產(chǎn)生直接的影響。

方法

為了獲得輕量級(jí)、易實(shí)現(xiàn)和Reward-free的人類偏好對(duì)齊方法,同時(shí)也緩解最終模型受訓(xùn)練樣本中噪聲數(shù)據(jù)的不利影響。受到表征工程Representation Engineering)[7]方面最新進(jìn)展的啟發(fā),我們提出了RAHF(Representation Alignment from Human Feedback)方法。在神經(jīng)網(wǎng)絡(luò)中,網(wǎng)絡(luò)權(quán)重決定了隱層表征、隱層表征決定了網(wǎng)絡(luò)輸出、網(wǎng)絡(luò)輸出決定了網(wǎng)絡(luò)行為(如:安全、真實(shí)、偏見等方面)。我們通過(guò)首先發(fā)現(xiàn)模型在生成不同質(zhì)量回復(fù)時(shí)網(wǎng)絡(luò)隱層激發(fā)模式及差異,然后利用差異來(lái)對(duì)模型行為進(jìn)行調(diào)整和操控。具體方法包括以下三個(gè)主要步驟:

(1)使用帶偏好注釋的數(shù)據(jù)集來(lái)讓大型語(yǔ)言模型“感知”人類的偏好;

(2)收集模型在不同偏好“刺激”情況下的隱層激活模式;

(3)利用收集到的激活模式及差異來(lái)調(diào)整模型使其與與人類偏好對(duì)齊。

我們嘗試了兩種方法讓模型“感知”人類偏好:?jiǎn)我荒P停≧AHF-SCIT)和二元模型(RAHF-DualLLMs)。都取得了不錯(cuò)的結(jié)果,雖然二元模型RAHF-DualLLMs性能更佳,但單一模型RAHF-SCIT實(shí)現(xiàn)更為簡(jiǎn)單,對(duì)硬件資源的要求也更低。

結(jié)果

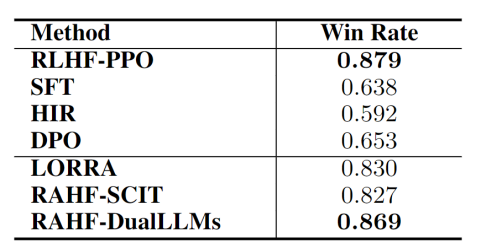

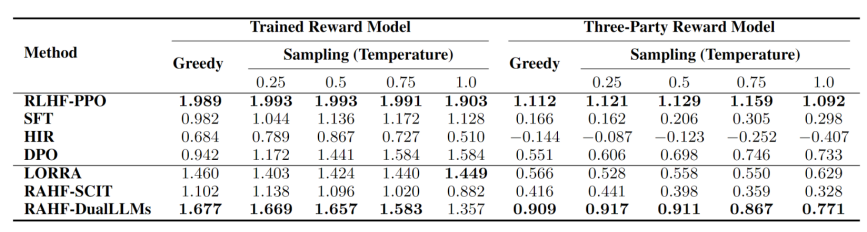

我們?cè)趯?duì)話任務(wù)上對(duì)進(jìn)行了對(duì)比實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果表明所提出的RAHF人類偏好對(duì)齊方法在各項(xiàng)指標(biāo)上都優(yōu)于其他非強(qiáng)化學(xué)習(xí)方法,并取得了與RLHF-PPO相媲美的結(jié)果。如表1所示,在Anthropic-HH數(shù)據(jù)集上相對(duì)于首選回復(fù)的勝率(結(jié)果使用GPT-4進(jìn)行評(píng)判),我們所提出的RAHF-DualLLMs超過(guò)了除RLHF-PPO之外的所有代替方法,并且與RLHF-PPO僅有0.01的差距。表2報(bào)告了在不同生成采樣溫度下,偏好注釋數(shù)據(jù)上我們自己所訓(xùn)練的獎(jiǎng)勵(lì)模型(Reward model)和第三方提供的獎(jiǎng)勵(lì)模型上的各方法的平均得分比較,這些數(shù)據(jù)也與表1的結(jié)果相吻合,并且表現(xiàn)出相似的趨勢(shì)。

表1. 在Anthropic-HH數(shù)據(jù)集上相對(duì)于首選回復(fù)的勝率(結(jié)果使用GPT-4進(jìn)行評(píng)判)。

表2. 在不同生成采樣溫度下,偏好注釋數(shù)據(jù)上所訓(xùn)練的獎(jiǎng)勵(lì)模型(Reward model)和第三方提供的獎(jiǎng)勵(lì)模型上的各方法的平均得分比較。

這項(xiàng)工作我們嘗試了一種受認(rèn)知神經(jīng)科學(xué)理論啟發(fā)的基于表征工程來(lái)實(shí)現(xiàn)生成式語(yǔ)言大模型與人類偏好對(duì)齊的策略,旨在提出一種輕量級(jí)和易實(shí)現(xiàn)的解決方案。目前仍然還有許多可改進(jìn)的空間,我們希望這項(xiàng)研究能夠有助于更可控人工智能技術(shù)的發(fā)展。

審核編輯:劉清

-

自然語(yǔ)言處理

+關(guān)注

關(guān)注

1文章

628瀏覽量

14065

原文標(biāo)題:基于表征工程的生成式語(yǔ)言大模型人類偏好對(duì)齊

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

【大語(yǔ)言模型:原理與工程實(shí)踐】探索《大語(yǔ)言模型原理與工程實(shí)踐》

【大語(yǔ)言模型:原理與工程實(shí)踐】揭開大語(yǔ)言模型的面紗

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的基礎(chǔ)技術(shù)

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的預(yù)訓(xùn)練

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的評(píng)測(cè)

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的應(yīng)用

大語(yǔ)言模型:原理與工程時(shí)間+小白初識(shí)大語(yǔ)言模型

大語(yǔ)言模型:原理與工程實(shí)踐+初識(shí)2

一種基于策略元素三元組的策略描述語(yǔ)言

一種基于域的遞增式策略部署模型

一種基于用戶偏好的權(quán)重搜索及告警選擇方法

LLMs實(shí)際上在假對(duì)齊!

大語(yǔ)言模型中的語(yǔ)言與知識(shí):一種神秘的分離現(xiàn)象

2024 年 19 種最佳大型語(yǔ)言模型

評(píng)論