Meta,這家社交媒體和科技巨頭,近日宣布推出一種新型的無監督視頻預測模型,名為“V-JEPA”。這一模型在視頻處理領域引起了廣泛關注,因為它通過抽象性預測生成視頻中缺失或模糊的部分來進行學習,提供了一種全新的視頻處理方法。

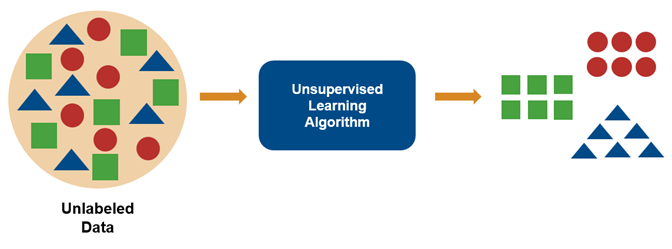

與傳統的生成模型不同,V-JEPA采用自監督學習的方式對特征預測目標進行訓練。這意味著它不需要大量的標注數據,而是能夠從無標簽的視頻中學習并預測未來的幀。這種能力使得V-JEPA在信息有限的情況下,仍然能夠理解和預測視頻中發生的事情。

與傳統的填充缺失像素的生成方法相比,V-JEPA的方法更為靈活和高效。據Meta表示,使用這種方法,訓練和樣本的效率可以提高6倍。這意味著在相同的計算資源下,V-JEPA可以更快地訓練,并且需要更少的樣本數據就能達到理想的預測效果。

這一突破性的模型不僅為視頻處理領域帶來了新的可能性,也為Meta在人工智能和機器學習領域的持續創新增添了新的動力。我們期待看到這一模型在實際應用中的表現,以及它將如何推動視頻處理技術的進步。

-

人工智能

+關注

關注

1806文章

48984瀏覽量

248921 -

Meta

+關注

關注

0文章

303瀏覽量

11842 -

預測模型

+關注

關注

0文章

27瀏覽量

8958

發布評論請先 登錄

無法在OVMS上運行來自Meta的大型語言模型 (LLM),為什么?

Meta組建四大專研小組,深入探索DeepSeek模型

Meta重磅發布Llama 3.3 70B:開源AI模型的新里程碑

評論