電子發燒友網報道(文/李彎彎)英偉達遇到勁敵了?近日,Groq芯片計算速度超過英偉達GPU的消息刷屏。Groq是一家成立于2016年的AI創企,該公司近日開放了自家產品的免費試用,相比其他AI聊天機器人,Groq閃電般的響應速度迅速引爆朋友圈,經網友測試,Groq每秒生成速度接近500 tok/s,碾壓GPT-4的40 tok/s。

而這樣的速度背后,源于Groq自研了一種名為張量流處理器(TSP)的新型處理單元,Groq將其命名為語言處理單元,即LPU,它的工作原理與GPU截然不同。

Groq芯片跑大模型的速度有多快

Groq芯片跑大模型最突出的特點,便是快。有網友震驚地說:“它回復的速度比我眨眼還快。”在傳統生成AI中,等待是很平常的事,經常是字符一個個往外蹦,回答完需要挺長時間。而有網友稱,在Groq近日開放的云服務體驗平臺上,你可以看到,當模型收到提示后,幾乎能夠立即生成答案。

電子郵件初創企業OthersideAI的首席執行官兼聯合創始人馬特·舒默在演示中親自體驗了Groq的強大功能。他稱贊Groq快如閃電,能夠在不到一秒鐘的時間內生成數百個單詞的事實性、引用性答案。更令人驚訝的是,它超過3/4的時間用于搜索信息,而生成答案的時間卻短到只有幾分之一秒。

需要說明的是,Groq并沒有研發新模型,它只是一個模型啟動器,主頁上運行的是開源模型Mixtral 8x7B-32k和Llama 270B-4k。而驅動模型的硬件便是Groq自研的一種名為張量流處理器(TSP)的新型處理單元,Groq將其命名為語言處理單元,即LPU(Language Processing Units),它的工作原理與GPU截然不同。

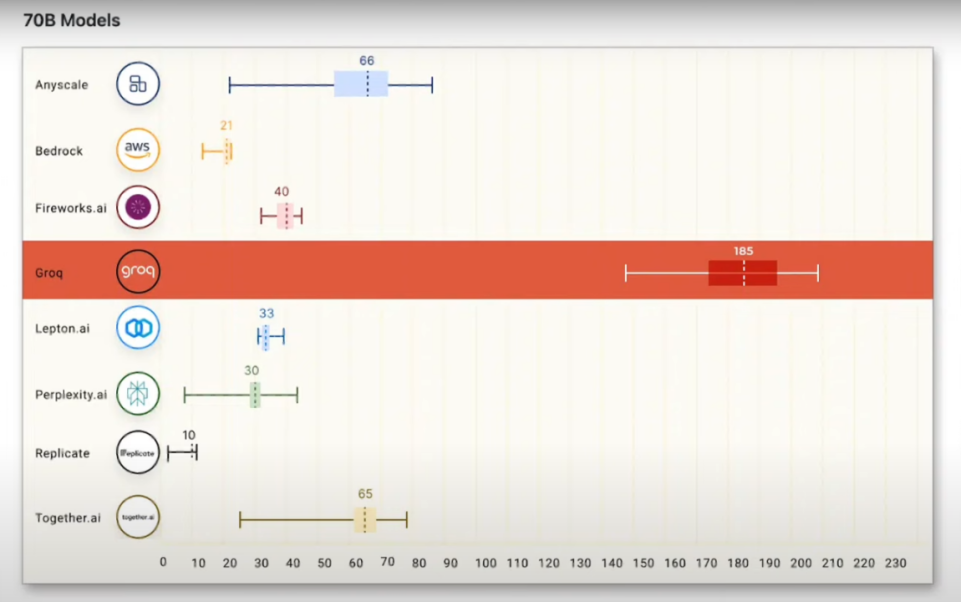

各種測試結果和網友的體驗,都顯示Groq LPU的計算速度相當快。根據2024年一月的測試結果,由Groq LPU驅動Meta Llama 2模型,推理性能遙遙領先,是頂級云計算供應商的18倍。有報道稱,Groq LPU搭配Meta Llama 2 70B能在7分鐘內就能生成與莎士比亞《哈姆雷特》相同數量的單詞,比普通人的打字速度快75倍。

有網友測試同時用Gemini、GPT-4和Groq完成一個代碼調試問題,結果,Groq的輸出速度比Gemini快10倍,比GPT-4快18倍。

有從事人工智能開發的用戶稱贊,Groq是追求低延遲產品的“游戲規則改變者”。有用戶認為,Groq的LPU可能成為英偉達A100和H100芯片的“高性能硬件”的有力替代品。不過,也有AI行業的專家表示,Groq的LPU從成本上來看并不具優勢,目前并不能代替英偉達。

Groq 開發的LPU與GPU有何不同

Groq開發的LPU到底是個怎樣的產品?據其官網介紹,LPU是一種專為AI推理所設計的芯片。驅動包括GPT等主流大模型的GPU,是一種為圖形渲染而設計的并行處理器,有數百個內核。而LPU架構則與GPU使用的SIMD(單指令,多數據)不同,這種設計可以讓芯片更有效地利用每個時鐘周期,確保一致的延遲和吞吐量,也降低了復雜調度硬件的需求。

Groq的LPU推理引擎不是普通的處理單元;它是一個端到端系統,專為需要大量計算和連續處理的應用(如LLM)提供最快的推理而設計。通過消除外部內存瓶頸,LPU推理引擎的性能比傳統GPU高出幾個數量級。

根據與Groq關系密切的投資人k_zeroS分享,LPU的工作原理與GPU截然不同。它采用了時序指令集計算機(TemporalInstructionSetComputer)架構,這意味著它無需像使用高帶寬存儲器(HBM)的GPU那樣頻繁地從內存中加載數據。這一特點不僅有助于避免HBM短缺的問題,還能有效降低成本。

Groq創始人兼首席執行官Jonathan Ross此前在接受采訪的時候就談到,在大模型推理場景,Groq LPU芯片的速度比英偉達GPU快10倍,但價格和耗電量都僅為后者的十分之一。

Ross認為,對于在產品中使用人工智能的公司來說,推理成本正在成為一個問題,因為隨著使用這些產品的客戶數量增加,運行模型的成本也在迅速增加。與英偉達GPU相比,Groq LPU集群將為大模型推理提供更高的吞吐量、更低的延遲和更低的成本。

他強調,由于技術路徑不同,Groq的LPU芯片不依賴于三星或SK海力士的HBM,也不依賴于臺積電將外部HBM焊接到芯片上的CoWoS封裝技術。它在供應方面比英偉達更充足,不會被臺積電或者SK海力士等供應商卡脖子。

可以看到,Groq LPU芯片相當于是去掉了HBM,而只是依靠SRAM來計算。雖然這樣計算速度確實相當驚艷,然而其更低成本的問題卻遭到質疑。

有AI專家表示,Groq芯片的實際成本并不低,如人工智能專家賈揚清分析稱,因為Groq小的可憐的內存容量(230MB),在運行Llama-270b模型時,需要305張Groq卡才足夠,而用H100則只需要8張卡。從目前的價格來看,這意味著在同等吞吐量下,Groq的硬件成本是H100的40倍,能耗成本是10倍。

當然也有SRAM行業的專家非常看好這種架構模式,他認為,賈揚清對Groq成本的估算不是很對,因為沒有考慮到Groq的per token cost明顯低于GPGPU。

可以看到,作為一種新的架構模式,Groq LPU當前必然還面臨一些潛在問題,然而它的出現,也讓人們看到GPU之外的可能路徑。

Groq LPU芯片未來能否肩負起運行大模型的重任,或許再等等,就能看到明確答案。事實上,在去年年底的采訪中,Ross就表示,考慮到GPU的短缺和高昂的成本,他相信Groq未來的發展潛力。他說到:“在未來12個月內,我們可以部署10萬個LPU,在24個月內,我們可以部署100萬個LPU。”

寫在最后

過去一年多時間,全球眾多科技公司都在研發大模型,今年將會是大模型落地部署的重要一年,而如眾多大模型的訓練和推理卻依賴英偉達的GPU。業界亟需除英偉達GPU之外的芯片,能夠用于大模型的部署推理,Groq的LPU芯片可以說是帶來了新的探索方向。

雖然Groq公司對自己的LPU芯片在性能和成本上都自信滿滿,然而業界對于其成本問題還是有所質疑。如果今年LPU芯片能夠如規劃那樣進行較大規模的部署,或許就能一定程度證明LPU芯片在成本上也在眾多用戶所能接受的范圍之內。

-

gpu

+關注

關注

28文章

4729瀏覽量

128890 -

英偉達

+關注

關注

22文章

3770瀏覽量

90984 -

Groq

+關注

關注

0文章

9瀏覽量

80

發布評論請先 登錄

相關推薦

挑戰英偉達:聚焦本土GPU領軍企業崛起

英偉達將全面轉向開源GPU內核模塊

英偉達GPU新品規劃與HBM市場展望

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

英偉達、AMD、英特爾GPU產品及優勢匯總

英偉達發布新一代AI芯片架構Blackwell GPU

英偉達擅用版權作品遭起訴 AI訓練數據和版權的矛盾凸顯

英偉達要小心了!爆火的Groq芯片能翻盤嗎?AI推理速度「吊打」英偉達?

刷屏的Groq芯片,速度遠超英偉達GPU!成本卻遭質疑

刷屏的Groq芯片,速度遠超英偉達GPU!成本卻遭質疑

評論