電子發燒友網報道(文/周凱揚)在Sora把AI生成領域的視線全部吸引過去的這段時間里,谷歌卻依然在竭盡全力推進新的生成模型發展。除了上周發布的下一代Gemini 1.5外,谷歌也在近日推出了一系列基于Gemini打造的開源模型Gemma。

谷歌加入AI模型開源陣營,Gemma橫空出世

根據谷歌的介紹,Gemma是由谷歌DeepMind以及其他團隊開發,由Gemini啟發并采用了相同的研究與技術的輕量級模型。與之一起發布的還有全新的響應式生成AI工具包,為利用Gemma創造更安全的AI應用提供關鍵工具和指導。

從參數大小上來看,Gemma分為20億參數(Gemma 2B)和70億(Gemma 7B)參數兩個版本,且每個版本又有基礎版(預訓練)和指令調整版兩個變體。其中70億參數的版本適合消費級的GPU和TPU開發,而20億參數的版本可以用于CPU和端側應用上。

在預訓練數據上,Gemma 2B和7B分別采用了2T和6T的Token進行訓練,數據來源是以英文為主的網絡文檔、數學計算和代碼。需要注意的是,盡管其背后所采用的技術與Gemini類似,但這些模型并不屬于多模態模型,也并不適合用于追求極致的多語言任務性能。

在訓練硬件上,谷歌采用了自研的TPUv5e,其中Gemma 7B用到了4096塊TPUv5e進行訓練,Gemma 2B用到了512塊TPUv5e進行訓練。

開源LLM混戰,Gemma 7B超越Llama-2 13B?

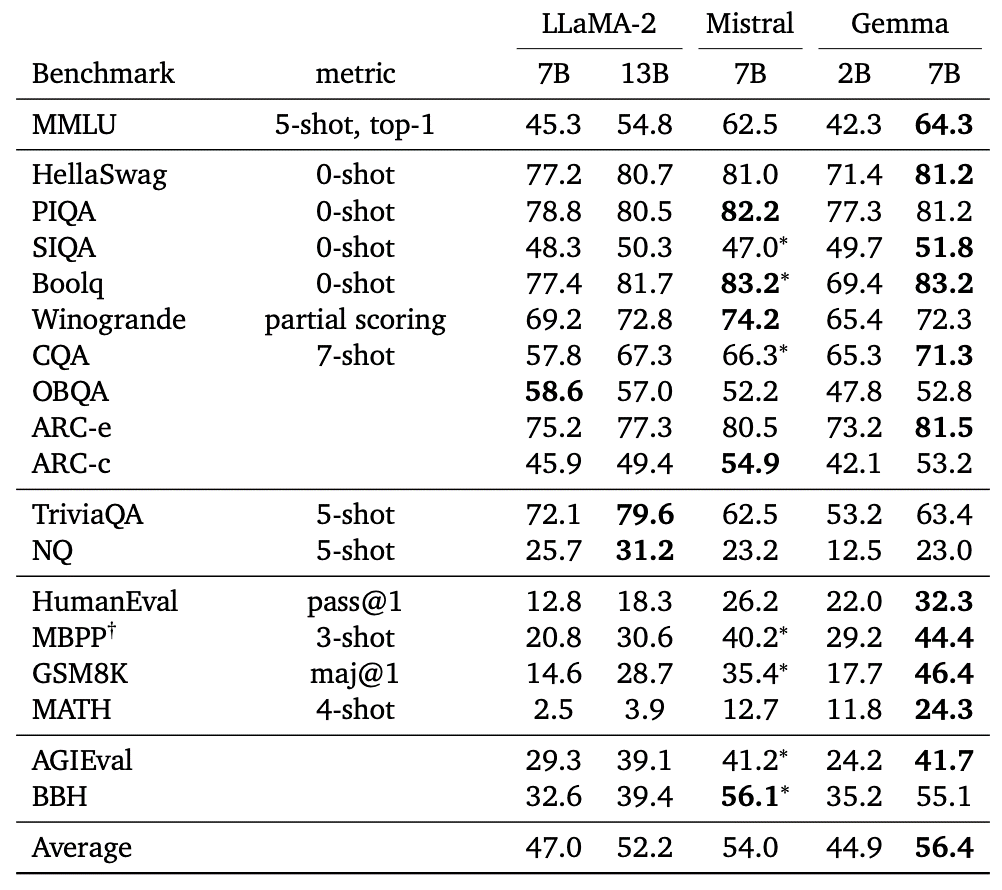

根據谷歌官方提供的數據,與Meta的Llama-2相比,Gemma 7B在多個項目上展現出了優勢,比如大規模多任務語言理解(MMLU)、GSM8K和Math計算和HumanEval Python代碼生成等應用上,都超過了Llama-2 7B,甚至不少超過了Llama-2 13B。

開源模型文本任務性能對比 / 谷歌

谷歌表示,與同等體量的開源模型對比,比如LLaMA-2和Mistral等,18項文字相關的任務中,Gemma能夠做到在11項任務中性能勝出,且平均性能得分占優。

不過Gemma也并不是完全超越了Llama-2,從Huggingface給出的平均得分來看,Gemma 7B超過了同級別的Llama 2 7B,但還是低于LLama 2 70B Chat,不過考慮到這兩者之間的參數差異,也印證了Gemma 7B的強大。至于Gemma 2B,與同規格的其他優秀開源LLM相比,比如PHI-2(2.7B),也不存在優勢。

作為一個輕量級的模型,Gemma也對跨設備兼容性做了優化,可以在筆記本、PC、IoT設備、智能手機和云端運行。谷歌也與英偉達達成合作,Gemma針對英偉達的GPU硬件進行了優化,無論是云端的AI GPU還是桌面端的RTX AI PC,都能享受Gemma帶來的性能。

寫在最后

盡管Gemma是谷歌首個大型的開源LLM,但這早已經不是谷歌對開源AI社區做出的首個貢獻了,諸如Transformers, TensorFlow, BERT, T5, JAX, AlphaFold和AlphaCode等,可以說當前AI能夠有如此繁榮的開發生態,谷歌做出了不少貢獻。無疑Gemma的出現,也會給AI開發生態帶來新的選擇。

-

谷歌

+關注

關注

27文章

6211瀏覽量

106490 -

AI

+關注

關注

87文章

32439瀏覽量

271626 -

算力

+關注

關注

1文章

1043瀏覽量

15101 -

大模型

+關注

關注

2文章

2781瀏覽量

3432

發布評論請先 登錄

相關推薦

無法在OVMS上運行來自Meta的大型語言模型 (LLM),為什么?

Meta重磅發布Llama 3.3 70B:開源AI模型的新里程碑

谷歌開源70億參數大語言模型,全方位超越Meta Llama-2?

谷歌開源70億參數大語言模型,全方位超越Meta Llama-2?

評論