前言: 人工智能推理的重要性日益凸顯,高效運行端側大模型及AI軟件背后的核心技術正是推理。不久的未來,全球芯片制造商的主要市場將全面轉向人工智能推理領域。

Groq LPU崛起,AI芯片主戰場轉向

與AI訓練相比,AI推理與用戶終端場景需求更為緊密,訓練后的大規模模型需通過AI推理實際應用到場景中。

然而,目前基于英偉達GPU的AI推理方案成本較高,性能和時延問題影響了用戶體驗。

在Groq LPU亮相之前,大型AI模型的訓練和推理均依賴于英偉達GPU,并采用CUDA軟件技術棧。

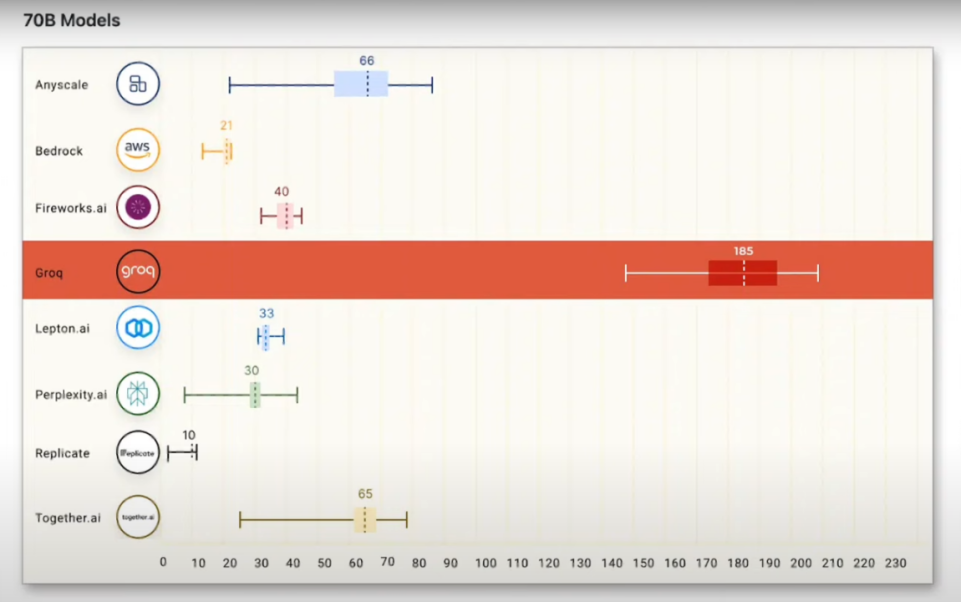

然而,Groq LPU的迅速崛起使市場開始猜測AI芯片的主戰場或將從訓練轉向推理。

Groq LPU推理卡從硬件層面解決了性能和成本問題,使AI推理大規模部署成為可能,推動更多AI推理類應用落地。

與此同時,AI推理需求的增長將進一步推動云端推理芯片的發展,尤其是更多可替代英偉達GPU的新一代專用推理芯片將應用于數據中心。

在推理階段,AI模型需以極致速度運行,旨在為終端用戶提供更多的Token,從而加快響應用戶指令的速度。

需求帶動,重心從訓練轉向推理

AI推理領域與大規模消費電子等應用終端需求緊密相關,因此,行業發展重心有望從[訓練]全面轉向[推理]。

相較于AI訓練,推理領域在[海量數據轟炸]應用背景下的GPU并行化算力需求遠低于訓練領域。

推理進程涉及已訓練模型的決策或識別,擅長處理復雜邏輯任務和控制流任務的以CPU為核心的中央處理器足以高效應對諸多推理場景。

當前,AI市場主要集中在使用大數據訓練大語言模型的[訓練]階段,英偉達成為這一領域的主要受益者。

然而,隨著AI大模型變得更精簡、可在設備上運行并專注于推理任務,芯片制造商的市場重心將轉向[推理],即模型應用。

展望產業發展趨勢,AI算力負載有望逐步從訓練向推理端遷移,從而降低AI芯片門檻。

覆蓋可穿戴設備、電動汽車及物聯網等領域的芯片公司有望全面滲透至AI推理芯片領域。

預計數據中心也將對專門用于已訓練模型推理任務的處理器產生興趣,共同推動推理市場規模超越訓練市場。

預計在一到兩年內,AI大模型在訓練端和推理端都將產生巨量的算力/AI芯片需求。

如果未來大模型廣泛商用落地,推理端的算力/AI芯片的需求量將明顯高于訓練端。

經過兩到三年的AI訓練用數據中心升級周期后,市場將看到更多來自推理芯片供應商的銷量。

AI推理漸多,企業與資本也向推理轉移

AMD CEO蘇姿豐認為:未來大模型推理市場的規模將遠遠大于模型訓練市場。

英特爾CEO基辛格表示:當推理發生時,就不存在CUDA依賴性了,并不是說英特爾不會在訓練領域展開競爭,而是從根本上說,推理市場才是競爭的焦點。

扎克伯格認為:很明顯,下一代服務需要構建全面的通用智能、構建最好的AI助手、為企業創造者以及更多要在AI各個領域取得進步——從推理到規劃到編碼到記憶和其他認知能力。

伴隨著企業AI應用逐步成熟,企業將把更多算力從模型訓練轉移到AI推理工作中。

在芯片需求方面,訓練芯片注重通用性,而推理芯片則與已訓練完成的大模型具有高度綁定性。

隨著大模型應用的不斷深化,推理需求也逐漸從云端遷移至邊緣/終端,并呈現出定制化的發展趨勢。

在全球AI芯片市場,先推理后訓練成為主流路徑,例如英特爾收購的AI芯片公司Habana以及我國諸多AI初創公司。

這一選擇背后,是下游市場的催化作用:隨著AI模型訓練逐漸成熟,AI應用逐步落地,云端推理市場已逐漸超過訓練市場。

人工智能計算資源正由訓練大規模AI模型逐步轉向推理,因此在客戶端、邊緣和云之間需要構建更為均衡的基礎設施。

據估計,全球已有超過18家致力于AI大模型訓練和推理的芯片設計初創公司,累計獲得超過60億美元融資,整體估值超過250億美元。

這些創業公司得到了諸如紅杉資本、OpenAI、五源資本、字節跳動等強大投資方的支持。

同時,微軟、英特爾、AMD等科技巨頭也在加大[造芯]力度,使得英偉達面臨前所未有的競爭壓力。

與英偉達競速,各企業從細分領域突破

為降低模型訓練與推理成本,業界持續探索實現高能效和高性能芯片架構的更多可能性。

觀察諸如Meta、亞馬遜、Alphabet等科技巨頭,它們均在研發自家的AI芯片。

這些芯片更具專業性和明確目標,相較之下,英偉達的芯片則具備更高的通用性。

①AMD:最新發布的MI300包括兩大系列,MI300X系列是一款大型GPU,擁有領先的生成式AI所需的內存帶寬和大語言模型所需的訓練和推理性能;

MI300A系列集成CPU+GPU,基于最新的CDNA3架構和Zen4 CPU,可以為HPC和AI工作負載提供突破性能。

去年12月,AMD在推出旗艦MI300X加速卡之外,還宣布Instinct MI300A APU已進入量產階段,預估今年開始交付,上市后有望成為世界上最快的HPC解決方案。

去年7月,英特爾公司在北京發布了一款針對中國市場、采用7納米工藝的AI芯片Habana Gaudi2,該芯片可運行大語言模型,加速AI訓練及推理。

其運行ResNet-50的每瓦性能約為英偉達A100的2倍,性價比相較于AWS云中基于英偉達的解決方案高出40%。

②英特爾:宣布與Arm公司合作,使其至強產品部署到Arm CPU上,并推出AI推理和部署運行工具套件OpenVINO。

此外,開源模型如LIama2陸續發布,促使更多企業直接使用這些模型,僅需AI推理芯片即可應用,從而減少了對算力訓練芯片的需求。

英特爾去年年底推出了新的計算機芯片,其中包括用于生成人工智能軟件的人工智能芯片Gaudi3。

Gaudi3將于今年推出,將與英偉達和AMD等競爭對手的芯片競爭,為大型且耗電的人工智能模型提供動力。

③Meta:計劃在今年投產自研芯片,降低AI加速卡采購成本,減少對英偉達的依賴。

該芯片功耗僅25瓦,為英偉達相同產品功耗的0.05%,并采用RISC-V開源架構。市場消息透露,該芯片由臺積電7納米工藝生產。

Meta近期宣布已構建自有DLRM推理芯片,并已廣泛部署。

這款ASIC內部被稱為[Artemis],主要性能集中在推理領域,基于去年宣布的第二代內部芯片產品線。

扎克伯格在視頻中透露了Meta人工智能計劃的更新路線圖:Meta將圍繞即將推出的Llama3構建全新的Meta AI路線圖,目前正在推進Llama3的AI訓練。

Llama3將與Google最近發布的Gemini模型、OpenAI的GPT-4,以及即將推出的GPT-5模型競爭。

④英偉達:去年8月,英偉達宣布推出新一代GH200 Grace Hopper超級芯片,新芯片將于今年第二季投產。

GH200和GH200NVL將采用基于Arm的CPU和Hopper解決大型語言模型的訓練和推理問題。

英偉達計劃基于x86架構推出B100替代H200,并基于ARM架構的推理芯片GB200替代GH200。

此外,英偉達還規劃了B40產品來替代L40S,以提供更好的面向企業客戶的AI推理解決方案。

根據英偉達計劃于今年發布Blackwell架構,采用該架構的B100 GPU芯片預計將大幅提高處理能力。

初步評估數據表明,與現有采用Hopper架構的H200系列相比,性能提升超過100%。

⑤亞馬遜:去年初,AWS發布專為人工智能打造的Inferentia2(Inf2),計算性能提高三倍,加速器總內存提高25%,支持分布式推理。

通過芯片之間的直接超高速連接,Inf2支持分布式推理,可以處理多達1750億個參數,使其成為當今人工智能芯片市場上最強大的內部制造商。

單點突破有收獲,國產有望追平

與此同時,我國華為、天數智芯等AI芯片制造商也在積極布局大模型訓練推理及AI算力產品。

當前,我國廠商如寒武紀、燧原、昆侖芯等的產品已具備與市場主流的Tesla T4正面競爭的實力:其能效比為1.71TOPS/W,與T4的1.86TOPS/W差距微小。

選擇GPGPU的登臨科技、天數智芯、燧原科技已實現訓練與推理的全面覆蓋,而ASIC類芯片如平頭哥,則需專注于推理或訓練場景。

①億鑄科技:基于CIM框架、RRAM存儲介質的研發的[全數字存算一體]大算力芯片,通過降低數據搬運提高運算能效比,同時借助數字存算一體方法確保運算精度,適用于云端AI推理和邊緣計算。

②寒武紀:思元370作為寒武紀第三代云端產品,運用7納米制程工藝,成為我國首款采用Chiplet技術的AI芯片,其最大算力可達256TOPS(INT8)。

寒武紀主要采用ASIC架構,雖通用性較差,但在特定應用場景下,其算力可超越GPU。

有測試結果顯示,590性能接近A100的90%性能;590基本支持主流模型,綜合性能接近A100的80%水平。

此外,思元370也是寒武紀首款采用Chiplet技術的AI芯片,集成了390億個晶體管,最大算力高達256TOPS(INT8)。

③平頭哥:去年8月,平頭哥發布首個自研RISC-V AI平臺,支持運行170余個主流AI模型,推動RISC-V進入高性能AI應用時代。

同時,平頭哥宣布玄鐵處理器C920全新升級,C920執行GEMM計算較Vector方案可提速15倍。

④壁仞科技:其BR100系列基于自主原創的芯片架構開發,采用成熟的7納米工藝制程,集成770億晶體管,16位浮點算力達到1000T以上、8位定點算力達到2000T以上,單芯片峰值算力達到PFLOPS級別。

同時,BR100結合了包括Chiplet等在內的多項業內前沿芯片設計、制造與封裝技術,具有高算力、高能效、高通用性等優勢。

⑤燧原科技:成立5年多來,已建成云端訓練和云端推理兩條產品線,并開發出云燧T10、云燧T20/T21訓練產品以及云燧i10、云燧i20等推理產品。

據媒體報道,燧原科技第三代AI芯片產品將于今年初上市。

⑥華為:昇騰310是面向推理和邊緣計算場景的低功耗芯片,是國內面向邊緣計算場景最強算力的AI SoC。

昇騰310芯片可以實現高達16Tops的現場算力,支持同時識別包括車、人、障礙物、交通標志在內的200個不同的物體;一秒鐘內可處理上千張圖片。

華為昇騰系列AI芯片具備一項獨特優勢,即采用了華為自主研發的統一且可擴展的架構。

這一架構實現了從極低功耗到極高算力場景的全覆蓋,使得一次開發即可適用于所有場景的部署、遷移及協同,從而顯著提升了軟件開發效率。

結尾:

隨著大模型在各類場景中的應用日益廣泛,推理環節的重要性日益凸顯。

因此,我們需要關注推理芯片的計算需求和系統配置,以降低成本、提升易用性,進而促進大模型在各個領域的迅速普及。

審核編輯:劉清

-

人工智能

+關注

關注

1791文章

47183瀏覽量

238244 -

中央處理器

+關注

關注

1文章

124瀏覽量

16518 -

AI芯片

+關注

關注

17文章

1879瀏覽量

34990 -

OpenAI

+關注

關注

9文章

1079瀏覽量

6481 -

大模型

+關注

關注

2文章

2423瀏覽量

2640

原文標題:深度丨AI芯片主戰場:從訓練轉向推理?

文章出處:【微信號:World_2078,微信公眾號:AI芯天下】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

刷屏的Groq芯片,速度遠超英偉達GPU!成本卻遭質疑

亞馬遜轉向Trainium芯片,全力投入AI模型訓練

深度學習工作負載中GPU與LPU的主要差異

NVIDIA助力麗蟾科技打造AI訓練與推理加速解決方案

沙特阿美攜手Groq打造全球最大推理數據中心

AMD助力HyperAccel開發全新AI推理服務器

蘋果承認使用谷歌芯片來訓練AI

AI推理,和訓練有什么不同?

開發者手機 AI - 目標識別 demo

英偉達要小心了!爆火的Groq芯片能翻盤嗎?AI推理速度「吊打」英偉達?

Groq LPU崛起,AI芯片主戰場從訓練轉向推理

Groq LPU崛起,AI芯片主戰場從訓練轉向推理

評論