作者:文永明,李博研,張寧寧,李小建,熊楚依,劉潔璽

采用深度強化學習算法解決了多智能體編隊協同控制問題。基于多智能體深度確定性策略梯度算法(MADDPG)構建分布式編隊控制架構,并結合集中式訓練-分布式執行框架進行求解。針對多智能體環境不穩定問題,依據單個智能體的局部信息構建對應獎勵函數。針對大規模編隊協同控制,實現了多個多智能體環境下的算法訓練與評估。試驗結果表明,應用該算法的多智能體能夠完成協同任務,且所有智能體都可得到合理的協同控制策略。

0引言

多智能體系統(MAS)由若干單獨控制的、通過無線網絡連接的智能體構成,在諸如控制、編隊、分配、博弈和分布式估計等問題中廣泛研究并取得了一定進展。在已知系統動力學模型基礎上,研究者們對多智能體系統基礎理論開展了大量研究。傳統的系統識別試驗依據輸入-輸出數據確定分析模型,但在實際應用中,復雜過程建模困難且昂貴。此外,傳統的控制方法在與復雜環境交互時存在局限性,固定策略不能應用于不同環境或任務場景中。深度強化學習關注一個智能體的策略模型,借鑒了不完全可知馬爾可夫決策中的最優控制思想,智能體通過與環境交互來最大化長期累積獎勵,控制優化與策略學習之間存在著緊密聯系。因此,深度強化學習技術在系統控制方面存在廣闊的應用前景。 深度強化學習算法分為基于值的強化學習算法和基于策略的強化學習算法2類。

1) Q學習及深度Q學習算法是最常用且直接的基于值的算法,它通過動作值函數來獲得最優策略。通過每個智能體學習一個獨立的最優方程,將基于值的算法直接應用于多智能體系統。然而,在學習過程中鄰居智能體更新時,當前智能體的獎勵和狀態轉移等信息也會發生改變。在這種情況下,環境就會出現不穩定性問題,并且也不再滿足馬爾可夫性,最終導致基于值的算法的收斂性得不到保證。

2) 基于策略的算法是另一類深度強化學習算法,該類算法通過獨立的神經網絡來近似隨機策略。執行者-評估者 (Actor-Critic, AC) 算法結合了基于值和基于策略的算法,其中執行者代表生成動作的策略函數,評估者代表評價動作獎勵的值逼近器。深度確定性策略梯度算法(DDPG)是一種無模型的AC算法,它結合了確定性策略梯度和深度Q學習算法,其中執行者和評估者均用深度神經網絡進行逼近。多智能體深度確定性策略梯度方法(MADDPG)將DDPG擴展到一個多智能體協同完成的任務環境,在這個環境中智能體智能獲得局部信息。MADDPG是一個針對多智能體場景重新設計的AC模型,旨在解決不斷變化的環境和多智能體間的復雜問題。

1理論基礎

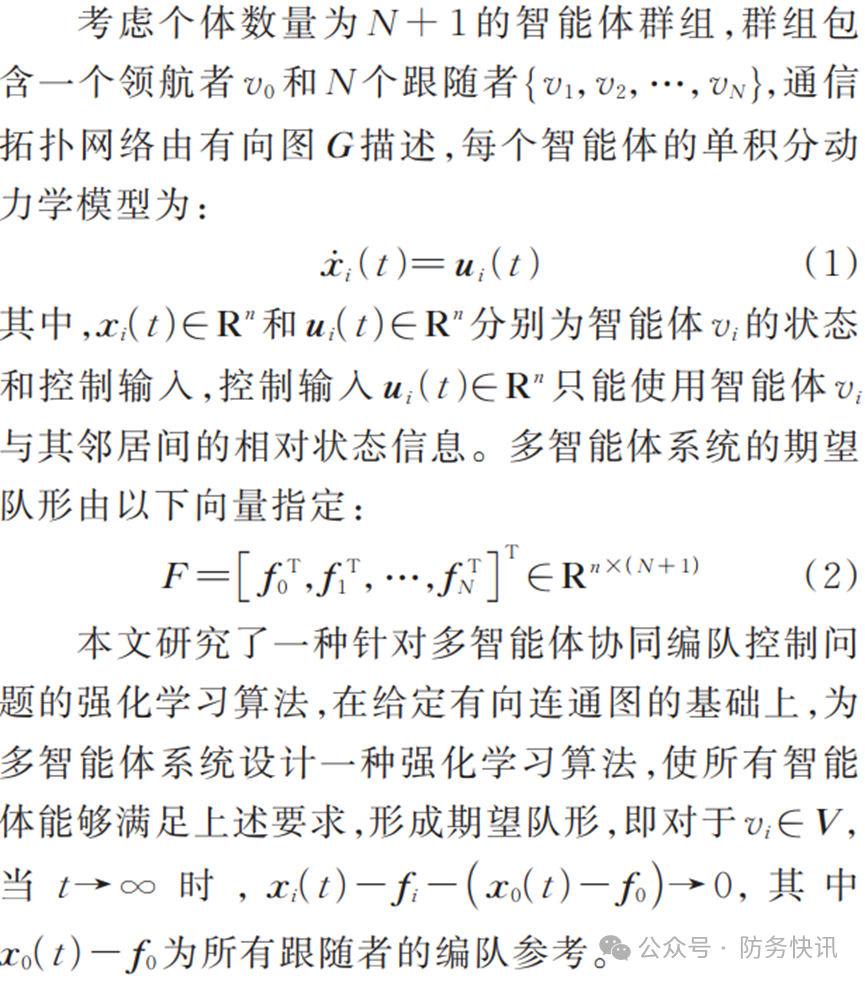

1.1 代數圖論

1.2 問題描述

2基于MADDPG迭代的編隊協同控制框架

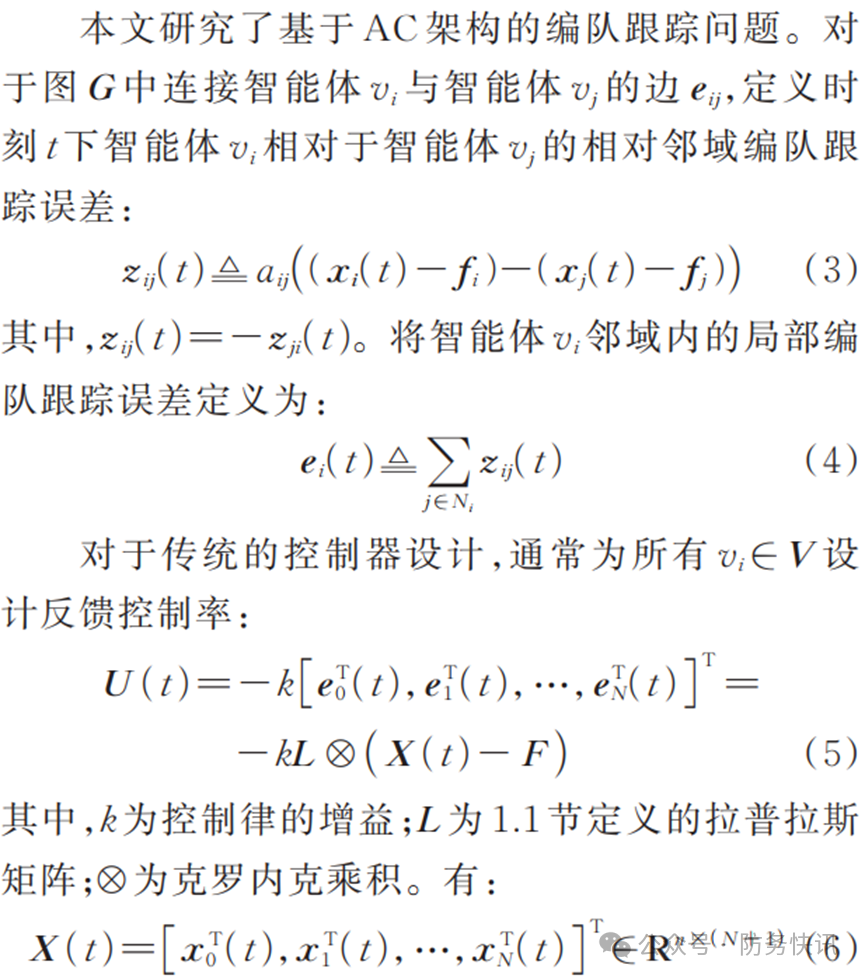

2.1 傳統控制設計

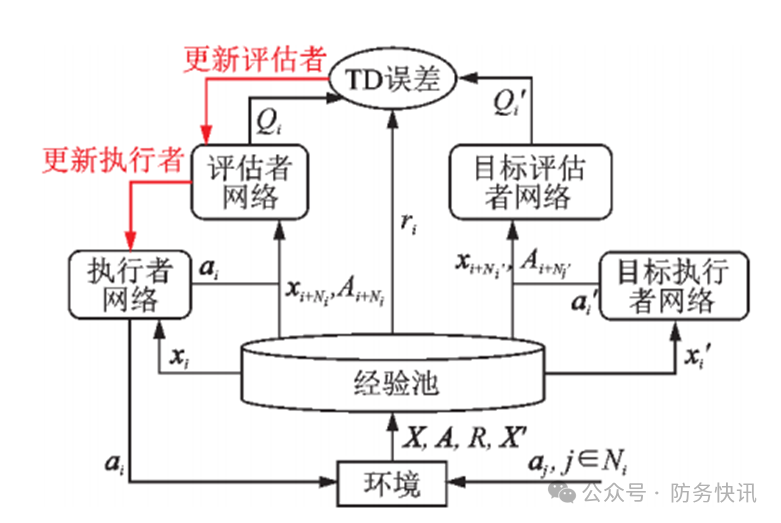

2.2 編隊協同控制算法框架設計

圖1 編隊控制算法框架

2.3 學習目標設計

2.4 編隊協同控制算法流程

3試驗結果與分析

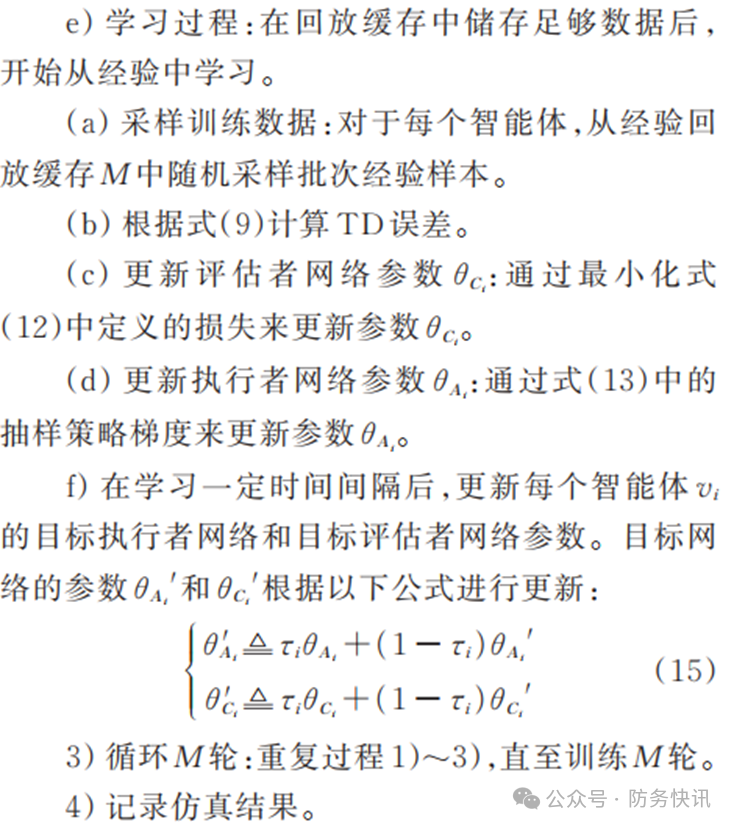

3.1 試驗設置

圖2 試驗交互拓撲圖

3.2 結果與分析

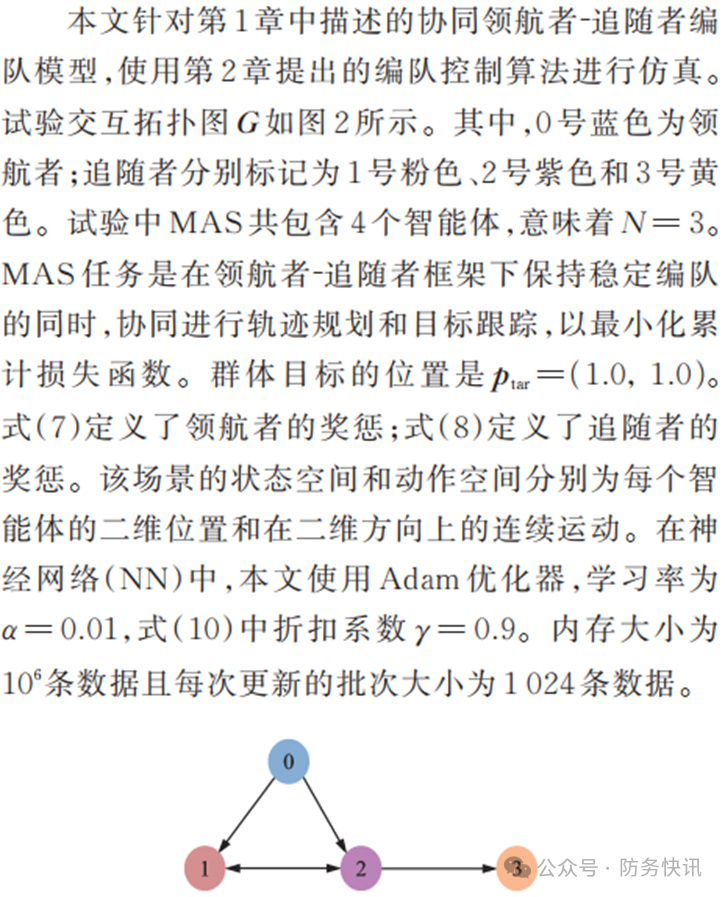

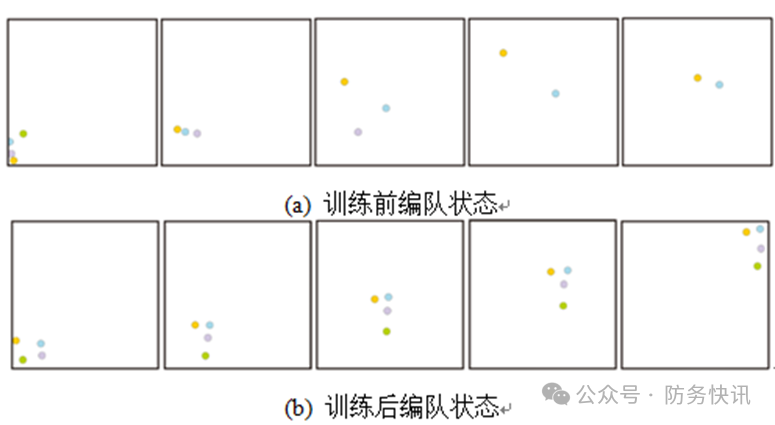

本文在3.1節展示的環境中運行并評估本文算法,仿真結果如圖3所示,圖4給出了智能體訓練前后運動軌跡對比。 4個智能體的長期累計獎勵得分如圖3(a)所示。在學習過程中得分是逐漸增加的,并且在50?000次迭代后收斂到6以內,這意味著MAS在50?000次迭代后可以有效消除初始誤差;同時,這個得分也意味著MAS實現理想編隊和到達目標位置所需的代價。圖3(b)是智能體最后50次訓練收斂時的穩定獎勵。由圖可見,4個智能體可以快速實現穩定編隊,且跟蹤誤差同樣意味著獎懲可以在1?s內收斂至接近于0。 4個智能體在訓練前后的初始、1?s、2?s、3?s和4?s編隊狀態如圖4所示。圖中藍色點為領航者,對應圖2中0號藍色點,粉色、灰色和綠色點分別對應圖2中1號粉色點、2號紫色點和3號橙色點。試驗結果表明,由于缺乏環境的先驗知識,MAS在首次嘗試時會偏離隊形。當智能體通過在環境中反復試錯積累經驗,MAS會收斂形成一個穩定的編隊。最終,領航者可以到達目標位置且追隨者可以與領航者保持編隊位置穩定。

圖 3 試驗環境下仿真結果

圖 4 智能體訓練前后狀態對比

4結束語

本文采用多智能體策略梯度算法,結合集中訓練和分布執行的框架,研究并求解多智能體協同編隊控制問題,設計構建了一種基于多智能體深度確定性策略梯度算法的分布式編隊控制框架,并給出了算法的訓練流程。通過對多智能體合作環境的仿真訓練與評估,驗證了本文算法的有效性。試驗結果表明,本文算法能夠使智能體在動力學模型先驗知識未知的情況下協同完成任務,有助于解決數學模型過于復雜而難以識別的控制問題。

審核編輯:黃飛

-

神經網絡

+關注

關注

42文章

4793瀏覽量

102051 -

算法

+關注

關注

23文章

4675瀏覽量

94205 -

無線網絡

+關注

關注

6文章

1457瀏覽量

66484 -

深度學習

+關注

關注

73文章

5540瀏覽量

122219

原文標題:基于深度強化學習的多智能體編隊協同控制

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【飛控開發高級篇7】瘋殼·開源編隊無人機-編隊飛行

【飛控開發高級教程7】瘋殼·開源編隊無人機-編隊飛行

【瘋殼·無人機教程29】開源編隊無人機-編隊飛行

基于二層鄰居信息的多智能體系統編隊控制

基于迭代填充的內存計算框架分區映射算法

多無人機協同編隊飛行控制的關鍵技術和發展展望

評論