人工智能(AI)領(lǐng)域中的大模型(Large Model)逐漸成為研究的熱點。大模型,顧名思義,是指擁有海量參數(shù)和高度復(fù)雜結(jié)構(gòu)的深度學(xué)習(xí)模型。它的出現(xiàn),不僅推動了AI技術(shù)的突破,更為各行各業(yè)帶來了革命性的變化。

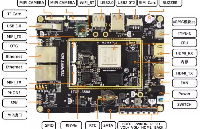

RK3588是瑞芯微推出的新一代旗艦級高端處理器,采用8nm工藝設(shè)計,搭載四核A76+四核A55的八核CPU和Arm高性能GPU,內(nèi)置6T算力的NPU。能夠高效地處理AI算法和模型,為大模型的運行提供了強大的硬件支持。

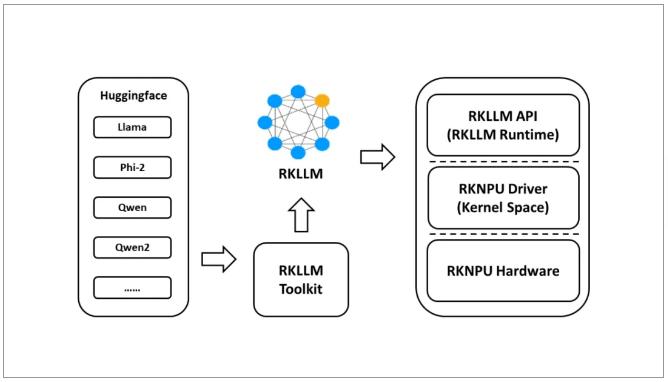

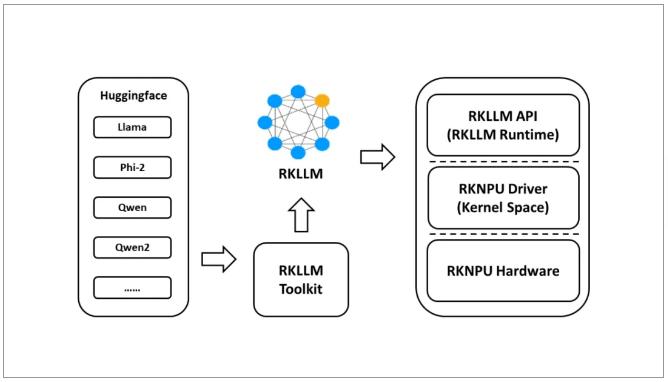

在北京迅為推出的搭載了RK3588處理器的iTOP-RK3588開發(fā)板上,使用RKLLM 工具套件支持在iTOP-RK3588平臺上進行LLM(大型語言模型)模型的轉(zhuǎn)換和部署。它與Hugging Face模型架構(gòu)兼容(Hugging Face是廣泛用于自然語言處理任務(wù)的模型架構(gòu)。目前,該系統(tǒng)支持以下模型:LLaMA、Qwen、Qwen2和Phi-2。支持量化技術(shù),即使用w8a8(8位權(quán)重,8位激活)和w4a16(4位權(quán)重,16位激活)精度進行模型量化。這可以在目標(biāo)平臺上更高效地存儲和計算模型,減小內(nèi)存占用。

iTOP-RK3588開發(fā)板體驗大模型

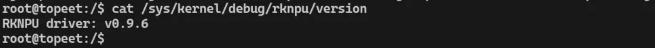

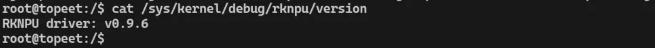

為了讓用戶更快速的體驗RKLLM ,北京迅為已經(jīng)對Linux內(nèi)核源碼中的NPU版本進行了升級,升級到了最新的0.9.6版本,具體如下所示:

默認以將RKLLM動態(tài)庫集成在了Ubuntu和Debian系統(tǒng)中,用戶可以直接拷貝轉(zhuǎn)換完成的RKLLM大預(yù)言模型和推理程序進行測試。詳細說明請見NPU手冊中RKLLM模型轉(zhuǎn)換和測試相關(guān)步驟。

《iTOP-RK3588開發(fā)板NPU使用手冊》v1.1教程目錄

第1章 你好!NPU

1.1 NPU的誕生!

1.2 初識RKNPU

第2章 準(zhǔn)備RKNPU開發(fā)環(huán)境

2.1 開發(fā)環(huán)境

2.1 軟件架構(gòu)

2.2 SDK說明

第3章 讓NPU跑起來

3.1 在Linux系統(tǒng)中使用NPU

3.1.1 設(shè)置交叉編譯器

3.1.2 修改編譯工具路徑

3.1.3 更新RKNN模型

3.1.4 編譯demo

3.1.5 開發(fā)板運行demo

3.2 在Android系統(tǒng)中使用NPU

3.2.1下載編譯所需工具

3.2.2 修改編譯工具路徑

3.2.3 更新RKNN模型

3.2.4 編譯demo

3.2.5 開發(fā)板運行demo

第4章 體驗RKNN_DEMO

4.1 rknn_ssd_demo體驗

4.2 rkn_api_demo體驗

4.3 rknn_multiple_input_demo體驗

第5章 模型轉(zhuǎn)換

5.1 RKNN-Toolkit2 介紹

5.2 RKNN-Toolkit2環(huán)境搭建

5.2.1 安裝Miniconda

5.2.2 創(chuàng)建RKNN虛擬環(huán)境

5.2.3 安裝pycharm

5.2.4 配置pycharm

5.3 RKNN-Toolkit2工具的使用

5.3.1 模型運行在模擬器

5.3.2 模型運行在RK3588開發(fā)板

第6章 其他模型轉(zhuǎn)換

6.1 使用tensorflow框架

6.2 使用caffe框架

6.3 使用tflite框架

6.4 使用onnx框架

6.5 使用darknet框架

6.6 使用pytorch框架

第 7章 使用RKNN-Toolkit-lite2

7.1 主要功能說明

7.2 環(huán)境搭建步驟

7.2.1 安裝Miniconda

7.2.2 創(chuàng)建RKNN虛擬環(huán)境

7.2.3 安裝RKNN-ToolkitLite 2軟件包

7.2.4 安裝opencv

7.3 運行測試程序

第8章 RKLLM大預(yù)言模型測試

8.1 RKLLM-Toolkit介紹

8.2 RKLLM-Toolkit環(huán)境搭建

8.2.1 安裝Miniconda

8.2.2 創(chuàng)建RKLLM虛擬環(huán)境

8.3 大語言模型轉(zhuǎn)換

8.4 推理程序編譯

8.5 開發(fā)板運行測試

-

測試

+關(guān)注

關(guān)注

8文章

5687瀏覽量

128784 -

人工智能

+關(guān)注

關(guān)注

1806文章

48987瀏覽量

249134 -

RK3588

+關(guān)注

關(guān)注

7文章

418瀏覽量

5876

發(fā)布評論請先 登錄

技術(shù)分享|iTOP-RK3588開發(fā)板Ubuntu20系統(tǒng)旋轉(zhuǎn)屏幕方案

評論