電子發燒友網報道(文/黃山明)現如今,不少終端產品中都安裝了AI程序,不過這些AI程序基本上都需要通過互聯網訪問云端AI服務,來實現各種智能化功能,例如語音識別、圖像識別、自然語言處理等。這種模式下,用戶的終端設備并不需要強大的本地AI處理能力,而是將數據上傳至云端服務器,在那里由大型AI模型進行復雜的計算處理,并將結果返回給用戶。

但隨著人們需求提升,尤其是對設備的響應速度與穩定性,還有個性化服務需求的增加,本地AI可以根據用戶的特定習慣和偏好進行優化,使得體驗更為個性化和無縫。

更重要的一點是,本地處理用戶數據可以減少數據泄露的風險,因為數據不需要被發送到云端服務器,這在一定程度上增強了用戶對隱私的保護。并且在沒有互聯網連接的情況下,本地AI仍然可以正常運作,而依賴云端的智能家居設備可能會失去部分或全部功能。

高通的現任CEO安蒙曾公開表示,“真正有趣的地方在于讓生成式AI在智能手機本地運行,而不是云端”,安蒙認為“生成式AI的變革意義在于終端上的信息能夠幫助AI成為無處不在的個人助手”。

當然,部署本地AI除了上述的原因外,網絡通暢性也至關重要。雖然如今5G已基本完成覆蓋,但完全跟不上AI的發展速度。數據顯示,一家波音787每秒產生5GB的數據,而全球每時每刻都有數千駕飛機正在空中飛行,高通發布的《混合AI是AI的未來》中顯示,相比傳統方式,生成式AI的搜索成本增加了10倍,全球每天產生超過100億次的搜索查詢量。

隨著邊緣計算技術的進步,越來越多的智能設備具備了一定程度的本地AI計算能力,能夠在離數據源頭更近的地方進行預處理或初步決策,減輕云端壓力的同時也提高了效率。

不僅是高通,包括英偉達、AMD、英特爾等企業都認為,本地AI計算、AI應用本地化將會是未來主要發展方向之一。

本地AI面臨的難題

想要在本地部署AI,讓設備可以離線運行,就需要確保終端設備具備足夠的計算能力,如CPU、GPU或TPU,以保證在有限的空間和功耗預算內完成實時推理。另一方面,AI模型往往體積龐大,尤其是在深度學習領域。要在本地部署,必須優化模型大小,使其適合小型化的智能家居設備有限的內存和存儲資源。

為了適應硬件限制,需對AI模型進行剪枝、量化或知識蒸餾等操作,以降低計算復雜度和資源占用。同時開發節能型AI算法和硬件架構,確保在提供智能服務的同時不影響設備整體的能源效率。

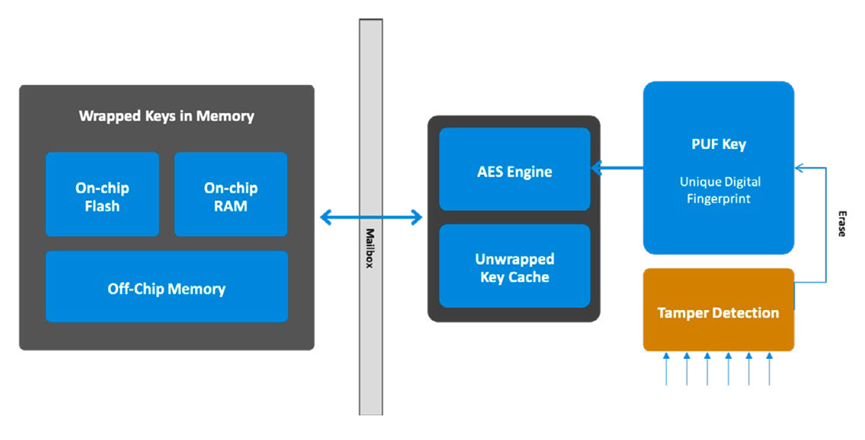

在數據處理與隱私保護上,需要確保本地存儲和處理的數據受到充分的安全保護,防止未經授權的訪問和泄露。還要確保AI算法能在特定的嵌入式操作系統上穩定運行,并適配各類傳感器及設備接口驅動。

不過即使在本地處理,也需要與云端及其他智能家居設備之間保持良好互聯,以便在必要時進行數據交換和協同工作。

體驗上,本地AI需要提供與云端相似的用戶體驗,包括快速響應用戶命令并做出準確判斷。設計合理的故障檢測和恢復機制,并能方便地進行遠程或本地固件更新,包括AI模型的迭代升級。

因此,在目前來看,普通個人用戶想要在本土部署大模型AI的門檻較高,一個是普通用戶在技術能力上無法完成本體部署,另一方面,AI技術比如AI生圖等功能對性能要求較高,普通的芯片難以應付,而專用芯片價格又比較昂貴。

同時,不管是什么類型的AI應用,算力都是繞不開的話題,如何做到快速響應、低延遲等特點,就需要有強力的本地AI算力支持。針對那些大型的家電設備而言可能還好,但對于一些小型的智能家居產品,如智能助手、智能中控屏等,在追求更強AI算力的同時,還需要平衡好功耗,降低對內存帶寬、顯存的高依賴。

當然,阻礙本土AI應用發展的最大難題,或許不在技術層面,而在于商業運作上,如何實現有效的盈利模式,讓企業有動力去推進本地AI。

小結

盡管云端AI服務廣泛應用,但在特定需求和環境下,本地AI仍然具有不可替代的價值。現代智能設備通常采用混合策略,即根據應用場景靈活利用云端和本地AI資源。而本地AI的部署,也將是主流AI芯片企業未來的重要發展方向。

-

AI

+關注

關注

87文章

30728瀏覽量

268886 -

智能家居

+關注

關注

1928文章

9553瀏覽量

184936

發布評論請先 登錄

相關推薦

傳感器類型在智能家居中的應用

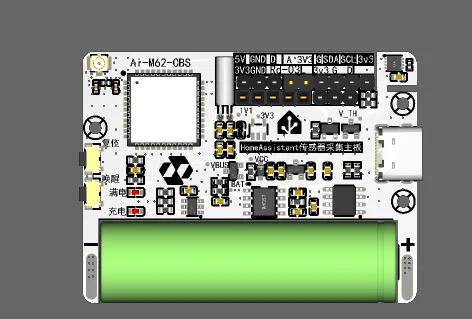

智能家居之旅(15):HA傳感器采集主板低功耗設計的遭遇

有了云端,智能家居還有必要部署本地AI嗎?

有了云端,智能家居還有必要部署本地AI嗎?

評論