電子發燒友網報道(文/周凱揚)云服務廠商以及數據中心供應商正在以一種前所未有的速度打造AI系統,對于他們來說消費級AI用例的增加,驅使AI加速器成了新時代下最重要的硬件基礎設施資源之一。但在打造這些系統之時,他們也在斟酌不同方案的選取。

英偉達的專有AI生態

作為目前不折不扣的AI芯片王者,可以說英偉達提供了一套完整的AI基礎設施方案,基礎算力以GPU為核心,輔以Arm CPU,結合專有的CUDA軟件生態,加上Infiniband網絡和NVLink的互聯方案。對于客戶而言,他們完全可以直接選擇英偉達的打包方案,就能直接開始構建高性能AI應用。

計算層面上,GPU依然是目前最萬用的AI算力硬件,英偉達在架構上的創新顯著提高了新一代Blackwell GPU的算力,尤其是在生成式AI應用上。結合大容量的HBM,無論是計算還是帶寬,都是目前AI硬件的領頭羊。云服務廠商和不少構建大型AI應用的公司,仍在大量購置英偉達GPU或基于該硬件生態的服務器。

同樣不可忽視的還有CUDA這一護城河生態,即便作為封閉的專有軟件棧生態,CUDA依然憑借龐大的開發者社區和應用站在了頂點。比起芯片設計的技術優勢,這一生態才是絕大多數AI芯片廠商難以企及的優勢。

博通的開放之路

但也有的廠商憑借別的路線實現了成功,比如博通提供的“開放”標準。在大多數人看來,博通是一家網絡與通信巨頭,為客戶提供開放的以太網連接方案、PCIe互聯方案以及共封裝光學方案等。然而事實上,博通也有營收相當可觀的定制芯片設計業務。通過給云服務廠商提供芯片設計服務,這些客戶得以推出基于自研計算架構的AI加速計算芯片,同時具備較快的迭代速度。

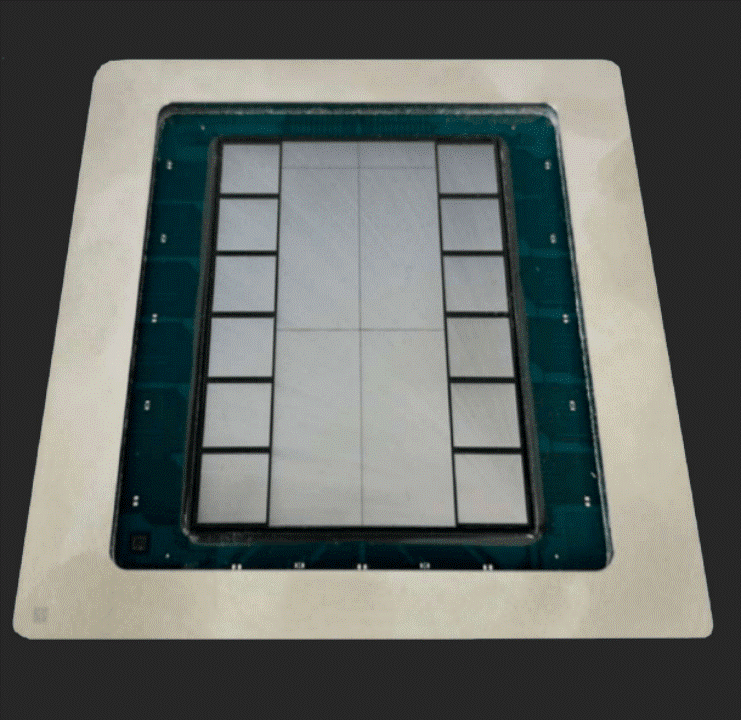

博通XPU芯片 / 博通

博通在不久前舉辦的AI投資者大會上展示了他們參與設計的新款XPU芯片,從圖中可以看出,除了中間兩個大大的計算單元外,左右兩邊都是HBM內存,一共有12塊,這已經到了目前臺積電CoWoS-S封裝的極限,容量可能超過英偉達的Blackwell,由此可以看出,使用該芯片的廠商追求極高的AI性能,很有可能是微軟、Meta之類的大型云服務廠商。

據預測,2024博通半導體業務中,來自AI的營收將達到35%,其中不僅包含兩大客戶的定制ASIC方案量產,也包含新的第三大客戶今年相關產品量產。需求推動之下,AI芯片的營收目標將達到100億美元。

不難猜出,其中一大客戶就是谷歌,他們與博通聯合打造的XPU就是已經發展至第五代的TPU芯片。至于新加入的客戶,據透露其第三個XPU設計來自另一家大型消費級AI公司。之所以這些客戶會選擇與博通合作設計XPU,除了博通擁有的豐富AI IP/封裝技術外,也離不開極短的開發周期。從設計開發到量產,最短只要10個月的時間。

寫在最后

無論是英偉達的GPU路線,還是博通的XPU路線,都為市場提供了更多的選擇。而且對于大型云服務廠商而言,他們會同時走這兩條路線,為客戶提供不同的服務器實例,而自己除了云服務之外的業務上,未來會更加依賴自研的XPU路線。

-

博通

+關注

關注

35文章

4325瀏覽量

106910 -

AI芯片

+關注

關注

17文章

1886瀏覽量

35014

發布評論請先 登錄

相關推薦

2026年亮相!蘋果正與博通合作研發AI芯片

博通股價躍升 或因蘋果與博通合作開發人工智能芯片的利好刺激

蘋果與博通聯手開發AI服務器芯片

OpenAI計劃自研AI推理芯片,攜手博通與臺積電共謀發展

博聯AI大模型全屋智能亮相2024中國建博會

OpenAI邁向AI芯片新紀元:與博通等巨頭共謀未來

OpenAI與博通攜手探索新AI芯片研發

字節跳動與博通合作開發AI芯片傳聞不實

字節跳動攜手博通開發5nm AI處理器,保障高端芯片供應

大廠自研芯片背后的贏家,不只有晶圓廠

risc-v多核芯片在AI方面的應用

納微半導體發布最新AI數據中心電源技術路線圖

博通,開放路線AI芯片的贏家

博通,開放路線AI芯片的贏家

評論