日本多企業聯合科研組于昨日宣布推出Fugaku-LLM大模型,此模型基于Arm架構的“富岳”超級計算機進行培訓,呈現出顯著特性。

Fugaku-LLM模型項目自2023年5月起啟動,初始參加方包括富士通、東京工業大學、日本東北大學及日本理化學研究所(簡稱理研)。至同年8月,又有三家合作伙伴——名古屋大學、CyberAgent(Cygames母公司)以及HPC-AI領域創新企業Kotoba Technologies加入。

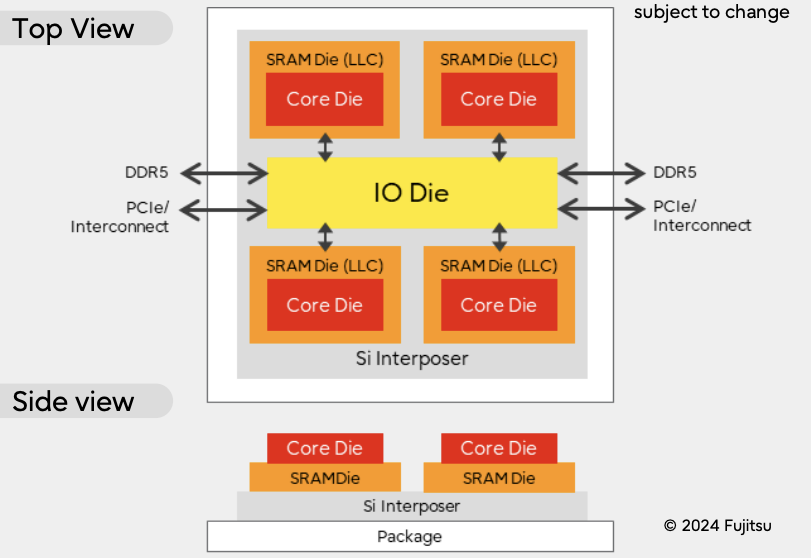

在昨日公布的新聞稿中,研究團隊表示他們成功發掘了富岳超級計算機的潛能,使矩陣乘法運算速度提升六倍,通信速度提高三倍,從而證實大型純CPU超級計算機同樣適用于大模型訓練。

Fugaku-LLM模型參數規模達13B,成為日本國內最大的大型語言模型。該模型利用13824個富岳超級計算機節點,在3800億個Token上進行訓練,其中60%為日語數據,其余40%涵蓋英語、數學、代碼等內容。

研究團隊表示,Fugaku-LLM模型能夠在交流過程中自然運用日語敬語等特殊表達方式。

在測試結果方面,該模型在日語MT-Bench模型基準測試中的平均得分高達5.5,位列基于日本語料資源的開放模型之首;同時,在人文社科類別的測試中獲得9.18的高分。

目前,Fugaku-LLM模型已在GitHub和Hugging Face平臺公開發布,外部研究人員和工程師可以在遵循許可協議的前提下,將該模型應用于學術和商業領域。

-

cpu

+關注

關注

68文章

10872瀏覽量

211999 -

超級計算機

+關注

關注

2文章

462瀏覽量

41953 -

大模型

+關注

關注

2文章

2476瀏覽量

2793

發布評論請先 登錄

相關推薦

什么是LLM?LLM在自然語言處理中的應用

LLM和傳統機器學習的區別

新品|LLM Module,離線大語言模型模塊

大模型LLM與ChatGPT的技術原理

llm模型和chatGPT的區別

LLM模型的應用領域

LLM之外的性價比之選,小語言模型

日本超算富岳助力構建大規模語言模型Fugaku-LLM

日本超算富岳助力構建大規模語言模型Fugaku-LLM

評論