K折交叉驗證算法通常使用數據集中的大部分數據作為**訓練集**。

K折交叉驗證是一種評估模型性能的統計方法,它涉及將數據集分成K個子集,每個子集大致等大。在K折交叉驗證過程中,其中一個子集被留作測試集,而其余的K-1個子集合并起來形成訓練集。這個過程會重復K次,每次選擇不同的子集作為測試集,以確保每個樣本都有機會作為測試集和訓練集的一部分。這種方法可以有效地評估模型對新數據的泛化能力,因為它考慮了數據集的多個子集。具體步驟如下:

1. 數據劃分:原始數據集被平均分成K個子集。這些子集通常具有相似的數據分布,以確保訓練過程的穩定性。

2. 模型訓練:在每次迭代中,K-1個子集被合并用作訓練集,剩下的一個子集用作驗證集。模型在訓練集上進行訓練。

3. 模型驗證:訓練好的模型在保留的驗證集上進行測試,以評估模型的性能。

4. 性能匯總:重復上述過程K次,每次都使用不同的子集作為驗證集。最后,將所有迭代的結果平均,得到模型的整體性能估計。

5. 模型選擇:如果有多個模型需要比較,可以根據K折交叉驗證的結果選擇表現最佳的模型。

6. 最終測試:一旦選擇了最佳模型,可以在未參與交叉驗證的獨立測試集上進行最終測試,以驗證模型的泛化能力。

總的來說,K折交叉驗證的優勢在于它能夠更全面地利用數據集,每個數據點都有機會參與訓練和測試,從而提高了評估的準確性。此外,它還可以減少由于數據劃分方式不同而導致的評估結果波動。然而,這種方法的缺點是計算成本較高,因為需要多次訓練模型。此外,如果數據集太小,K折交叉驗證可能不夠穩定,因為每次迭代的測試集只有總數據集的一小部分。

審核編輯 黃宇

-

算法

+關注

關注

23文章

4607瀏覽量

92840 -

數據集

+關注

關注

4文章

1208瀏覽量

24689

發布評論請先 登錄

相關推薦

第三章:訓練圖像估計光照度算法模型

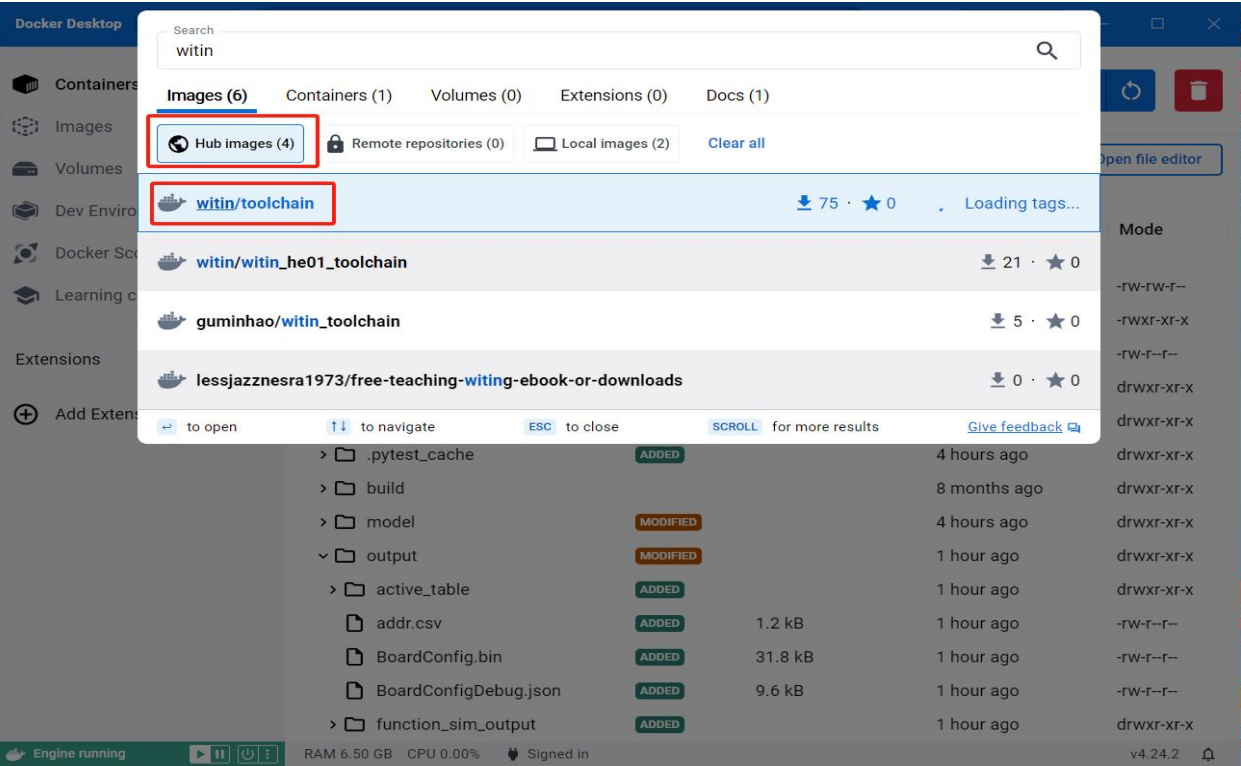

【飛凌嵌入式OK3576-C開發板體驗】RKNN神經網絡算法開發環境搭建

pycharm怎么訓練數據集

機器學習中的交叉驗證方法

如何理解機器學習中的訓練集、驗證集和測試集

神經網絡如何用無監督算法訓練

人臉識別模型訓練失敗原因有哪些

人臉識別模型訓練是什么意思

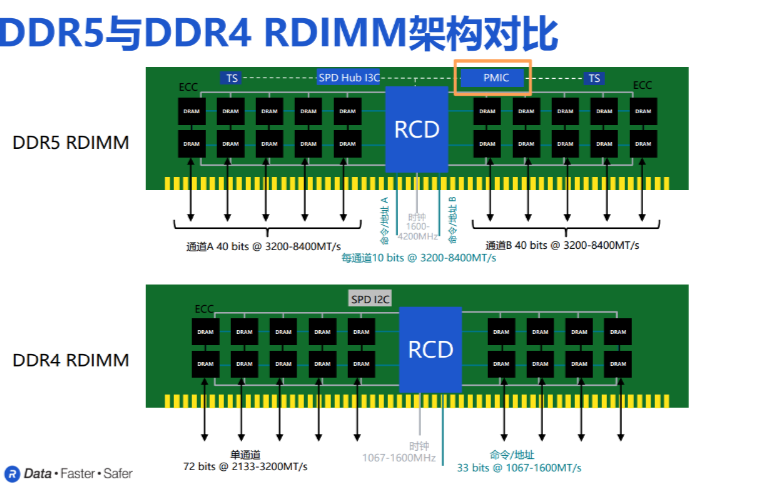

AI訓練狂飆,DDR5集成PMIC護航,內存技術持續助力

PyTorch如何訓練自己的數據集

Kaggle知識點:訓練神經網絡的7個技巧

K折交叉驗證算法與訓練集

K折交叉驗證算法與訓練集

評論