當前,在人工智能領域,大模型在豐富人工智能應用場景中扮演著重要的角色,經過不斷的探索,大模型進入到落地的階段。而大模型在落地過程中面臨兩大關鍵難題:對龐大計算資源的需求和對數據隱私與安全的考量。為應對這些挑戰,在邊緣側私有化部署大模型成為了一個有效的解決方案。

將大模型部署到邊緣側,不僅能夠減少延遲和帶寬消耗,使得大模型能夠在邊緣節點快速進行推理和應用;還能增強數據隱私保護,這對于維護企業的數據安全至關重要。

為響應市場需求,英碼科技推出了基于算能BM1684X平臺的大模型私有化部署產品方案,包括:邊緣計算盒子IVP03X-V2、云邊加速卡AIV02X和AIV03X,助力企業實現垂直大模型應用落地!

▎邊緣計算盒子IVP03X-V2

IVP03X-V2是英碼科技基于BM1684X推出的高性能邊緣計算盒子,INT8算力高達32Tops,配置了16GB大內存,支持適配Llama2-7B/ChatGLM3-6B/Qwen-7B和SAM/StableDiffusion等大模型,是業內少數能同時兼容國內外深度學習框架,并且能夠流暢運行大語言模型推理的邊緣計算設備之一。

▎大模型推理加速卡AIV02X & AIV03X

AIV02X和AIV03X算力可達64 TOPS@INT8和72 TOPS@INT8,顯存配置32GB和48GB,支持多芯分布式推理及支持大語言/提示型/圖像生成模型等大模型推理;這兩款云邊大模型推理加速卡均可應用于邊緣大語言、文生圖等通用大模型、垂直行業私有模型的推理應用。

接下來,以英碼科技IVP03X邊緣計算盒子為例,為大家介紹實測大語言模型、文生圖大模型的部署流程和效果演示:

英碼科技IVP03X-V2實測大語言模型

一、前期準備工作

demo下載地址:

https://github.com/sophgo/sophon-demo

二、大模型內存配置

1、建一個存放工具的文件夾:

mkdir memedit && cd memedit

2、下載內存配置工具:

wget -nd https://sophon-file.sophon.cn/sophon-prod-s3/drive/23/09/11/13/DeviceMemoryModificationKit.tgz tar xvf DeviceMemoryModificationKit.tgz cd DeviceMemoryModificationKit tar xvf memory_edit_{vx.x}.tar.xz #vx.x是版本號 cd memory_edit

3、重配內存:

./memory_edit.sh -p #這個命令會打印當前的內存布局信息 ./memory_edit.sh -c -npu 7615 -vpu 3072 -vpp 3072 #npu也可以訪問vpu和vpp的內存 替換emmbboot.itb: sudo cp /data/memedit/DeviceMemoryModificationKit/memory_edit/emmcboot.itb /boot/emmcboot.itb && sync

4、重啟生效:

reboot 重啟后,檢查配置: free -h cat /sys/kernel/debug/ion/bm_npu_heap_dump/summary | head -2 cat /sys/kernel/debug/ion/bm_vpu_heap_dump/summary | head -2 cat /sys/kernel/debug/ion/bm_vpp_heap_dump/summary | head -2

三、實測Chat-GLM3大模型(英文模式)

1、demo下載(Chat-GLM3)

進到Chat-GLM2案例目錄下:sophon-demo-release/sample/Chat-GLM2/

安裝pip3,安裝dfss

sudo apt install python3-pip pip3 install dfss -i https://pypi.tuna.tsinghua.edu.cn/simple/ pip3 install dfss --upgrade

下載模型:

sudo apt install unzip chmod -R +x scripts/ ./scripts/download.sh

2、安裝依賴

安裝python依賴:

pip3 install -r python/requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/ Sail安裝包,下載安裝: python3 -m dfss --url=open@sophgo.com:sophon-demo/ChatGLM3/sail/soc/sophon_arm-3.7.0-py3-none-any.whl pip3 install sophon_arm-3.7.0-py3-none-any.whl

3、大模型運行測試:

python3 python/chatglm3.py --bmodel models/BM1684X/chatglm3-6b_int4.bmodel --token python/token_config --dev_id 0 python3 python/chatglm3.py --bmodel models/BM1684X/chatglm3-6b_int8.bmodel --token python/token_config --dev_id 0 python3 python/chatglm3.py --bmodel models/BM1684X/chatglm3-6b_fp16.bmodel --token python/token_config --dev_id 0

9

四、實測Qwen大模型(中文模式)

1、demo下載(Qwen)

進到Chat-GLM2案例目錄下:sophon-demo-release/sample/Qwen/

安裝pip3,安裝dfss

sudo apt install python3-pip pip3 install dfss -i https://pypi.tuna.tsinghua.edu.cn/simple/ pip3 install dfss --upgrade

下載模型:

sudo apt install unzip chmod -R +x scripts/ ./scripts/download.sh

2、安裝依賴

安裝python依賴:

pip3 install -r python/requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/ Sail安裝包,下載安裝: python3 -m dfss --url=open@sophgo.com:sophon-demo/ChatGLM3/sail/soc/sophon_arm-3.7.0-py3-none-any.whl pip3 install sophon_arm-3.7.0-py3-none-any.whl

3、大運行測試:

python3 python/qwen.py --bmodel models/BM1684X/qwen-7b_int4_1dev.bmodel --token python/token_config --dev_id 0 python3 python/qwen.py --bmodel models/BM1684X/qwen-7b_int8_1dev.bmodel --token python/token_config --dev_id 0

英碼科技IVP03X-V2實測文生圖大模型

1、demo下載(StableDiffusionV1_5)

進到Chat-GLM2案例目錄下:sophon-demo-release/sample/Qwen/

安裝pip3,安裝dfss

sudo apt install python3-pip pip3 install dfss -i https://pypi.tuna.tsinghua.edu.cn/simple/ pip3 install dfss --upgrade

下載模型:

sudo apt install unzip chmod -R +x scripts/ ./scripts/download_controlnets_bmodel.sh ./scripts/download_multilize_bmodel.sh ./scripts/download_singlize_bmodel.sh

2、安裝依賴

安裝python依賴:

pip3 install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/ 安裝sail包 python3 -m dfss --url=open@sophgo.com:sophon-demo/ChatGLM3/sail/soc/sophon_arm-3.7.0-py3-none-any.whl

3、大模型運行測試:

①文本生成圖像

迭代20次

python3run.py--model_path../models/BM1684X--stagesinglize--prompt"Aparrotrestingonabranch"--neg_prompt"worstquality"--num_inference_steps20--dev_id0

迭代500次

python3 run.py --model_path ../models/BM1684X --stage singlize --pr ompt "A parrot resting on a branch" --neg_prompt "worst quality" --num_inference_steps 500 --dev_id 0

② Controlnet插件輔助控制 生成圖像

一只小兔子晚上在酒吧喝酒 :迭代次數,20次

python3 run.py --model_path ../models/BM1684X --stage multilize --controlnet_name scribble_controlnet_fp16.bmodel --processor_name scribble_processor_fp16.bmodel --controlnet_img ../pics/generated_img.jpg --prompt "a rabbit drinking at the bar at night" --neg_prompt "worst quality" --num_inference_steps 100 --dev_id 0

一只小兔子晚上在酒吧喝酒 :迭代次數,200次

python3 run.py --model_path ../models/BM1684X --stage multilize --controlnet_name scribble_controlnet_fp16.bmodel --processor_name scribble_processor_fp16.bmodel --controlnet_img ../pics/generated_img.jpg --prompt "a rabbit drinking at the bar at night" --neg_prompt "worst quality" --num_inference_steps 200 --dev_id 0

結語

隨著大模型技術的不斷落地和應用,大模型涌現的強大能力不再局限于云端,模型的算法正逐漸向邊緣端延伸;未來,英碼科技將結合自身在軟硬件方面的技術優勢和豐富的經驗,以AI賦能更多企業低門檻、高效落地邊緣側大模型應用,從而推動各行業智能化轉型的進程。

審核編輯 黃宇

-

AI

+關注

關注

87文章

30728瀏覽量

268886 -

人工智能

+關注

關注

1791文章

47183瀏覽量

238247 -

大模型

+關注

關注

2文章

2423瀏覽量

2640

發布評論請先 登錄

相關推薦

智能水電表管理系統支持本地私有化部署嗎?

【算能RADXA微服務器試用體驗】+ GPT語音與視覺交互:2,圖像識別

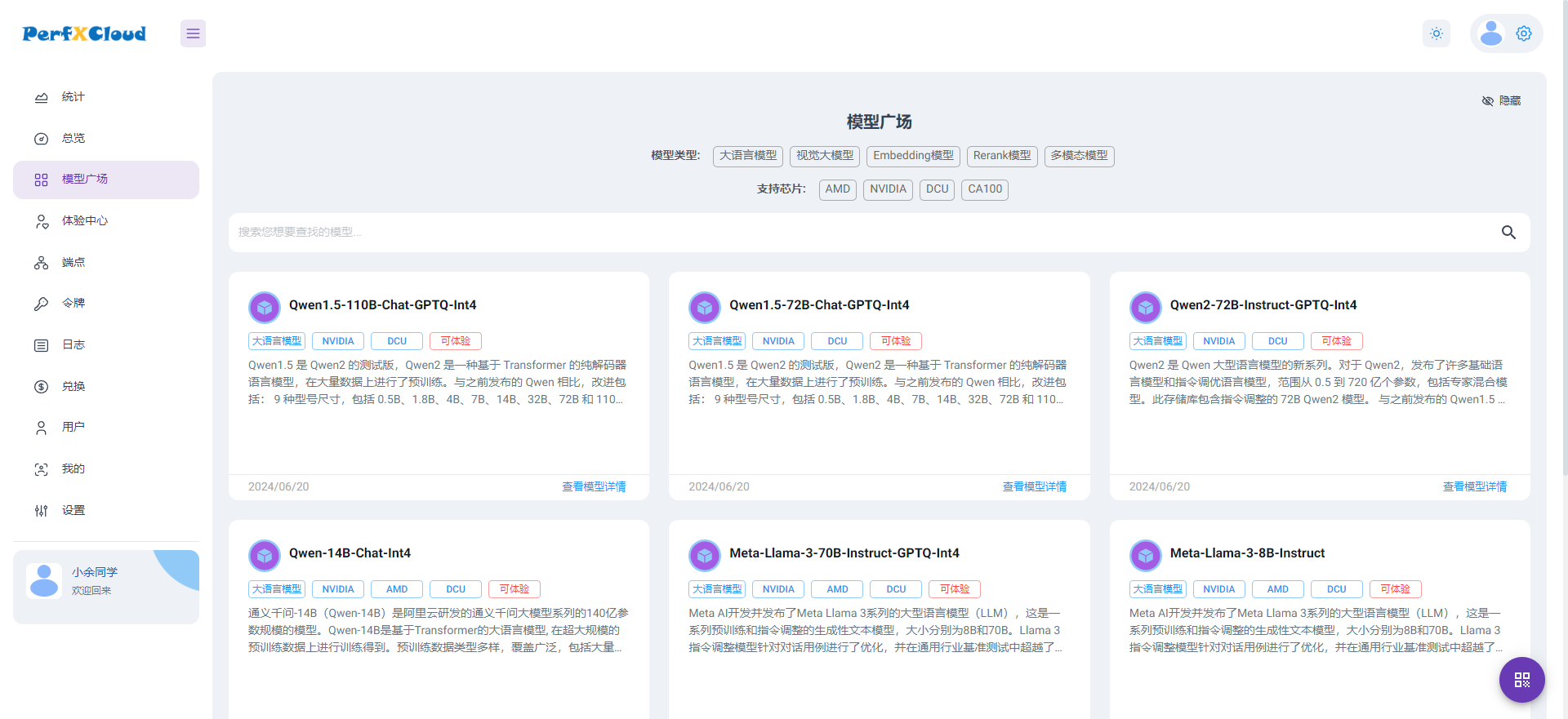

PerfXCloud大模型開發與部署平臺開放注冊

用yolov5的best.pt導出成onnx轉化成fp32 bmodel后在Airbox上跑,報維度不匹配怎么處理?

bm1684運行demo報錯怎么解決?

搭載TPU處理器BM1688&CV186AH的英碼科技邊緣計算盒子,功耗更低、接口更豐富

源2.0適配FastChat框架,企業快速本地化部署大模型對話平臺

產品應用 | 小盒子跑大模型!英碼科技基于算能BM1684X平臺實現大模型私有化部署

產品應用 | 小盒子跑大模型!英碼科技基于算能BM1684X平臺實現大模型私有化部署

評論