人工神經網絡(Artificial Neural Networks, ANNs)是一種受到生物神經網絡啟發的計算模型,用于模擬人腦處理信息的方式。它們在許多領域都有廣泛的應用,包括圖像識別、語音識別、自然語言處理等。

- 神經網絡的基本概念

神經網絡是由大量的節點(或稱為神經元)組成的網絡結構。每個節點都與其他節點相連,形成一個復雜的網絡。這些節點可以接收輸入信號,對其進行處理,并將輸出信號傳遞給其他節點。神經網絡的工作原理是通過調整節點之間的連接權重來實現的。

- 神經元模型

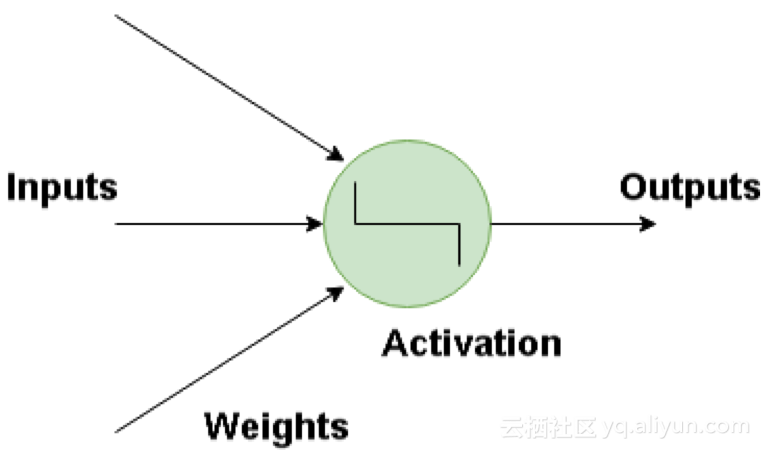

神經元是神經網絡的基本單元,它接收輸入信號,對其進行加權求和,然后通過激活函數進行非線性轉換,生成輸出信號。一個典型的神經元模型包括以下幾個部分:

- 輸入:神經元接收來自其他神經元或外部的輸入信號。

- 權重:每個輸入信號都有一個與之對應的權重,用于調整輸入信號的重要性。

- 偏置:偏置是一個常數,用于調整神經元的輸出。

- 激活函數:激活函數是一個非線性函數,用于將輸入信號的線性組合轉換為非線性輸出。

- 神經網絡的架構

神經網絡的架構通常包括輸入層、隱藏層和輸出層。輸入層接收外部信號,隱藏層負責處理和轉換輸入信號,輸出層生成最終的輸出結果。

- 輸入層:輸入層的神經元數量與輸入信號的特征數量相同。

- 隱藏層:隱藏層可以有多個,每個隱藏層可以包含不同數量的神經元。隱藏層的神經元數量和層數可以根據問題的復雜性進行調整。

- 輸出層:輸出層的神經元數量取決于問題的輸出需求。例如,在分類問題中,輸出層的神經元數量通常與類別數量相同。

- 權重和偏置的初始化

在神經網絡的訓練過程中,權重和偏置的初始化對網絡的性能有很大影響。通常,權重可以使用小的隨機值進行初始化,而偏置可以初始化為0或小的常數。

- 損失函數

損失函數是衡量神經網絡預測結果與真實結果之間差異的函數。常見的損失函數包括均方誤差(Mean Squared Error, MSE)、交叉熵損失(Cross-Entropy Loss)等。損失函數的選擇取決于問題的類型和需求。

- 反向傳播算法

反向傳播算法(Backpropagation)是一種用于訓練神經網絡的算法。它通過計算損失函數關于權重的梯度,然后使用梯度下降法或其他優化算法來更新權重和偏置。

反向傳播算法的主要步驟包括:

- 前向傳播:將輸入信號通過神經網絡的各層進行前向傳播,生成預測結果。

- 計算損失:使用損失函數計算預測結果與真實結果之間的差異。

- 反向傳播:根據損失函數的梯度,從輸出層開始反向傳播,計算每層神經元的梯度。

- 更新權重和偏置:使用梯度下降法或其他優化算法更新權重和偏置。

- 優化算法

優化算法用于在訓練過程中調整權重和偏置,以最小化損失函數。常見的優化算法包括梯度下降法(Gradient Descent)、隨機梯度下降法(Stochastic Gradient Descent, SGD)、Adam等。

- 正則化

為了防止神經網絡過擬合,可以采用正則化技術。常見的正則化方法包括L1正則化、L2正則化、Dropout等。正則化通過在損失函數中添加額外的懲罰項,限制模型的復雜度。

- 超參數調整

超參數是神經網絡訓練過程中需要手動設置的參數,如學習率、批量大小、迭代次數等。超參數的選擇對模型的性能有很大影響。通常,可以通過網格搜索(Grid Search)、隨機搜索(Random Search)等方法進行超參數調整。

- 神經網絡的類型

根據網絡結構和應用場景的不同,神經網絡可以分為多種類型,如前饋神經網絡(Feedforward Neural Networks)、卷積神經網絡(Convolutional Neural Networks, CNNs)、循環神經網絡(Recurrent Neural Networks, RNNs)等。

- 應用領域

人工神經網絡在許多領域都有廣泛的應用,包括:

-

人工神經網絡

+關注

關注

1文章

120瀏覽量

14870 -

計算模型

+關注

關注

0文章

29瀏覽量

9937 -

自然語言處理

+關注

關注

1文章

628瀏覽量

14051

發布評論請先 登錄

基于Python 的人工神經網絡的工作原理

人工神經網絡原理及下載

【PYNQ-Z2試用體驗】神經網絡基礎知識

人工神經網絡實現方法有哪些?

【AI學習】第3篇--人工神經網絡

怎么解決人工神經網絡并行數據處理的問題

人工神經網絡,人工神經網絡是什么意思

BP神經網絡編碼樣例及工作原理

評論