電子發燒友網報道(文/李彎彎)近日,2024世界人工智能大會正在舉行,無問芯穹聯合創始人兼CEO夏立雪在大會論壇上談到一個現象,從GPT-3到GPT-4,無論是算力還是大模型能力都遵循指數級增長,而GPT-4之后的一段時間里,無論是OpenAI發布的新模型,還是其他大模型,整體算法能力進入了放緩甚至是停滯的階段。

夏立雪認為,這其中,表面上看是大模型的發展放緩或者停止了,其實背后的邏輯卻是支撐算法的算力遇到了瓶頸。在他看來,算力是AI發展的前哨和基石,支撐模型能力邁向下一代的算力系統,還需要去研發和構建。

國內模型層和芯片層生態相對分散

為了應對大模型對算力的需求,國內外巨頭都在加大對算力資源的投入,如國外的微軟、谷歌、Meta、OpenAI,以及國內的大廠百度,移動、聯通、電信三大運營商等都在構建萬卡集群,萬卡集群儼然成為了大模型性能提升的兵家必爭之地。

然而相比之下,國外模型層與芯片層生態相對集中,算法廠商不超過10家,芯片廠商差不多是兩家,英偉達和AMD。國內生態則是一個非常分散的狀態,大家都知道,中國百模大戰,包括非常多通用的基座大模型,還有很多行業大模型。芯片層面,除了英偉達和AMD之外,國內還有非常多算力芯片廠商去爭相擴展市場。

這些分散的生態,就會面臨很多生態打通的關鍵問題。因此,在國內,雖然大家知道構建萬卡集群非常重要。而且據統計,現在國內已經有一百多個建設方宣布正在建設或者已經建設了千卡集群,這里面大部分采用的是異構算力,原因之一是國內的生態非常分散,另外是在供應方面,需要非常多不同的卡來滿足集群性能需求。

夏立雪談到,這些異構的芯片之間,存在一種“生態豎井”,即硬件生態系統封閉且互不兼容。用了A卡的開發者,無法輕易遷移至B卡上展開工作,也難以同時使用A卡和B卡完成大模型訓練或推理。

這導致,如果一個算力集群中存在兩種或以上的芯片,算力使用方會面臨一系列技術挑戰,比如不同硬件平臺適配不同的軟件棧和工具鏈,而某些任務更容易在特定類型的芯片上運行,開發者若要在異構芯片上從事生產,就需要為每種芯片定制和優化代碼,這大大增加了開發和維護的復雜性。這也使得多種算力芯片被投入各地集群從事AI生產,而“生態豎井”的存在,讓“多芯片”并不等于“大算力”。

無問芯穹提出了異構千卡混訓解決方案。異構芯片間的混訓主要面臨兩大挑戰,一是異構卡通信庫差異,導致異構卡之間通信難;二是異構卡之間性能差異,導致模型分布式訓練低效。

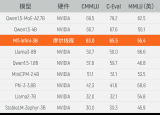

為此,無問芯穹建立了一個通用集合通信庫,實現不同芯片的高效通信;然后提出了一種基于流水線并行的非均勻拆分方案,以解決不同種芯片負載均衡的問題;最后提出了一個自研的混訓性能預測工具,用于判斷最優的非均勻拆分策略,指導千卡異構集群訓練。從實際千卡混合訓練效果可見,無問芯穹千卡異構混合訓練集群算力利用率最高達到了97.6%。

沐曦、壁仞談“算力瓶頸破局之術”

在某個論壇“算力瓶頸破局之術”的圓桌討論環節,沐曦聯合創始人兼軟件CTO楊建分別從算法層面和芯片層面談到解決之道。首先是算法層面,硅基的算力三年只能提升三倍,而大模型對算力的需求則要求吞吐量三年提升750倍。在楊建看來,這用硬件的方法無論如何也達不到,單從芯片層面無法解決這個問題。

他認為,今天大家追捧的Transfomer算法可能是錯的,即使大家也在Transfomer軟件上進行一些創新,其實作用并不大。我們還是需要從基本的算法層面出發,思考怎么從算法上進行改變,才能讓算法在三年內推理效率提高750倍。大模型已經進入一個新的時代,Transfomer的時代已經結束了,大家需要思考的是怎么突破Transfomer的限制。

接著看從芯片層面的破局,楊建認為,這很難。他認為,我們與美國算力差距會在2029年達到最大。首先,我們與英偉達存在工藝上的差距。其次,我們無法進口最先進的芯片,在2029年的時候,中國芯片仍然還是會落后英偉達。據他推算,到2029年,中國的算力綜合,可能不到美國的四分之一。

其實,在2022年之前,我們與美國的算力基本上是一比一,2023年開始急劇下降,可以看到,美國很多企業部署集群都是一萬張卡以上,國內到五千張卡已經非常了不起了。因此,我們與美國算力的差距,從2023年開始逐步擴大,到2029年會到達一個高峰值,原因是,美國對算力需求的總量到那時候再往上添加意義不大了。

但國內單芯片的算力到那時候還是沒有辦法去趕上美國,因此在楊建看來,當沒有辦法從這個層面去破局的時候,我們需要跳出原來的圈子。

怎么做呢?他談到,英偉達B200其實給出了一個很好的例子,一直以來AMD在chiplet上都非常領先,它無論是CPU還是GPU都要做chiplet。然而英偉達在B200上又做了一個新的chiplet,它把中間的傳輸性一下子提升到了10TB per second,這是一個全新的架構,AMD完全沒有往這個方向走。

中國在chiplet方向其實已經走得很遠,不僅有chiplet封裝,還有Die to Die封裝,還有wafer to wafer的封裝,中國的芯片公司如果想要在硬件上提升,其實可以利用先進封裝這個優勢,去思考如何提高提高單芯片的性能。

此外,除了提升單芯片性能之外,還可以去思考怎么從系統級做優化,以前基本上是一個CPU帶8張卡,現在可以思考是不是能夠一個CPU帶16張卡、32張卡。單芯片算力不夠,是不是能通過系統級互聯結構,在互聯上進行一些加速,從而達到更好的性能。數據傳輸在算力上是一個非常重要的方面,可以探索好的壓縮算法技術,通過壓縮數據本身,而不改變推理和訓練的精度,來提升效率。

壁仞科技副總裁兼AI軟件首席架構師丁云帆從三個維度談到算力瓶頸的破局之法。大模型的訓練是一個系統工程,它需要軟件和硬件結合起來,同時也需要算法和工程協同,在這樣一個復雜的系統里,它面臨非常多的挑戰。

丁云帆提到三個點,一是硬件算力,二是軟硬結合之后的有效算力,三是異構混訓的聚合算力。硬件算力,即單卡的算力乘以卡的個數,單卡的算力可能因為制程等原因,它能做到的上限有限,不過單卡本身微架構層面仍談有創新的空間。比如,壁仞在第一代產品里用了chiplet架構,這就是用chiplet的當時提升從單卡層面提升算力。

單卡之外,還有單機,傳統基本上是單機8卡,現在可以通過一些方式做到單機16卡,把單機性能提升上去。單機之外,現在還可以看到有很多千卡集群、萬卡集群,通過更大規模的集群去提升算力,這個時候網絡對基礎設施的要求會非常高。

有了超大集群之后,最終軟件是不是能夠把集群的算力發揮出來,這就談到了軟硬件結合的有效算力,丁云帆將這個效率總結了三個點:首先是,集群的調度效率怎么樣,比如說,有一萬張卡,調度效率不好,相當于可能在用的只有九千張;其次是能不能夠用好它,也就能不能夠通過算法功能的協同,訓練把算法的性能優化上去,尤其是大規模參數的大模型,在超大集群里,如何去做模型拆分、做各種并行策略,真正把集群的算力發揮出來;

其三大規模集群還有一個穩定問題,無論是采用英偉達還是國產的算力芯片,都會存在這個問題,大規模集群的故障率非常高,可能分配有10個小時,卻只能用到8個小時。這需要對故障的檢測能夠自動定位出來,出了故障之后,能夠更快速的恢復它。

聚合算力,現在可以看到建了很多千卡集群、萬卡集群,可能有些集群用的同一種英偉達的卡,它也可能是很多小的池子,現在隨著更多國產GPU的落地,這又會出現新的池子。對于用戶來說,這么多小池子,是不是能夠聚合起來去訓一個大的模型。那么這個在互聯互通層面,首先要通,其次通行的效率怎么樣,肯定會有通行快慢的問題,這種異構的并行的拆分策略就非常關鍵。

總結來說,就是硬件算力、軟硬件結合的有效算力、聚合算力,我們從這三個維度都把相關的工作做好,即使是國產單個芯片看上去不夠強,我們通過這樣的方式也能夠把國產算力提升到滿足大模型訓練的需求。

寫在最后

隨著大模型的發展,其性能提升放緩甚至停滯,而這背后則是支撐算法的算力遇到瓶頸。國內外都在加大千卡、萬卡集群的建設來提升算力,然而這其中仍然存在問題,在國內芯片生態分散,集群使用多種芯片,異構芯片之間的混訓存在挑戰。同時相對于國外,國產單芯片存在落差,如何通過本身優勢,如chiplet,來提升單機、集群的算力,如何通過軟硬件結合提升算法訓練效率等,都是可以思考突破算力瓶頸的方向。

-

AI

+關注

關注

87文章

30728瀏覽量

268886 -

算力芯片

+關注

關注

0文章

46瀏覽量

4516 -

AI算力

+關注

關注

0文章

72瀏覽量

8652 -

壁仞科技

+關注

關注

1文章

55瀏覽量

2733 -

沐曦

+關注

關注

0文章

26瀏覽量

1152

發布評論請先 登錄

相關推薦

壁仞科技聯合中國電信等合作伙伴共同發布智算異構四芯混訓解決方案

性能提升近一倍!壁仞科技攜手無問芯穹,在千卡訓練集群等領域取得技術新突破

芯片、模型生態分散,無問芯穹、沐曦、壁仞談國產算力瓶頸破局之道

芯片、模型生態分散,無問芯穹、沐曦、壁仞談國產算力瓶頸破局之道

評論