引言

在自然語言處理(NLP)領域,Transformer模型以其卓越的性能和廣泛的應用前景,成為了近年來最引人注目的技術之一。Transformer模型由谷歌在2017年提出,并首次應用于神經機器翻譯任務,隨后迅速擴展到其他NLP任務中,如文本生成、語言理解、問答系統等。本文將詳細介紹Transformer語言模型的原理、特點、優勢以及實現過程。

一、Transformer模型原理

1.1 模型結構

Transformer模型是一種基于自注意力機制的編碼器-解碼器(Encoder-Decoder)結構。它完全摒棄了傳統的循環神經網絡(RNN)和卷積神經網絡(CNN)中的序列依賴性,通過自注意力機制實現了對序列數據的全局建模。Transformer模型由多個編碼器(Encoder)和解碼器(Decoder)堆疊而成,每個編碼器和解碼器又由多個Transformer Block組成。

1.2 編碼器(Encoder)

編碼器的主要功能是將輸入序列轉換為一系列隱藏狀態,這些隱藏狀態將作為解碼器的輸入。每個編碼器包含兩個子層:自注意力層(Self-Attention Layer)和前饋神經網絡層(Feed Forward Neural Network Layer)。自注意力層用于計算序列中每個位置與其他位置的關系,使得模型能夠捕捉到序列內部的依賴關系。前饋神經網絡層則用于對自注意力層的輸出進行進一步處理,并引入非線性變換。

1.3 解碼器(Decoder)

解碼器負責根據編碼器的輸出生成目標序列。與編碼器類似,解碼器也包含自注意力層和前饋神經網絡層,但增加了一個額外的注意力層——編碼器-解碼器注意力層(Encoder-Decoder Attention Layer)。這個層用于計算解碼器當前位置與編碼器所有位置之間的關系,從而幫助解碼器在生成目標序列時參考輸入序列的信息。

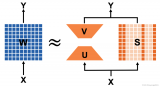

1.4 自注意力機制(Self-Attention Mechanism)

自注意力機制是Transformer模型的核心。它通過計算序列中每個位置與其他位置之間的注意力權重,來捕捉序列內部的依賴關系。具體來說,自注意力機制首先計算查詢(Query)、鍵(Key)和值(Value)三個矩陣,然后通過縮放點積注意力(Scaled Dot-Product Attention)機制計算注意力權重,并將這些權重應用于值矩陣上,得到加權和作為輸出。

二、Transformer模型的優點

2.1 并行性

相比于RNN,Transformer模型能夠在所有位置同時計算,充分利用了GPU的并行計算能力,從而加速了模型的訓練和推理過程。

2.2 長距離依賴

傳統的RNN模型在處理長序列時容易出現梯度消失和梯度爆炸的問題,難以捕捉長距離依賴關系。而Transformer模型通過自注意力機制能夠同時考慮所有位置的信息,從而更好地處理長序列。

2.3 性能表現

在自然語言處理領域中,Transformer模型已經取得了許多重要的研究成果。它在機器翻譯、文本生成、語言模型等任務中都取得了很好的效果,并在多項基準測試中刷新了記錄。

三、Transformer模型的實現過程

3.1 數據預處理

在訓練Transformer模型之前,需要對輸入數據進行預處理。這通常包括分詞(Tokenization)、構建詞匯表(Vocabulary)、添加位置編碼(Positional Encoding)等步驟。分詞是將文本轉換為一系列單詞或子詞單元的過程;詞匯表則用于將單詞或子詞單元映射為唯一的索引;位置編碼則是為了向模型提供單詞在序列中的位置信息。

3.2 模型構建

模型構建是Transformer模型實現的核心部分。它通常包括以下幾個步驟:

- 初始化參數 :設置模型的超參數,如編碼器和解碼器的層數、隱藏層的大小、注意力頭的數量等。

- 構建編碼器 :根據設定的超參數構建編碼器層,每個編碼器層包含自注意力層、前饋神經網絡層以及殘差連接和層歸一化(Layer Normalization)操作。

- 構建解碼器 :解碼器的構建過程與編碼器類似,但增加了編碼器-解碼器注意力層。

- 嵌入層 :將分詞后的單詞轉換為嵌入向量,并與位置編碼相加,得到模型的輸入。

3.3 訓練過程

訓練Transformer模型通常采用無監督的方式進行預訓練,然后再進行有監督的微調。在預訓練過程中,通常使用自編碼器(Autoencoder)或掩碼語言模型(Masked Language Model)等方式進行訓練,目標是學習輸入序列的表示。在微調過程中,則使用有監督的數據集進行訓練,例如在機器翻譯任務中,使用平行語料庫進行訓練,學習將輸入序列映射到目標序列的映射關系。

訓練過程通常包括以下幾個步驟:

- 前向傳播 :將輸入數據送入模型,計算模型的輸出。

- 計算損失 :根據輸出和真實標簽計算損失函數,如交叉熵損失。

- 反向傳播 :通過鏈式法則計算損失函數對模型參數的梯度。在Transformer模型中,由于自注意力機制和前饋神經網絡的復雜性,梯度的計算也相應變得復雜,需要仔細設計以保證計算的高效和準確。

- 參數更新 :利用梯度下降(或其變體,如Adam優化器)更新模型的參數,以最小化損失函數。在訓練過程中,通常會采用學習率衰減、梯度裁剪等技術來穩定訓練過程,防止模型過擬合或梯度爆炸。

3.4 模型評估與調優

在訓練完成后,需要對模型進行評估以驗證其性能。評估通常包括在測試集上計算各種性能指標,如準確率、召回率、F1分數等。此外,還可以通過可視化技術(如注意力權重可視化)來深入理解模型的工作機制,發現潛在的問題并進行調優。

調優是一個迭代的過程,可能包括調整模型的超參數(如學習率、隱藏層大小、注意力頭數量等)、修改模型結構(如增加或減少層數)、使用不同的優化算法等。通過不斷嘗試和調整,可以逐步提升模型的性能。

四、Transformer模型的應用

Transformer模型因其強大的表示能力和廣泛的應用前景,在NLP領域得到了廣泛的關注和應用。以下是一些典型的應用場景:

- 機器翻譯 :Transformer模型最初就是為解決機器翻譯問題而設計的,并在多個翻譯任務中取得了優異的性能。

- 文本生成 :利用Transformer模型可以生成連貫、流暢的文本,如文章摘要、詩歌創作、對話生成等。

- 語言理解 :Transformer模型在情感分析、命名實體識別、問答系統等語言理解任務中也表現出色。

- 多模態任務 :通過將Transformer模型與圖像、音頻等其他模態的數據結合,可以實現跨模態的任務,如圖像描述生成、視頻字幕生成等。

五、結論與展望

Transformer模型作為NLP領域的一項重大突破,以其獨特的自注意力機制和高效的并行計算能力,為自然語言處理任務提供了強大的支持。隨著技術的不斷發展和應用的深入拓展,Transformer模型將在更多領域發揮重要作用,并推動人工智能技術的進一步發展。

未來,我們可以期待Transformer模型在以下幾個方面取得更多的進展:

- 模型優化 :通過改進模型結構、優化訓練算法等方式,進一步提升Transformer模型的性能和效率。

- 多模態融合 :加強Transformer模型與其他模態數據的融合能力,實現更加全面的多模態理解和生成。

- 可解釋性增強 :提升Transformer模型的可解釋性,使得其決策過程更加透明和可理解,從而增強用戶對其的信任度。

- 低資源語言處理 :探索如何在低資源語言環境下有效訓練和應用Transformer模型,以推動自然語言處理技術的全球化普及。

總之,Transformer模型作為自然語言處理領域的重要基石,將繼續引領著技術的發展和應用的拓展。我們期待著未來更多的創新和突破,為人類社會帶來更加智能和便捷的服務。

-

語言模型

+關注

關注

0文章

561瀏覽量

10802 -

Transformer

+關注

關注

0文章

151瀏覽量

6528 -

自然語言處理

+關注

關注

1文章

628瀏覽量

14172

發布評論請先 登錄

如何使用MATLAB構建Transformer模型

大語言模型背后的Transformer,與CNN和RNN有何不同

【大語言模型:原理與工程實踐】探索《大語言模型原理與工程實踐》

【大語言模型:原理與工程實踐】大語言模型的基礎技術

大語言模型:原理與工程時間+小白初識大語言模型

如何更改ABBYY PDF Transformer+界面語言

超大Transformer語言模型的分布式訓練框架

基于Transformer的大型語言模型(LLM)的內部機制

transformer模型詳解:Transformer 模型的壓縮方法

評論