PyTorch,作為一個廣泛使用的開源深度學習庫,提供了豐富的工具和模塊,幫助開發者構建、訓練和部署神經網絡模型。在神經網絡模型中,輸出層是尤為關鍵的部分,它負責將模型的預測結果以合適的形式輸出。以下將詳細解析PyTorch中神經網絡輸出層的特性及整個模型的構建過程。

一、PyTorch神經網絡輸出層詳解

1. 輸出層的作用

輸出層是神經網絡模型的最后一層,其主要作用是將前一層(通常是全連接層或卷積層的輸出)轉換為模型所需的預測結果形式。根據任務的不同,輸出層的結構也會有所差異。例如,在分類任務中,輸出層通常會包含多個神經元,每個神經元對應一個類別,輸出值表示屬于該類別的概率;在回歸任務中,輸出層則可能只包含一個神經元,輸出值為連續的預測值。

2. PyTorch中的輸出層實現

在PyTorch中,輸出層通常通過torch.nn.Linear(全連接層)或torch.nn.functional中的激活函數(如softmax、sigmoid等)來實現。對于分類任務,全連接層后通常會接softmax激活函數,將輸出轉換為概率分布;對于回歸任務,則可能直接輸出全連接層的原始值,或使用其他激活函數(如ReLU)進行非線性變換。

示例:分類任務的輸出層

import torch

import torch.nn as nn

class Classifier(nn.Module):

def __init__(self, num_inputs, num_classes):

super(Classifier, self).__init__()

self.fc = nn.Linear(num_inputs, num_classes) # 全連接層

def forward(self, x):

x = self.fc(x)

x = torch.nn.functional.softmax(x, dim=1) # softmax激活函數

return x

在這個例子中,Classifier類定義了一個分類器的輸出層,它包含一個全連接層fc,用于將輸入特征映射到類別空間。在forward方法中,全連接層的輸出通過softmax激活函數轉換為概率分布。

示例:回歸任務的輸出層

對于回歸任務,輸出層可能更加簡單,直接輸出全連接層的原始值或使用ReLU等激活函數進行非線性變換。

class Regressor(nn.Module):

def __init__(self, num_inputs, num_outputs):

super(Regressor, self).__init__()

self.fc = nn.Linear(num_inputs, num_outputs) # 全連接層

def forward(self, x):

x = self.fc(x)

# 對于回歸任務,通常不需要額外的激活函數,除非有特定的非線性需求

return x

3. 注意事項

- 輸出層神經元數量 :輸出層神經元的數量應根據具體任務的需求來確定。例如,在K分類問題中,輸出層應有K個神經元。

- 激活函數的選擇 :對于分類任務,softmax是常用的激活函數;而對于回歸任務,則可能不需要激活函數或選擇其他適合的激活函數。

- 損失函數 :輸出層的損失函數應與任務類型相匹配。例如,分類任務常使用交叉熵損失函數,而回歸任務則常使用均方誤差損失函數。

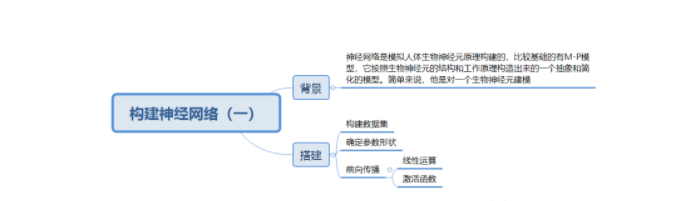

二、PyTorch神經網絡模型構建過程

1. 確定網絡結構

在構建神經網絡之前,首先需要確定網絡的結構,包括輸入層、隱藏層和輸出層的數量以及每層中的節點數等。這通常需要根據具體任務和數據集的特性來決定。

2. 收集和準備數據

數據是訓練神經網絡的基礎。在收集到原始數據后,需要進行預處理操作,如清洗數據、轉換數據格式、劃分訓練集和測試集等。對于圖像數據,可能還需要進行歸一化、裁剪、旋轉等操作以增強模型的泛化能力。

3. 定義模型

在PyTorch中,可以通過繼承nn.Module類來定義自己的神經網絡模型。在定義模型時,需要實現__init__方法來初始化模型的各個層,并定義forward方法來描述模型的前向傳播過程。

示例:簡單的CNN模型

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 6, 5) # 輸入通道數為1,輸出通道數為6,卷積核大小為5x5

self.pool = nn.MaxPool2d(2, 2) # 最大池化層,池化核大小為2x2,步長為2

self.conv2 = nn.Conv2d(6, 16, 5) # 第二個卷積層,輸入通道數為6,輸出通道數為16

self.fc1 = nn.Linear(16 * 5 * 5, 120) # 全連接層,假設輸入特征圖大小為5x5(經過兩次卷積和池化后的大小可能需調整)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10) # 假設是10分類問題

def forward(self, x):

x = self.pool(torch.nn.functional.relu(self.conv1(x)))

x = self.pool(torch.nn.functional.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5) # 展平操作,將多維的輸入一維化,以便輸入全連接層

x = torch.nn.functional.relu(self.fc1(x))

x = torch.nn.functional.relu(self.fc2(x))

x = self.fc3(x)

return x

4. 初始化模型參數

在定義了模型之后,通常需要初始化模型的參數。PyTorch在默認情況下會自動初始化這些參數,但也可以根據需求自定義初始化方法。

model = SimpleCNN()

# 如果你想自定義初始化,可以遍歷model的參數,并使用如nn.init.xavier_uniform_等函數進行初始化

for m in model.modules():

if isinstance(m, nn.Conv2d):

nn.init.xavier_uniform_(m.weight)

nn.init.constant_(m.bias, 0)

elif isinstance(m, nn.Linear):

nn.init.xavier_uniform_(m.weight)

nn.init.constant_(m.bias, 0)

5. 定義損失函數和優化器

損失函數用于評估模型預測值與實際值之間的差異,而優化器則用于根據損失函數的梯度來更新模型的參數。

6. 訓練模型

在準備好數據、模型、損失函數和優化器之后,就可以開始訓練模型了。訓練過程通常包括前向傳播、計算損失、反向傳播和參數更新等步驟。

# 假設trainloader是加載訓練數據的DataLoader

for epoch in range(num_epochs):

for i, (inputs, labels) in enumerate(trainloader):

# 前向傳播

outputs = model(inputs)

loss = criterion(outputs, labels)

# 反向傳播和優化

optimizer.zero_grad() # 清除之前的梯度

loss.backward() # 反向傳播計算梯度

optimizer.step() # 更新參數

# 打印訓練信息(可選)

if (i+1) % 100 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Step [{i+1}/{len(trainloader)}], Loss: {loss.item():.4f}')

7. 評估模型

在訓練過程中或訓練完成后,需要使用測試集來評估模型的性能。評估過程與訓練過程類似,但不包括反向傳播和參數更新步驟。

# 假設testloader是加載測試數據的DataLoader

model.eval() # 設置為評估模式

with torch.no_grad(): # 在評估模式下,不需要計算梯度

correct = 0

total = 0

for data in testloader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total}%')

8. 模型保存與加載

在PyTorch中,模型通常通過保存其參數(即權重和偏置)來持久化。這些參數被存儲在一個名為state_dict的字典對象中。

保存模型

# 保存整個模型

torch.save(model, 'model.pth')

# 或者,只保存模型的參數(推薦方式)

torch.save(model.state_dict(), 'model_weights.pth')

加載模型

當需要加載模型時,你需要首先定義模型結構,然后加載參數。

# 加載整個模型(需要確保模型定義與保存時完全一致)

model = torch.load('model.pth')

# 或者,加載模型參數

model = SimpleCNN() # 首先定義模型結構

model.load_state_dict(torch.load('model_weights.pth'))

model.eval() # 設置為評估模式

10. 模型優化

在模型訓練過程中,可能需要進行一系列的優化操作以提高模型的性能。

10.1 超參數調優

- 學習率 :嘗試不同的學習率,看哪個值能使模型更快且更穩定地收斂。

- 批量大小 (Batch Size):調整批量大小可以影響內存使用量和模型訓練的穩定性。

- 優化器 :除了SGD,還可以嘗試Adam、RMSprop等其他優化器。

- 正則化 :使用L1、L2正則化或Dropout來防止過擬合。

10.2 數據增強

對于圖像數據,數據增強是提高模型泛化能力的有效手段。通過隨機旋轉、裁剪、翻轉、顏色抖動等操作,可以增加數據集的多樣性。

from torchvision import transforms

transform = transforms.Compose([

transforms.RandomResizedCrop(224),

transforms.RandomHorizontalFlip(),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

10.3 模型架構調整

- 增加或減少層數 :嘗試更深的或更淺的模型架構。

- 改變層類型 :例如,用卷積層替換全連接層,或嘗試使用殘差連接。

- 使用預訓練模型 :對于大型數據集,可以使用在ImageNet等大規模數據集上預訓練的模型進行遷移學習。

11. 模型部署

訓練并優化好模型后,下一步通常是將其部署到生產環境中,以進行實際的預測或推理。

11.1 轉換為ONNX

PyTorch模型可以轉換為ONNX(Open Neural Network Exchange)格式,這是一種開放的格式,允許模型在不同框架和硬件上高效運行。

# 假設模型已加載并處于評估模式

dummy_input = torch.randn(1, 1, 224, 224) # 創建一個符合模型輸入要求的隨機張量

torch.onnx.export(model, dummy_input, "model.onnx")

11.2 部署到服務器或邊緣設備

- 服務器部署 :使用Flask、Django等框架將模型封裝為Web服務,或利用TensorFlow Serving、TorchServe等工具進行部署。

- 邊緣設備部署 :對于移動設備或嵌入式系統,可以使用PyTorch Mobile或ONNX Runtime等工具將模型部署到這些設備上。

12. 結論

在PyTorch中構建、訓練、優化和部署神經網絡模型是一個復雜但充滿挑戰和機遇的過程。通過精心設計模型架構、合理選擇超參數、充分利用數據增強和正則化技術,可以顯著提高模型的性能。同時,了解如何將模型轉換為可部署的格式,并在不同的硬件和平臺上運行,也是成功應用深度學習技術的關鍵。希望這篇文章能為你提供一個全面的視角,幫助你更好地理解和使用PyTorch來構建神經網絡模型。

-

神經網絡

+關注

關注

42文章

4814瀏覽量

103472 -

模型

+關注

關注

1文章

3516瀏覽量

50359 -

pytorch

+關注

關注

2文章

809瀏覽量

13925

發布評論請先 登錄

評論