BP神經(jīng)網(wǎng)絡(luò),全稱為反向傳播神經(jīng)網(wǎng)絡(luò)(Backpropagation Neural Network),是一種在機(jī)器學(xué)習(xí)、數(shù)據(jù)挖掘和模式識(shí)別等領(lǐng)域廣泛應(yīng)用的人工神經(jīng)網(wǎng)絡(luò)模型。其工作原理基于多層前饋網(wǎng)絡(luò)結(jié)構(gòu),通過誤差反向傳播算法(Error Backpropagation Algorithm)來訓(xùn)練網(wǎng)絡(luò),實(shí)現(xiàn)對(duì)復(fù)雜問題的學(xué)習(xí)和解決。以下將詳細(xì)闡述BP神經(jīng)網(wǎng)絡(luò)的工作方式,涵蓋其基本原理、訓(xùn)練過程、應(yīng)用實(shí)例以及優(yōu)缺點(diǎn)等多個(gè)方面。

一、BP神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)

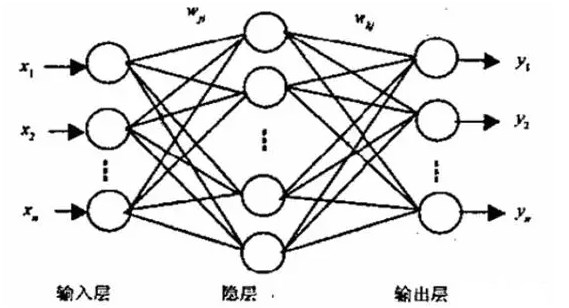

BP神經(jīng)網(wǎng)絡(luò)由多個(gè)層次組成,主要包括輸入層、隱藏層(可以有多個(gè))和輸出層。每一層都包含多個(gè)神經(jīng)元,這些神經(jīng)元通過帶有權(quán)重的連接相互連接。信息在網(wǎng)絡(luò)中從輸入層開始,逐層向前傳遞,通過各層的激活函數(shù)進(jìn)行計(jì)算和轉(zhuǎn)化,最終到達(dá)輸出層。

- 輸入層 :接收外部輸入信號(hào),不進(jìn)行任何計(jì)算,僅作為數(shù)據(jù)輸入的接口。

- 隱藏層 :對(duì)輸入信號(hào)進(jìn)行非線性變換,是神經(jīng)網(wǎng)絡(luò)的核心部分,負(fù)責(zé)學(xué)習(xí)輸入與輸出之間的復(fù)雜映射關(guān)系。隱藏層可以有一層或多層,層數(shù)和神經(jīng)元數(shù)量根據(jù)具體問題而定。

- 輸出層 :輸出網(wǎng)絡(luò)的處理結(jié)果,通常與問題的具體目標(biāo)(如分類、回歸等)相對(duì)應(yīng)。

如圖所示為BP神經(jīng)網(wǎng)絡(luò)的拓?fù)浣Y(jié)構(gòu),一般包含三層前饋網(wǎng),即輸入層、中間層(也稱隱層)和輸出層。它的特點(diǎn)是:各層神經(jīng)元僅與相鄰層神經(jīng)元之間相互全連接,同層內(nèi)神經(jīng)元之間無連接,各層神經(jīng)元之間無反饋連接,構(gòu)成具有層次結(jié)構(gòu)的前饋型神經(jīng)網(wǎng)絡(luò)系統(tǒng)。單計(jì)算層前饋神經(jīng)網(wǎng)絡(luò)只能求解線性可分問題,能夠求解非線性問題的網(wǎng)絡(luò)必須是具有隱層的多層神經(jīng)網(wǎng)絡(luò)。

如圖所示的BP神經(jīng)網(wǎng)絡(luò),輸入層包含m個(gè)節(jié)點(diǎn),輸出層包含n個(gè)節(jié)點(diǎn),可以看做是一個(gè)m維向量到一個(gè)n維向量的映射。

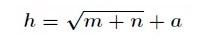

隱層節(jié)點(diǎn)的選擇有一個(gè)經(jīng)驗(yàn)公式:

其中h為隱含層節(jié)點(diǎn)數(shù)目,m為輸入層節(jié)點(diǎn)數(shù)目,n為輸出層節(jié)點(diǎn)數(shù)目,a為1~10之間的調(diào)節(jié)常數(shù)。

二、BP神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過程

BP神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過程主要分為兩個(gè)階段:前向傳播和反向傳播。

1. 前向傳播

前向傳播是信號(hào)在網(wǎng)絡(luò)中從輸入層向輸出層傳播的過程。具體來說,輸入層的信號(hào)經(jīng)過加權(quán)和運(yùn)算后傳遞給隱藏層,隱藏層的神經(jīng)元接收來自前一層的信號(hào),經(jīng)過激活函數(shù)處理后再傳遞給下一層,直到最終到達(dá)輸出層。每一層的輸出都是下一層輸入的來源。

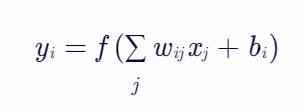

在前向傳播過程中,神經(jīng)元的輸出計(jì)算方式通常為:

其中,yi?表示當(dāng)前神經(jīng)元的輸出,f(?)為激活函數(shù),wij?為從神經(jīng)元j到神經(jīng)元i的連接權(quán)重,xj?為前一層的輸入(或神經(jīng)元j的輸出),bi?為神經(jīng)元i的偏置項(xiàng)。

2. 反向傳播

反向傳播是誤差從輸出層向輸入層反向傳播的過程,用于調(diào)整網(wǎng)絡(luò)中的連接權(quán)重和偏置項(xiàng),以減小網(wǎng)絡(luò)輸出與期望輸出之間的誤差。

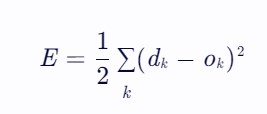

首先,計(jì)算網(wǎng)絡(luò)輸出與期望輸出之間的誤差,常用的誤差函數(shù)為均方誤差(Mean Squared Error, MSE):

其中,dk為期望輸出,ok為實(shí)際輸出。

然后,利用鏈?zhǔn)椒▌t計(jì)算誤差關(guān)于各層權(quán)重的梯度,即誤差信號(hào)在各層之間的反向傳播。梯度表示了權(quán)重變化對(duì)誤差減少的影響程度,通過梯度下降法更新權(quán)重,使誤差逐步減小。

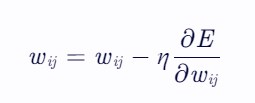

權(quán)重更新公式為:

其中,η為學(xué)習(xí)率,決定了權(quán)重更新的步長。

三、BP神經(jīng)網(wǎng)絡(luò)的算法實(shí)現(xiàn)

BP神經(jīng)網(wǎng)絡(luò)的算法實(shí)現(xiàn)包括網(wǎng)絡(luò)初始化、前向傳播、誤差計(jì)算、反向傳播和權(quán)重更新等步驟。以下是一個(gè)簡(jiǎn)化的算法流程:

- 初始化網(wǎng)絡(luò) :隨機(jī)初始化網(wǎng)絡(luò)中所有連接的權(quán)重和偏置項(xiàng)。

- 前向傳播 :根據(jù)輸入數(shù)據(jù),通過加權(quán)和和激活函數(shù)計(jì)算每一層的輸出,直至得到輸出層的輸出。

- 誤差計(jì)算 :計(jì)算輸出層的誤差,并將其反向傳播到隱藏層。

- 反向傳播 :根據(jù)誤差和梯度下降法,計(jì)算每一層權(quán)重的梯度,并更新權(quán)重。

- 迭代訓(xùn)練 :重復(fù)步驟2-4,直到滿足停止條件(如達(dá)到最大迭代次數(shù)、誤差小于預(yù)定閾值等)。

四、BP神經(jīng)網(wǎng)絡(luò)的應(yīng)用實(shí)例

BP神經(jīng)網(wǎng)絡(luò)在多個(gè)領(lǐng)域有著廣泛的應(yīng)用,如模式識(shí)別、分類、回歸、預(yù)測(cè)等。以下列舉幾個(gè)具體的應(yīng)用實(shí)例:

- 手寫數(shù)字識(shí)別 :通過訓(xùn)練BP神經(jīng)網(wǎng)絡(luò),可以實(shí)現(xiàn)對(duì)手寫數(shù)字圖像的分類識(shí)別。網(wǎng)絡(luò)輸入為數(shù)字圖像的像素值,輸出為數(shù)字類別。

- 人臉識(shí)別 :在人臉識(shí)別系統(tǒng)中,BP神經(jīng)網(wǎng)絡(luò)可以學(xué)習(xí)人臉圖像的特征,實(shí)現(xiàn)人臉的檢測(cè)和識(shí)別。

- 語音識(shí)別 :通過訓(xùn)練BP神經(jīng)網(wǎng)絡(luò),可以提取語音信號(hào)的特征,實(shí)現(xiàn)對(duì)語音的識(shí)別和理解。

- 股票價(jià)格預(yù)測(cè) :利用歷史股票價(jià)格數(shù)據(jù)訓(xùn)練BP神經(jīng)網(wǎng)絡(luò),可以預(yù)測(cè)未來股票價(jià)格的走勢(shì),為投資者提供決策支持。

五、BP神經(jīng)網(wǎng)絡(luò)的優(yōu)缺點(diǎn)

優(yōu)點(diǎn):

- 非線性映射能力 :BP神經(jīng)網(wǎng)絡(luò)通過隱藏層的非線性激活函數(shù),能夠?qū)W習(xí)和逼近復(fù)雜的非線性映射關(guān)系,解決傳統(tǒng)方法難以處理的問題。

- 自學(xué)習(xí)和自適應(yīng)能力 :網(wǎng)絡(luò)在訓(xùn)練過程中能夠自動(dòng)調(diào)整權(quán)重和偏置項(xiàng),以適應(yīng)不同輸入數(shù)據(jù)的特性,表現(xiàn)出較強(qiáng)的自學(xué)習(xí)和自適應(yīng)能力。

- 容錯(cuò)能力強(qiáng) :BP神經(jīng)網(wǎng)絡(luò)具有一定的容錯(cuò)性,即當(dāng)輸入數(shù)據(jù)存在噪聲或缺失時(shí),網(wǎng)絡(luò)仍能給出較為合理的輸出。

- 并行處理能力 :神經(jīng)網(wǎng)絡(luò)的計(jì)算是高度并行的,每個(gè)神經(jīng)元都可以獨(dú)立進(jìn)行計(jì)算,這使得網(wǎng)絡(luò)在處理大規(guī)模數(shù)據(jù)時(shí)具有較高的效率。

缺點(diǎn):

- 訓(xùn)練時(shí)間長 :由于BP神經(jīng)網(wǎng)絡(luò)采用梯度下降法來更新權(quán)重,而梯度下降法本身可能陷入局部最小值,導(dǎo)致訓(xùn)練過程耗時(shí)較長,且可能無法找到全局最優(yōu)解。

- 過擬合問題 :當(dāng)網(wǎng)絡(luò)結(jié)構(gòu)過于復(fù)雜或訓(xùn)練數(shù)據(jù)不足時(shí),BP神經(jīng)網(wǎng)絡(luò)容易出現(xiàn)過擬合現(xiàn)象,即網(wǎng)絡(luò)對(duì)訓(xùn)練數(shù)據(jù)過度擬合,而對(duì)新數(shù)據(jù)的泛化能力較差。

- 權(quán)重初始化敏感 :BP神經(jīng)網(wǎng)絡(luò)的性能對(duì)權(quán)重的初始值較為敏感,不同的初始值可能導(dǎo)致網(wǎng)絡(luò)收斂到不同的局部最小值。

- 參數(shù)選擇困難 :網(wǎng)絡(luò)中的學(xué)習(xí)率、隱藏層數(shù)、神經(jīng)元數(shù)量等參數(shù)需要人工設(shè)定,且這些參數(shù)的選擇對(duì)網(wǎng)絡(luò)的性能有較大影響,缺乏統(tǒng)一的選擇標(biāo)準(zhǔn)。

六、BP神經(jīng)網(wǎng)絡(luò)的改進(jìn)方法

為了克服BP神經(jīng)網(wǎng)絡(luò)的上述缺點(diǎn),研究者們提出了多種改進(jìn)方法,包括但不限于以下幾種:

- 優(yōu)化算法 :引入更高效的優(yōu)化算法,如動(dòng)量法、共軛梯度法、牛頓法等,以加快訓(xùn)練速度并減少陷入局部最小值的風(fēng)險(xiǎn)。

- 正則化技術(shù) :通過添加正則化項(xiàng)(如L1正則化、L2正則化)到誤差函數(shù)中,限制網(wǎng)絡(luò)權(quán)重的復(fù)雜度,從而減輕過擬合問題。

- 早停法 :在訓(xùn)練過程中監(jiān)控網(wǎng)絡(luò)在驗(yàn)證集上的性能,當(dāng)性能開始下降時(shí)停止訓(xùn)練,以避免過擬合。

- Dropout技術(shù) :在訓(xùn)練過程中隨機(jī)丟棄一部分神經(jīng)元及其連接,以減少神經(jīng)元之間的共適應(yīng)性,提高網(wǎng)絡(luò)的泛化能力。

- 批量歸一化 :在每個(gè)隱藏層之后添加批量歸一化層,對(duì)輸入數(shù)據(jù)進(jìn)行歸一化處理,以加速訓(xùn)練過程并提高網(wǎng)絡(luò)的穩(wěn)定性。

- 深度學(xué)習(xí)框架 :利用深度學(xué)習(xí)框架(如TensorFlow、PyTorch等)來構(gòu)建和訓(xùn)練BP神經(jīng)網(wǎng)絡(luò),這些框架提供了豐富的工具和庫,使得網(wǎng)絡(luò)的設(shè)計(jì)、訓(xùn)練和評(píng)估變得更加簡(jiǎn)單和高效。

七、結(jié)論

BP神經(jīng)網(wǎng)絡(luò)作為一種經(jīng)典的人工神經(jīng)網(wǎng)絡(luò)模型,在多個(gè)領(lǐng)域展現(xiàn)了其強(qiáng)大的學(xué)習(xí)和適應(yīng)能力。然而,它也存在一些固有的缺點(diǎn)和挑戰(zhàn)。通過不斷優(yōu)化算法、引入正則化技術(shù)、采用Dropout和批量歸一化等方法,可以進(jìn)一步提高BP神經(jīng)網(wǎng)絡(luò)的性能和穩(wěn)定性。隨著深度學(xué)習(xí)技術(shù)的不斷發(fā)展,BP神經(jīng)網(wǎng)絡(luò)及其改進(jìn)版本將在更多領(lǐng)域發(fā)揮重要作用,推動(dòng)人工智能技術(shù)的持續(xù)進(jìn)步。

-

BP神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

2文章

127瀏覽量

30658 -

人工神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

1文章

120瀏覽量

14723 -

模型

+關(guān)注

關(guān)注

1文章

3415瀏覽量

49475

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

粒子群優(yōu)化模糊神經(jīng)網(wǎng)絡(luò)在語音識(shí)別中的應(yīng)用

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

基于BP神經(jīng)網(wǎng)絡(luò)的PID控制

BP神經(jīng)網(wǎng)絡(luò)概述

BP神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)和訓(xùn)練過程

BP神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)和訓(xùn)練過程

評(píng)論