“基于原生多模態(tài)大模型,商湯絕影正在打造一系列全新的車載智能化產(chǎn)品,推動智能汽車向超級智能體進(jìn)化。”商湯科技聯(lián)合創(chuàng)始人、首席科學(xué)家、絕影智能汽車事業(yè)群總裁王曉剛在WAIC 2024商湯科技“大愛無疆·向新力”人工智能論壇上說。

一個超級智能體的進(jìn)化離不開強(qiáng)大的端側(cè)模型,大量原生多模態(tài)大模型正在從云走向智能汽車為代表的各種智能終端,車端模型部署能力將成為智能汽車進(jìn)化過程中不可或缺的技術(shù)保障。

在論壇上,王曉剛宣布商湯絕影在行業(yè)內(nèi)率先實(shí)現(xiàn)了原生多模態(tài)大模型的車端部署。絕影行業(yè)領(lǐng)先的車載端側(cè)8B模型首包延遲可低至300毫秒以內(nèi),推理速度40 Tokens/秒,并且能夠覆蓋主流算力平臺。

商湯絕影在行業(yè)率先實(shí)現(xiàn)

原生多模態(tài)大模型的車端部署

此前GPT-4o的發(fā)布為消費(fèi)者展示了多模態(tài)實(shí)時交互的方式,讓更多人領(lǐng)略多模態(tài)感知和交互的魅力,也開始幫助釋放多模態(tài)大模型的商業(yè)落地想象空間。

相較于手機(jī),智能汽車才是更適合承載多模態(tài)大模型的落地場景。因為智能汽車內(nèi)外的各種攝像頭是常開的,用戶可以實(shí)時跟汽車通過多模態(tài)的方式進(jìn)行交互。同時,智能汽車的保有量不斷增加,能夠產(chǎn)生豐富的終端用戶反饋和數(shù)據(jù)信息,讓模型不斷迭代成長。

和OpenAI等公司相比,商湯絕影是汽車智能化的核心供應(yīng)商,在智能駕駛和智能座艙領(lǐng)域具備豐富的量產(chǎn)經(jīng)驗,將以多模態(tài)大模型為核心加速“以人為本”的智能汽車交互革新。

但相比于其他的終端,智能汽車有其特殊性,對安全和實(shí)時響應(yīng)有著非常高的要求,汽車是私密空間,終端用戶非常在意隱私保護(hù)。這就注定了多模態(tài)大模型大部分的任務(wù)將在車載終端完成。商湯絕影能夠以云側(cè)、端云結(jié)合、端側(cè)等全棧方式靈活部署多模態(tài)大模型,讓商湯原生多模態(tài)能力能夠快速落地智能汽車。

在WAIC 2024商湯人工智能論壇上,商湯絕影宣布在行業(yè)率先實(shí)現(xiàn)原生多模態(tài)大模型的車端部署,并在現(xiàn)場演示了搭載在200 TOPS+平臺上的8B模型(即80億參數(shù))車端部署方案,展示強(qiáng)多模態(tài)感知和交互能力。

相較于動輒就有幾秒鐘延遲的云上部署方案,商湯絕影車載端側(cè)8B多模態(tài)模型可以實(shí)現(xiàn)首包延遲可低至300毫秒以內(nèi),推理速度40 Tokens/秒,引領(lǐng)“以人為本”的智能汽車交互革新。

在WAIC 2024面向公眾的展臺上,商湯絕影還對外展示了在多個不同算力平臺上運(yùn)行2.1B或8B端側(cè)多模態(tài)大模型的適配能力。

明年,上千TOPS算力的車載芯片就會問世。基于更高算力的計算平臺,商湯絕影多模態(tài)大模型車端部署方案的首包延遲將大幅度降低,推理速度進(jìn)一步提高,為用戶帶來更加流暢和自然的智能汽車交互體驗。

引領(lǐng)多模態(tài)車端部署

商湯絕影有“殺器”

多模態(tài)大模型能夠?qū)⒄Z音、文字、圖像、手勢、視頻等各種模態(tài)進(jìn)行高效且深度地融合,提供更加豐富且自然的人機(jī)交互體驗。

過去許多模型處理不同模態(tài)信息是先把語音等輸入轉(zhuǎn)化為文字,文字和圖像結(jié)合進(jìn)行分析,輸出反饋也是先生成文字,根據(jù)文字再生成語音輸出,會有大量信息丟失和很高的延遲。

由“日日新5.5”體系支持的全新商湯多模態(tài)大模型是一種端到端的模型,也就是文字、語音、視頻等模態(tài)一同輸入,模型統(tǒng)一處理后輸出相應(yīng)模態(tài)的信息,相較于過去的方案,多模態(tài)融合的技術(shù)難度是幾何倍數(shù)的提升。

技術(shù)上的高難度是商湯行業(yè)領(lǐng)先的原生多模態(tài)能力的直接體現(xiàn)。今年4月發(fā)布的“日日新5.0”是國內(nèi)首個對標(biāo)GPT-4 Turbo的國產(chǎn)大模型,“日日新5.5”體系更是全面升級,數(shù)學(xué)推理、英文能力和指令跟隨等能力明顯增強(qiáng),交互效果和多項核心指標(biāo)實(shí)現(xiàn)對標(biāo)GPT-4o。

商湯持續(xù)迭代的“日日新”大模型體系是商湯絕影多模態(tài)的車端部署領(lǐng)先行業(yè)的底氣所在,也是絕影的“大殺器”之一。

要讓多模態(tài)大模型從云上落地到車端,商湯絕影還有更多的秘密武器。

由于車載硬件、系統(tǒng)種類繁多,各種加速芯片層出不窮,其他行業(yè)和開源的框架工具很難完全支持和適配,同時也為了解決自回歸方式生成token效率較低的問題,商湯絕影專為多模態(tài)大模型打造了一個“大殺器”——高性能計算引擎“HyperPPL”。它綜合了大語言模型、多模態(tài)模型、CNN模型、前后處理完整的優(yōu)化能力,是智能汽車領(lǐng)域最廣泛的高性能AI芯片異構(gòu)計算平臺,為商湯絕影多模態(tài)大模型落地車端提供強(qiáng)大的計算底座。

HyperPPL目前擴(kuò)展并支持主流車載計算硬件,兼容多種主流操作系統(tǒng),適配多個車載芯片的部署平臺,使得商湯絕影原生多模態(tài)大模型在主流芯片平臺均可快速部署上線。

同時,HyperPPL支持flash decode、segment prefill等400多個硬件算子,并對算子進(jìn)行性能優(yōu)化,同時量化支持int8、int4模式,并支持訓(xùn)練后量化,從而實(shí)現(xiàn)極致推理效率。相較于大多數(shù)開源的Python推理框架、C++推理框架以及訓(xùn)練推理框架,商湯絕影自研HyperPPL方案在Orin平臺上的推理速度更快,超過40 Tokens/S。而對比英偉達(dá)的原生推理框架 TensorRT,絕影的HyperPPL在推理能力相當(dāng)?shù)那闆r下,在內(nèi)存上有明顯優(yōu)勢,即以更小的內(nèi)存達(dá)到和前者相同的推理速度。

不僅如此,商湯絕影HyperPPL還針對車載多人場景進(jìn)行優(yōu)化,使得車內(nèi)多人并發(fā)情況下,車端多模態(tài)大模型的模型推理效率相比單人沒有明顯降低。

這些“大殺器”為商湯絕影引領(lǐng)多模態(tài)大模型的車端部署保駕護(hù)航。基于車端原生多模態(tài)大模型,商湯絕影將與合作伙伴共同打造全新的車載智能化產(chǎn)品,引領(lǐng)“以人為本”的智能汽車交互革新,加速智能汽車駛?cè)階GI時代。

-

人工智能

+關(guān)注

關(guān)注

1791文章

47183瀏覽量

238261 -

商湯科技

+關(guān)注

關(guān)注

8文章

508瀏覽量

36083 -

大模型

+關(guān)注

關(guān)注

2文章

2423瀏覽量

2643

原文標(biāo)題:80億參數(shù),40 Tokens/秒,0.3秒延遲!商湯絕影行業(yè)首發(fā)原生多模態(tài)大模型車端部署

文章出處:【微信號:SenseTime2017,微信公眾號:商湯科技SenseTime】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

商湯日日新多模態(tài)大模型權(quán)威評測第一

利用OpenVINO部署Qwen2多模態(tài)模型

商湯發(fā)布國內(nèi)首個病理大模型,開啟病理診斷新篇章

基于AX650N芯片部署MiniCPM-V 2.0高效端側(cè)多模態(tài)大模型

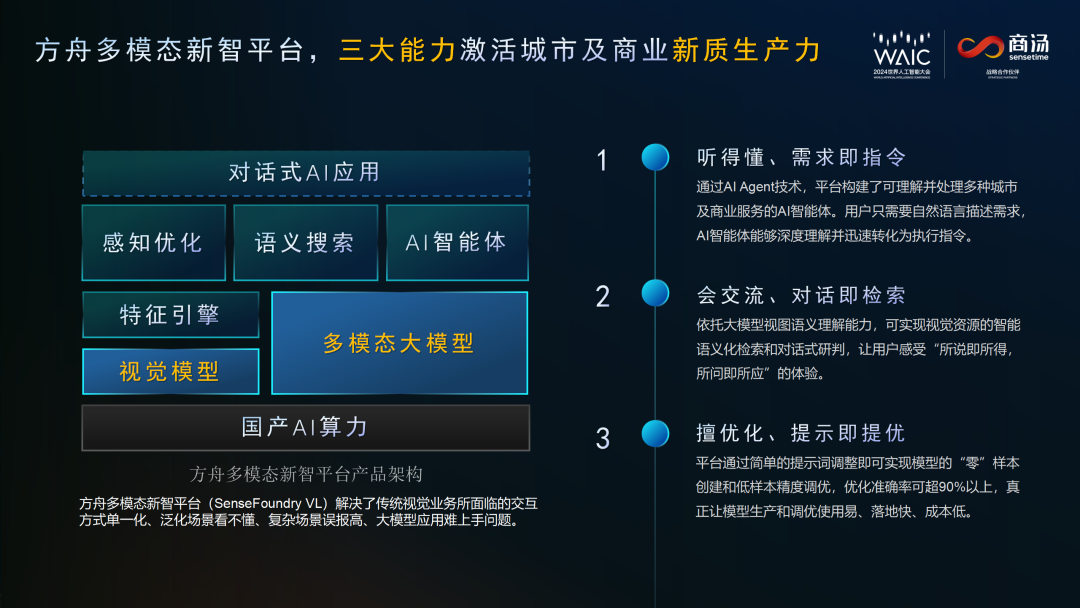

商湯科技推出SenseFoundry-VL方舟多模態(tài)新智平臺

商湯“日日新”大模型全面賦能2024 WAIC

商湯絕影大模型C助力LEVC全新智慧出行體驗

商湯絕影攜手經(jīng)緯恒潤推出智能感知后視鏡

商湯科技聯(lián)合海通證券發(fā)布多模態(tài)全棧式大模型

商湯科技發(fā)布“日日新SenseNova 5.0”大模型

商湯科技與海通證券攜手發(fā)布金融行業(yè)首個多模態(tài)全棧式大模型

商湯科技聯(lián)合海通證券發(fā)布業(yè)內(nèi)首個面向金融行業(yè)的多模態(tài)全棧式大模型

商湯絕影在行業(yè)率先實(shí)現(xiàn)原生多模態(tài)大模型的車端部署

商湯絕影在行業(yè)率先實(shí)現(xiàn)原生多模態(tài)大模型的車端部署

評論