當前,以生成式AI為代表的新一代人工智能技術持續火熱,大模型推理場景向端側加速遷移,在深度變革人機交互界面的同時,也為手機、PC等消費電子產業注入源源動能。然而,生成式AI對硬件的快速賦能背后,也對算力、存儲等方面提出了新的需求。這些新的需求,也為芯片廠商、終端廠商以及應用開發者帶來了新的挑戰與新的機遇。

我們應該如何應對這些挑戰?如何把握生成式AI帶來的機遇呢?產業各界已經聯手給出了答案。

近日,國內領先的通用計算CPU設計公司此芯科技正式推出了其首款專為AI PC打造的異構高能效芯片產品——“此芯P1”。據了解,這款芯片不僅異構集成了Armv9 CPU核心與Arm Immortalis GPU,還搭載了安謀科技“周易”NPU等自研業務產品,能夠提供高效能的異構算力資源、系統級的安全保障以及技術生態支持,將更好地滿足生成式AI在PC等端側場景的應用需求。

除AI PC以外,AI手機同樣熱度高漲,三星、華為、小米、vivo、OPPO、榮耀等各大手機廠商也都在積極探索與端側AI的深度融合,力求為用戶帶來更加智能化的新體驗。

如此看來,推動端側AI快速落地,需要更多類似的創新應用方案,而其中的底層技術革新更是關鍵所在。

眾所周知,AI大模型從生產到應用主要包括“訓練”和“推理”兩個步驟。其訓練和推理過程需要占用大量的計算資源和存儲空間,通常部署在云計算平臺上。而當用戶調用智能對話助手等AI大模型時,必須聯網接入。但云端大模型不僅算力成本高昂,而且在實時性、數據隱私安全等方面也面臨著諸多挑戰。

在此背景下,端側大模型順勢而生。其核心是將AI大模型直接部署到終端設備,讓這些設備擁有“本地智能”,無需依賴網絡連接,即可自行完成數據處理和智能決策。

在新一輪端側大模型熱潮中,以下兩大趨勢正逐步顯現:

首先是大模型逐漸小型化,通過將大模型的參數規模進行有效壓縮,以適配終端設備的軟硬件性能范圍。目前,大模型廠商新品往往包含大、中、小等不同參數量級,其最小的模型參數多在百億以下。這背后的原因主要是出于對計算成本、功耗和性能等因素的綜合考量,尤其是在端側部署大模型時,百億參數級大模型能夠更好地匹配現階段的大眾級終端設備。

第二個趨勢是終端廠商正加速端側大模型“裝機”。以PC和手機為例,自去年以來,頭部PC廠商相繼推出了內置本地大模型的AI PC新品,國內主流手機廠商也已經在其旗艦產品中成功部署70億參數規模的大模型,AI PC和AI手機隨即進入了應用爆發期。除此之外,端側大模型也已擴展到智能汽車以及具身智能機器人、AR/VR等IoT設備領域。

綜上所述,模型公司與終端硬件公司正相向而行,共同推動端側大模型的場景化落地,讓更多普通消費者也能輕松享用到大模型帶來的智能體驗。而大模型與終端產品二者間的交匯點,正是邊緣端設備的計算基礎——芯片。

其中,CPU作為最為核心的計算“大腦”,在端側推理過程中發揮著不容小覷的作用。

CPU作為智能終端的運算及控制中樞,其性能直接關系到端側設備的響應速度、處理能力、能效、用戶體驗和安全性等,是衡量終端性能的關鍵指標。生成式AI興起后,隨著大模型小型化和推理任務向端側遷移,CPU始終穩居終端硬件的核心地位,能夠出色勝任本地AI推理,為海量設備提供強有力的計算支持。具體來看:

首先,AI處理始于CPU。早期智能手機上的AI功能大多基于自然語言處理(NLP)和計算機視覺(CV)等技術,如文字轉寫、人臉識別、相冊分類、美顏濾鏡等細分功能。此類AI工作負載或是全權交由CPU處理,或是結合其他協處理器共同支持。

其次,AI處理爆發于CPU。CPU的通用性使其能夠快速響應端側大模型在不同場景的落地需求。例如面對入門級智能手機、汽車智能座艙、AIoT設備等應用場景,CPU可高效處理參數規模在數十億級別的小型計算任務。而在PC和旗艦智能手機等更高階的應用場景,所需處理的計算任務則相對復雜且龐大,即便配備了AI專用加速器,CPU依舊是不可或缺的計算基石,且能獨立承擔處理百億參數級別的更大規模計算任務。

Arm CPU憑借其在低功耗、高能效上的顯著優勢,被廣泛應用于各類消費電子設備。得益于Arm CPU的AI計算能力,目前全世界約99%的智能手機都具備在端側處理大模型所需的技術,包括NEON擴展架構、SVE可擴展向量擴展技術、SME可擴展矩陣擴展技術等關鍵Arm架構功能。以當今的安卓平臺來看,第三方應用中有70%的AI運行在Arm CPU上。除手機外,基于Arm CPU的PC市場規模也在迅速增長。

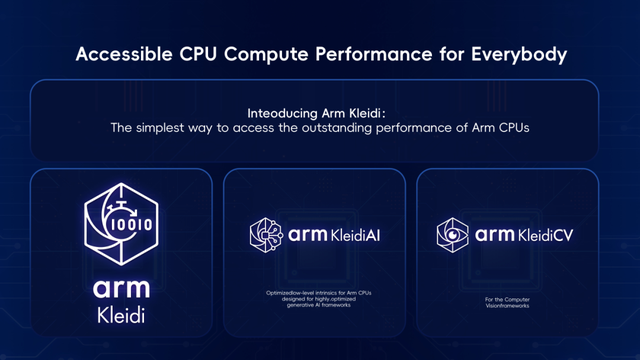

面向下一代AI終端設備,全新Arm終端計算子系統(CSS)應運而生,這是迄今為止運行速度最快的Arm計算平臺,不僅在計算和圖形性能上實現30%以上的提升,而且AI推理速度提高了59%,適用于更廣泛的AI、機器學習(ML)和計算視覺工作負載。同步推出的還有Arm Kleidi軟件開發平臺,能夠幫助開發者快速獲得開發生成式AI應用所需的性能、工具和軟件庫。

Arm終端CSS和Arm KleidiAI等新一代終端計算技術將進一步加速AI終端普及。預計2025年底,基于Arm架構的AI設備有望突破1000億臺。

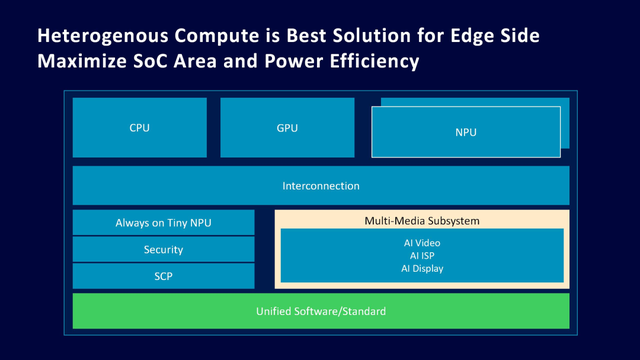

與此同時,隨著端側推理需求的日漸高漲,生成式AI用例將在更多元化的應用場景中“遍地開花”,然而計算任務復雜度和數據量也隨之激增,將對未來AI終端硬件提出更高的要求。由此,兼具通用性和專用性的異構計算解決方案已是大勢所趨,它能夠有機融合CPU、GPU、NPU等不同處理器,以滿足端側大模型部署的多樣化計算需求。

其中,NPU全稱Neural Processing Unit(神經網絡處理單元),專門針對神經網絡進行設計與優化,能更加高效地運行Transformer架構的AI模型。隨著AI手機、AI PC概念的普及,NPU的重要性也日益凸顯,它可以在視頻、圖像、系統管理等各類場景中發揮出色的AI加速能力,解決日益增長的終端推理需求。

安謀科技早在成立之初既已布局AI賽道,本土自研的“周易”NPU目前已迭代了Z系列和X系列的多款產品,廣泛應用于中高端安防、智能家居、移動設備、物聯網、智能座艙、ADAS、邊緣服務器等市場。

開篇提到的“此芯P1”則采用了基于第三代“周易”架構設計的NPU。通過對低功耗與高算力的針對性優化,“周易”NPU不僅能夠勝任長時間、高負載的任務處理,還支持多核多Cluster的算力擴展。在“周易”NPU的設計上,安謀科技從性能、精度、帶寬、調度管理、算子支持等多個維度,對各類圖像、視頻AI模型算法進行了深度優化,并且完成了對主流大模型的適配,進一步強化其在面對高性能AI計算需求時的表現。

面對端側生成式AI的高速發展和算力需求的不斷攀升,CPU無疑是為終端設備提供了得以接入AI功能的廣泛計算基礎,而異構計算與NPU則為多模態大模型等新興AI應用在端側落地打開了新的想象空間。但無論設備和應用如何演進,算力始終是支撐端側AI發展的基石,也是引領終端AI創新的核心引擎。

審核編輯 黃宇

-

cpu

+關注

關注

68文章

10854瀏覽量

211578 -

AI

+關注

關注

87文章

30728瀏覽量

268886 -

NPU

+關注

關注

2文章

279瀏覽量

18582 -

大模型

+關注

關注

2文章

2423瀏覽量

2640

發布評論請先 登錄

相關推薦

怎樣將matlab中的數學模型封裝成物理電氣模型

在PCB中怎樣快捷地將器件從頂層移到底層

上海:PC底層驅動工程師

Android手機操控ARM開發板外圍硬件設備【創科之龍】(2016年最給力!原創)

芯齊齊PC版還是移動版好用一點

怎樣才能得到LTC6090的PSpice模型?如何將模型從LTspice導出到PSpice?

以MINIPC為中心,創盈芯與時代同行

芯海科技2023PC新品全芯發布 四顆EC新品重磅首發

我們需要怎樣的大模型?

將大模型裝進PC和手機,需要怎樣的底層創“芯”?

將大模型裝進PC和手機,需要怎樣的底層創“芯”?

評論