芝能科技出品

隨著全球對人工智能(AI)的需求不斷增長,數據中心作為AI計算的重要基礎設施,其網絡架構與連接技術的發展變得尤為關鍵。

本文將簡述數據中心網絡架構的演變及其在AI應用中的重要性,并探討兩種主流網絡架構——InfiniBand和RoCEv2。

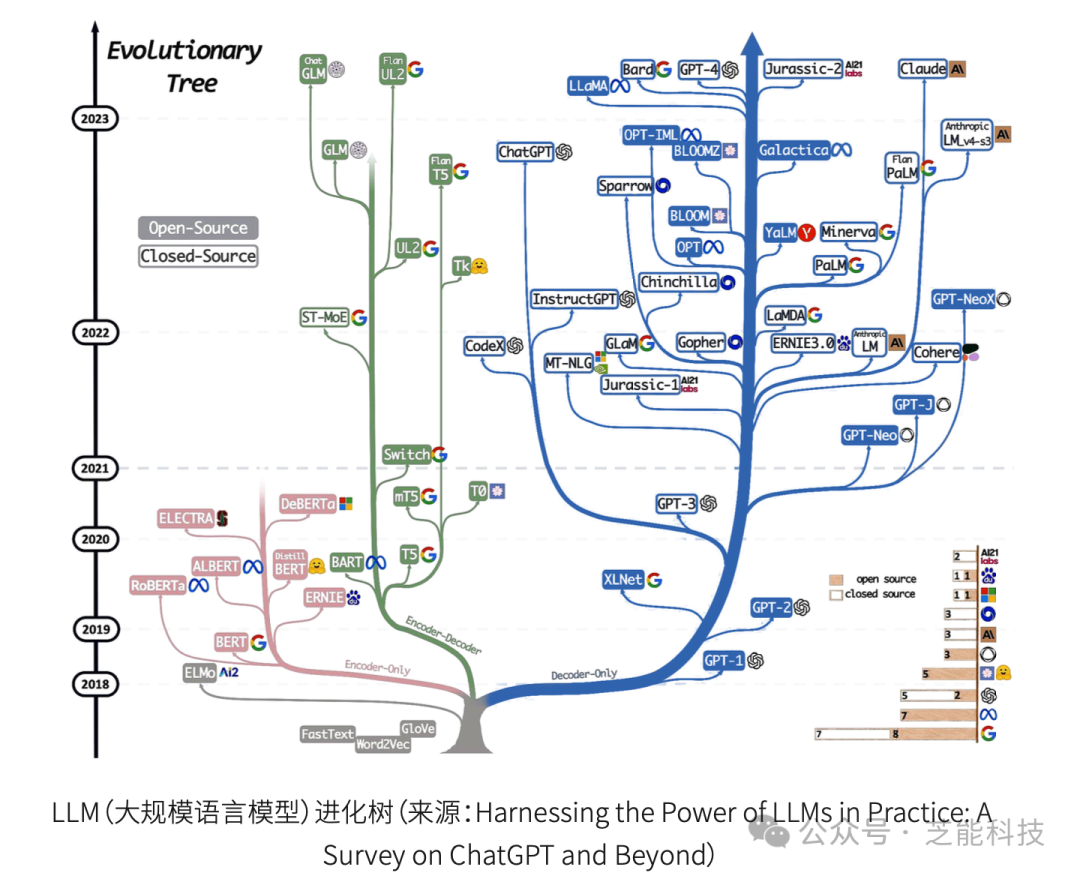

AI生成內容(AIGC)市場在2024年迎來了爆發式增長。OpenAI發布的Sora和國內的Kimi大模型引領了這一潮流。

預計到2024年,全球對AIGC解決方案的投資將達到200億美元,并在2027年超過1400億美元。這種增長對AI網絡架構提出了更高的要求,因其需要支撐大規模AI模型的訓練和推理。

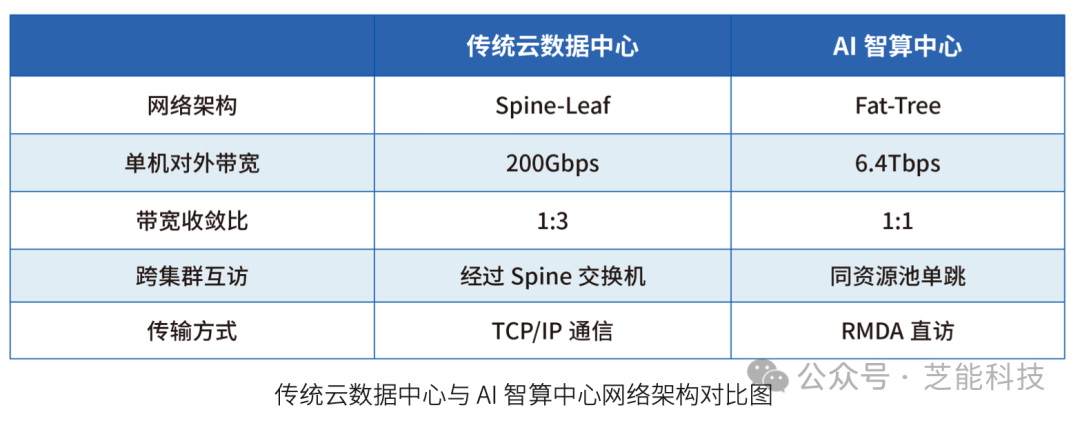

01 傳統云計算與AI智算中心網絡架構對比

●傳統云計算數據中心網絡架構

傳統云計算數據中心主要基于南北向流量模型設計,即對外提供服務的流量較大,而內部東西向流量較小。

這種架構存在一些不足,例如高帶寬收斂比、較高的互訪時延和網卡帶寬低。這些問題導致傳統架構無法滿足AI計算對高帶寬和低時延的要求。

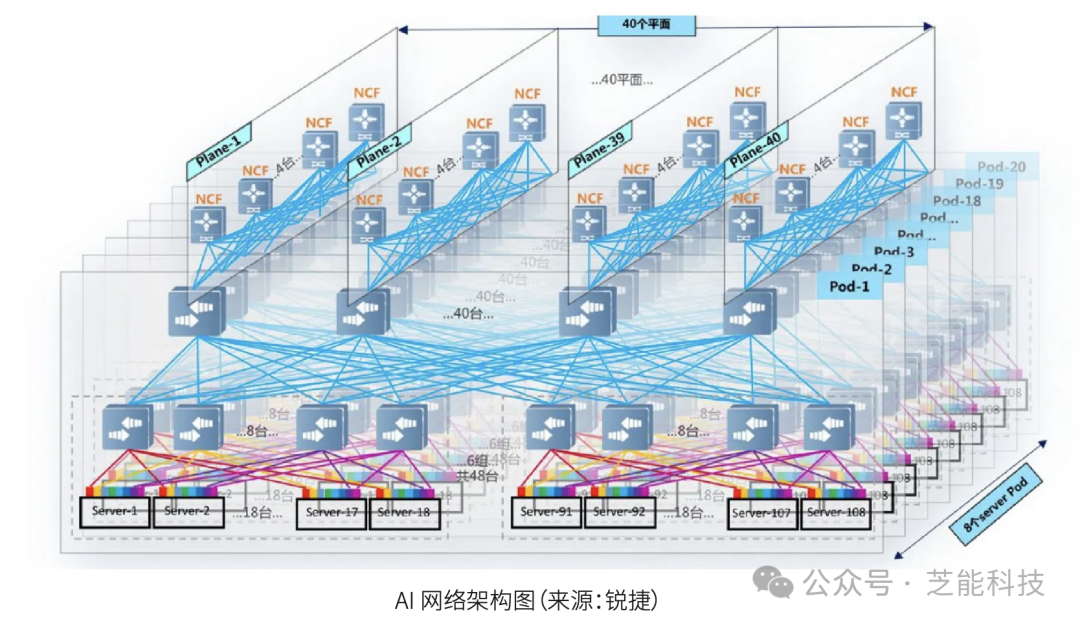

●AI智算中心網絡架構

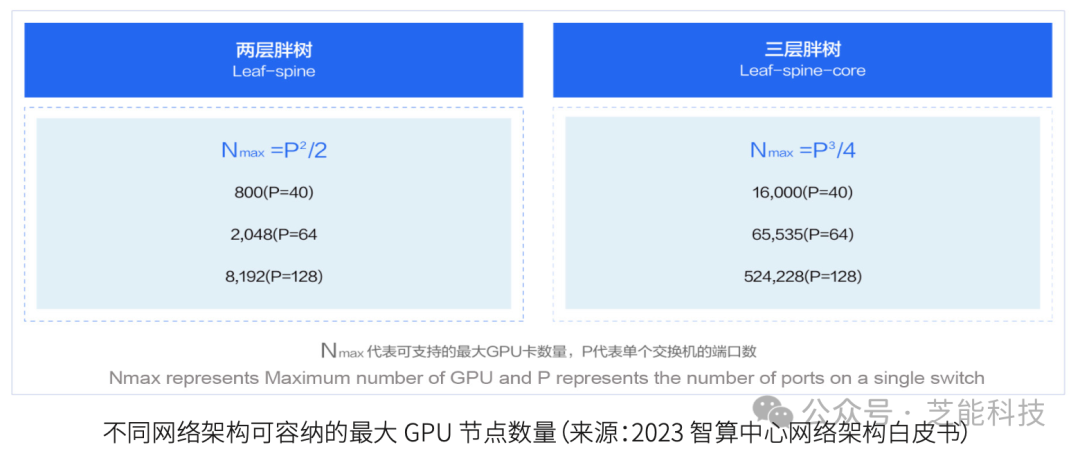

AI智算中心通常采用Fat-Tree(胖樹)架構,通過1:1的無收斂配置,確保了高性能和無阻塞傳輸。此架構能夠有效降低時延,并支持大規模GPU集群。

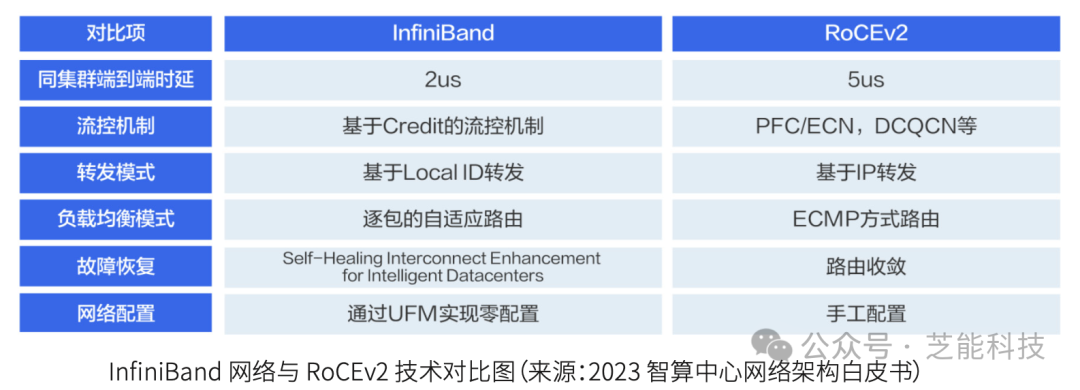

此外,AI網絡架構中常用的RDMA技術,允許主機之間直接內存訪問,顯著降低了同集群內部的時延,提高了網絡性能。

02 AI智算網絡的兩大主流架構

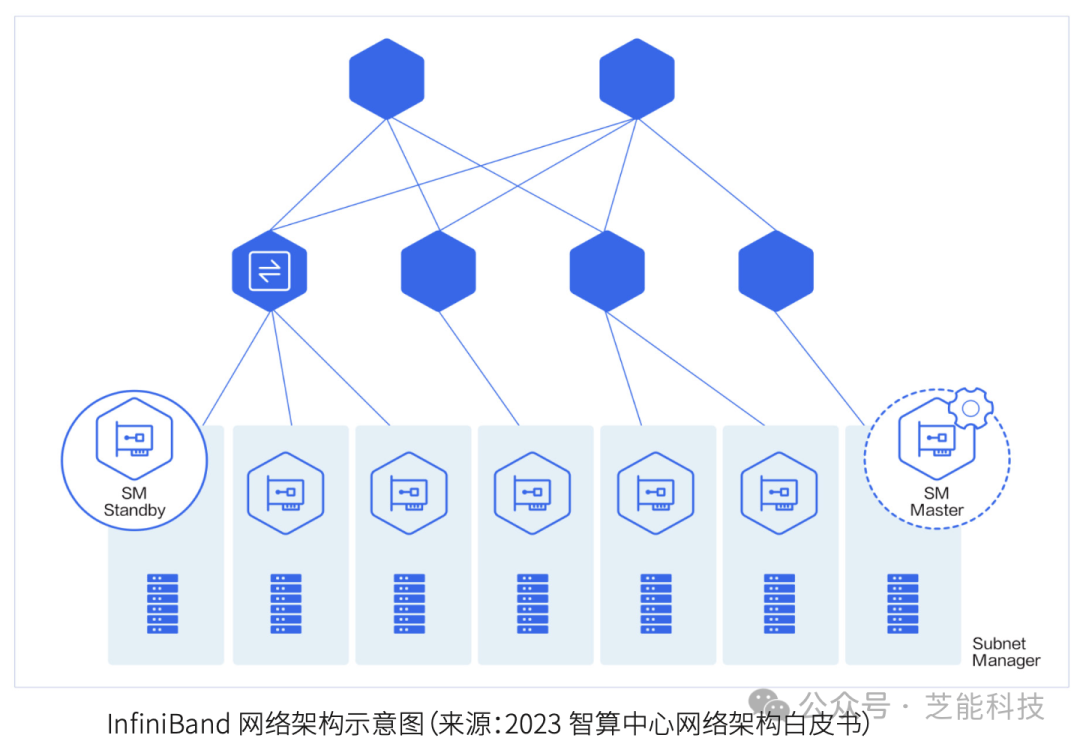

●InfiniBand網絡架構

InfiniBand網絡通過子網管理器(SM)進行集中管理,使用信用令牌機制確保數據在有足夠緩沖區時才發送,從而避免數據丟包。其自適應路由技術能夠根據數據包情況動態選擇路徑,實現最佳負載均衡。

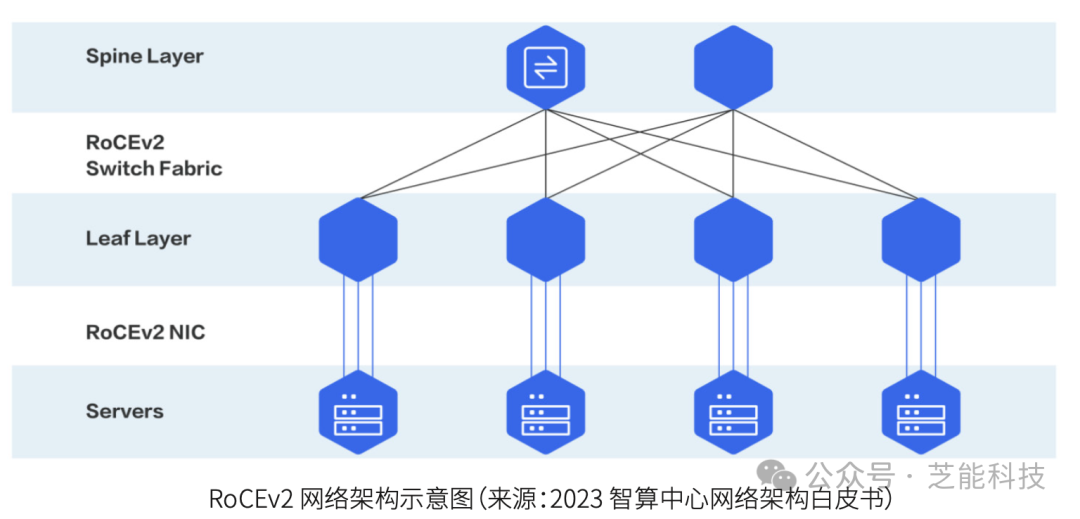

●RoCEv2網絡架構

RoCEv2(RDMA over Converged Ethernet)采用以太網和UDP傳輸層,具有更好的可擴展性和部署靈活性。其流控機制包括優先流控制(PFC)和顯式擁塞通知(ECN),結合數據中心量化擁塞通知(DCQCN),能夠在保持網絡高效運行的同時避免數據丟失。

隨著AI計算需求的增加,800G和1.6T的主流傳輸方案逐漸成為市場熱點。

這些方案在實際應用中,尤其是單模傳輸和預端接技術方面,提供了創新的解決方案。

同時,為應對高能耗高熱量問題,液冷解決方案也在AI數據中心得到廣泛應用。

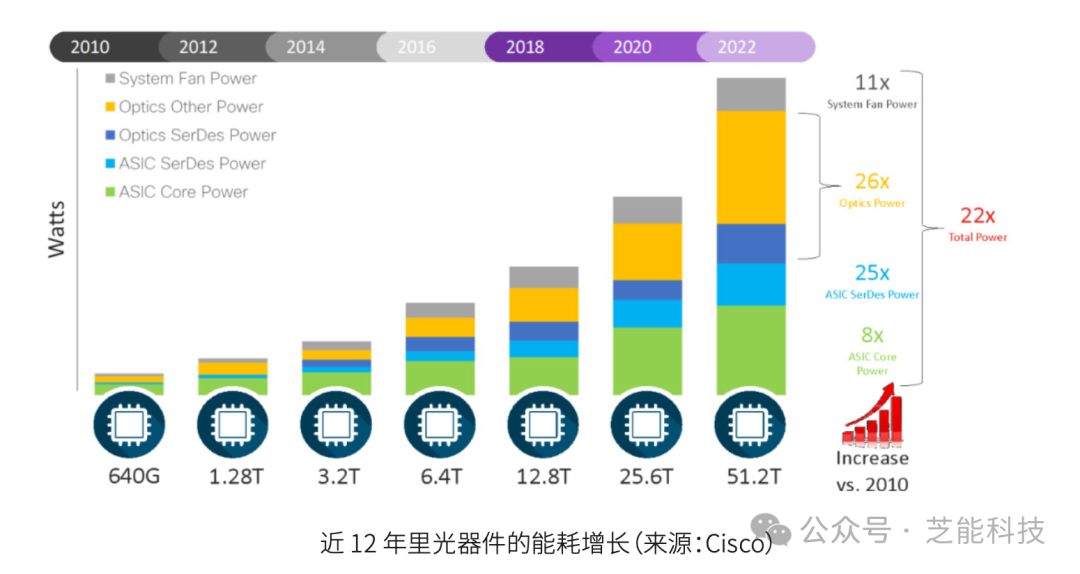

隨著光模塊技術向 400G 及更高速率邁進,挑戰不單是提升數據傳輸速度,還包括功耗和成本。

從 2007 年的 10G 光模塊僅需 1W 功率,到如今 400G 及 800G光模塊功耗接近 30W,隨著速率的每一次迭代,功耗也相應攀升。

在滿載狀態下,一個交換機可能搭載多達數十個光模塊,48 個光模塊的總功耗可達 1440W,而光模塊通常占整機功耗的 40%以上,導致整個智算中心的能耗可能超過 3000W。

液冷技術因其高導熱性能和高效散熱能力,已成為降低網絡系統能源功耗的廣泛認可解決方案,特別適用于高功率密度數據中心,但需解決冷卻液腐蝕性和壓強差等挑戰以確保系統安全。

小結

AI智算數據中心的網絡架構和連接技術正朝著更高效、更低時延和更高帶寬的方向發展。無論是InfiniBand還是RoCEv2,這些技術的進步都在為AI的發展提供堅實的基礎。

在未來,隨著技術的不斷創新,AI智算網絡架構將進一步優化,推動AI應用的廣泛普及和深入發展。

-

數據中心

+關注

關注

16文章

4761瀏覽量

72033 -

AI

+關注

關注

87文章

30728瀏覽量

268886 -

網絡架構

+關注

關注

1文章

93瀏覽量

12581

原文標題:數據中心的網絡架構及連接技術

文章出處:【微信號:QCDZSJ,微信公眾號:汽車電子設計】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

簡述數據中心網絡架構的演變

簡述數據中心網絡架構的演變

評論