導(dǎo)讀

2023年以ChatGPT為代表的大語言模型橫空出世,它的出現(xiàn)標(biāo)志著自然語言處理領(lǐng)域取得了重大突破。它在文本生成、對(duì)話系統(tǒng)和語言理解等方面展現(xiàn)出了強(qiáng)大的能力,為人工智能技術(shù)的發(fā)展開辟了新的可能性。同時(shí),人工智能技術(shù)正在進(jìn)入各種應(yīng)用領(lǐng)域,在智慧城市、智能制造、智慧醫(yī)療、智慧農(nóng)業(yè)等領(lǐng)域發(fā)揮著重要作用。

柴火創(chuàng)客2024年將依托母公司Seeed矽遞科技在人工智能領(lǐng)域的創(chuàng)新硬件,與全球創(chuàng)客愛好者共建“模型倉”,通過“SenseCraft AI”平臺(tái)可以讓使用者快速部署應(yīng)用體驗(yàn)人工智能技術(shù)!

本期介紹:模型案例:|花卉分類識(shí)別模型!

FCOS

FCOS?(Fully Convolutional One-Stage Object Detection)是一種基于全卷積的單階段目標(biāo)檢測算法,它是一種無Anchor box的算法,實(shí)現(xiàn)了無Anchor、無Proposal,并且提出了Center-ness的思想,極大地提升了Anchor-Free目標(biāo)檢測算法的性能。

FCOS的優(yōu)點(diǎn)包括避免了Anchor Box帶來的復(fù)雜計(jì)算,如計(jì)算重合度IoU,避免了Anchor Box相關(guān)的超參數(shù)設(shè)置,這些設(shè)置對(duì)性能影響較大。

因此,F(xiàn)COS可以與其他使用FCN結(jié)構(gòu)的任務(wù)相統(tǒng)一,方便其他任務(wù)方法之間的re-use,減少了超參數(shù)數(shù)量,更簡單,同時(shí)也減少了計(jì)算復(fù)雜度,如IoU計(jì)算。

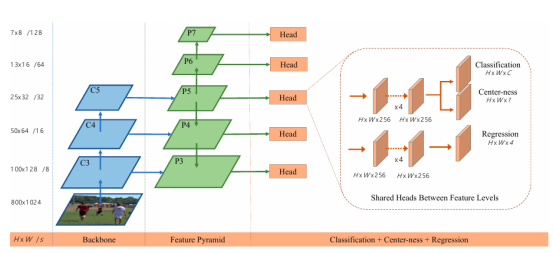

FCOS網(wǎng)絡(luò)結(jié)構(gòu)

FCOS的網(wǎng)絡(luò)結(jié)構(gòu)主要由三部分組成:Backbone、FPN(Feature Pyramid Networks)和Classification+Center-ness+Regression Head。

Backbone

Backbone是FCOS網(wǎng)絡(luò)的特征提取部分,通常采用深度卷積神經(jīng)網(wǎng)絡(luò)(如ResNet、VGG等)來提取圖像的多尺度特征。這些特征圖不僅包含了豐富的語義信息,還保留了足夠的空間信息,為后續(xù)的目標(biāo)檢測提供了有力的支持。

在FCOS中,Backbone輸出的特征圖尺寸逐層減半,形成金字塔結(jié)構(gòu)。對(duì)于特征圖上的每一個(gè)點(diǎn)(x, y),其映射回原圖的坐標(biāo)可以通過公式(?s/2?+xs, ?s/2?+ys)計(jì)算得到,其中s為特征圖相對(duì)于原圖的下采樣倍數(shù)。這種映射關(guān)系使得FCOS能夠直接利用特征圖上的點(diǎn)進(jìn)行目標(biāo)預(yù)測,而無需預(yù)設(shè)Anchor boxes。

FPN

FPN(Feature Pyramid Networks)是一種用于多尺度目標(biāo)檢測的網(wǎng)絡(luò)結(jié)構(gòu),它通過融合不同尺度的特征圖來增強(qiáng)網(wǎng)絡(luò)對(duì)不同尺寸目標(biāo)的檢測能力。在FCOS中,F(xiàn)PN同樣扮演著重要的角色。

與Anchor Based的檢測器不同,F(xiàn)COS通過限制不同層級(jí)特征圖上的邊界框回歸范圍來分配檢測任務(wù)。具體來說,F(xiàn)COS將每個(gè)特征圖上的點(diǎn)分配給其最近的目標(biāo)(如果存在的話),并根據(jù)目標(biāo)的大小將其分配到不同的特征層級(jí)上。這種分配策略不僅提高了檢測效率,還使得網(wǎng)絡(luò)能夠更專注于處理與其層級(jí)相匹配的目標(biāo)尺寸。

Classification+Center-ness+Regression Head

在FCOS中,每個(gè)特征圖上的點(diǎn)都被視為一個(gè)潛在的訓(xùn)練樣本,用于進(jìn)行目標(biāo)分類、Center-ness預(yù)測和邊界框回歸。為了實(shí)現(xiàn)這些任務(wù),F(xiàn)COS在特征圖后接入了三個(gè)并行的卷積頭:Classification Head、Center-ness Head和Regression Head。

Classification Head:用于預(yù)測特征圖上每個(gè)點(diǎn)所屬的目標(biāo)類別。在訓(xùn)練過程中,只有當(dāng)特征點(diǎn)位于某個(gè)目標(biāo)的有效區(qū)域內(nèi)時(shí)(即與目標(biāo)的邊界框有足夠的重疊),才會(huì)被標(biāo)記為正樣本并參與分類訓(xùn)練。否則,該點(diǎn)被視為負(fù)樣本。

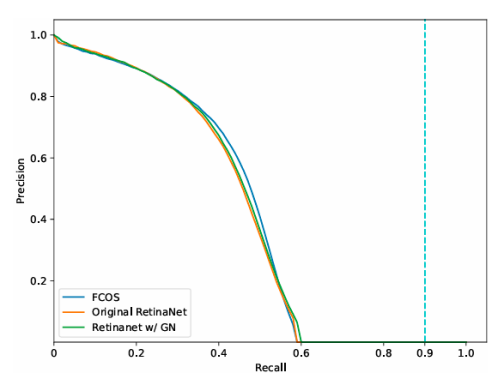

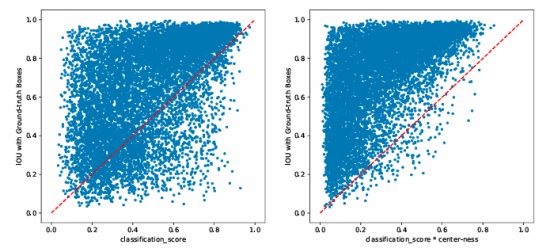

Center-ness Head:是FCOS的一個(gè)創(chuàng)新點(diǎn),用于預(yù)測特征點(diǎn)上目標(biāo)中心區(qū)域的相對(duì)位置。具體來說,Center-ness是一個(gè)0到1之間的值,表示該點(diǎn)到其所屬目標(biāo)中心的距離遠(yuǎn)近。在訓(xùn)練過程中,Center-ness的值會(huì)根據(jù)點(diǎn)到目標(biāo)中心的距離進(jìn)行計(jì)算和標(biāo)注。在推理過程中,Center-ness的值會(huì)與分類得分相乘作為最終的預(yù)測得分,以降低遠(yuǎn)離目標(biāo)中心的預(yù)測框的得分從而提高檢測性能。

Regression Head:用于預(yù)測特征圖上每個(gè)點(diǎn)到其所屬目標(biāo)邊界框四條邊的距離。與許多Anchor-based的方法不同,F(xiàn)COS直接回歸這些距離值而無需預(yù)設(shè)Anchor boxes。這種回歸方式不僅簡化了檢測流程還減少了計(jì)算量。·

FCOS性能優(yōu)勢

減少了計(jì)算復(fù)雜度,由于摒棄了Anchor boxes機(jī)制FCOS避免了與之相關(guān)的復(fù)雜計(jì)算如計(jì)算重合度IoU等從而減少了計(jì)算量提高了檢測效率。同時(shí)FCOS還減少了與Anchor相關(guān)的超參數(shù)數(shù)量簡化了算法設(shè)計(jì)并降低了超參數(shù)調(diào)整的難度。

提高了檢測精度,通過引入Center-ness優(yōu)化機(jī)制FCOS能夠降低遠(yuǎn)離目標(biāo)中心的預(yù)測框的得分從而提高檢測精度。此外FCOS還采用了多尺度預(yù)測與層級(jí)分配策略來處理不同尺寸的目標(biāo)進(jìn)一步提高了檢測性能。

增強(qiáng)了與其他任務(wù)的兼容性,由于FCOS采用了全卷積網(wǎng)絡(luò)結(jié)構(gòu)因此它可以與其他使用FCN結(jié)構(gòu)的任務(wù)相統(tǒng)一方便其他任務(wù)方法之間的re-use。這種兼容性不僅有助于實(shí)現(xiàn)多任務(wù)學(xué)習(xí)還能夠促進(jìn)不同領(lǐng)域之間的知識(shí)共享和遷移學(xué)習(xí)。

花卉分類識(shí)別模型

該模型用來檢測花卉,可以識(shí)別郁金香(tulips)、向日葵(sunflowers)和粉玫瑰(roses)三種花卉。

花卉識(shí)別數(shù)據(jù)集

數(shù)據(jù)集下載地址

在Grove - VisionAIV2模塊上訓(xùn)練和部署模型

SenseCraft Al平臺(tái)提供和簡單、方便的AI模型訓(xùn)練和部署功能,可以讓技術(shù)小白也能快速進(jìn)行特定場景的AI模型訓(xùn)練和部署。

1、打開SenseCraft AI平臺(tái),如果第一次使用請(qǐng)先注冊一個(gè)會(huì)員賬號(hào),還可以設(shè)置語言為中文,在頂部菜單欄單擊【模型訓(xùn)練】選項(xiàng),如下圖所示。

平臺(tái)地址:https://sensecraft.seeed.cc/ai/#/model

2、進(jìn)入【模型訓(xùn)練】頁面后單擊左側(cè)的【分類識(shí)別類別】選項(xiàng),如下圖所示。

3、單擊Class1和Class2右邊的修改分類名稱圖標(biāo),修改兩個(gè)類別名稱為roses(粉玫瑰)和sunflowers(向日葵)兩個(gè)圖像分類類別,再單擊底部的“添加類別”選項(xiàng)并修改類別名稱為tulips(郁金香),如下圖所示。

4、在每個(gè)分類選項(xiàng)中,單擊右邊的【...】圖標(biāo),單擊【導(dǎo)入圖片】打開導(dǎo)入圖像窗口,將下載好的數(shù)據(jù)圖片導(dǎo)入到每個(gè)類別中,這樣就導(dǎo)入了一定數(shù)量的數(shù)據(jù)集(至少100張),如下圖所示。

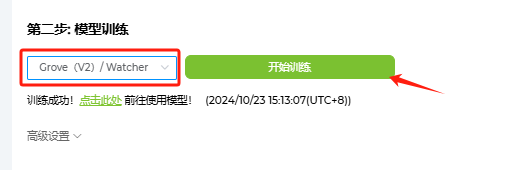

5、接著進(jìn)行第二步:模型訓(xùn)練,先選中“Grove(V2)”然后單擊【開始訓(xùn)練】按鈕,如下圖所示。經(jīng)過一段時(shí)間的訓(xùn)練后,即可生成花卉分類圖像識(shí)別模型。

6、第三步是部署,先選中“Grove(V2)”選項(xiàng),單擊【部署到設(shè)備】如下圖所示,按提示連接Grove vision AI V2硬件后開始進(jìn)行模型部署。

7、部署完成后進(jìn)入工作窗口,這時(shí)會(huì)打開攝像頭預(yù)覽功能,對(duì)郁金香(tulips)、向日葵(sunflowers)和粉玫瑰(roses)圖像,預(yù)覽窗口底部會(huì)看到預(yù)測的類別名稱和置信率,如下圖所示。

推理結(jié)果演示

Grove Al視覺模塊 V2套裝介紹

Grove Al視覺模塊 V2

OV5647-62攝像頭

Grove - Vision Al Module V2是一款拇指大小的人工智能視覺模塊, 配備Himax WiseEye2 HX6538處理器和Arm Ethos-U55嵌入式神經(jīng)網(wǎng)絡(luò)加速單元(NPU), 該處理器采用 ArmCortex-M55雙核架構(gòu)。

Arm Ethos-U55 嵌入式神經(jīng)網(wǎng)絡(luò)處理器(NPU)

嵌入式神經(jīng)網(wǎng)絡(luò)處理器(NPU)是一種特別設(shè)計(jì)用于執(zhí)行神經(jīng)網(wǎng)絡(luò)計(jì)算的高效率處理器。它主要基于數(shù)據(jù)驅(qū)動(dòng)并行計(jì)算架構(gòu),特別擅長處理視頻、圖像等大量的多媒體數(shù)據(jù)。NPU模仿了生物神經(jīng)網(wǎng)絡(luò)的架構(gòu),與CPU、GPU相比,它能夠通過更少的指令(一條或幾條)完成神經(jīng)元的處理,因此在深度學(xué)習(xí)的處理效率方面具有明顯優(yōu)勢。

它具有標(biāo)準(zhǔn)的CSI接口, 并與樹莓派相機(jī)兼容。它有一個(gè)內(nèi)置的數(shù)字麥克風(fēng)和SD卡插槽。它非常適用于各種嵌入式視覺項(xiàng)目。

有了SenseCraft Al算法平臺(tái), 經(jīng)過訓(xùn)練的ML模型可以部署到傳感器, 而不需要編碼。它兼容XIAO系列和Arduino生態(tài)系統(tǒng), 是各種物體檢測應(yīng)用的理想選擇。

主要硬件配置

- 板卡基于WiseEye2 HX6538處理器, 采用雙核ARM Cortex-M55架構(gòu)

- 配備集成Arm Ethos-U55嵌入式神經(jīng)網(wǎng)絡(luò)處理器(NPU), 兼容的樹莓派相機(jī)

- 板載PDM麥克風(fēng), SD卡插槽, Type-C, Grove接口, 豐富的外設(shè)支持樣機(jī)開發(fā)

- Seeed Studio XIAO的可擴(kuò)展性, SenseCraft Al的現(xiàn)成AI模型用于無代碼部署。

- 支持各種有效的模型, 包括MobilenetV1、MobilenetV2、 Eficientnet-Lite、Yolov5和Yolov8.

寫在最后

SenseCraft-AI平臺(tái)的模型倉數(shù)量還很少,但是好消息是它支持自定義模型上傳并輸出推理結(jié)果,平臺(tái)會(huì)逐漸增加模型倉的數(shù)量和分享愛好者設(shè)計(jì)的模型倉原型,敬請(qǐng)關(guān)注!

-

人工智能

+關(guān)注

關(guān)注

1804文章

48418瀏覽量

244699 -

模型

+關(guān)注

關(guān)注

1文章

3462瀏覽量

49782 -

目標(biāo)檢測

+關(guān)注

關(guān)注

0文章

220瀏覽量

15840 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1584瀏覽量

8646

原文標(biāo)題:模型案例:| 花卉分類識(shí)別模型!

文章出處:【微信號(hào):ChaiHuoMakerSpace,微信公眾號(hào):柴火創(chuàng)客空間】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

基于隱馬爾可夫模型的音頻自動(dòng)分類

【GoKit申請(qǐng)】智能花卉澆水系統(tǒng)

Edge Impulse的分類模型淺析

多分類器融合行為識(shí)別模型

一種新的目標(biāo)分類特征深度學(xué)習(xí)模型

評(píng)論