人類和動物在學(xué)習(xí)新行為時,大部分只需要觀察一次就能學(xué)會,然而想讓機(jī)器人學(xué)習(xí)就沒那么容易了。隨著計算機(jī)視覺的發(fā)展,目前的技術(shù)能讓機(jī)器人依靠人體姿勢檢測系統(tǒng),模仿人類的動作進(jìn)行學(xué)習(xí)。不過每次都需要人類“做示范”未免有些麻煩,本篇論文的研究人員們想出了新方法:讓機(jī)器人通過一段只有一個人的視頻來模仿學(xué)習(xí)。

此前的研究表明,機(jī)器人能通過觀察示范學(xué)習(xí)一系列復(fù)雜的技能,例如倒水、打乒乓球、打開抽屜等。然而,機(jī)器人模仿最有效的方法與人類學(xué)習(xí)有很大的不同:機(jī)器人通常需要接到具體的動作示范或遙控操作,人類只需看別人做一遍就能了解。另外,人類還能根據(jù)環(huán)境變化改變策略,適應(yīng)新情況。所以,我們怎樣能讓機(jī)器人像人類一樣,通過觀察第三方示范進(jìn)行學(xué)習(xí)?

從原始視頻中獲得技能存在兩大挑戰(zhàn)。首先,人類演示者和機(jī)器人的外觀及形態(tài)的差異會帶來系統(tǒng)性的域轉(zhuǎn)移(domain shift),即對應(yīng)問題(correspondence problem)。其次,從原始視覺輸入中學(xué)習(xí)通常需要大量數(shù)據(jù),深度學(xué)習(xí)視覺系統(tǒng)一般要使用數(shù)十萬至數(shù)百萬的圖像。而在本文中,我們展示了通過基于元學(xué)習(xí)的單一方法解決這兩個挑戰(zhàn)。

前期準(zhǔn)備

該方法建立在之前的工作成果或者元學(xué)習(xí)的基礎(chǔ)上,我們將對模型元學(xué)習(xí)算法進(jìn)行擴(kuò)展,它能夠處理提供的數(shù)據(jù)(即人類演示)和評估設(shè)置(即機(jī)器人動作)之間的域轉(zhuǎn)移。

元學(xué)習(xí)算法能快速有效地學(xué)習(xí)新任務(wù),一般來說,元學(xué)習(xí)可以看作是發(fā)現(xiàn)任務(wù)之間存在的結(jié)構(gòu)的功能。當(dāng)模型從元測試集中提出新任務(wù)時,模型可以使用已知結(jié)構(gòu)快速學(xué)習(xí)。算法(MAML)通過對深度網(wǎng)絡(luò)的初始參數(shù)設(shè)置進(jìn)行優(yōu)化來實現(xiàn)這一點。在元訓(xùn)練之后,根據(jù)新任務(wù)的數(shù)據(jù)對學(xué)習(xí)參數(shù)進(jìn)行微調(diào)。

模仿人類

在這一部分,我們將說明機(jī)器人一次性模仿人類學(xué)習(xí)的問題,并介紹我們的試驗方法。從含有人類的視頻中進(jìn)行學(xué)習(xí)可以看做是一個推理問題,其目標(biāo)是推斷機(jī)器人的策略參數(shù),它能將先驗知識與少量證據(jù)結(jié)合來完成任務(wù)。為了從只有一個人的視頻中有效學(xué)習(xí),我們需要包含著對世界有著豐富視覺和物體理解的先驗知識。

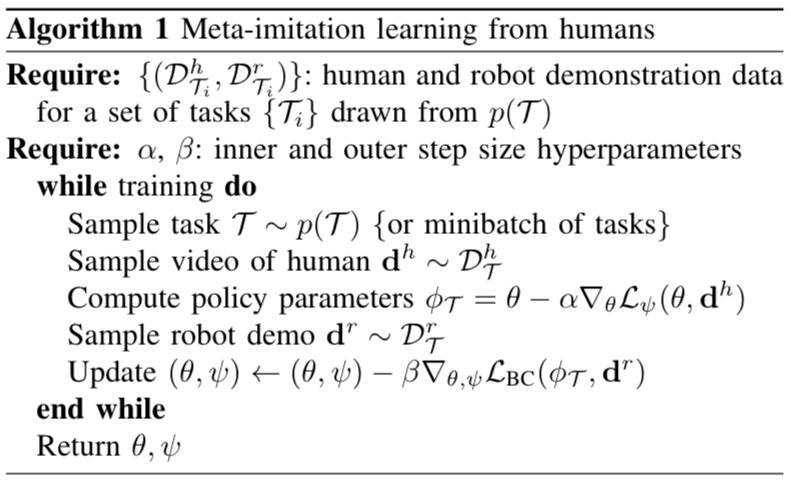

而試驗方法包括兩個階段,在元訓(xùn)練階段,我們需要利用人類和機(jī)器人的動作數(shù)據(jù)獲取先驗知識,然后通過快速學(xué)習(xí)模仿動作。這一方法的關(guān)鍵部分在于,它可以遷移到其他元學(xué)習(xí)算法中去。如MAML算法一樣,我們將學(xué)習(xí)一系列初始參數(shù),在經(jīng)歷過幾次梯度下降后,模型還能有效地完成新任務(wù)。最終用于元目標(biāo)的算法可以總結(jié)為:

在元訓(xùn)練階段之后,學(xué)習(xí)到的先驗知識將用于第二階段。當(dāng)機(jī)器人模仿人類的新動作時,必須將先驗知識與新的人類示范動作結(jié)合,來推斷解決新任務(wù)的策略參數(shù)。算法總結(jié)為:

時序適應(yīng)目標(biāo)學(xué)習(xí)

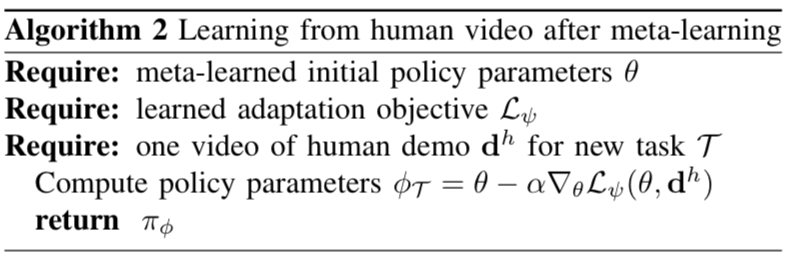

為了從人的視頻中學(xué)習(xí),我們需要一個適應(yīng)目標(biāo),可以有效地捕捉視頻中的相關(guān)信息,比如人的意圖和與任務(wù)有關(guān)的對象。由于時序卷積在處理時序和數(shù)據(jù)序列時是有用的,所以我們選擇用一個卷積網(wǎng)絡(luò)表示適應(yīng)目標(biāo)。效果如圖所示:

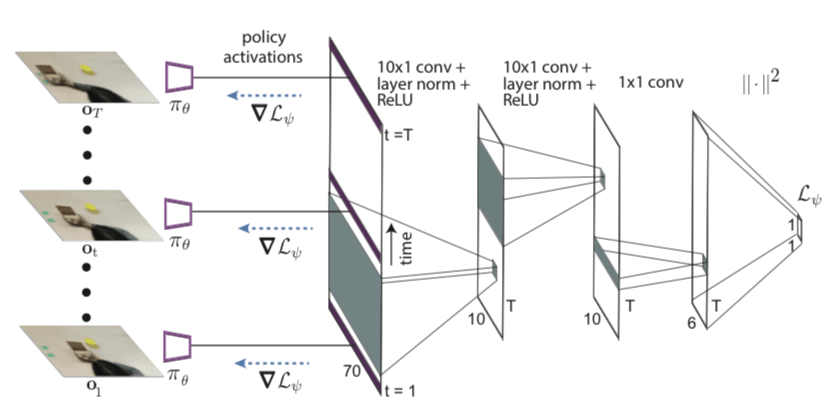

網(wǎng)絡(luò)架構(gòu)

如圖所示,網(wǎng)絡(luò)架構(gòu)是一個卷積神經(jīng)網(wǎng)絡(luò),將RGB圖像映射到動作分布。卷積網(wǎng)絡(luò)從幾個卷積層開始,然后被輸送到通道空間的argmax中,為每個通道提取二維特征點f。接著我們將這些特征點與機(jī)器人結(jié)構(gòu)連接在一起,該結(jié)構(gòu)包括夾具上的3個非軸對齊的點。然后,我們將連接的特征點和機(jī)器人姿態(tài)傳遞給多個完全連接層。

實驗過程

我們的實驗主要想解決三個問題:

我們的方法能否有效地學(xué)習(xí)先驗知識,讓機(jī)器人能夠通過僅有一人的視頻學(xué)習(xí)操作新物體?

我們的方法能否從新的角度讓機(jī)器人模仿人類動作?

我們所提出的方法與元學(xué)習(xí)方法以及其他方法有何不同?

為了進(jìn)一步了解我們的方法以及其實用性,我們還要另外評估:

時序適應(yīng)目標(biāo)有多重要?

我們的方法能否用于多個機(jī)器人平臺,以及用于動作或遙控示范的元訓(xùn)練?

為了進(jìn)行評估,我們在7軸的PR2機(jī)械臂和Sawyer機(jī)器人上進(jìn)行實驗。

PR2實驗過程

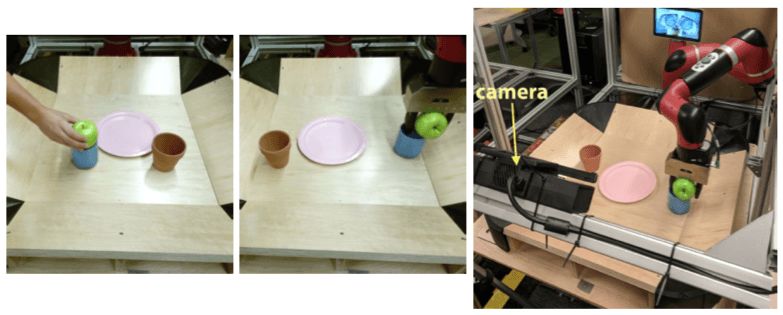

首先是用機(jī)械臂PR2進(jìn)行物體的放置、前推、撿拾等動作的測試,具體過程如圖:

從左至右分別是:物體放置、推動以及撿拾-放下動作。上面一排是人類示范

整個過程的裝置情況是這樣的:

用于拍攝的是一臺智能手機(jī),從中看到的情況是這樣的:

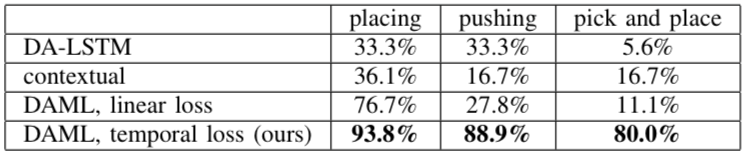

最后,PR2一次學(xué)習(xí)的評估情況展示在下表中,可以看到成功率大大高于之前的方法:

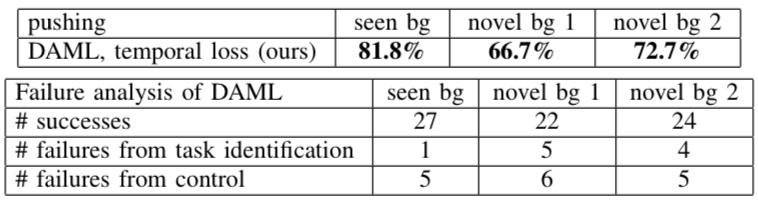

另外,研究人員還統(tǒng)計了PR2在做“推動”時發(fā)生的錯誤:

Sawyer實驗過程

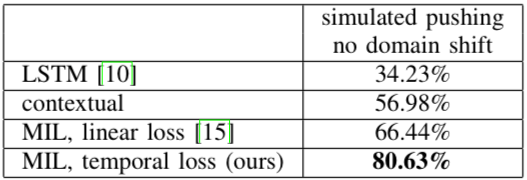

實驗的另一個目標(biāo)是我們的方法能否應(yīng)用于別的平臺上,于是我們選擇了7個自由度的Sawyer進(jìn)行驗證。不同與PR2實驗,動作空間將是末端執(zhí)行器的單個指令姿態(tài),我們將使用均方誤差作為外部的元目標(biāo)。

最終,在使用時序適應(yīng)目標(biāo)的實驗中,成功率比沒有使用的提高了14%,證明了從視頻中學(xué)習(xí)時融合時間信息的重要性。

實驗的局限性

雖然我們的工作成果能讓機(jī)器人從視頻中一次性學(xué)習(xí)操作新的物體,但是目前的實驗還沒有證明模型能夠一次性學(xué)習(xí)全新動作。希望未來有更多的數(shù)據(jù)和更高性能的模型能實現(xiàn)這一目標(biāo)。

-

機(jī)器人

+關(guān)注

關(guān)注

211文章

28380瀏覽量

206918 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5500瀏覽量

121113

原文標(biāo)題:利用自適應(yīng)域的元學(xué)習(xí)讓機(jī)器人一次學(xué)會人類動作

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

讓機(jī)器人通過一段只有一個人的視頻來模仿學(xué)習(xí)

讓機(jī)器人通過一段只有一個人的視頻來模仿學(xué)習(xí)

評論