得益于大數據的興起和計算能力的快速提升,機器學習技術近年來經歷了革命性的發展。諸如圖像分類、語音識別和自然語言處理等機器學習任務,都是對具有一定大小、維度和有序排列的歐幾里得數據進行處理。然而,在許多現實場景中,數據是由復雜的非歐幾里得數據(例如圖形)表示的。這些圖形不僅包含數據,還包含數據之間的依賴關系,例如社交網絡、蛋白質分子結構、電子商務平臺中的客戶數據等。數據復雜性的提升給傳統的機器學習算法設計及其實現技術帶來了嚴峻的挑戰。在這種情況下,許多全新的基于圖形的機器學習算法或圖神經網絡(GNN)不斷在學術界和工業界涌現。

GNN對計算能力和存儲有非常高的要求,而且其算法的軟件實現效率非常低。因此,業界對GNN的硬件加速有著非常迫切的需求。盡管傳統的卷積神經網絡(CNN)硬件加速有很多種解決方案,但GNN的硬件加速還沒有得到充分的討論和研究。在撰寫本白皮書時,谷歌(Google)和百度(Baidu)都無法搜索到關于GNN硬件加速的中文研究資料。本白皮書的寫作動機是將國外最新的GNN算法、對加速技術的研究以及對基于現場可編程邏輯門陣列(FPGA)的GNN加速技術的探討相結合,并以概述的形式呈現給讀者。

對圖神經網絡(GNN)的介紹

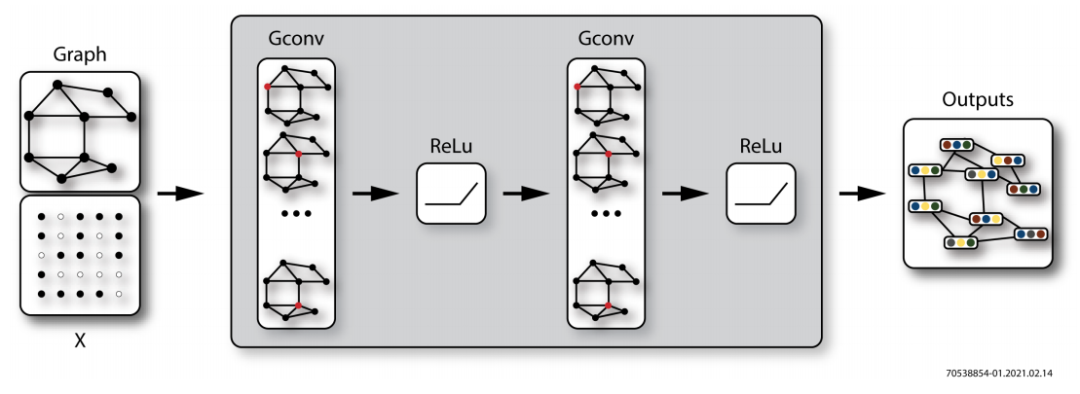

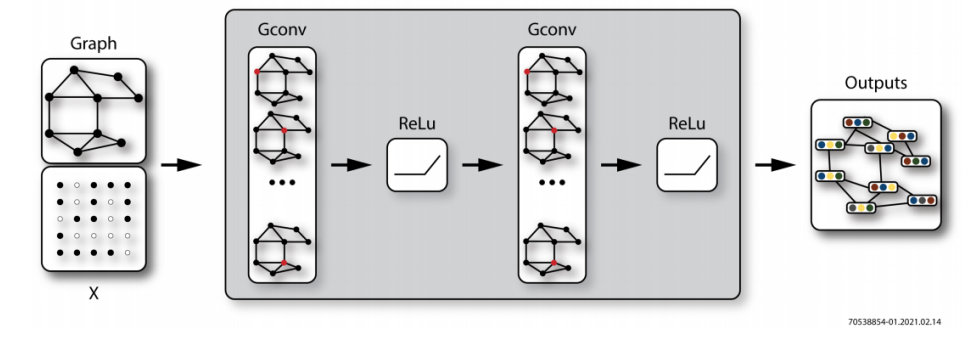

在宏觀層面上,GNN的架構與傳統CNN有很多相似之處,諸如卷積層、池化、激活函數、機器學習處理器(MLP)、全連接層(FC layer)等模塊,這些都可以應用到GNN。下圖展示了一個相對簡單的GNN架構。

圖1:典型的GNN架構(來源:https://arxiv.org/abs/1901.00596)

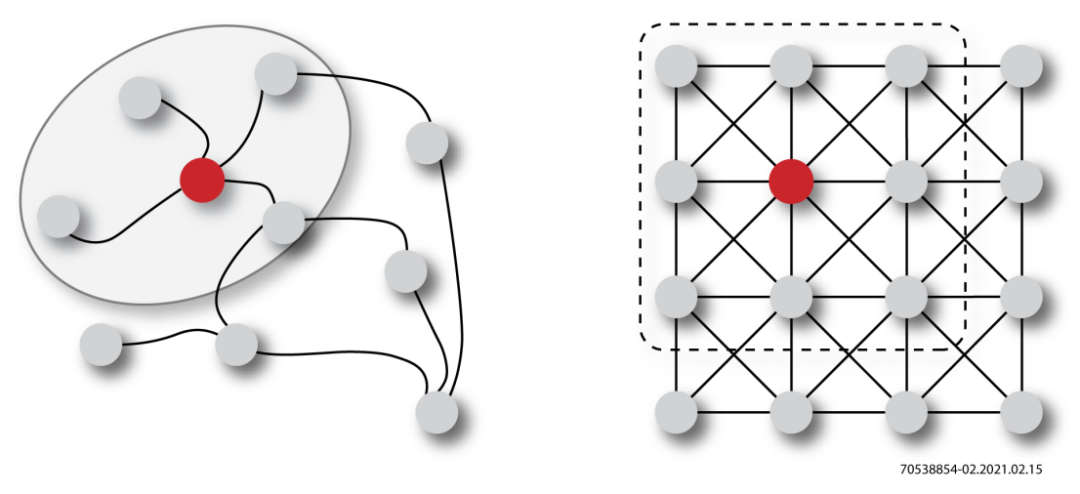

但是,GNN中的圖形數據卷積計算與傳統CNN中的二維卷積計算不同。以下圖為例,紅色目標節點的卷積計算過程如下所示:

1、圖卷積 - 使用近鄰函數對周圍節點的特征進行采樣,并計算平均值。相鄰節點的數量是不確定且無序的(非歐幾里得數據)

2、二維卷積——使用卷積核對周圍節點的特征進行采樣,并計算加權平均值。相鄰節點的數量是確定且有序的(歐幾里得數據)

圖2:圖卷積和二維卷積(來源:https://arxiv.org/abs/1901.00596)

對GraphSAGE算法的介紹

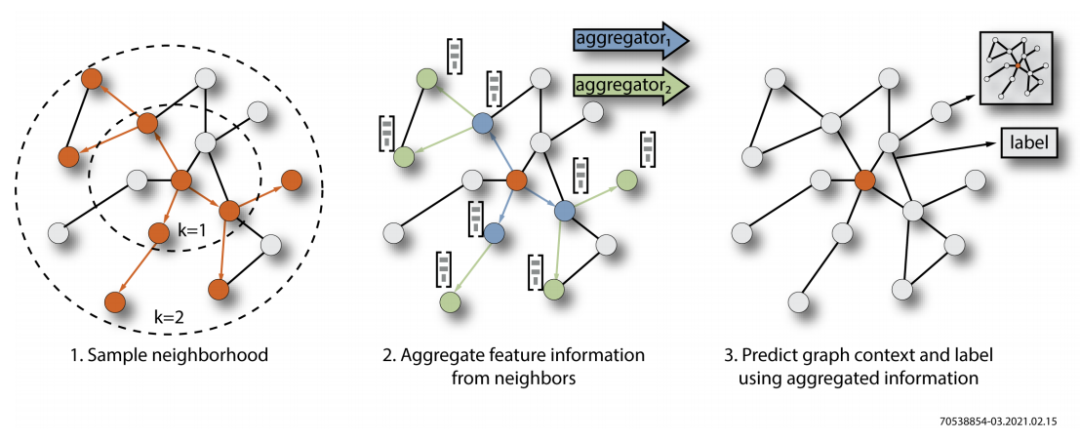

學術界對GNN算法進行了大量的研究和探討,提出了相當多的創新實現方法。其中,由斯坦福大學(Stanford University)于2017年提出的GraphSAGE是一種歸納表示學習算法,用于預測大規模圖中動態的、全新的、未知的節點類型,還專門針對節點數量龐大、節點特征豐富的圖進行了優化。如下圖所示,GraphSAGE算法的計算過程可以分為三個主要步驟:

1、相鄰節點采樣——用于降低復雜性,一般采樣兩層,每層采樣幾個節點。

2、聚合——用于嵌入目標節點,即圖的低維向量表示。

3、預測——使用嵌入作為全連接層的輸入,以預測目標節點d的標簽。

圖3:GraphSAGE算法的可視化表示(來源:http://snap.stanford.edu/graphsage)

1、樣本鄰域

2、聚合來自鄰域的特征信息

3、利用聚合信息預測圖形情況和標簽

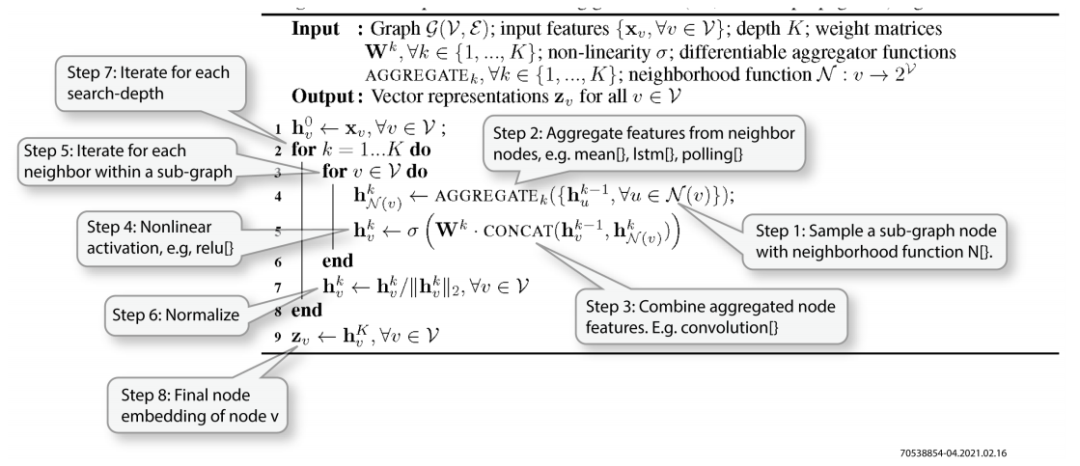

為了在FPGA中實現GraphSAGE算法加速,必須了解其數學模型,以便將算法映射到不同的邏輯模塊。下圖所示的代碼說明了該算法的數學過程。

圖4:GraphSAGE算法的數學模型(來源:http://snap.stanford.edu/graphsage)

步驟1:使用近鄰函數N[}對子圖節點進行采樣。

步驟2:聚合相鄰節點的特征,例如mean[}、lstm[}、polling[}

步驟3:合并聚合的節點特征。例如卷積[}

步驟4:非線性激活,例如relu[}

步驟5:使用子圖迭代每個鄰域

步驟6:標準化

步驟7:對每個深度搜索進行迭代

步驟8:節點v的最終節點嵌入

對于每個要處理的目標節點xv,GraphSAGE算法都會執行以下操作:

1、通過近鄰采樣函數N(v)對子圖中的節點進行采樣。

2、聚合要采樣的相鄰節點的特征。聚合函數可以是mean()、lstm()或polling()等。

3、將聚合結果與上一次迭代的輸出表示合并起來,并使用Wk進行卷積。

4、對卷積結果進行非線性處理。

5、多次迭代以結束當前第k層的所有相鄰節點的處理。

6、對第k層迭代的結果進行標準化處理。

7、多次迭代以結束對所有K層采樣深度的處理。

8、將最終的迭代結果zv嵌入到輸入節點xv。

GNN加速器設計所面臨的挑戰

GNN算法涉及大量的矩陣計算和存儲訪問操作。在傳統的x86架構服務器上運行這種算法的效率是非常低的,表現為速度慢、能耗高等。

新型圖形處理器(GPU)的應用可以顯著提高GNN的計算速度與能效比。但是,GPU在存儲可擴展性方面存在短板,使其無法處理圖形中的海量節點。GPU的指令執行方式也會導致計算延遲過大和不確定性;因此,它不適用于需要實時計算圖形的場景。

上面提到的各種設計挑戰,使得業界迫切需要一種能夠支持高并發、實時計算,擁有巨大存儲容量和帶寬,并可擴展到數據中心的GNN加速解決方案。

基于FPGA設計方案的GNN加速器

Achronix的Speedster?7t系列FPGA產品(以及該系列的第一款器件AC7t1500)是針對數據中心和機器學習工作負載進行了優化的高性能FPGA器件,消除了基于中央處理器(CPU)、GPU和傳統FPGA的解決方案中存在的若干性能瓶頸。Speedster7t系列FPGA產品采用了臺積電(TSMC)的7nm FinFET工藝,其架構采用了一種革命性的全新二維片上網絡(NoC)、獨創的機器學習處理器矩陣(MLP),并采用高帶寬GDDR6控制器、400G以太網和PCI Express Gen5接口,在確保ASIC級性能的同時,它為用戶提供了靈活的硬件可編程性。

下圖展示了高性能FPGA器件Speedster7t1500的架構。

圖5:Achronix高性能FPGA器件SpeedsterAC7t1500的架構

上述特點使Achronix Speedster7t1500器件成為應對在GNN加速器設計中面臨的各種挑戰的完美解決方案。

表1:GNN設計面臨的挑戰和Achronix Speedster7t1500 FPGA器件提供的解決方案

| GNN設計所面臨的挑戰 | Speedster AC7t1500器件提供的解決方案 |

| 高速矩陣運算 | 機器學習處理器(MLP) |

| 高帶寬和低延遲存儲 | LRAM+BRAM+GDDR6+DDR4。 |

| 高并發和低延遲計算 | FPGA使用可編程邏輯電路,以確保在硬件層面進行低并發和高并發延遲計算。 |

| 存儲擴展 | 基于4×400 Gbps的RDMA確保在數據中心以極低的延遲擴展存儲訪問。 |

| 算法不斷演進 | FPGA中的可編程邏輯確保算法可以在硬件層面進行升級和重新配置。 |

| 復雜的設計 | 豐富的硬IP減少開發時間、降低復雜性,NoC簡化模塊之間的互連并改善時序 |

-

FPGA

+關注

關注

1629文章

21729瀏覽量

602982 -

加速器

+關注

關注

2文章

796瀏覽量

37838 -

神經網絡

+關注

關注

42文章

4771瀏覽量

100712 -

機器學習

+關注

關注

66文章

8406瀏覽量

132558 -

Achronix

+關注

關注

1文章

76瀏覽量

22530

原文標題:白皮書:一種基于FPGA的圖神經網絡加速器解決方案(WP024)(第一部分)

文章出處:【微信號:Achronix,微信公眾號:Achronix】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一種基于FPGA的圖神經網絡加速器解決方案

基于FPGA的圖神經網絡加速器解決方案

基于FPGA的圖神經網絡加速器解決方案

評論