一、OrangePi Kunpeng Pro簡介

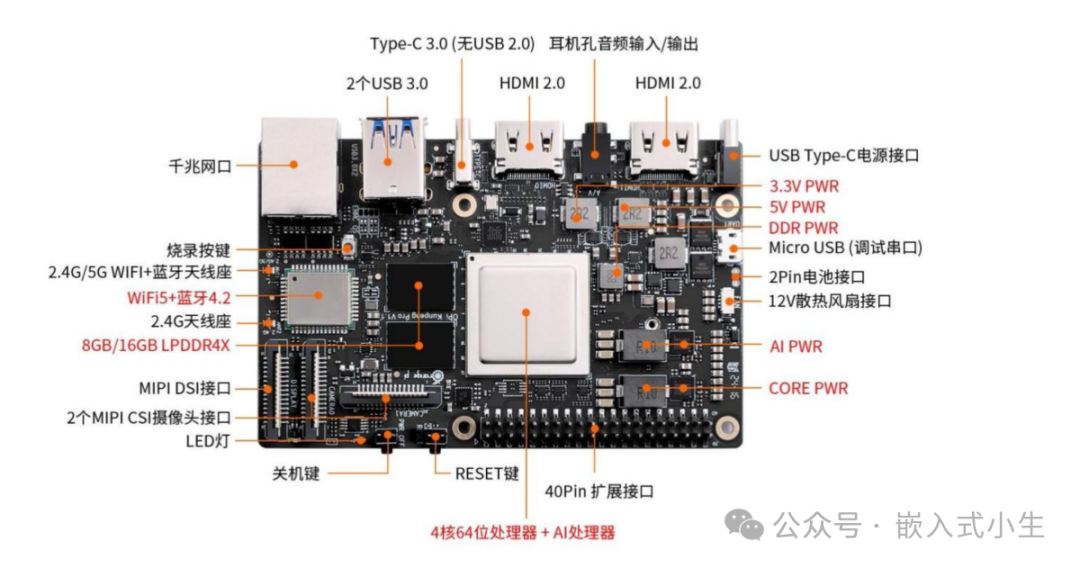

OrangePi Kunpeng Pro是一款香橙派聯合華為精心打造的高性能板卡,搭載了鯤鵬處理器,可提供8TOPS INT8計算能力,板卡設計很精致,板載資源也非常多:

?擁有以太網、Wi-Fi+藍牙功能,提供多種可選擇的網絡接入方式。

? 2個USB3.0 Host、1個支持USB3.0的Type-C接口:可接入鼠標、鍵盤、USB攝像頭等設備,方便板卡操作。

? 2個HDMI接口、1 個 MIPI DSI 2 Lane接口,提供兩種顯示方案。

?引出了40 pin 擴展口,可擴展UART、I2C、SPI、PWM 和 GPIO 等接口功能。板卡完整接口如下圖所示:

板卡擴展出的功能很多,能夠滿足很多應用場景和行業的開發需求,本文將描述使用OrangePi Kunpeng Pro來部署AI大模型,記錄分析模型運行期間板卡的狀態和模型運行效果。

二、環境搭建

(1)首先取出板卡,為板卡接入一個HDMI顯示屏、一個無線藍牙鼠標、一個有線鍵盤,接著接通電源,完成后如下圖所示:

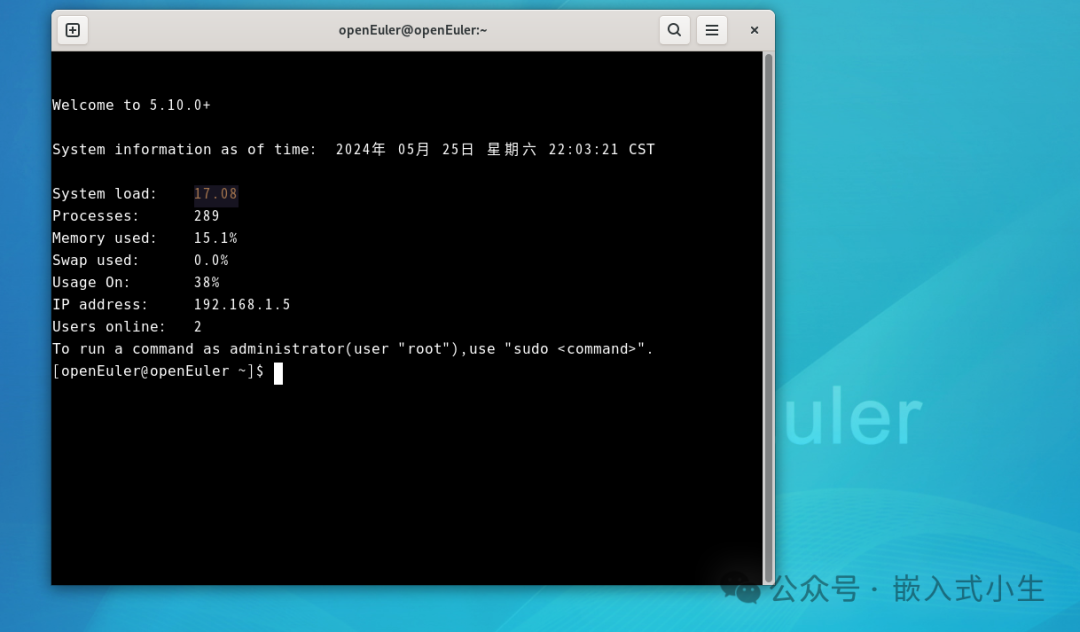

(2)隨后板卡將自動啟動運行openEuler操作系統,接著我們進入終端:

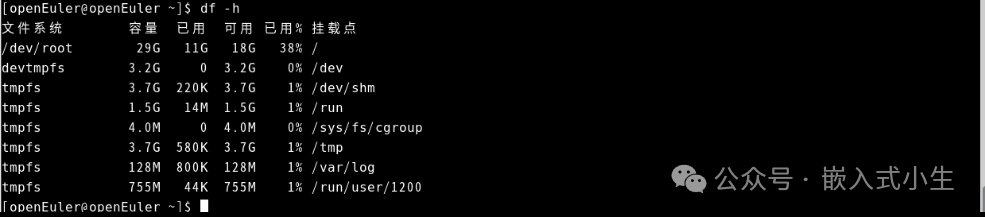

(3)查看下存儲容量:

從上圖可知目前可用容量很大,可滿足小量級離線模型的存儲。

板卡運行openEuler非常流暢,使用體驗感非常好。

(4)選擇網絡接入方式,本文使用Wifi接入。

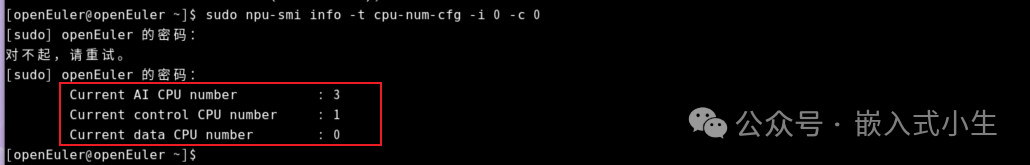

(5)更改CPU為AI CPU

從上圖中可知目前板卡有3個AI CPU和1個control CPU。

接著就進行模型運行環境搭建和模型部署了。

三、模型運行環境搭建

(1)下載Ollama用于啟動并運行大型語言模型

由于在線下載Ollama速度較慢,故而使用手動方式安裝Ollama,首先從下列地址下載Ollama:

https://ollama.com/download/ollama-linux-arm64

完成后將其通過ssh方式傳輸到板卡。接著將其重名為ollama,便于命令操作,然后將ollama復制到/usr/bin目錄中并賦予可執行權限:

sudochmod+x/usr/bin/ollama

(2)配置ollama系統服務

使用以下命令創建ollama服務描述文件:

sudotouch/etc/systemd/system/ollama.service

并在文件中編輯如下內容:

[Unit] Description=OllamaService After=network-online.target [Service] ExecStart=/usr/bin/ollamaserve User=root Group=root Restart=always RestartSec=3 [Install] WantedBy=default.target

(3)啟動ollama服務

使用下述命令啟動ollama服務:

sudosystemctldaemon-reload sudosystemctlenableollama

(4)啟動ollama

使用下述命令啟動ollama:

sudosystemctlstartollama

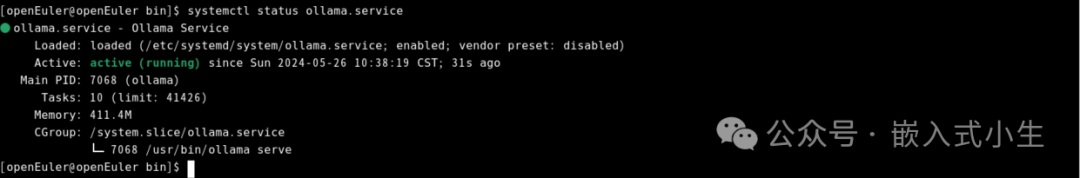

(5)查看ollama運行狀態

使用如下命令查看ollama運行狀態:

systemctlstatusollama.service

從上圖可知目前ollama啟動成功。

四、模型部署

通過上述第三小節的步驟后,Ollama模型運行環境就搭建完成,本小節將部署五個模型:1.8b的qwen、2b的gemma、3.8b的phi3、4b的qwen和7b的llama2,測試OrangePi Kunpeng Pro運行模型的實際效果。模型細節如下表所示:

| 序號 | 模型 | 參數 | 描述 |

| 1 | qwen | 1.8b | Qwen是阿里云開發的大型語言模型,1.8b,1.1GB |

| 2 | gemma | 2b | Gemma是由Google DeepMind構建的一系列輕量級的開放模型,大小1.7GB |

| 3 | phi3 | 3.8b | phi3是微軟開發的開放AI模型系列,3.8b為Mini系列,大小2.4GB |

| 4 | qwen | 4b | Qwen是阿里云開發的大型語言模型,4b,大小2.3GB |

| 5 | llama2 | 7b | Llama 2是由Meta平臺公司發行的基礎語言模型,大小3.8GB |

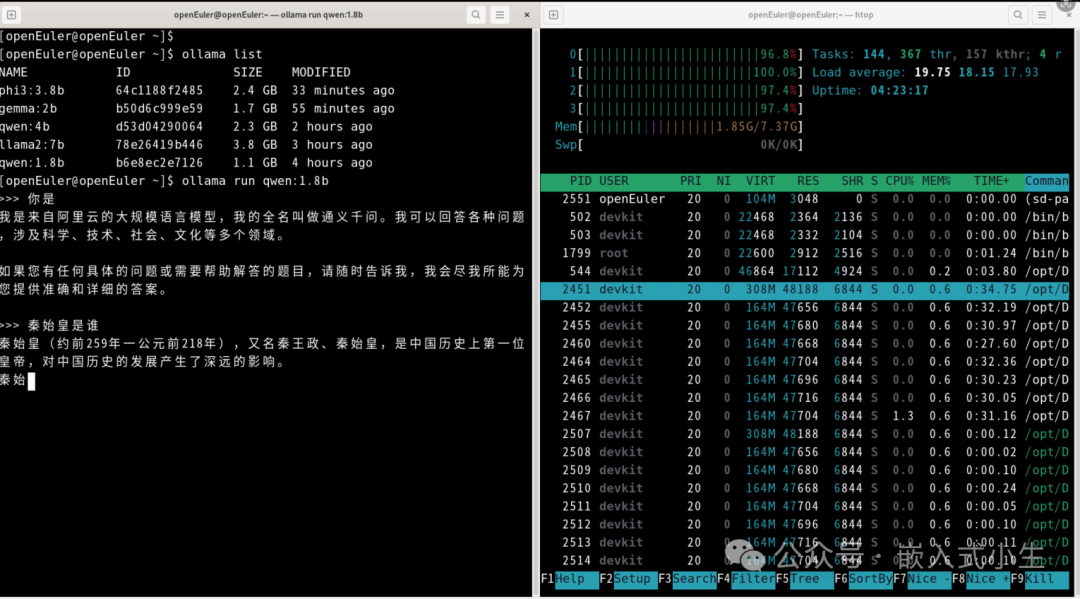

(1)部署1.8b的qwen

使用ollama run qwen:1.8b部署1.8b的qwen模型:

上述模型部署完成后,對其進行問答測試,如下圖所示:

效果:運行1.8b的qwen模型,CPU負載沒有占滿,進行問答測試,回答速度較快,效果很好!

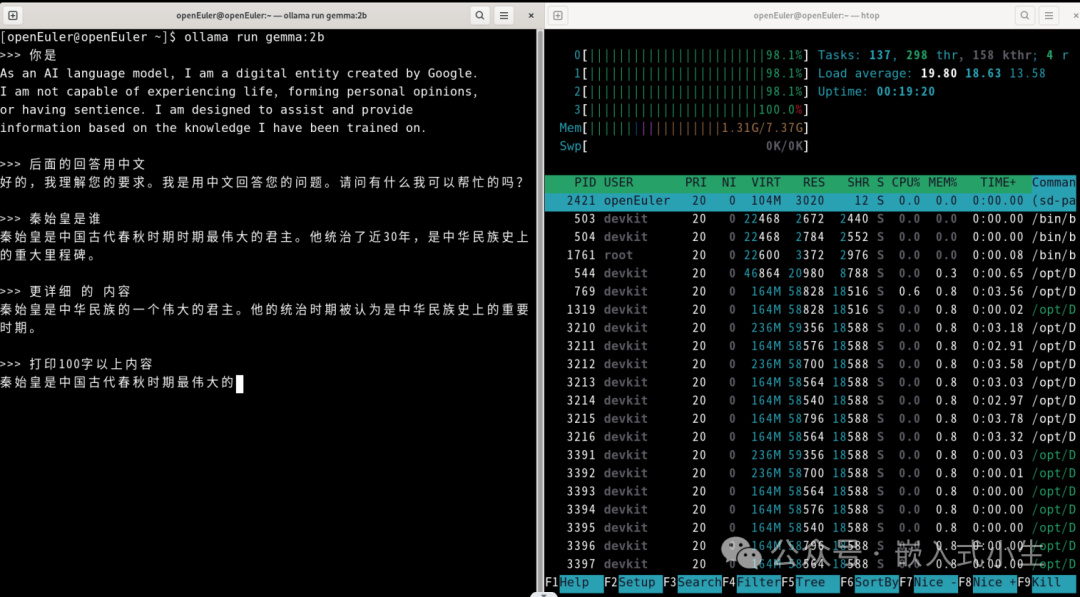

(2)部署2b的gemma

使用ollama run gemma:2b部署2b的gemma模型:

上述模型部署完成后,對其進行問答測試,如下圖所示:

效果:運行2b的gemma模型和運行1.8b的qwen模型效果相似,CPU負載同樣沒有占滿,進行問答測試,回答速度快,效果好!

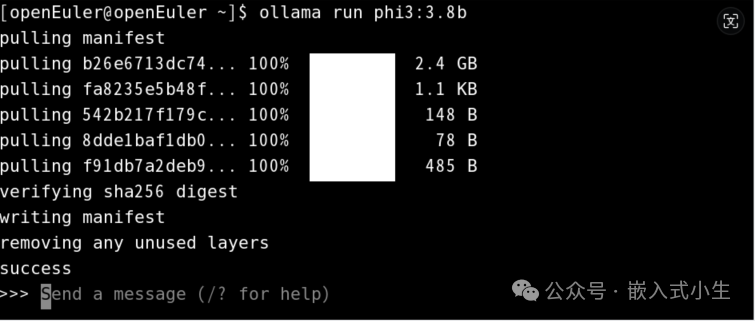

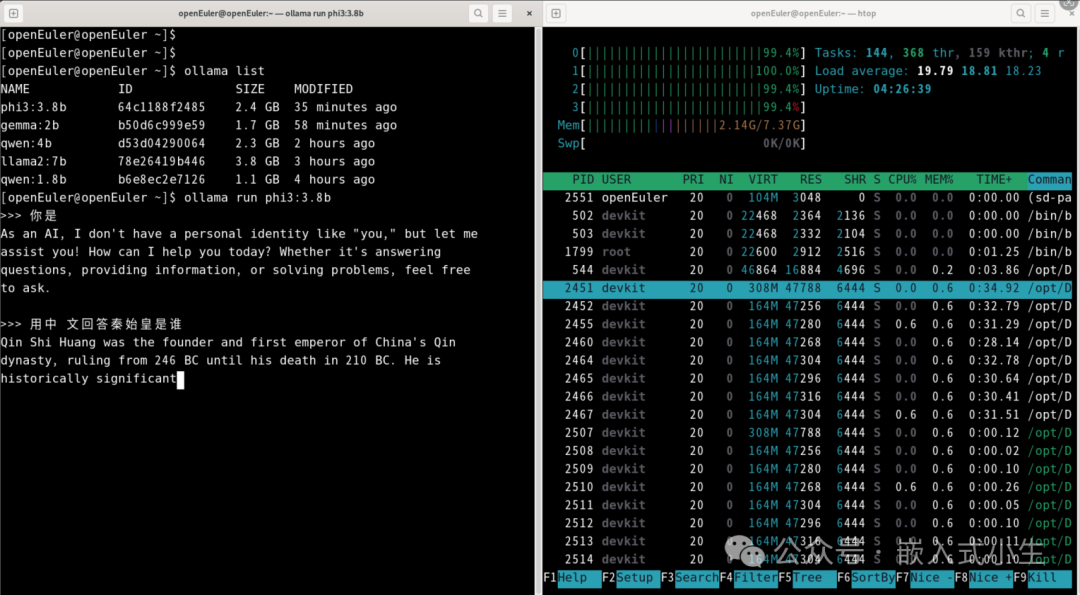

(3)部署3.8的phi3

使用ollama run phi3:3.8b部署3.8b的phi3模型:

上述模型部署完成后,對其進行問答測試,如下圖所示:

效果:運行3.8b的phi3模型,進行問答測試,回答速度變慢了。

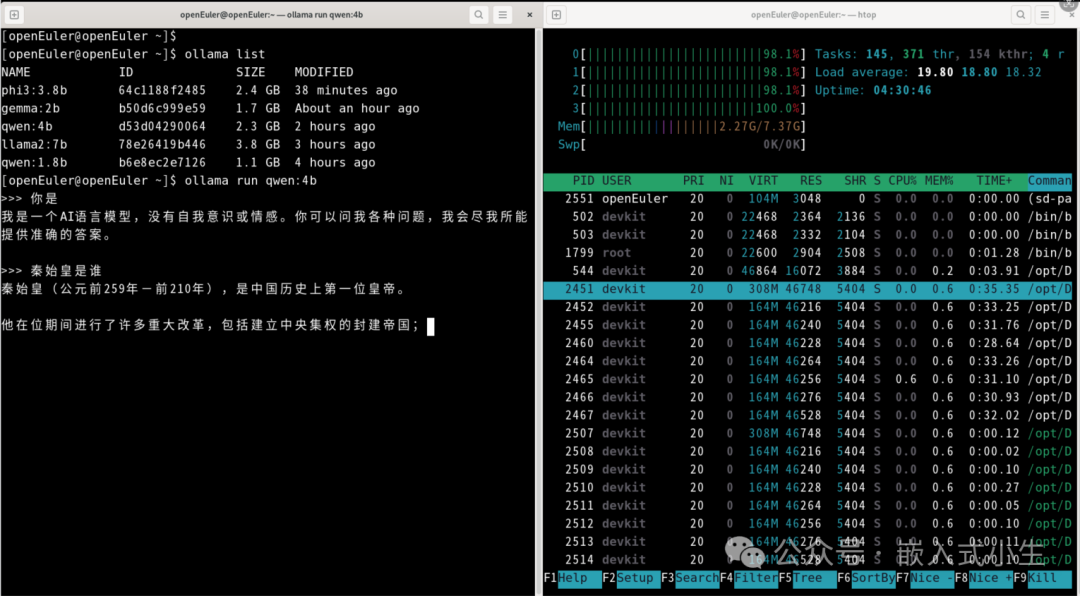

(4)部署4b的qwen

使用ollama run qwen:4b部署4b的qwen模型:

上述模型部署完成后,對其進行問答測試,如下圖所示:

效果:運行4b的qwen模型,進行問答測試,回答問題速度明顯變慢:計算生成答案的速度變慢,打印文字的速度也變慢了。

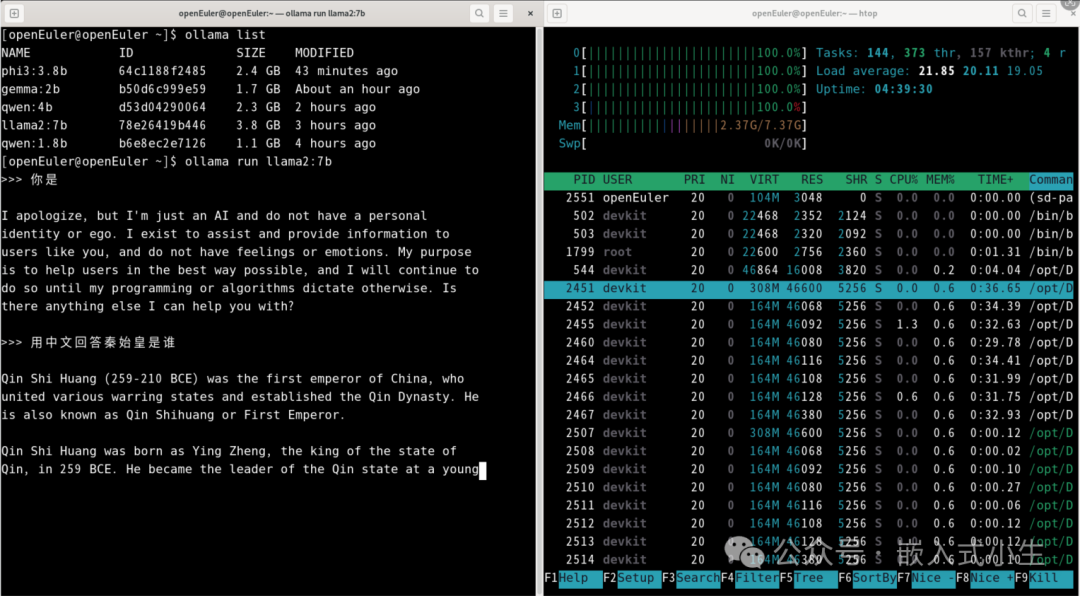

(5)部署7b的llama2

使用ollama run llama2:7b部署7b的llama2模型:

上述模型部署完成后,對其進行問答測試,如下圖所示:

效果:運行7b的llama2模型,CPU滿負載了,進行問答測試,回答問題速度也明顯變得很慢:計算生成答案的速度變慢,打印文字的速度也變慢了。

五、實際效果

上述第四小節描述了運行五個模型的實際使用效果,本小節附上運行2b的gemma模型的效果,如下圖所示:

(注:因gif圖對視頻有所處理,以實際運行效果為準!)

六、總結

OrangePi Kunpeng Pro板卡是一塊擁有較高計算性能的板卡,本文使用該板卡部署了五個模型(以本文所描述模型為參考),對于1.8b和2b量級的模型來說運行效果還可以,體驗較好;對于3.8b和4b量級的模型來說,體驗感有所下降,一是計算生成答案的過程變長,二是文字輸出存在斷續;對于7b量級的模型,體驗感更是降了一個層次,文字輸出存在明顯的斷續了。

體驗感是一個非理性的名詞,因人而異,不同的場景和模型,不同的使用者都可能存在不同的體驗,本文所有內容僅供參考和評測!

-

AI

+關注

關注

88文章

34780瀏覽量

277086 -

板卡

+關注

關注

3文章

133瀏覽量

17162 -

模型

+關注

關注

1文章

3504瀏覽量

50198

原文標題:玩玩OrangePi KunPeng Pro部署AI模型

文章出處:【微信號:嵌入式小生,微信公眾號:嵌入式小生】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

企業部署AI大模型怎么做

AI端側部署開發(SC171開發套件V3)

首創開源架構,天璣AI開發套件讓端側AI模型接入得心應手

如何在RAKsmart服務器上實現企業AI模型部署

《AI Agent 應用與項目實戰》閱讀心得3——RAG架構與部署本地知識庫

香橙派發布OrangePi 5Plus本地部署Deepseek-R1蒸餾模型指南

云軸科技ZStack智塔攜手昇騰AI實現DeepSeek模型部署

C#集成OpenVINO?:簡化AI模型部署

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

企業AI模型部署攻略

AI模型部署邊緣設備的奇妙之旅:目標檢測模型

如何在STM32f4系列開發板上部署STM32Cube.AI,

香橙派OrangePi?5 Pro性能全面測試!

OrangePi KunPeng Pro部署AI模型介紹

OrangePi KunPeng Pro部署AI模型介紹

評論