前言

最近半年以來,人工智能的發展重心逐漸從云端向終端轉移,相伴而生的是全新一代的計算芯片產業全面崛起。

在AI領域無論是學術界的大咖還是行業的大佬,都在如火如荼的搞類腦芯片的研究,當然也取得了不少成果。日前,斯坦福大學研究院電子與微系統技術實驗室的Jeehwan Kim教授在《自然》雜志上發表了一篇論文,一時間引來了產學研三界的關注。原因是Jeehwan Kim教授與研究員們使用一種稱為硅鍺的材料研發了一款人工突觸芯片,可支持識別手寫字體的機器學習算法。無獨有偶,近日中國科學院自動化研究所類腦智能研究中心類腦信息處理(BRAVE)研究組也在借鑒生物神經結構的神經網絡建模與類人學習研究中取得了突破性的研究。

從計算機誕生起,人們就不斷要求它的計算能力提升,隨著芯片集成性越來越高,CPU與內存之間的性能差距越來越大。基于馮諾依曼結構的計算機結構呈現的缺點也愈加明顯,也有人稱這為內存墻,意思是說CPU再快,也要等內存。相比之下,人腦卻沒有此類問題出現,據研究表明,人類大腦平均每秒可執行 1 億億次操作,所需能量只有 10~25 瓦特。因而研究員們正轉向模擬人類大腦研究,試圖通過模擬人腦運轉機制,使計算機能低能耗高功效地進行計算,甚至使計算機優于類人的智能。

國內外有許多公司和機構正在類腦芯片研發上投入大量精力,美國在此項研究上開始較早,2014年IBM就推出了業內首款類腦芯片TrueNorth。國內最近幾年在芯片研發上也不甘示弱,也有西井科技這樣的初創公司投身到類腦芯片的研發中來,清華等知名高校也紛紛建立類腦研究中心。

相比于傳統芯片,類腦芯片的確在功耗上具有絕對優勢,拿英特爾在本次CES上展出的自我學習芯片Loihi來說,不僅其學習效率比其他智能芯片高100萬倍,而且在完成同一個任務所消耗的能源比傳統芯片節省近1000倍。類腦芯片的集成度也非常高,拿浙大推出的“達爾文”芯片來說,其面積為25平方毫米,也就是說邊長只有0.5厘米,但內部卻能包含500萬個晶體管。隨著行業對計算力要求越來越高,馮氏瓶頸將越來越明顯,顛覆傳統架構的類腦芯片已為芯片行業開啟了一扇新的大門。

傳統芯片遇馮·諾依曼瓶頸 模擬神經元成新思路

現代計算機基本都基于馮·諾依曼結構,它將程序和處理該程序的數據用同樣的方式分別存儲在兩個區域,一個稱為指令集,一個稱為數據集。計算機每次進行運算時需要在CPU和內存這兩個區域往復調用,因而在雙方之間產生數據流量。而隨著深度學習算法的出現,對芯片計算力的要求不斷提高,馮·諾伊曼瓶頸遇見明顯:當CPU需要在巨大的資料上執行一些簡單指令時,資料流量將嚴重降低整體效率,CPU將會在資料輸入或輸出時閑置。

不僅如此,傳統芯片還存在一個大問題就是效率低。芯片在工作時,大部分的電能將轉化為熱能,一個不帶散熱器的計算機,其CPU產生的熱量就可在短時間內將其自身融化。其他的智能化設備,也因芯片復雜耗能太高,導致續航能力差,不管如何改善工藝,高溫和漏電都是難以避免的問題。

為了解決CPU在大量數據運算效率低能耗高的問題,目前有兩種發展路線:一是延用傳統馮諾依曼架構,主要以3中類型芯片為代表:GPU、FPGA、ASIC;二是采用人腦神經元結構設計芯片來提升計算能力,已完全擬人化為目標,追求在芯片架構上不斷逼近人腦,這類芯片被稱為類腦芯片。

人腦神經元在接受到刺激后,其細胞膜內外帶電離子分布將發生變化,因而形成電位差,電位差將沿著神經細胞軸突、樹突雙向傳導,形成脈沖電流。而當該電信號傳遞到突觸時,突觸前神經元將釋放神經遞質(如多巴胺、腎上腺素)由突觸后神經元接受神經遞質產生興奮(該過程單向傳遞),并向下傳遞作用與人體反應器并發生反應。

類腦芯片架構就是模擬人腦的神經突觸傳遞結構。眾多的處理器類似于神經元,通訊系統類似于神經纖維,每個神經元的計算都是在本地進行的,從整體上看神經元們分布式進行工作的,也就是說整體任務進行了分工,每個神經元只負責一部分計算。在處理海量數據上這種方式優勢明顯,并且功耗比傳統芯片更低。比如IBM的TrueNorth芯片每平方厘米功耗消耗僅為20毫瓦。

類腦芯片雖面世 但大規模商用進展緩慢

相比于依靠馮諾依曼結構的GPU、FPGA、ASIC來說,類腦芯片是一種相對處于概念階段的集成電路。目前面世的類腦芯片并不多,更不要說大規模的商業化了。

美國為保持技術優勢,率先發起類腦計算芯片的相關研究工作,通過模仿人腦工作原理,使用神經元和突觸的方式替代傳統馮諾依曼架構體系,使芯片能夠進行異步、并行、低速和分布式處理信息數據,并具備自主感知、識別和學習的能力。因此市面上第一款類腦芯片就來自于美國的IBM公司。

1、IBM TrueNorth(SyNAPSE芯片)

2011年8月,IBM率先在類腦芯片上取得進展,他們在模擬人腦大腦結構基礎上,研發出兩個具有感知、認知功能的硅芯片原型。但因技術上的限制,IBM戲稱第一代TrueNorth為“蟲腦”。2014年TrueNorth第二代誕生,它使用了三星的28nm的工藝,共用了54億個晶體管,其性能相比于第一代有了不少提升。功耗每平方厘米消耗僅為 20 毫瓦,是第一代的百分之一,直徑僅有幾厘米,是第一代的十五分之一。

▲IBM Truenorth芯片

每個核都簡化模仿了人類大腦神經結構,包含256個“神經元”(處理器)、256個“軸突”(存儲器)和64000個突觸(神經元和軸突之間的通信)。總體來看,TrueNorth芯片由4096 個內核,100 萬個 “神經元”、2.56 億個 “突觸” 集成。此外,不同芯片還可以通過陣列的方式互聯。

IBM稱如果 48 顆TrueNorth芯片組建起具有 4800 萬個神經元的網絡,那這48顆芯片帶來的智力水平將相似于普通老鼠。

從2014年亮相后,這款芯片一直沒有大的動作。不久前,TrueNorth終于傳出了新進展,有報道稱IBM公司即將開發由64個“TrueNorth”類腦芯片驅動的新型超級計算機。這一計算機能進行大型深度神經網絡的實時分析,可用于高速空中真假目標的區分,并且功耗比傳統的計算機芯片降低4個數量級。如果該系統功耗可以達到人腦級別,那么理論上就可以在64顆芯片原型基礎上進一步擴展,從而能夠同時處理任何數量的實時識別任務。

2、英特爾Loihi芯片

▲英特爾神經擬態芯片Loihi

幾日前的CES上芯片巨頭英特爾展示了其首款自學習神經元芯片Loihi,去年9月英特爾就曾宣稱歷時十年研究設計出了這款芯片的原型。Loihi芯片可以像人類大腦一樣,通過脈沖或尖峰傳遞信息,并自動調節突觸強度,通過環境中的各種反饋信息,進行自主學習、下達指令。據英特爾方面稱Loihi內部包含了128個計算核心,每個核心集成1024個人工神經元,總計13.1萬個神經元,彼此之間通過1.3億個突觸相互連接。

相比于人腦內的800多億個神經元,Intel這款芯片的運算規模僅僅比蝦腦大一點。但根據英特爾給出的數據Loihi的學習效率比其他智能芯片高100萬倍,而在完成同一個任務所消耗的能源可節省近1000倍。

3、高通Zeroth芯片

芯片巨頭高通也在進行類腦芯片的研發,早在2013年高通就曾公布一款名為Zeroth的芯片,Zeroth不需要通過大量代碼對行為和結果進行預編程,而是通過類似于神經傳導物質多巴胺的學習(又名“正強化”)完成的。高通為了讓搭載該芯片的設備能隨時自我學習,并從周圍環境中獲得反饋,還為此開發了一套軟件工具。在公布的資料中高通還用裝載該芯片的機器小車進行了演示,使小車在受人腦啟發的算法下完成尋路、躲避障礙等任務。

國內也開始了類腦芯片的研究,除清華等知名高校開設研究院外,也出現了專注類腦芯片研發的創企,代表企業如上海的西井科技。

4、西井科技DeepSouth芯片

西井科技是國內研究類腦強人工智能的公司,目前西井已推出了自主研發的擁有100億規模的神經元人腦仿真模擬器(Westwell Brain)和可商用化的5000 萬類腦神經元芯片(DeepSouth)兩款產品。 DeepSouth 是一款可商用化的芯片,它能模擬出高達 5000 萬級別的“神經元”,總計有 50 多億“神經突觸”。據西井CEO譚黎敏稱,該芯片除了具備“自我學習、自我實時提高”的能力外,還可以直接在芯片上完成計算,不需要通過網絡連接后臺服務器,可在“無網絡”情況下使用。

能耗方面,DeepSouth 在同一任務下的功耗僅為傳統芯片的幾十分之一到幾百分之一。

5、浙大“達爾文”類腦芯片

▲浙大和杭州電子科技共同研發的“達爾文”芯片

2015年一群來自浙江大學與杭州電子科技大學的年輕的研究者們研發出一款成為達爾文的類腦芯片。這款芯片是國內首款基于硅材料的脈沖神經網絡類腦芯片。“達爾文”芯片面積為25平方毫米,比1元硬幣還要小,內含500萬個晶體管。芯片上集成了2048個硅材質的仿生神經元,可支持超過400萬個神經突觸和15個不同的突觸延遲。

據研發團隊介紹說,這款芯片可從外界接受并累計刺激,產生脈沖(電信號)進行信息的處理和傳遞,這如我們前面提到的人類神經元間的信息傳遞一樣。研發人員還為“達爾文”開發了兩款簡單的智能應用。一是這款芯片可識別不同人手寫的1-10這10個數字,二是“達爾文”在接受了人類腦電腦后,可控制電腦屏幕上籃球的移動方向。在熟悉并學習了操作者的腦電波后,“達爾文”會在后續接受相同刺激時做出同樣反映。

6、AI-CTX芯片

此外,國內也出現了一些小型的類腦芯片研究團隊,如AI-CTX團隊。據稱他們目前設計出了一款類腦芯片模型,不僅每個神經元都具有跟人腦神經元類似的電學特征與動態參數,具有簡單的運算與存儲功能。他們還采用了一種特殊的布線方式,使各芯片之間的交流突破物理限制,進而增加芯片群組的原有網絡。這一芯片不適合處理靜態硬盤數據,但擅長處理如溫度、氣壓、人體信號、loT等包含時間參數的數據。

雖然目前市面上出現了幾款類腦芯片,但其在計算力上還不及傳統架構芯片快。為了提升計算機對大規模數據的運算效率,芯片企業現在最常見的做法就是基于傳統芯片架構,搭載人工神經網絡,從功能上模擬人腦計算的GPU、FPGA·、ASIC三種芯片,加上類腦芯片,并稱為AI芯片。

類腦計算成新方向

人腦的這三大特性始終是計算機無法比擬的:一是低能耗,人腦的功率大約為20瓦,而目前計算機功耗需要幾百萬瓦;二是容錯性,人腦時刻都在失去神經元,而計算機失去一個晶體管就會破壞整個處理器;三是無需編程,大腦在于外界交互過程中自發學習和改變,并非遵循預先設計好的算法。

中國也十分重視類腦研究,并將類腦計算作為國家戰略發展的制高點。中國不僅在2015年將腦計劃作為重大科技項目列入國家“十三五”規劃,還發布了關于腦計劃“一體兩翼”的總體戰略:一體即認識腦:以闡釋人類認知的神經基礎為主體和核心;兩翼即保護腦:預防、診斷和治療腦重大疾病和模擬腦:類腦計算。

中國的學術界也展開了對類腦的研究,2015 年中科院、清華、北大,相繼成立“腦科學與類腦智能研究中心”,2017年5月在合肥成立了類腦智能技術及應用國家工程實驗室。這些實驗室將借鑒人腦機制攻關人工智能技術,推進類腦神經芯片、類腦智能機器人等新興產業發展。

結語:類腦芯片或將賦予機器智能

目前,搭載神經網絡引擎的芯片層出不窮,芯片巨頭和初創們都在原有的馮諾依曼架構上爭相利用神經網絡優化芯片計算力。從目前這類AI芯片的表現上看,FPGA的靈活性較好但開發難度大,ASIC因其功耗低、開發難度適中將在終端AI芯片上具有較大優勢。

類腦芯片不僅能提高計算機的計算速度、降低功耗,其在國防領域也將發揮重要作用,對研發高度自主性的智能機器人以及提高其他設備的智能水平也有重要意義。就讓機器實現智能這一人工智能終極理想來說,從人類自身結構出發是一可選思路,但并非僅此一種。

從現在各大公司的研究成果來看,像IBM TrueNorth這樣的類腦芯片運行的效率還不及以上提到的在傳統架構上運用神經網絡的芯片。但馮諾依曼瓶頸是客觀存在的事實,隨著運算數據量的增加,這一短板將越來越明顯。

而人腦也的確憑借低功耗、高運算力成為計算機芯片研發學習的方向,但短期內類腦芯片還難以表現出其優勢,或許隨著對人腦研究的深入,會有人像牛頓一樣被“上帝的蘋果”砸中,從而擁有敲開具有高速運算力的類腦芯片領域的敲門磚。或許現在的傳統架構加神經網絡芯片就是像牛頓的萬有引力定律一樣適用于數據量較大的運算,而類腦芯片像愛因斯坦的相對論一樣在實現機器智能上更具潛力。

原文標題:解析目前六款類腦芯片,如何顛覆傳統架構

文章出處:【微信號:edn-china,微信公眾號:EDN電子技術設計】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

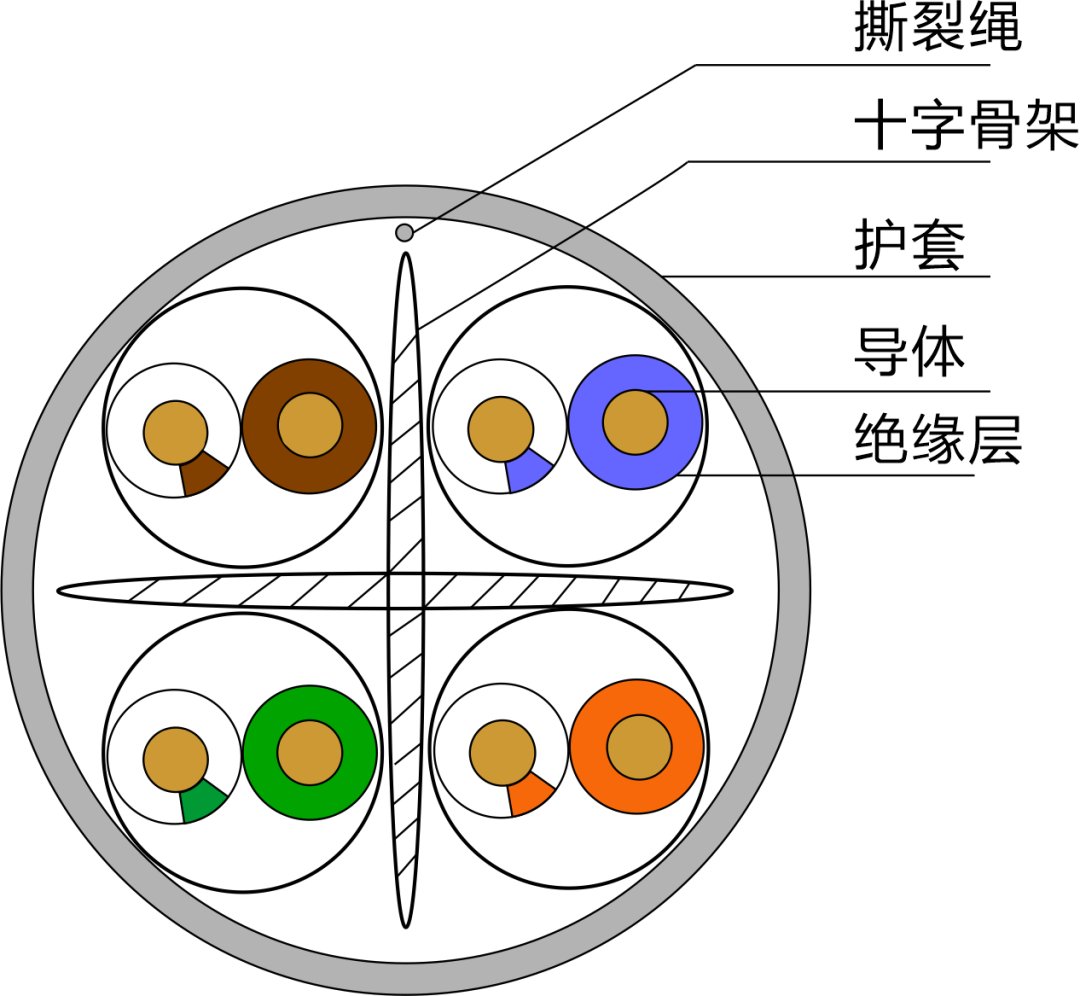

超六類非屏蔽模塊是什么

六類網線和超六類網線有什么不同

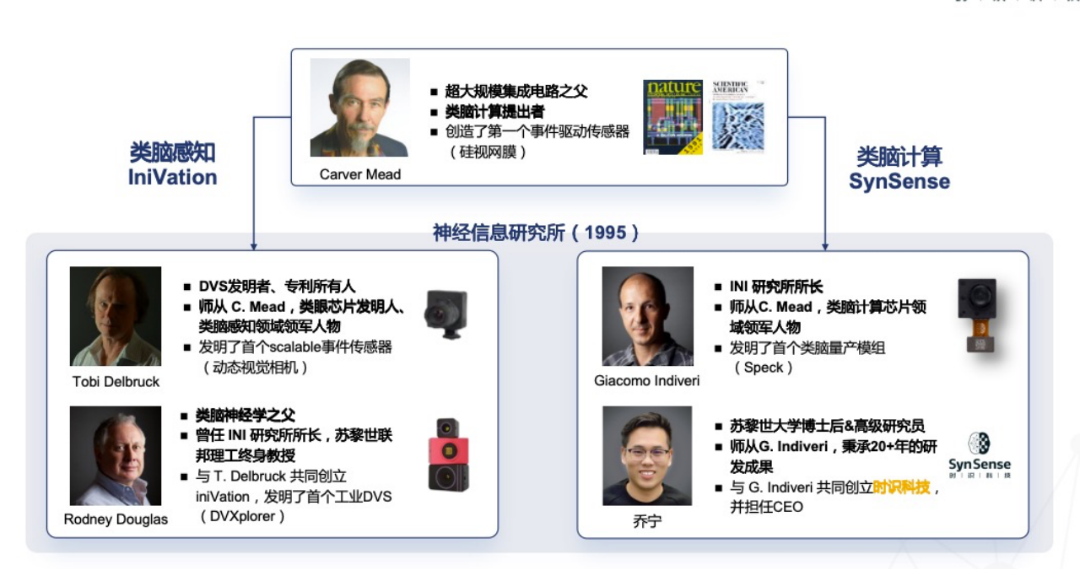

SynSense時識科技成功收購瑞士類腦視覺傳感器公司iniVation,類腦智能航母蓄勢待發

utp6是六類還是超六類

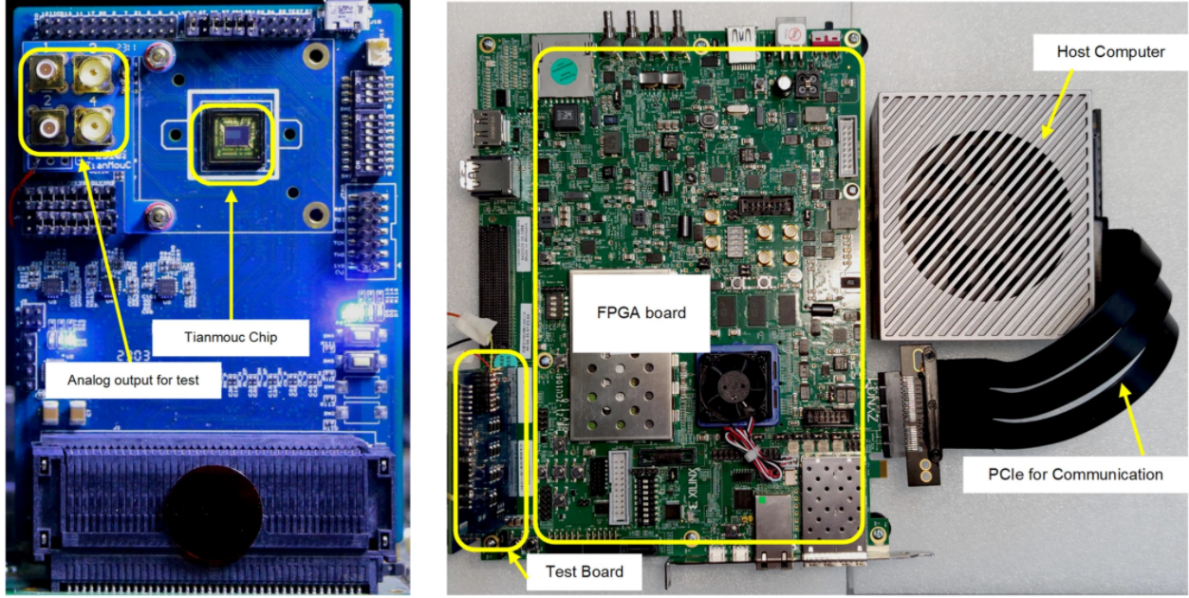

基于FPGA的類腦計算平臺 —PYNQ 集群的無監督圖像識別類腦計算系統

顛覆傳統DCS架構 | 中控技術全球首款通用控制系統Nyx震撼發布

清華類腦視覺芯片取得重大突破,“天眸芯”登上Nature封面

目前六類網線多少錢一米

六類屏蔽水晶頭

六類和超六類網線區別

解析目前六款類腦芯片,如何顛覆傳統架構

解析目前六款類腦芯片,如何顛覆傳統架構

評論