一、Flexus 云服務器 X 實例介紹

在數字化時代,云服務器已成為企業發展的重要基石。它提供靈活的資源擴展和高效的計算能力,幫助企業降低成本、提升效率。無論是數據存儲還是業務創新,云服務器都能滿足多樣化需求,是各行業不可或缺的技術支持。

華為云下一代云服務器 Flexus X 實例煥新上線,新產品首創大模型加持,智能全域調度;X-Turbo 加速,常見應用性能最高可達業界同規格 6 倍,可搭載多版本主機安全服務,歷經極度嚴苛的網絡安全挑戰,全面保障主機整體安全,覆蓋大多數通用工作負載場景。

Flexus X 實例通過和其他服務組合,具備計算、鏡像安裝、網絡、存儲、安全等能力,您可根據業務需要靈活配置各資源。

本次測評使用的規格是:4 核 12G-100G-3M 規格的 Flexus X 實例基礎模式

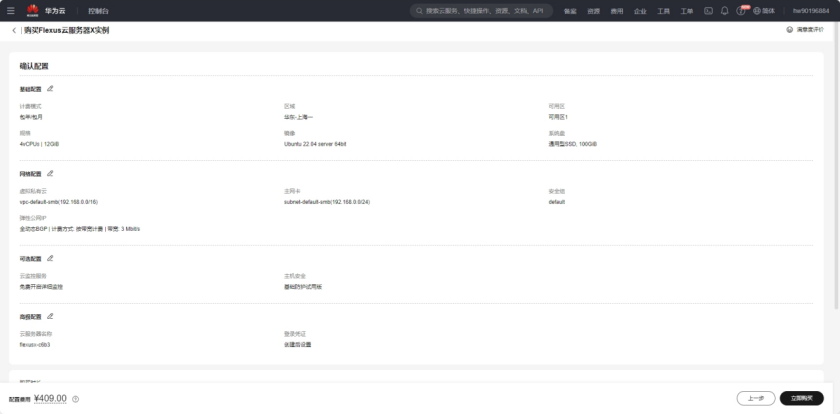

二、Flexus 云服務器 X 實例配置

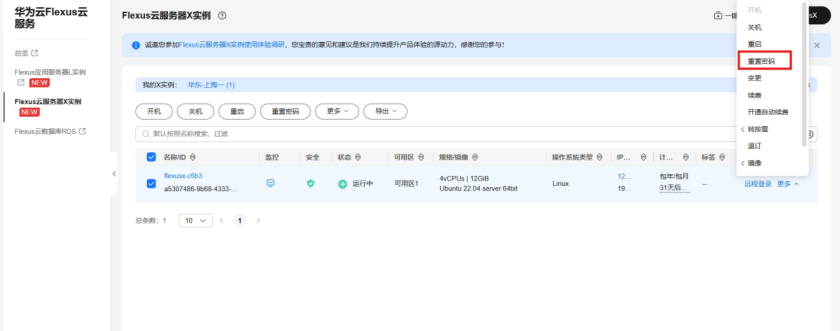

2.1 重置密碼

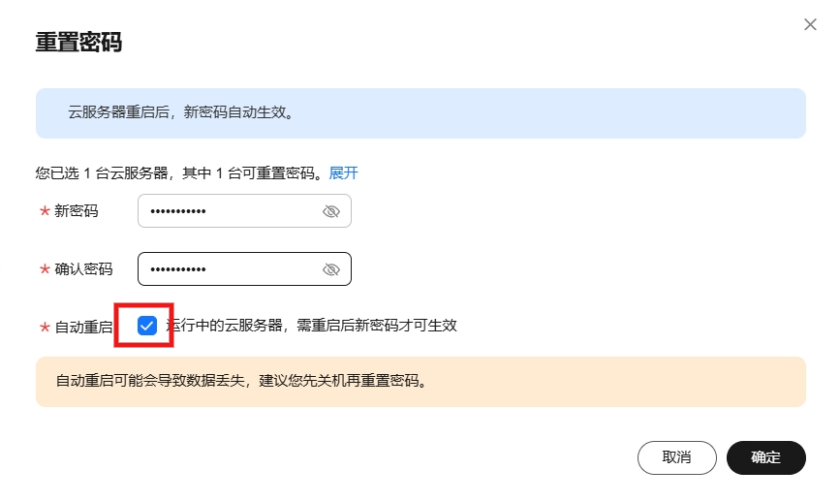

購買服務器的時候可以提前設置用戶名和密碼,因為我這里跳過了,所以購買完成后需要重置密碼,會短信或站內消息通過你的云服務器信息,重點是公網 IP 地址和用戶名,首先打開你的服務器控制臺,選擇重置密碼

勾選自動重啟,點擊確定即可

2.2 服務器連接

華為云服務器提供了多種鏈接方式,如使用控制臺提供的 VNC 方式登錄、使用 Linux/Mac OS 系統主機登錄 Linux 彈性云服務器(即 ssh root@192.168.48.78 命令)或者使用 Putty、Xshell 等工具登錄 Linux 彈性云服務器。

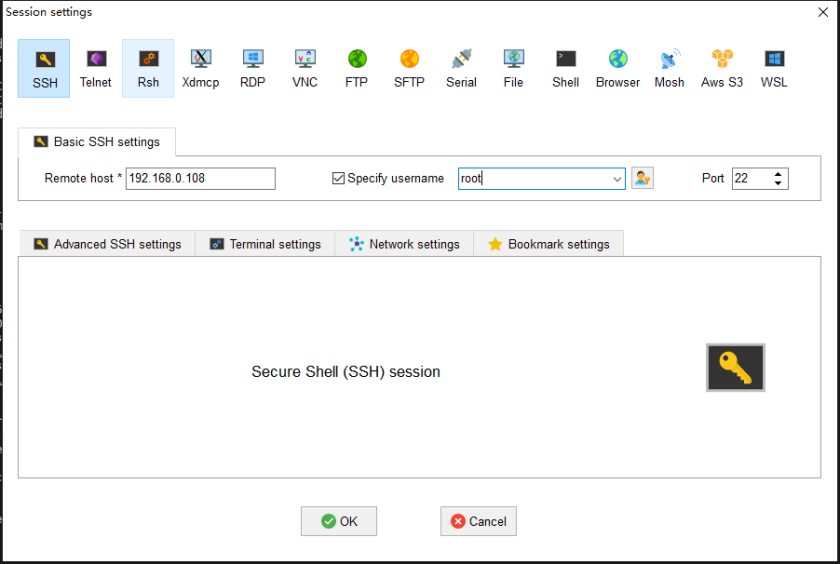

我個人習慣使用 MobaXterm這款軟件,添加 SSH 連接,輸出公網 IP、用戶名和端口(默認 22),連接即可。

2.3 安全組配置

安全組是一個邏輯上的分組,為同一個 VPC 內的云服務器提供訪問策略。用戶可以在安全組中定義各種訪問規則,當云服務器加入該安全組后,即受到這些訪問規則的保護。

系統為每個網卡默認創建一個默認安全組,默認安全組的規則是對出方向上的數據報文全部放行,入方向訪問受限。您可以使用默認安全組,也可以根據需要創建自定義的安全組。

主要需要填寫優先級(默認填 1 即可)、協議端口(協議一般為 TCP 或 UDP,端口一般選擇你項目需要暴露的端口即可),描述(選填,一般會填寫此端口的用途以免忘記了),其他默認點擊確定即可。安全組配置主要是暴露端口可以給外網訪問。

如果還不清楚可以參考文檔:安全組配置示例

2.4 Docker 環境搭建

本次服務器環境是 ubuntu 系統鏡像,需要自己安裝 docker 環境

使用 apt-get 命令安裝 docker 及其配置

#安裝必要工具包 $ sudo apt-get install apt-transport-https ca-certificates curl gnupg-agent software-properties-common#添加 Docker GPG 秘鑰 $ sudo curl -fsSL https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/gpg | sudo apt-key add -#配置倉庫源 $ sudo add-apt-repository "deb [arch=amd64] https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu $(lsb_release -cs) stable" #更新 apt 包索引 $ sudo apt-get update#安裝 docker$ sudo apt-get install docker-ce docker-ce-cli containerd.io#添加 docker 鏡像源 $ sudo vim /etc/docker/daemon.json{"registry-mirrors": ["https://ustc-edu-cn.mirror.aliyuncs.com/","https://docker.mirrors.ustc.edu.cn","https://docker.nju.edu.cn","https://ccr.ccs.tencentyun.com/","https://docker.m.daocloud.io/","https://dockerproxy.com",]}#重啟 $ sudo systemctl daemon-reload$ sudo systemctl restart docker

測試 docker 安裝是否成功

root@flexusx-c6b3:~# docker -vDocker version 27.2.0, build 3ab4256```

檢查 docker 服務狀態

root@flexusx-c6b3:~# systemctl status docker* docker.service - Docker Application Container EngineLoaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset: enabled)Active: active (running) since Fri 2024-08-30 15:53:45 CST; 17h agoTriggeredBy: * docker.socketDocs: https://docs.docker.comMain PID: 24912 (dockerd)Tasks: 13Memory: 24.7MCPU: 3.778sCGroup: /system.slice/docker.service`-24912 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

檢查 docker compose 版本

root@flexusx-c6b3:~# docker compose versionDocker Compose version v2.29.2

三、Flexus 云服務器 X 實例部署 LobeChat

3.1 LobeChat 介紹

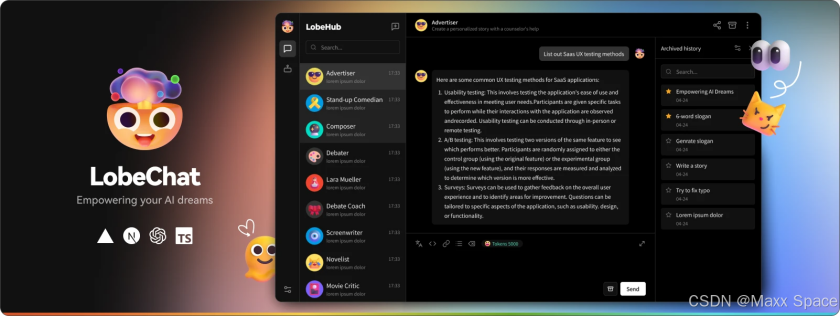

LobeChat 是現代化設計的開源 ChatGPT/LLMs 聊天應用與開發框架,支持語音合成、多模態、可擴展的(function call)插件系統,一鍵免費擁有你自己的 ChatGPT/Gemini/Claude/Ollama 應用。

?文件上傳/知識庫 LobeChat 支持文件上傳與知識庫功能,你可以上傳文件、圖片、音頻、視頻等多種類型的文件,以及創建知識庫,方便用戶管理和查找文件。同時在對話中使用文件和知識庫功能,實現更加豐富的對話體驗。

?多模型服務商支持在 LobeChat 的不斷發展過程中,我們深刻理解到在提供 AI 會話服務時模型服務商的多樣性對于滿足社區需求的重要性。因此,我們不再局限于單一的模型服務商,而是拓展了對多種模型服務商的支持,以便為用戶提供更為豐富和多樣化的會話選擇。

?支持本地大語言模型(LLM)為了滿足特定用戶的需求,LobeChat 還基于 Ollama 支持了本地模型的使用,讓用戶能夠更靈活地使用自己的或第三方的模型。

?模型視覺識別(Model Visual)LobeChat 已經支持 OpenAI 最新的 gpt-4-vision 支持視覺識別的模型,這是一個具備視覺識別能力的多模態應用。 用戶可以輕松上傳圖片或者拖拽圖片到對話框中,助手將能夠識別圖片內容,并在此基礎上進行智能對話,構建更智能、更多元化的聊天場景。

?TTS & STT 語音會話 LobeChat 支持文字轉語音(Text-to-Speech,TTS)和語音轉文字(Speech-to-Text,STT)技術,這使得我們的應用能夠將文本信息轉化為清晰的語音輸出,用戶可以像與真人交談一樣與我們的對話助手進行交流。用戶可以從多種聲音中選擇,給助手搭配合適的音源。同時,對于那些傾向于聽覺學習或者想要在忙碌中獲取信息的用戶來說,TTS 提供了一個極佳的解決方案。

?Text to Image 文生圖支持最新的文本到圖片生成技術,LobeChat 現在能夠讓用戶在與助手對話中直接調用文生圖工具進行創作。 通過利用 DALL-E 3、MidJourney 和 Pollinations 等 AI 工具的能力, 助手們現在可以將你的想法轉化為圖像。同時可以更私密和沉浸式地完成你的創作過程。

LobeChat 是經過精心設計的界面,具有優雅的外觀和流暢的交互效果,支持亮暗色主題,適配移動端。支持 PWA,提供更加接近原生應用的體驗。流式響應帶來流暢的對話體驗,并且支持完整的 Markdown 渲染,包括代碼高亮、LaTex 公式、Mermaid 流程圖等。使用 我們的 Docker 鏡像,只需點擊一鍵部署按鈕,即可在 1 分鐘內完成部署,無需復雜的配置過程,很適合構建自己 AI 對話應用。

?官網:https://lobechat.com/welcome

?Github:https://github.com/lobehub/lobe-chat

3.2 LobeChat 部署

?創建 docker-compose.yml

version:'3.5'services:lobe-chat:image:lobehub/lobe-chatcontainer_name:lobe-chatrestart:alwaysports: -'3210:3210'environment:OLLAMA_PROXY_URL:http://123.60.144.170:11434/

?ports:映射主機的 3210 端口到容器的 3210 端口

?OLLAMAPROXYURL: Ollama 服務地址

如果將上述代碼片段保存在名為 docker-compose.yml 的文件中,則只需從同一文件夾中運行 docker compose up -d即可自動拉取 LobeChat 鏡像,并創建并啟動一個容器。up表示啟動服務,-d表示在后臺執行。docker-compose down命令用于停止和清理由 docker-compose up啟動的服務。

?啟動服務

進入項目目錄,執行 docker-compose up -d 啟動命令,會自動拉取容器并運行

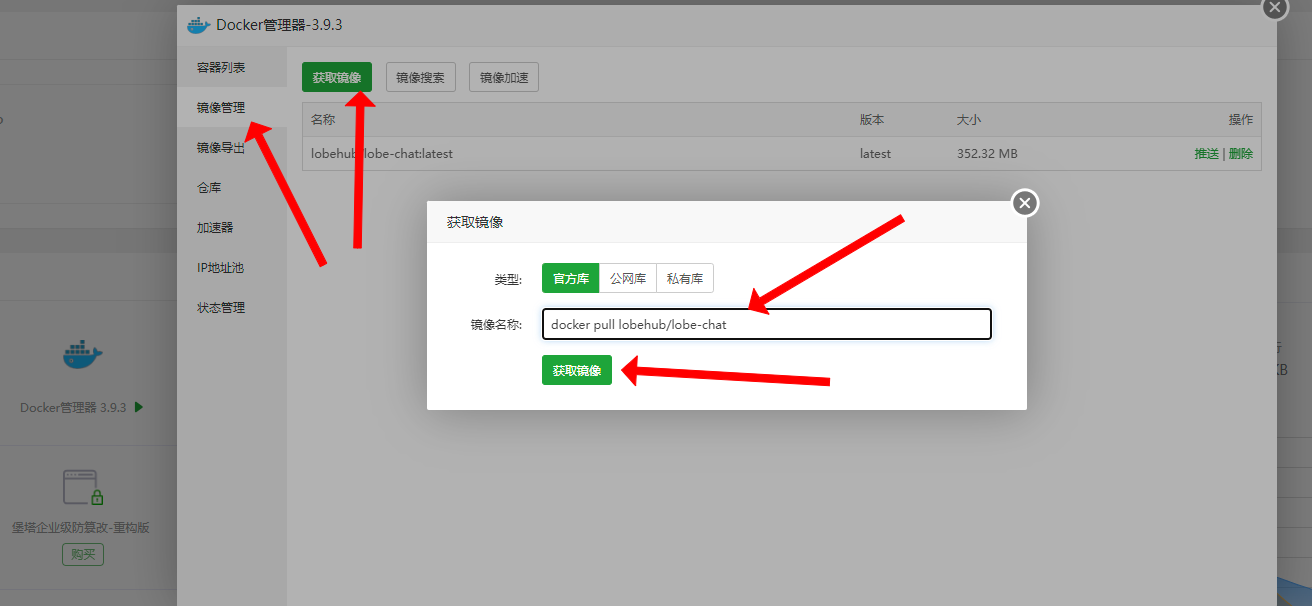

從 Dockerhub 拉取 LobeChat 鏡像,地址:https://hub.docker.com/r/lobehub/lobe-chat

root@flexusx-c6b3:~/lobechat# docker-compose up -dCreating network "lobechat_default" with the default driverPulling lobe-chat (lobehub/lobe-chat:latest)...latest: Pulling from lobehub/lobe-chata2318d6c47ec: Pull complete00e35d36405a: Pull complete225fba03fa1f: Pull complete447f637b003c: Pull completedd1be0639854: Pull complete9db807b569f9: Pull complete7d6120d566fb: Pull completeDigest: sha256:2b1663efad8125c5e428fa371a6b2d324f582d9010bae1a3e526df2b2b11dd3cStatus: Downloaded newer image for lobehub/lobe-chat:latestCreating lobe-chat ... Creating lobe-chat ... done

?配置安全組

在 Flexus 云服務器 X 實例的安全組管理頁面,添加入方向規則,接下來我們啟動服務需要監聽 3210 端口,所以添加安全組為 TCP:3210 協議端口。

?檢查容器狀態

檢查 LobeChat 容器狀態,確保容器正常啟動

root@flexusx-c6b3:~/lobechat# docker psCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES1b8d6fa19e28 lobehub/lobe-chat "docker-entrypoint.s…" 2 minutes ago Up About a minute 0.0.0.0:3210->3210/tcp, :::3210->3210/tcp lobe-chat

?訪問地址

內網:http://localhost:3210 外網:http://公網 IP:3210

?訪問結果

若出現此頁面,則部署 lobechat server 成功。

3.3 LobeChat 使用

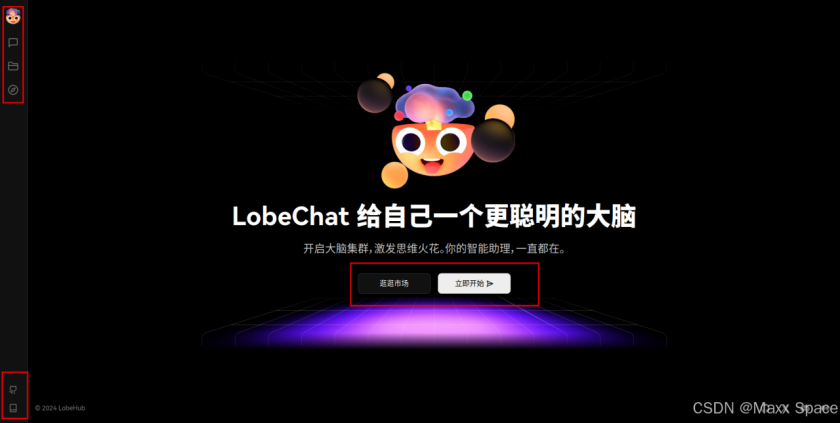

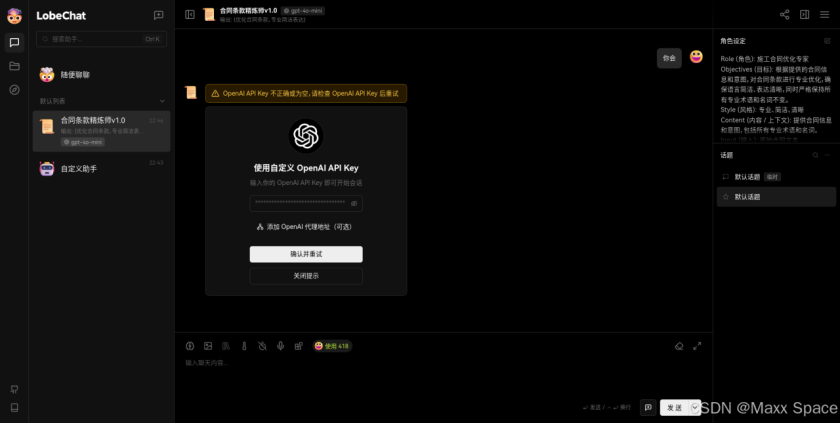

應用啟動完成后,進入主頁面,頭像是設置菜單,左側顯示會話、文件、發現模塊,左下角有 Github 地址和使用文檔鏈接,

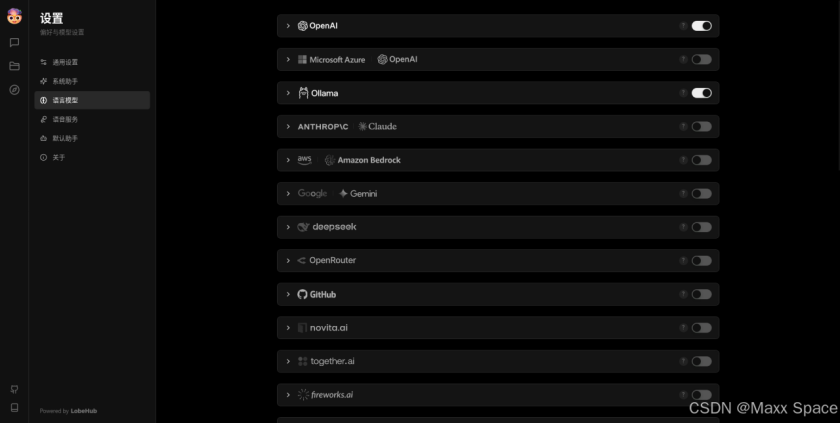

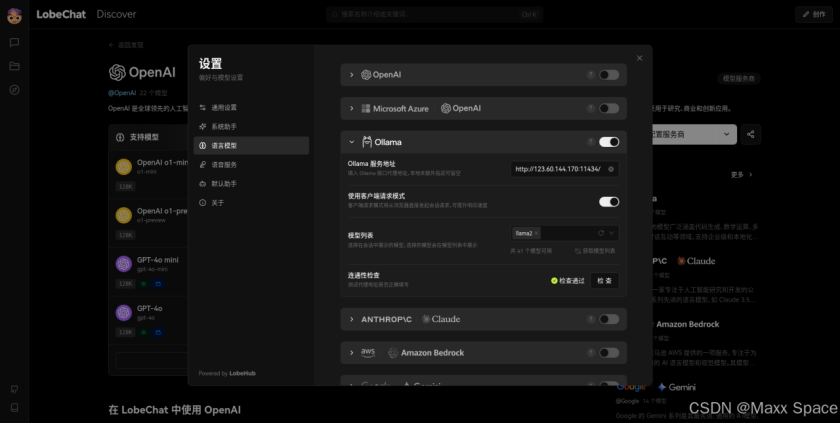

點擊頭像進入設置應用,這里包含通用設置、系統助手、語言模型、語音服務、默認助手,可配置的選項很多,主要是集成其他模型的 API Key

支持超多模型服務商

?AWS Bedrock:集成了 AWS Bedrock 服務,支持了 Claude / LLama2 等模型,提供了強大的自然語言處理能力。

?Google AI (Gemini Pro、Gemini Vision):接入了 Google 的 Gemini 系列模型,包括 Gemini 和 Gemini Pro,以支持更高級的語言理解和生成。

?Anthropic (Claude):接入了 Anthropic 的 Claude 系列模型,包括 Claude 3 和 Claude 2,多模態突破,超長上下文,樹立行業新基準。

?ChatGLM:加入了智譜的 ChatGLM 系列模型(GLM-4/GLM-4-vision/GLM-3-turbo),為用戶提供了另一種高效的會話模型選擇。

?Moonshot AI (月之暗面):集成了 Moonshot 系列模型,這是一家來自中國的創新性 AI 創業公司,旨在提供更深層次的會話理解。

?Together.ai:集成部署了數百種開源模型和向量模型,無需本地部署即可隨時訪問這些模型。

?01.AI (零一萬物):集成了零一萬物模型,系列 API 具備較快的推理速度,這不僅縮短了處理時間,同時也保持了出色的模型效果。

?Groq:接入了 Groq 的 AI 模型,高效處理消息序列,生成回應,勝任多輪對話及單次交互任務。

?OpenRouter:其支持包括 Claude 3,Gemma,Mistral,Llama2 和 Cohere 等模型路由,支持智能路由優化,提升使用效率,開放且靈活。

?Minimax:接入了 Minimax 的 AI 模型,包括 MoE 模型 abab6,提供了更多的選擇空間。了解更多

?DeepSeek:接入了 DeepSeek 的 AI 模型,包括最新的 DeepSeek-V2,提供兼顧性能與價格的模型。

?Qwen:接入了 Qwen 的 AI 模型,包括最新的 qwen-turbo,qwen-plus 和 qwen-max 等模型。

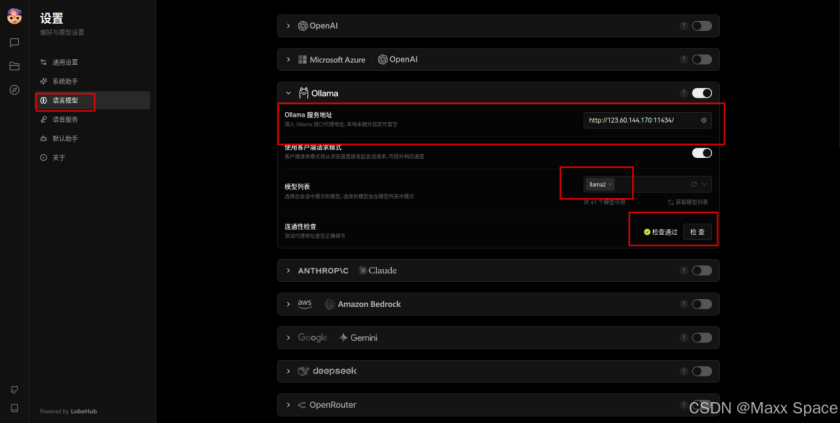

我這里配置的是 Ollama 的本地模型服務,填寫 Ollama 服務地址,并測試下聯通性,通過即可

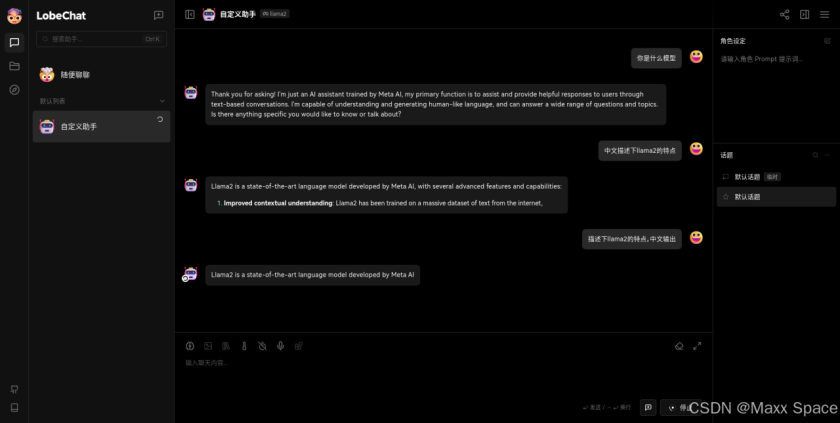

選擇會話菜單,進入會話界面,和常見的大模型會話界面差不多,左側列表顯示不同的助手,對話框輸入消息,可選擇模型、圖片、知識庫、隨機性、不限歷史消息數、語音輸入、函數調用等選項,需要當前模型支持時才可用,否則是置灰狀態

使用 Ollama llama2 模型測試下效果,貌似中文不太行

當前部署模式不支持文件管理,當前部署實例為客戶端數據庫模式,無法使用文件管理功能

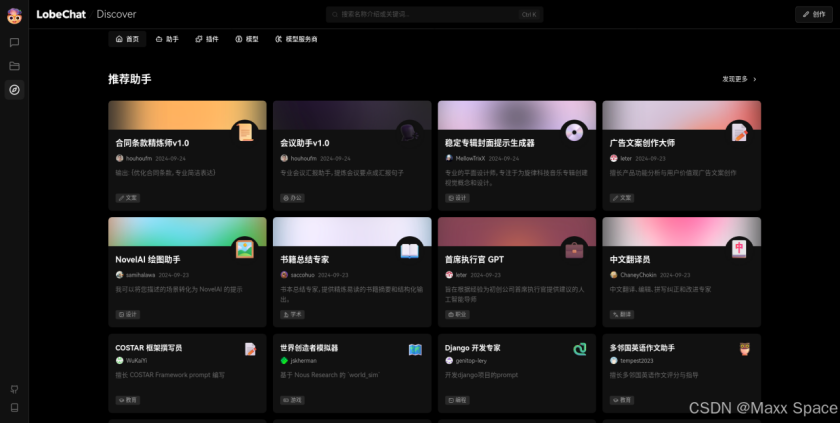

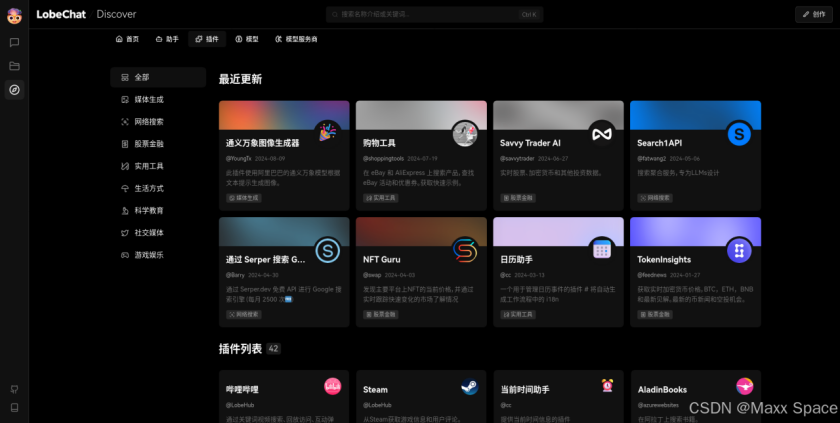

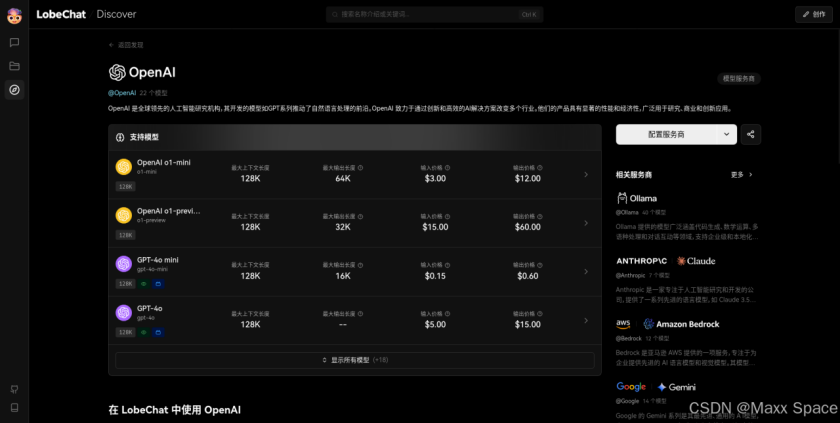

發現頁展示助手、插件、模型和模型服務商四大分類的內容

這里有很多優化好的針對專門需求的助手,當然需要添加 OpenAI API Key,這些助手都是基于 OpenAI 的模型輸出的

豐富的插件市場

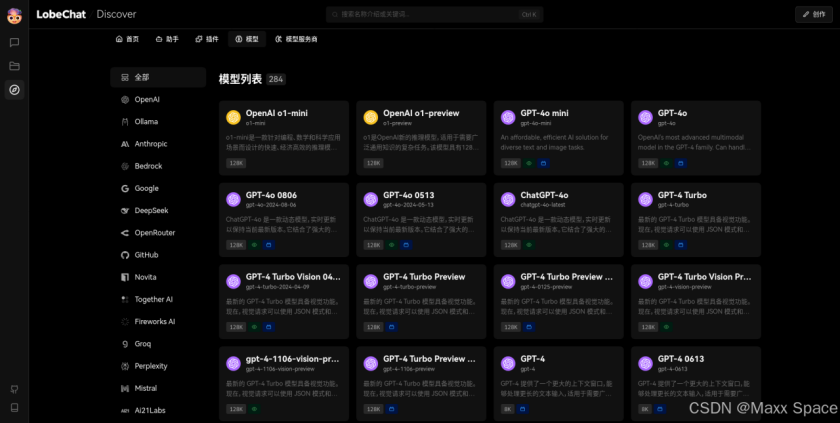

列表展示超多的模型,按照模型服務商分類展示其旗下的各種模型

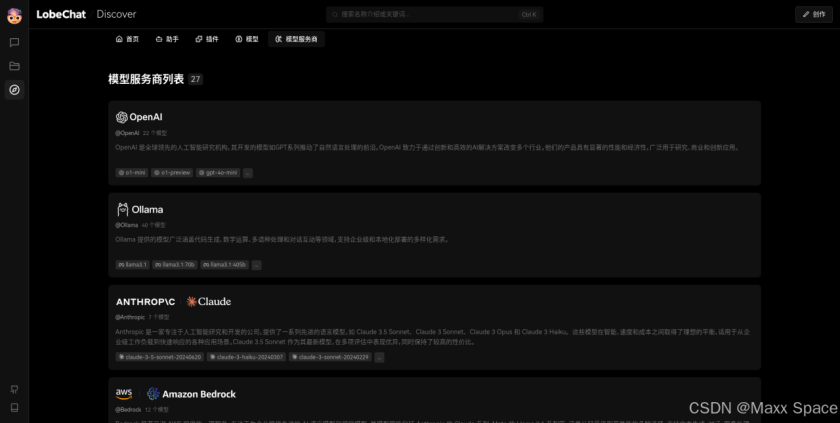

模型服務商分類,介紹各個模型服務商的信息,

點擊 OpenAI 查看,會介紹旗下的多個模型及其價格

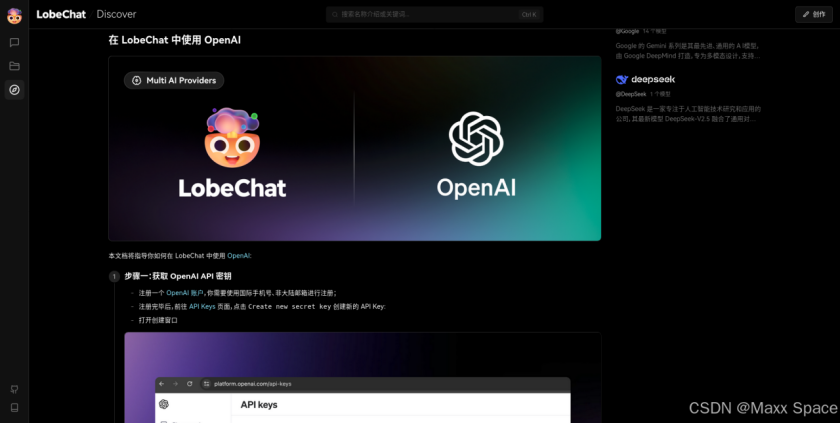

下面還有介紹在 LobeChat 中使用 OpenAI 的步驟

點擊配置服務商,直接進入語言模型設置

LobeChat 打開了對話助手的新世界,在不斷優化自身和擴展功能的過程中,LobeChat 努力為用戶帶來更加智能、靈活、多樣化的對話體驗。LobeChat 是一個開源、可擴展(函數調用)、高性能的聊天機器人框架,它支持一鍵免費部署您的私人 ChatGPT/LLM Web 應用程序。作為集成大模型的聊天應用的使用就是這些了,配置模型、使用模型并開啟對話,還有更多有趣的設置和功能就需要自行探索了。

四、總結

LobeChat,是一個集成了語音合成、多模態、可擴展插件系統的聊天框架。這一平臺最顯著的特性之一便是其多模型服務商的支持性,包括 AWS Bedrock、Google AI、Anthropic、ChatGLM 及其他多個全球知名模型服務商。此次使用的 Flexus X 實例配置還是很高的 4 核 12G-100G-3M 規格的基礎模式,此項目并不進行大模型的推理過程,而是一個聊天網站,主要通過集成其他大模型服務來輸出對話,整體占用的 CPU 和內存都不高,能夠很流暢的運行。

華為云服務器正值 828 B2B 企業節,限時促銷,性能卓越,安全可靠。現在購買,享受超值優惠,還有專業技術支持,助力企業騰飛。抓緊機會,立即行動!

審核編輯 黃宇

-

服務器

+關注

關注

12文章

9195瀏覽量

85511 -

開源

+關注

關注

3文章

3362瀏覽量

42526 -

ChatGPT

+關注

關注

29文章

1563瀏覽量

7746 -

大模型

+關注

關注

2文章

2474瀏覽量

2779

發布評論請先 登錄

相關推薦

怎樣搭建基于 ChatGPT 的聊天系統

ChatGPT 與傳統聊天機器人的比較

ChatGPT 適合哪些行業

Meta人工智能聊天機器人進軍新市場,挑戰ChatGPT

亞馬遜秘密研發AI聊天機器人Metis,挑戰ChatGPT

寶塔面板一鍵免費部署LobeChat聊天機器人開發自己私有的ChatGPT

在FPGA設計中是否可以應用ChatGPT生成想要的程序呢

微軟和OpenAI面臨關于ChatGPT和Copilot的更多訴訟指控

谷歌發布輕量級開源人工智能模型Gemma

英偉達推出全新AI聊天機器人

【國產FPGA+OMAPL138開發板體驗】(原創)6.FPGA連接ChatGPT 4

OpenAI推出Vision Pro版ChatGPT

ChatGPT遭安全風波:用戶敏感信息或遭泄露

LLMs時代進行無害性評估的基準解析

部署開源 ChatGPT/LLMs 聊天應用 LobeChat

部署開源 ChatGPT/LLMs 聊天應用 LobeChat

評論