一、Flexus 云服務(wù)器 X 實(shí)例概要

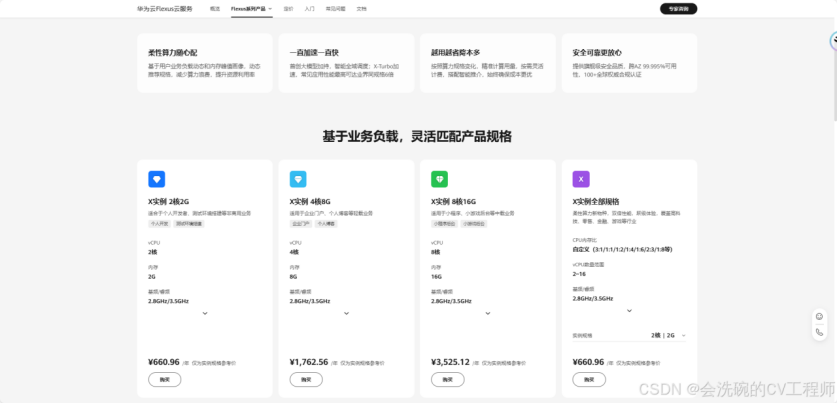

Flexus云服務(wù)器X實(shí)例是華為云推出的一款面向中小企業(yè)和開(kāi)發(fā)者的柔性算力云服務(wù)器。這款服務(wù)器的主要特點(diǎn)是其靈活的 vCPU 內(nèi)存配比,支持熱變配不中斷業(yè)務(wù)變更規(guī)格,以及能夠智能感知業(yè)務(wù)負(fù)載并自動(dòng)調(diào)整資源配置,如下圖。

?1.1 Flexus 云服務(wù)器 X 實(shí)例摘要

Flexus 云服務(wù)器 X 實(shí)例的設(shè)計(jì)理念是提供一個(gè)更加靈活和高效的計(jì)算資源管理方式。其通過(guò)智能調(diào)整資源配置,能夠更好地滿足不同業(yè)務(wù)的需求,提高資源利用率。此外,該實(shí)例還提供了豐富的公共鏡像供用戶選擇,方便快速部署各種應(yīng)用和服務(wù)。用戶還可以根據(jù)自己的需要靈活調(diào)整虛擬 CPU 和內(nèi)存的配比,以滿足不同場(chǎng)景的需求。

1.2 產(chǎn)品特點(diǎn)

除了之前提到的靈活的 vCPU 內(nèi)存配比、支持熱變配、智能感知業(yè)務(wù)負(fù)載以及出色的存儲(chǔ)性能外,F(xiàn)lexus 云服務(wù)器 X 實(shí)例的產(chǎn)品特點(diǎn)還包括以下幾個(gè)方面:

1.高性能與成本優(yōu)化:

1.Flexus X 實(shí)例通過(guò) X-Turbo 加速技術(shù),實(shí)現(xiàn)了性能上的顯著提升,為用戶帶來(lái)了倍增的性能體驗(yàn)。

2.該實(shí)例提供了經(jīng)濟(jì)型的價(jià)格和近乎旗艦級(jí)的性能,實(shí)現(xiàn)了躍級(jí)體驗(yàn),同時(shí)降低了算力成本。

2.廣泛的應(yīng)用場(chǎng)景:

1.Flexus X 實(shí)例覆蓋了高科技、零售、金融、游戲等多個(gè)行業(yè)的大多數(shù)通用工作負(fù)載場(chǎng)景,包括網(wǎng)絡(luò)應(yīng)用、數(shù)據(jù)庫(kù)、虛擬桌面、分析索引、微服務(wù)、CI/CD 等。

2.它能夠滿足多樣化的業(yè)務(wù)需求,為中小企業(yè)和開(kāi)發(fā)者提供即開(kāi)即用、超快部署的云計(jì)算解決方案。

3.安全性與可靠性:

1.Flexus X 實(shí)例擁有華為云旗艦級(jí)云服務(wù)器產(chǎn)品相同的單 AZ 99.975%可用性,跨 AZ 99.995%可用性,確保了服務(wù)的高可靠性。

2.該實(shí)例還提供了智能識(shí)別和全面的安全防護(hù)技術(shù),確保提供智能化且安全的云服務(wù)。

4.易用性與維護(hù)性:

1.Flexus X 實(shí)例內(nèi)置了豐富的解決方案與鏡像,支持零門檻快速搭建業(yè)務(wù)環(huán)境,輕松啟動(dòng)和管理業(yè)務(wù)。

2.用戶可以通過(guò)簡(jiǎn)單的配置和購(gòu)買流程,快速上手并使用該實(shí)例。

5.靈活的計(jì)費(fèi)模式:

1.Flexus X 實(shí)例支持包年/包月和按需計(jì)費(fèi)等多種計(jì)費(fèi)模式,用戶可以根據(jù)自己的業(yè)務(wù)需求選擇合適的計(jì)費(fèi)方式。

官網(wǎng)如下圖:

?1.3存儲(chǔ)方面性能

Flexus 云服務(wù)器 X 實(shí)例在存儲(chǔ)方面表現(xiàn)出色。它支持多種存儲(chǔ)類型,包括系統(tǒng)盤和數(shù)據(jù)盤,且系統(tǒng)盤為通用型 SSD,確保了數(shù)據(jù)讀寫的高速性和穩(wěn)定性。用戶可以根據(jù)自己的業(yè)務(wù)需求選擇合適的存儲(chǔ)類型和容量。此外,該實(shí)例還支持快照和備份功能,確保數(shù)據(jù)的安全性和可恢復(fù)性。在數(shù)據(jù)處理和存儲(chǔ)方面,F(xiàn)lexus 云服務(wù)器 X 實(shí)例滿足了現(xiàn)代企業(yè)對(duì)高性能和高可靠性的要求。

Flexus 云服務(wù)器 X 實(shí)例以其靈活的資源配置、高效的計(jì)算性能和可靠的存儲(chǔ)能力,成為了中小企業(yè)和開(kāi)發(fā)者的優(yōu)選云服務(wù)器產(chǎn)品。

接下來(lái),我們就利用 FIO 工具來(lái)測(cè)試一下 Flexus 云服務(wù)器 X 實(shí)例在存儲(chǔ)方面的性能怎么樣,主要從 IOPS,IO 延遲、IOPS 和吞吐量等方面進(jìn)行測(cè)試。

1.4 測(cè)評(píng)服務(wù)器規(guī)格

二、FIO 工具

FIO(Flexible I/O Tester)是一款開(kāi)源的磁盤 I/O 性能測(cè)試工具,旨在提供一種全方面的測(cè)試方案,能夠模擬常見(jiàn)的 I/O 場(chǎng)景,并記錄和評(píng)估存儲(chǔ)系統(tǒng)(如硬盤、固態(tài)硬盤、網(wǎng)絡(luò)存儲(chǔ)等)在不同負(fù)載條件下的輸入/輸出(I/O)性能。該工具廣泛應(yīng)用于標(biāo)準(zhǔn)測(cè)試、QA(質(zhì)量保證)、驗(yàn)證測(cè)試等領(lǐng)域,并支持多種操作系統(tǒng),如 Linux、FreeBSD、NetBSD、OS X、OpenSolaris、AIX、HP-UX、Windows 等。對(duì)于存儲(chǔ)性能的測(cè)試,首選就是 FIO。在本次測(cè)評(píng)中測(cè)試示例均使用 fio jobfile 方式,即通過(guò)一個(gè) job 文件來(lái)描述待訪真的 IO 負(fù)載,一個(gè) job 文件可以控制產(chǎn)生任意數(shù)目的線程和文件,典型的 job 文件包含一個(gè) global 段(定義共享參數(shù))和一個(gè)或多少 job 段(描述具體要產(chǎn)生的 job)。

2.1 安裝部署 FIO

其下載地址:https://brick.kernel.dk/snaps/fio-2.1.10.tar.gz

或者登錄其官網(wǎng):http://freshmeat.sourceforge.net/projects/fio/進(jìn)行下載。但是官網(wǎng)很難找得到入口在哪,還是直接訪問(wèn)第一個(gè)鏈接就可以下載了。

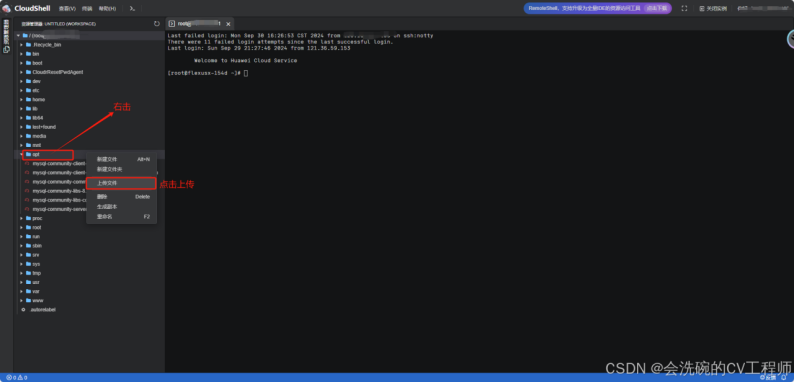

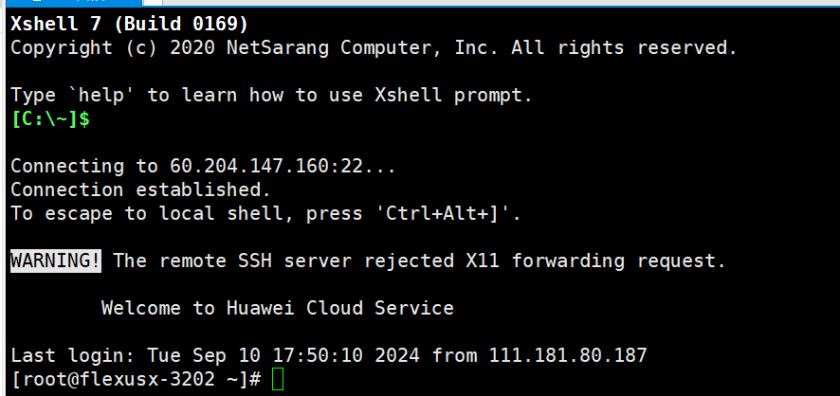

接下來(lái)我們上傳到服務(wù)器中,還是老規(guī)矩,我們使用 cloudshell 遠(yuǎn)程登陸我們的服務(wù)器。接下來(lái)我們將剛剛下載的 FIO 壓縮包上傳到服務(wù)器的 opt 目錄下:如下圖所示:

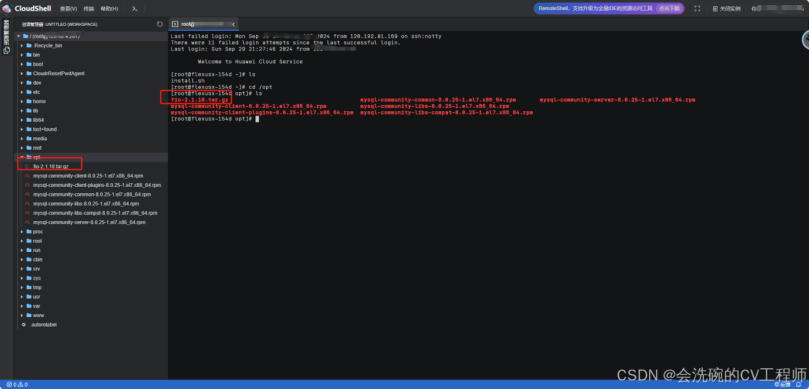

OK,我們輸入 ls 命令看看是否上傳成功。

?可以看得到,我們的安裝包已經(jīng)上傳進(jìn)去了,右側(cè)文件管理器也有該壓縮包。接下來(lái)我們解壓安裝:

執(zhí)行以下命令解壓縮安裝包到我們的/usr/local 目錄下:

tar -zxvf fio-2.1.10.tar.gz -C /usr/local

注意:這里最好是先安裝好下面兩個(gè)依賴再執(zhí)行,上面的安裝命令,這里我忘記了,因此還要重新編譯 fio

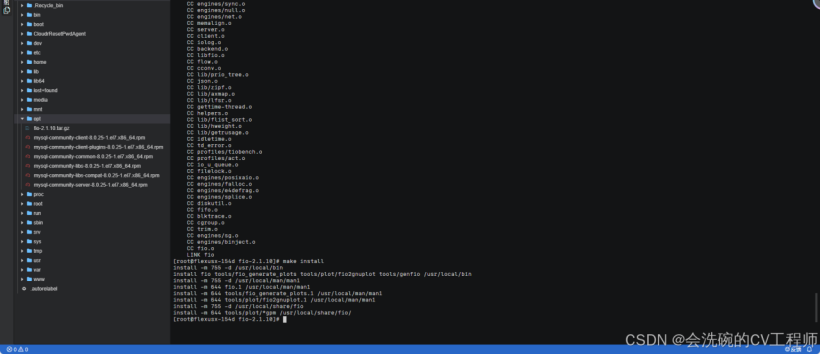

按順序執(zhí)行以下命令進(jìn)行安裝:

cd /usr/local/fio-2.1.10

./configure

make

make install

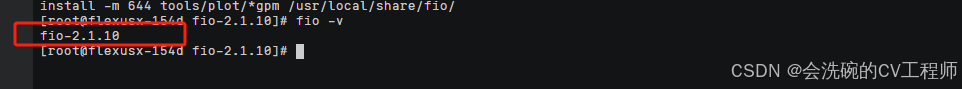

?OK,到這里我們就基本安裝完成了,然后使用 fio -v 命令查看一下版本看看是否安裝好:

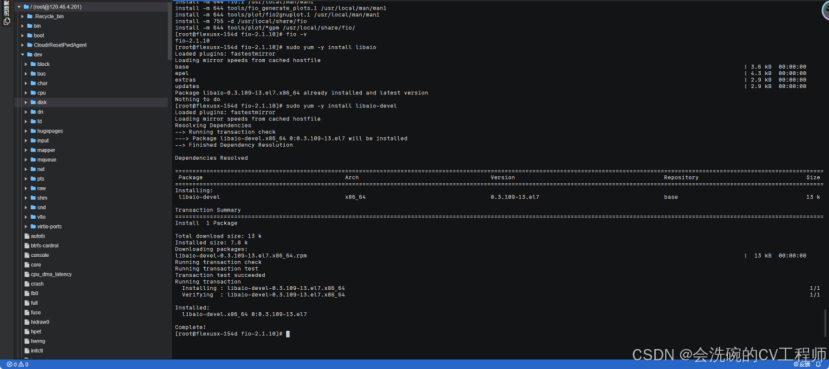

?因?yàn)?fio 還需要 libaio 依賴,然后依次執(zhí)行以下命令,安裝 libaio:

sudo yum -y install libaio

sudo yum -y install libaio-devel

注意:這里最好是先安裝好上面兩個(gè)依賴再執(zhí)行,上面的安裝命令,這里我忘記了,因此還要重新編譯 fio

?

可以看到我們已經(jīng)安裝好了。

2.2 主要性能指標(biāo)概要

下列這些都是服務(wù)器關(guān)于存儲(chǔ)性能的相關(guān)指標(biāo)

1.IOPS(Input/Output Operations Per Second):

1.定義:每秒的輸入輸出操作次數(shù),是衡量存儲(chǔ)設(shè)備性能的重要指標(biāo)之一。

2.重要性:IOPS 越高,表示存儲(chǔ)設(shè)備在單位時(shí)間內(nèi)能夠處理的 I/O 操作越多,性能越好。

2.吞吐量(Throughput):

1.定義:存儲(chǔ)設(shè)備在單位時(shí)間內(nèi)傳輸?shù)臄?shù)據(jù)量。

2.重要性:吞吐量越大,表示存儲(chǔ)設(shè)備的數(shù)據(jù)傳輸速度越快,性能越好。

3.延遲(Latency):

1.定義:I/O 操作的響應(yīng)時(shí)間,即從發(fā)出 I/O 請(qǐng)求到接收到響應(yīng)的時(shí)間。

2.重要性:延遲越小,表示存儲(chǔ)設(shè)備的響應(yīng)速度越快,用戶體驗(yàn)越好。

4.CPU 利用率:

1.定義:在執(zhí)行 I/O 操作時(shí),CPU 的使用率。

2.重要性:CPU 利用率反映了 I/O 操作對(duì)系統(tǒng)資源的占用情況,過(guò)高的 CPU 利用率可能導(dǎo)致系統(tǒng)性能下降。

5.I/O 深度:

1.定義:并發(fā)發(fā)出的 I/O 請(qǐng)求數(shù),也稱為隊(duì)列深度。

2.重要性:I/O 深度越大,表示存儲(chǔ)設(shè)備能夠同時(shí)處理的 I/O 請(qǐng)求越多,可能提高系統(tǒng)的吞吐量。

6.讀寫塊大小:

1.定義:每次 I/O 操作傳輸?shù)臄?shù)據(jù)塊大小。

2.重要性:讀寫塊大小對(duì)存儲(chǔ)設(shè)備的性能有顯著影響,不同的塊大小可能導(dǎo)致不同的 IOPS 和吞吐量。

三、進(jìn)行壓測(cè)

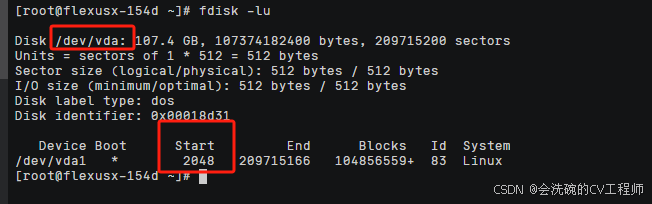

不過(guò)在測(cè)試之前,我們需要執(zhí)行以下命令查看存儲(chǔ)設(shè)備是否已經(jīng) 4KiB 對(duì)齊。如果不是 4KiB 對(duì)齊,則對(duì)性能影響較大。fdisk -lu 如果返回的 Start 值能夠被 8 整除則表示 4KiB 對(duì)齊。

?可以看得到,我們這里的 start 值為 2048,2048%4 = 0 是合適的。

執(zhí)行以下命令,切換路徑。cd /tmp

3.1 測(cè)試全盤隨機(jī)讀 IO 延遲

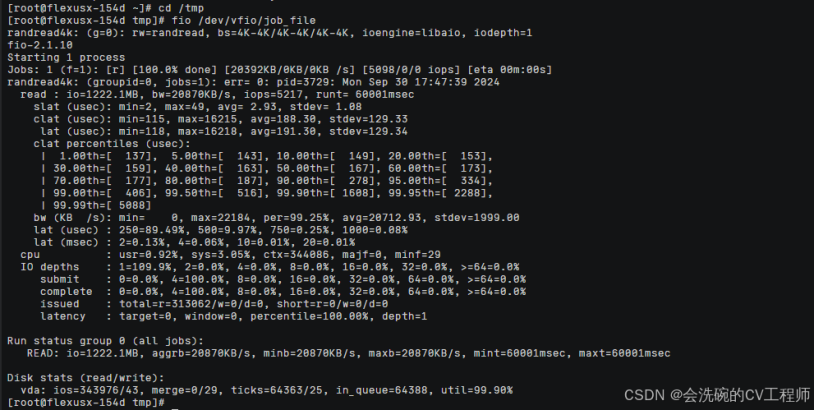

創(chuàng)建 job_file 文件測(cè)試隨機(jī)讀的 IO 延遲,文件內(nèi)容如下。創(chuàng)建后,執(zhí)行命令 fio job_file 查看測(cè)試結(jié)果。

[global]ioengine=libaiouserspace_reapruntime=60direct=1group_reportingrandrepeat=0norandommapramp_time=6iodepth=1numjobs=1exitall[randread4k]filename=/dev/vda1rw=randreadbs=4K

?這個(gè)測(cè)試結(jié)果是通過(guò)fio工具進(jìn)行的隨機(jī)讀取測(cè)試,具體是針對(duì) 4KB 大小的塊進(jìn)行的。以下是對(duì)測(cè)試結(jié)果的詳細(xì)解讀:

性能指標(biāo)

·總讀取量:1222.1MB

·帶寬:20870KB/s(平均)

·IOPS:5217(每秒輸入輸出操作數(shù))

延遲統(tǒng)計(jì)

·服務(wù)時(shí)間(slat):平均 2.93 微秒,標(biāo)準(zhǔn)差 1.08 微秒

·完成時(shí)間(clat):平均 188.30 微秒,標(biāo)準(zhǔn)差 129.33 微秒

·總延遲(lat):平均 191.30 微秒,標(biāo)準(zhǔn)差 129.34 微秒

·完成時(shí)間百分位數(shù):

o1%:137 微秒

o5%:143 微秒

o10%:149 微秒

o...

o99.99%:5088 微秒(即 5.088 毫秒)

帶寬分布

·最小帶寬:0KB/s

·最大帶寬:22184KB/s

·99.25%的時(shí)間內(nèi),帶寬在 20712.93KB/s 左右

延遲分布

·250 微秒以內(nèi):89.49%

·500 微秒以內(nèi):99.46%(包括 250 微秒以內(nèi)的)

·1 毫秒以內(nèi):99.60%(包括 500 微秒以內(nèi)的)

·2 毫秒以內(nèi):99.73%(包括 1 毫秒以內(nèi)的)

·...

CPU 使用情況

·用戶態(tài) CPU 使用率:0.92%

·系統(tǒng)態(tài) CPU 使用率:3.05%

IO 深度與提交/完成狀態(tài)

·所有 IO 操作都在 IO 深度為 1 時(shí)完成

·提交和完成操作都集中在 4 個(gè)塊大小(即 16KB)的批次上

磁盤統(tǒng)計(jì)

·vda(虛擬磁盤設(shè)備):

o讀取 IO 操作數(shù):343976

o寫入 IO 操作數(shù):43(很少,可能是元數(shù)據(jù)或后臺(tái)操作)

o合并讀取操作:0(沒(méi)有合并)

o合并寫入操作:29(有一些合并)

o隊(duì)列中時(shí)間:64388 個(gè) ticks(表示磁盤忙碌程度)

o磁盤利用率:99.90%

總結(jié)

這個(gè)測(cè)試結(jié)果表明,在隨機(jī)讀取 4KB 塊的情況下,系統(tǒng)能夠達(dá)到約 20870KB/s 的帶寬和 5217 IOPS 的性能。延遲方面,大部分讀取操作在 250 微秒以內(nèi)完成,99.99%的讀取操作在 5 毫秒以內(nèi)完成。CPU 使用率相對(duì)較低,表明測(cè)試期間 CPU 不是瓶頸。磁盤利用率非常高,接近 100%,說(shuō)明磁盤在測(cè)試期間幾乎一直在忙碌。

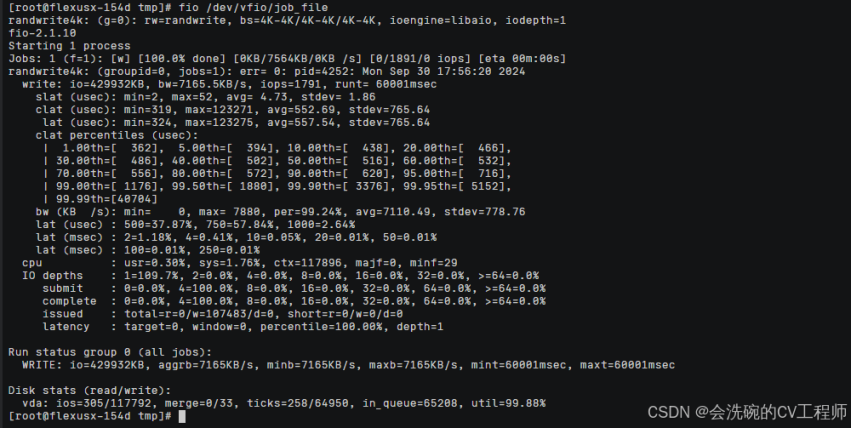

3.2 測(cè)試全盤隨機(jī)寫 IO 延遲

創(chuàng)建 job_file 文件測(cè)試隨機(jī)讀的 IO 延遲,文件內(nèi)容如下。創(chuàng)建后,執(zhí)行命令 fio job_file 查看測(cè)試結(jié)果。

[global]

ioengine=libaio

userspace_reap

time_based runtime=60

direct=1

group_reporting randrepeat=0

norandommap ramp_time=6

iodepth=1

numjobs=1

exitall

[randwrite4k]

filename=/dev/vda1

rw=randwrite bs=4K

?下面就是上述結(jié)果的解讀:

總體性能指標(biāo)

·

o總寫入數(shù)據(jù)量:429932KB(約 420MB)

o平均帶寬:7165.5KB/s(或約 7.17MB/s)

o每秒 I/O 操作次數(shù)(IOPS):1791

o運(yùn)行時(shí)間:60001 毫秒(60 秒)

·

提交時(shí)延(slat):

·

o最小值:2 微秒

o最大值:52 微秒

o平均值:4.73 微秒

o標(biāo)準(zhǔn)差:1.86 微秒

o提交時(shí)延主要由服務(wù)器處理器和操作系統(tǒng)決定,也受 SSD 的接口協(xié)議和工作模式影響。在這個(gè)測(cè)試中,提交時(shí)延非常低且穩(wěn)定。

·

完成時(shí)延(clat):

·

o最小值:319 微秒

o最大值:123271 微秒(即 123.271 毫秒)

o平均值:552.69 微秒

o標(biāo)準(zhǔn)差:765.64 微秒

o完成時(shí)延主要由 SSD 決定,反映了從 I/O 提交到 I/O 完成的時(shí)長(zhǎng)。在這個(gè)測(cè)試中,完成時(shí)延的波動(dòng)較大,但平均值仍在可接受范圍內(nèi)。

·

總時(shí)延(lat):

·

o最小值:324 微秒

o最大值:123275 微秒(即 123.275 毫秒)

o平均值:557.54 微秒

o標(biāo)準(zhǔn)差:765.64 微秒

o總時(shí)延是提交時(shí)延和完成時(shí)延之和,反映了從 fio 創(chuàng)建 I/O 到 I/O 完成的時(shí)長(zhǎng)。

·最小帶寬:0KB/s(測(cè)試開(kāi)始時(shí))

·最大帶寬:7880KB/s

·帶寬利用率:99.24%

·平均帶寬:7110.49KB/s(與平均帶寬指標(biāo)略有差異,但相差不大)

·標(biāo)準(zhǔn)差:778.76KB/s

·

CPU 使用率:

·

o用戶態(tài):0.30%

o系統(tǒng)態(tài):1.76%

o上下文切換次數(shù):117896 次

oCPU 使用率較低,表明測(cè)試對(duì) CPU 資源的消耗不大。

·

I/O 深度:

·

oI/O 深度為 1 時(shí),占比為 109.7%(超過(guò) 100%可能是因?yàn)樗纳嵛迦牖虿l(fā) I/O 請(qǐng)求數(shù)略有波動(dòng))

o其他 I/O 深度(2、4、8、16、32、>=64)的占比均為 0%

o這表明測(cè)試期間主要使用的是 I/O 深度為 1 的并發(fā) I/O 請(qǐng)求。

·

磁盤 I/O 操作數(shù):

·

o讀操作數(shù):305 次

o寫操作數(shù):117792 次

o合并讀操作數(shù):0 次

o合并寫操作數(shù):33 次

o磁盤主要忙于寫操作。

·

磁盤忙碌時(shí)間:

·

o讀操作忙碌時(shí)間:258 個(gè) ticks

o寫操作忙碌時(shí)間:64950 個(gè) ticks

o隊(duì)列中等待時(shí)間:65208 個(gè) ticks

o磁盤利用率:99.88%

o磁盤在測(cè)試期間幾乎一直處于忙碌狀態(tài)。

這份 fio 測(cè)試結(jié)果表明,存儲(chǔ)系統(tǒng)在執(zhí)行 4KB 大小的隨機(jī)寫入操作時(shí)表現(xiàn)出良好的性能。盡管完成時(shí)延存在一定的波動(dòng),但平均帶寬和 IOPS 均保持在較高水平。同時(shí),CPU 使用率較低,磁盤利用率較高,表明測(cè)試期間存儲(chǔ)系統(tǒng)得到了充分的利用。

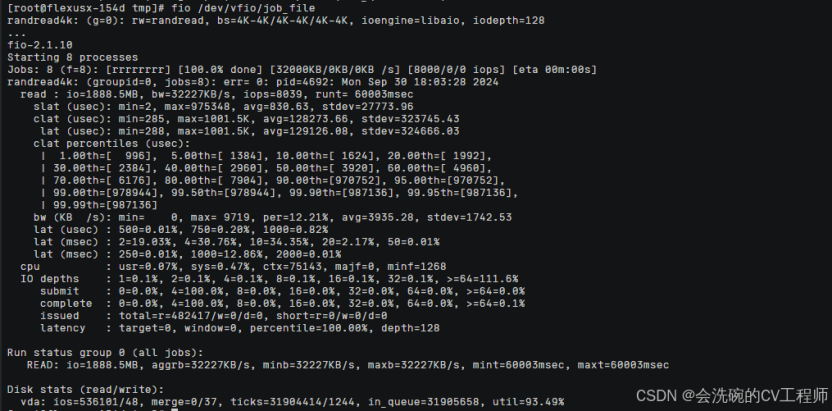

3.3 測(cè)試隨機(jī)讀 IOPS

創(chuàng)建 job_file 文件測(cè)試隨機(jī)讀的 IOPS,文件內(nèi)容如下。創(chuàng)建后,執(zhí)行命令 fio job_file 查看測(cè)試結(jié)果。

[global]ioengine=libaiouserspace_reaptime_basedruntime=60direct=1group_reportingrandrepeat=0norandommapramp_time=6iodepth=128numjobs=8exitall[randread4k]filename=/dev/vda1rw=randreadbs=4k

?這份 fio 測(cè)試結(jié)果提供了關(guān)于存儲(chǔ)系統(tǒng)在執(zhí)行 4KB 大小的隨機(jī)讀取操作時(shí)的詳細(xì)性能數(shù)據(jù)。以下是對(duì)測(cè)試結(jié)果的詳細(xì)解讀:

總體性能指標(biāo)

·總讀取數(shù)據(jù)量:1888.5MB

·平均帶寬:32227KB/s(或約 32.23MB/s)

·每秒 I/O 操作次數(shù)(IOPS):8039

·運(yùn)行時(shí)間:60003 毫秒(60 秒)

時(shí)延分析

·提交時(shí)延(slat):

o最小值:2 微秒

o最大值:975348 微秒(即 0.975 秒)

o平均值:830.63 微秒

o標(biāo)準(zhǔn)差:27773.96 微秒

o提交時(shí)延的波動(dòng)較大,但平均值仍在可接受范圍內(nèi)。這可能是由于系統(tǒng)負(fù)載、中斷處理等因素導(dǎo)致的。

·完成時(shí)延(clat):

o最小值:285 微秒

o最大值:1001.5K 微秒(即 1001.5 毫秒或 1 秒)

o平均值:128273.66 微秒(即 128.27 毫秒)

o標(biāo)準(zhǔn)差:323745.43 微秒

o完成時(shí)延的波動(dòng)非常大,且平均值較高。這表明存儲(chǔ)系統(tǒng)在處理隨機(jī)讀取請(qǐng)求時(shí)存在較大的延遲。

·總時(shí)延(lat):

o最小值:288 微秒

o最大值:1001.5K 微秒(即 1001.5 毫秒或 1 秒)

o平均值:129126.08 微秒(即 129.13 毫秒)

o標(biāo)準(zhǔn)差:324666.03 微秒

o總時(shí)延的波動(dòng)和平均值都與完成時(shí)延相似,因?yàn)橥瓿蓵r(shí)延在總時(shí)延中占主導(dǎo)地位。

此外,測(cè)試還提供了時(shí)延的百分位數(shù)數(shù)據(jù)。例如,99.99%的 I/O 操作在 987136 微秒(即 0.987 毫秒)內(nèi)完成,但需要注意的是,這里的 99.99%百分位數(shù)實(shí)際上受到了極端值的影響,因?yàn)榇蟛糠植僮鞯耐瓿蓵r(shí)延都遠(yuǎn)低于這個(gè)值。

帶寬分析

·最小帶寬:0KB/s(測(cè)試開(kāi)始時(shí))

·最大帶寬:9719KB/s

·帶寬利用率和平均值等數(shù)據(jù)在測(cè)試報(bào)告中未直接給出百分比形式,但可以通過(guò)計(jì)算得出。例如,平均帶寬為 3935.28KB/s(在多個(gè)并發(fā) I/O 請(qǐng)求下測(cè)得),這表明存儲(chǔ)系統(tǒng)在測(cè)試期間能夠提供穩(wěn)定的帶寬輸出。然而,與平均帶寬 32227KB/s(整體測(cè)試的平均值)相比,單個(gè)請(qǐng)求的帶寬波動(dòng)較大。

磁盤統(tǒng)計(jì)信息

·磁盤 I/O 操作數(shù):

o讀操作數(shù):536101 次

o寫操作數(shù):48 次(幾乎可以忽略不計(jì))

o磁盤主要忙于讀操作。

·磁盤合并操作數(shù):

o讀操作合并數(shù):0 次(表明讀操作沒(méi)有被合并)

o寫操作合并數(shù):37 次(但寫操作次數(shù)很少,所以合并操作的影響不大,因?yàn)檫@里我們主要測(cè)試的是隨機(jī)讀情況下的 IOPS)

·磁盤忙碌時(shí)間:

o讀操作忙碌時(shí)間:31904414 個(gè) ticks(表明磁盤在測(cè)試期間幾乎一直處于忙碌狀態(tài))

o寫操作忙碌時(shí)間:1244 個(gè) ticks(很少)

o隊(duì)列中等待時(shí)間:31905658 個(gè) ticks(與讀操作忙碌時(shí)間相近)

o磁盤利用率:93.49%(表明磁盤在測(cè)試期間得到了充分的利用)

這份 fio 測(cè)試結(jié)果表明,存儲(chǔ)系統(tǒng)在執(zhí)行 4KB 大小的隨機(jī)讀取操作時(shí),雖然能夠提供較高的平均帶寬和 IOPS,但完成時(shí)延的波動(dòng)較大且平均值較高。但是這可能是由于存儲(chǔ)系統(tǒng)的內(nèi)部機(jī)制、磁盤性能或系統(tǒng)負(fù)載等因素導(dǎo)致的。為了改善性能,可以考慮優(yōu)化存儲(chǔ)系統(tǒng)的配置、升級(jí)硬件或降低系統(tǒng)負(fù)載等方法。同時(shí),進(jìn)行更多類型的測(cè)試(如順序讀、混合讀寫等)并分析測(cè)試結(jié)果也是很有必要的。 但整體下面我們主要測(cè)試的是隨機(jī)讀的情況下。

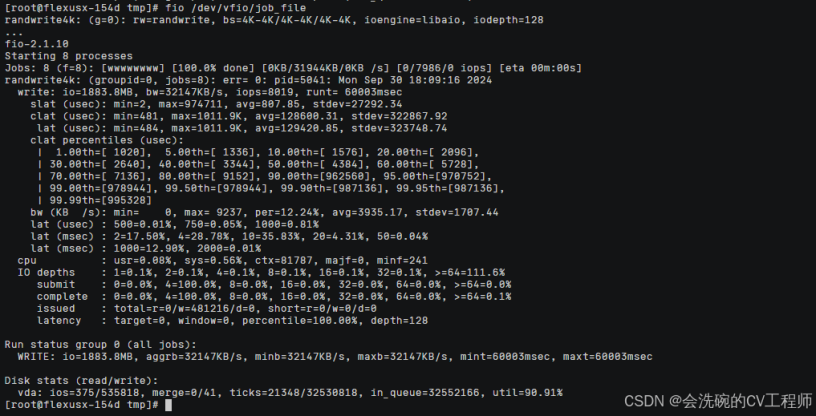

3.4 測(cè)試隨機(jī)寫 IOPS

創(chuàng)建 job_file 文件測(cè)試隨機(jī)寫的 IOPS,文件內(nèi)容如下。創(chuàng)建后,執(zhí)行命令 fio job_file 查看測(cè)試結(jié)果。

[global]ioengine=libaiouserspace_reaptime_basedruntime=60direct=1group_reportingrandrepeat=0norandommapramp_time=6iodepth=128numjobs=8exitall[randwrite4k]filename=/dev/vda1rw=randwritebs=4k

?

這份 fio 測(cè)試結(jié)果提供了關(guān)于存儲(chǔ)系統(tǒng)在執(zhí)行 4KB 大小的隨機(jī)寫入操作時(shí)的詳細(xì)性能數(shù)據(jù)。以下是對(duì)測(cè)試結(jié)果的解讀:

總體性能指標(biāo)

·總寫入數(shù)據(jù)量:1883.8MB

·平均帶寬:32147KB/s(或約 32.15MB/s)

·每秒 I/O 操作次數(shù)(IOPS):8019

·運(yùn)行時(shí)間:60003 毫秒(60 秒)

時(shí)延分析

·提交時(shí)延(slat):

o最小值:2 微秒

o最大值:974711 微秒(即 0.975 秒)

o平均值:807.85 微秒

o標(biāo)準(zhǔn)差:27292.34 微秒

o提交時(shí)延的波動(dòng)較大,但平均值在可接受范圍內(nèi),表明系統(tǒng)處理 I/O 請(qǐng)求的中斷和調(diào)度效率尚可。

·完成時(shí)延(clat):

o最小值:481 微秒

o最大值:1011.9K 微秒(即 1011.9 毫秒或 1 秒多)

o平均值:128600.31 微秒(即 128.6 毫秒)

o標(biāo)準(zhǔn)差:322867.92 微秒

o完成時(shí)延的波動(dòng)非常大,且平均值較高。這表明存儲(chǔ)系統(tǒng)在處理隨機(jī)寫入請(qǐng)求時(shí)存在較大的延遲,可能是由于磁盤性能瓶頸、存儲(chǔ)系統(tǒng)內(nèi)部處理機(jī)制或系統(tǒng)負(fù)載等因素導(dǎo)致的。

·總時(shí)延(lat):

o最小值:484 微秒

o最大值:1011.9K 微秒(即 1011.9 毫秒或 1 秒多)

o平均值:129420.85 微秒(即 129.42 毫秒)

o標(biāo)準(zhǔn)差:323748.74 微秒

o總時(shí)延的波動(dòng)和平均值與完成時(shí)延相似,因?yàn)橥瓿蓵r(shí)延在總時(shí)延中占主導(dǎo)地位。

此外,測(cè)試還提供了時(shí)延的百分位數(shù)數(shù)據(jù)。例如,99.99%的 I/O 操作在 995328 微秒(即 0.995 毫秒)內(nèi)完成,但需要注意的是,這里的 99.99%百分位數(shù)實(shí)際上受到了極端值的影響,因?yàn)榇蟛糠植僮鞯耐瓿蓵r(shí)延都遠(yuǎn)低于這個(gè)值。

帶寬分析

·最小帶寬:0KB/s(測(cè)試開(kāi)始時(shí))

·最大帶寬:9237KB/s

·平均帶寬利用率和值等數(shù)據(jù)表明,存儲(chǔ)系統(tǒng)在測(cè)試期間能夠提供穩(wěn)定的帶寬輸出,但單個(gè)請(qǐng)求的帶寬波動(dòng)較大。

CPU 和 I/O 深度

·CPU 使用率:

o用戶態(tài):0.08%

o系統(tǒng)態(tài):0.56%

oCPU 使用率非常低,表明測(cè)試對(duì) CPU 資源的消耗很小。

·I/O 深度:

o在測(cè)試期間,主要使用的是 I/O 深度大于等于 64 的并發(fā) I/O 請(qǐng)求(占比 111.6%,超過(guò) 100%可能是因?yàn)樗纳嵛迦牖虿l(fā) I/O 請(qǐng)求數(shù)略有波動(dòng))。

o提交和完成 I/O 請(qǐng)求時(shí),主要使用的是 4KB 大小的塊(占比 100%)。

磁盤統(tǒng)計(jì)信息

·磁盤 I/O 操作數(shù):

o讀操作數(shù):375 次(很少,因?yàn)橹饕菍懭霚y(cè)試)

o寫操作數(shù):535818 次

o磁盤主要忙于寫操作。

·磁盤合并操作數(shù):

o讀操作合并數(shù):0 次

o寫操作合并數(shù):41 次(寫操作合并次數(shù)相對(duì)較多,但考慮到寫操作總數(shù)很大,合并比例仍然很低,因?yàn)槲覀冞@里主要是測(cè)試隨機(jī)寫的 IOPS)

·磁盤忙碌時(shí)間:

o讀操作忙碌時(shí)間:21348 個(gè) ticks(很少)

o寫操作忙碌時(shí)間:32530818 個(gè) ticks(表明磁盤在測(cè)試期間幾乎一直處于忙碌狀態(tài))

o隊(duì)列中等待時(shí)間:32552166 個(gè) ticks(與寫操作忙碌時(shí)間相近)

o磁盤利用率:90.91%(表明磁盤在測(cè)試期間得到了充分的利用)

綜上所述,這份 fio 測(cè)試結(jié)果表明,存儲(chǔ)系統(tǒng)在執(zhí)行 4KB 大小的隨機(jī)寫入操作時(shí),雖然能夠提供較高的平均帶寬和 IOPS,但完成時(shí)延的波動(dòng)較大且平均值較高。這可能是由于存儲(chǔ)系統(tǒng)的內(nèi)部機(jī)制、磁盤性能或系統(tǒng)負(fù)載等因素導(dǎo)致的。為了改善性能,可以考慮優(yōu)化存儲(chǔ)系統(tǒng)的配置、升級(jí)硬件(如使用更快的 SSD)、調(diào)整 I/O 調(diào)度策略或降低系統(tǒng)負(fù)載等方法。同時(shí),進(jìn)行更多類型的測(cè)試(如順序?qū)憽⒒旌献x寫等)并分析測(cè)試結(jié)果也是很有必要的。

整體感覺(jué)來(lái)說(shuō),還是非常不錯(cuò)的,帶寬方面也可以提供穩(wěn)定輸出,且磁盤的隨機(jī)讀寫性能都非常好。

結(jié)合上面測(cè)評(píng)來(lái)說(shuō),華為云 Flexus 云服務(wù)器 X 實(shí)例以其柔性算力、高性能加速、成本優(yōu)化和安全可靠等特點(diǎn),成為中小企業(yè)在 828 企業(yè)節(jié)期間選擇云服務(wù)的優(yōu)選之一。如果您正在尋找一款性價(jià)比高、性能卓越的云服務(wù)器產(chǎn)品,不妨考慮華為云 Flexus 云服務(wù)器 X 實(shí)例。點(diǎn)擊下方卡片立即跳轉(zhuǎn)查看吧:

Flexus云服務(wù)器X實(shí)例-華為云Flexus云服務(wù)器X實(shí)例(Flexus X)是柔性算力,六倍性能,旗艦體驗(yàn),覆蓋高科技、零售、金融、游戲等行業(yè)大多數(shù)通用工作負(fù)載場(chǎng)景。

https://www.huaweicloud.com/product/flexus-x.html

審核編輯 黃宇

-

云服務(wù)器

+關(guān)注

關(guān)注

0文章

639瀏覽量

13369 -

華為云

+關(guān)注

關(guān)注

3文章

2566瀏覽量

17455

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

華為云 Flexus 云服務(wù)器 X 實(shí)例部署 Trilium Notes 知識(shí)庫(kù)工具

Flexus X 實(shí)例服務(wù)器網(wǎng)絡(luò)性能深度評(píng)測(cè)

華為云 Flexus 云服務(wù)器 X 實(shí)例部署 Note Mark 筆記工具

華為云 Flexus 云服務(wù)器 X 實(shí)例之 Docker 環(huán)境下部署 JmalCloud 個(gè)人網(wǎng)盤

華為云 Flexus 云服務(wù)器 X 實(shí)例下的微微 CMS 安裝

華為云 Flexus 云服務(wù)器 X 實(shí)例的使用教程

Flexus 云服務(wù)器 X 實(shí)例:在 Docker 環(huán)境下搭建 java 開(kāi)發(fā)環(huán)境

華為云 Flexus 云服務(wù)器 X 實(shí)例之 openEuler 系統(tǒng)下部署 CodeX Docs 文檔工具

基于華為云 Flexus 云服務(wù)器 X 實(shí)例部搭建 Halo 博客平臺(tái)

華為云 Flexus X 實(shí)例 MySQL 性能加速評(píng)測(cè)及對(duì)比

基于華為云 Flexus 云服務(wù)器 X 實(shí)例搭建 Linux 學(xué)習(xí)環(huán)境

華為 Flexus 云服務(wù)器 X 實(shí)例 使用流程

云服務(wù)器 Flexus X 實(shí)例 MySQL 應(yīng)用加速測(cè)試

利用 FIO 工具測(cè)試 Flexus 云服務(wù)器 X 實(shí)例存儲(chǔ)性能

利用 FIO 工具測(cè)試 Flexus 云服務(wù)器 X 實(shí)例存儲(chǔ)性能

評(píng)論