眾所周知,過去一年間,大語言模型(LLM)領域經歷了翻天覆地的變化...

回望2023年底,OpenAI的GPT-4還是一座難以逾越的高峰,其他AI實驗室都在思考同一個問題:OpenAI究竟掌握了哪些獨特的技術秘密?

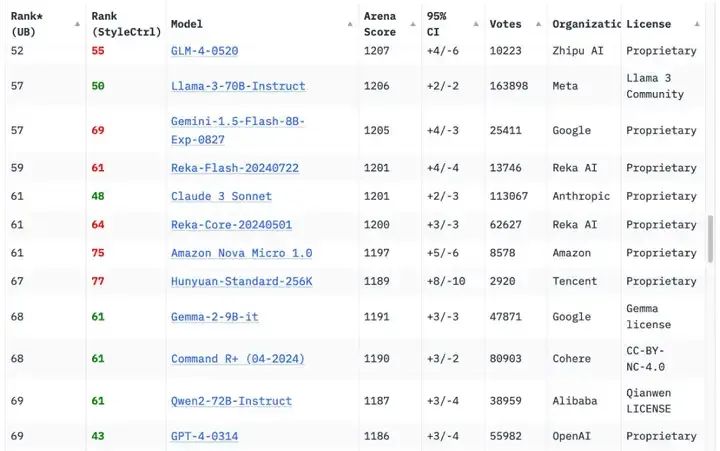

一年后的今天,形勢已發生根本性轉變,據Chatbot Arena排行榜顯示,原始版本的GPT-4(GPT-4-0314)已跌至第70位左右。目前,已有18家機構的70個模型在性能上超越了這個曾經的標桿。

圖源:Chatbot Arena

隨著2025年的嶄新啟航,是否意味著AI圈的一顆“王炸”已悄然“引爆”?

近日,國產大模型DeepSeek推出DeepSeek-V3,一個強大的混合專家(Mixture-of-Experts, MoE)語言模型,DeepSeek-V3擁有高達6710億的參數規模,但每次推理僅激活370億參數。

尤其,當o1、Claude、Gemini和Llama 3等模型還在為數億美元的訓練成本苦惱時, DeepSeek-V3用557.6萬美元的預算,在2048個H800 GPU集群上僅花費3.7天/萬億tokens的訓練時間,就達到了足以與它們比肩的性能 。

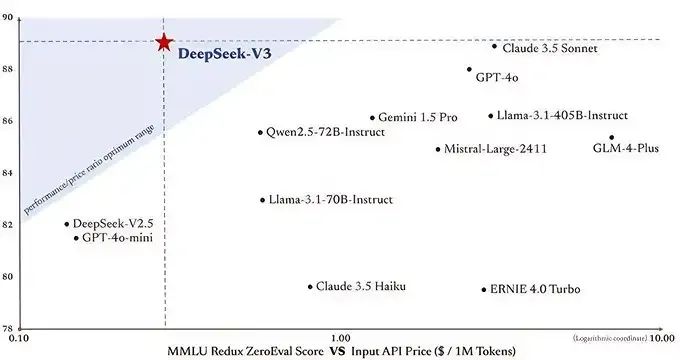

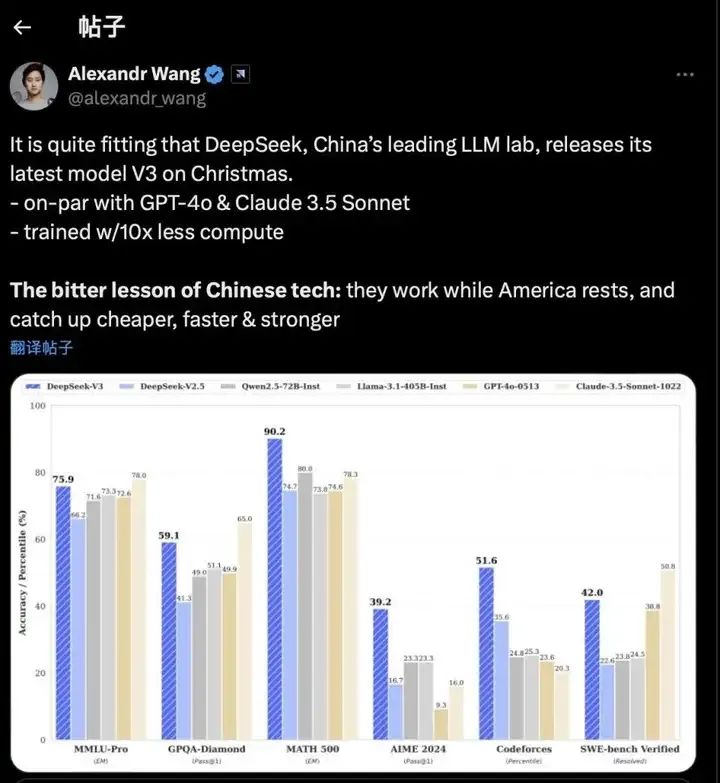

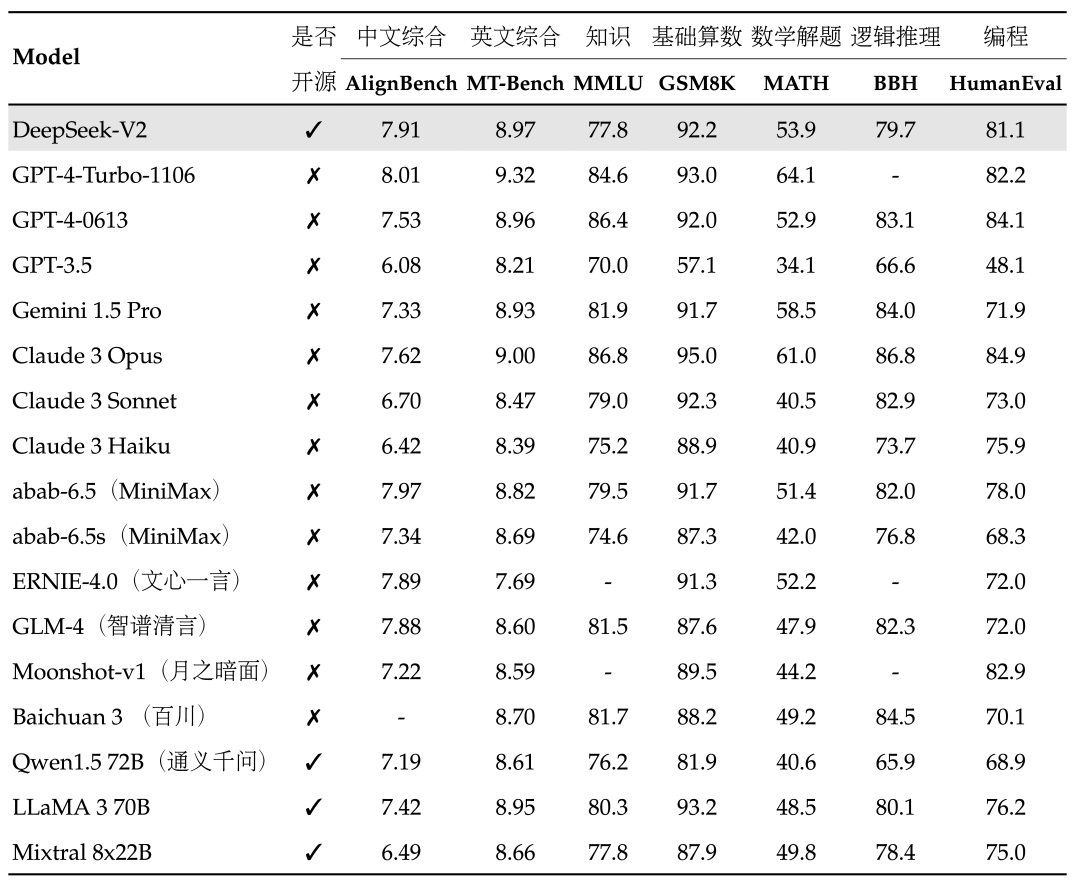

與此同時,DeepSeek-V3相比其他前沿大模型,性能卻足以比肩乃至更優。

DeepSeek-V3與其他大模型性能對比

其中,這種設計使得模型在性能和效率上實現了完美平衡,在多項模型測評中,DeepSeek-V3不僅超越了Llama 3.1 405B等頂級開源模型,更在代碼、數學、長文本處理等領域,與GPT-4o和Claude 3.5 Sonnet等閉源模型分庭抗禮。

其次,通過671B的總參數量,在每個token激活37B參數的精準控制下,DeepSeek-V3用14.8萬億高質量多樣化token,構建出了一個能夠超越所有開源模型,直逼GPT-4和Claude-3.5的AI巨人。

另外,在基礎理解能力測試中,DeepSeek-V3與Claude-3.5模型面對中文腦筋急轉彎“小明的媽媽有三個孩子”的問題,DeepSeek V3表現出色,不僅答對還進行了自我驗證。但在英文雙關語“April Fool's Day”的測試中則略顯不足,未能理解其中的語言巧思,而Claude3.5Sonnet則輕松應對。

DeepSeek-V3與Claude-3.5實測對比

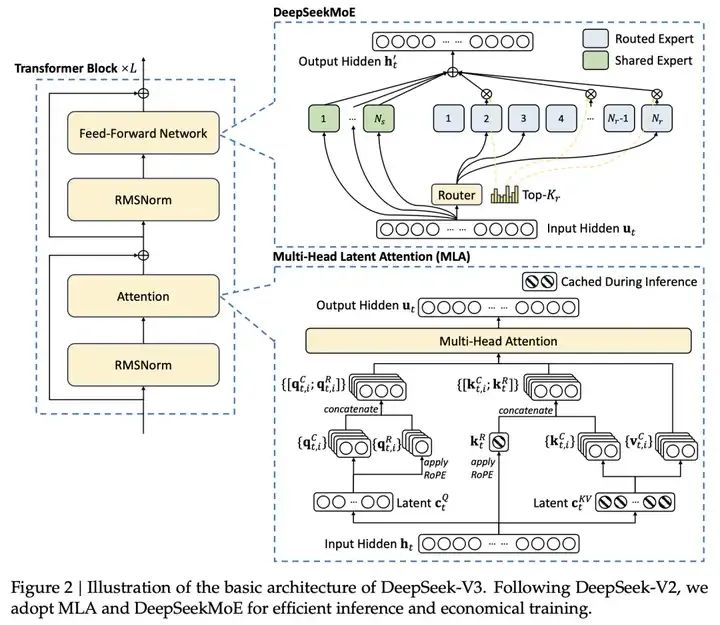

除此之外,DeepSeek自言,這得益于采用了Multi-head Latent Attention (MLA)和DeepSeek MoE架構,實現了高效的推理和經濟高效的訓練。

Multi-head Latent Attention (MLA):MLA 通過對注意力鍵和值進行低秩聯合壓縮,減少了推理時的 KV 緩存,同時保持了與標準多頭注意力(MHA)相當的性能。

DeepSeek-V3 的核心亮點

DeepSeekMoE:DeepSeekMoE 采用了更細粒度的專家分配策略,每個 MoE 層包含 1 個共享專家和 256 個路由專家,每個令牌激活 8 個專家,確保了計算的高效性。

因此,在系統架構層面,DeepSeek就使用了專家并行訓練技術,通過將不同的專家模塊分配到不同的計算設備上同時進行訓練,提升了訓練過程中的計算效率。

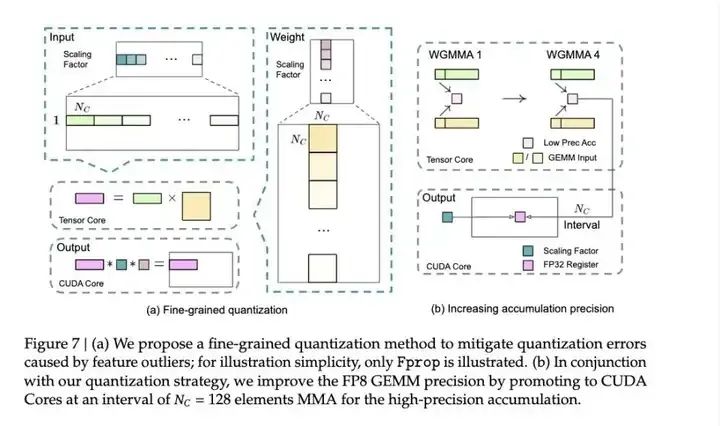

DeepSeek探索出一個精妙的解決策略,不等到最后再算總和,而是每加128個數就把當前結果轉移到科學計算器上繼續計算。其過程不影響速度,此技術利用了H800 GPU的特點:就像有兩個收銀員,當一個在結算購物籃的同時,另一個便可繼續掃描新商品。

這一策略使得模型訓練速度大幅提升,畢竟核心計算能提升100%的速度,而顯存使用減少也非常明顯,并且模型最終的效果精度損失能做到小于0.25%,幾乎無損。

DeepSeek 提出的誤差積累解決方法

但由于DeepSeek“大方”開源,Open AI水靈靈地被網友cue進行橫向對比,有一種被push的支配感。

Scale AI創始人亞歷山大·王 (Alexander Wang)更表示,DeepSeek-V3帶來的辛酸教訓是:當美國休息時,中國在工作,以更低的成本、更快的速度迎頭趕上,變得更強。

圖源:X平臺

簡言之,這種劇變深刻折射出AI領域的變革。在2023年,超越GPT-4還是一個值得載入史冊的重大突破,轉眼至2024年,這一成就已然演變為衡量頂級AI模型的基準線。

而剛到來的2025年,DeepSeek用行動說明,中國大模型創業者,共同參與這場全球創新AI競賽中。

由于篇幅受限,本次的DeepSeek V3就先介紹這么多......

想了解更多半導體行業動態,請您持續關注我們。

-

開源

+關注

關注

3文章

3368瀏覽量

42567 -

LLM

+關注

關注

0文章

293瀏覽量

351

原文標題:DeepSeek-V3橫空出世,GPT-4時代終結?

文章出處:【微信號:奇普樂芯片技術,微信公眾號:奇普樂芯片技術】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

談談DeepSeek-v3提到的基礎設施演進

雷軍千萬年薪挖角95后AI天才少女 DeepSeek開源大模型DeepSeek-V2關鍵開發者之一羅福莉

國產大模型發展的經驗與教訓

中國AI企業創新降低成本打造競爭力模型

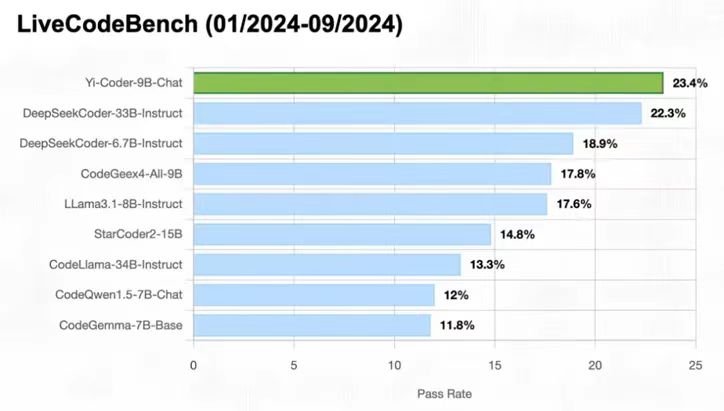

零一萬物正式開源Yi-Coder系列模型 PerfXCloud火速支持等你體驗!

PerfXCloud順利接入MOE大模型DeepSeek-V2

斯坦福團隊抄襲國產大模型,主要責任人失聯

Meta推出最強開源模型Llama 3 要挑戰GPT

國產GPU在AI大模型領域的應用案例一覽

國產大模型DeepSeek推出DeepSeek-V3

國產大模型DeepSeek推出DeepSeek-V3

評論