編者按:“趨勢”表現了事物發展的動向,它的目標可以是模糊的,但這種持續的前進反映到數據上是明確的。去年4月,特斯拉AI總監Andrej Karpathy發表了一篇A Peek at Trends in Machine Learning,揭示了機器學習論文總數(arxiv)、深度學習框架、CNN模型、優化算法及研究人員的發展趨勢。而就在幾天前,他又更新了一波數據,并從中看到了一種非常有趣的變化。

注:本文已更新論文總數與流行框架排名,其余內容仍為2017年4月數據。

好像少了點啥

不知道各位讀者有沒有用過Google Trends,這是一個很cool的工具——輸入關鍵詞,你就能查看相應Google搜索結果隨時間發生的變化。而現在,我們也已經有了一個機器學習論文庫arxiv-sanity,它在過去6年內積累了43108篇(arxiv)相關論文,所以我們為什么不落落俗套,也來看看6年來機器學習研究的演變情況呢?

注:該論文庫由Andrej Karpathy創建,由于機器學習涉及內容過廣,文中很大一部分都圍繞深度學習展開,尤其是Andrej Karpathy熟悉的領域。

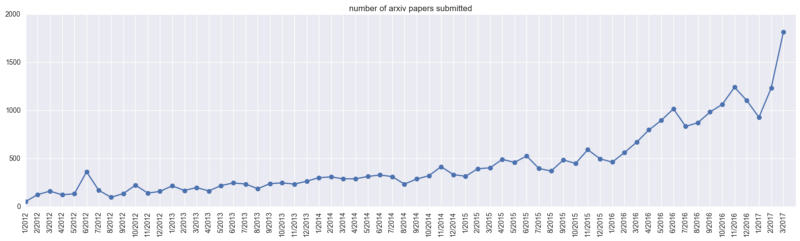

arxiv奇點

首先我們先來看看arxiv-sanity上的論文總數(cs.AI,cs.LG,cs.CV,cs.CL,cs.NE,stat.ML)。截至去年4月,arxiv-sanity共收錄28303篇機器學習論文,其中僅在2017年3月,數據庫就突增近2000份新論文,機器學習學術成果迎來爆發期。

arxiv上ML論文提交量變化

而就在短短一年后,arxiv-sanity上的論文總數已經突破43000篇,考慮到近年來機器學習國際頂會的熱門程度,我們先來看看幾個主要會議(去年4月后)的“吸金”能力:

雖然參與會議投稿的論文未必都會提交給arxiv,但可以看出,2017年以前,arxiv-sanity上收錄的論文總量尚不足3萬篇,而去年光這幾個會議就吸引了近2萬篇投稿,另外還有其他的頂會數據未計入其中,機器學習的熱度可見一斑。

當然,這也帶來了一個問題,就是學者需要通過閱讀大量論文才能從中篩選出真正有價值的內容,這也是許多人開始詬病頂會“灌水”嚴重的一個要因。但本文只關注發展趨勢,因此這些論文總數將作為分母,用來分析一些有趣的關鍵詞“現象”。

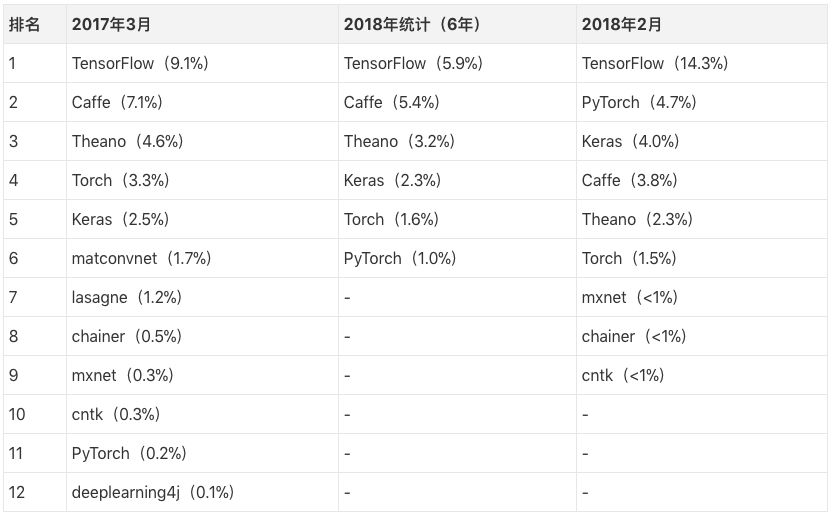

深度學習框架

談及機器學習,一個不可避免的熱門關鍵詞是深度學習框架,那么學術界更偏好哪種框架呢?我們匯總了去年和今年的統計結果,請結合表格對比感受:

需要注意的是,這里我們的分母是統計的論文總數,以2017年3月為例,TensorFlow(9.1%)指在去年3月投到arxiv的機器學習論文中,有將近10%提到了TensorFlow,當然這也意味著該月的大多數論文并沒有介紹自己使用的框架。但如果我們假設論文指出使用框架的現象遵循某種固定的隨機概率,那么經過粗略估計,我們可以猜測大約有40%的實驗室正在使用TensorFlow。而今年2月TensorFlow的比例提升到了14.3%,再算上把TF作為后端的各類框架,毫無疑問,TensorFlow確實是大多數學術界人士的首選框架。

而Caffe和Theano由于“歷史悠久”,已經積累了數量可觀的老用戶和論文基礎,因此它們的占比仍然很突出。

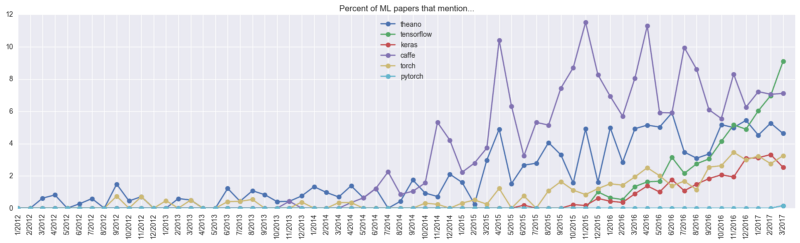

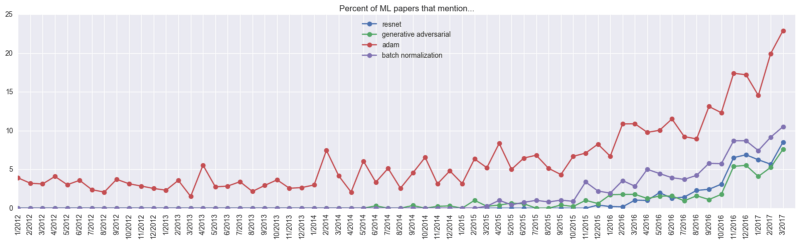

2017年4月前各框架發展情況

為了更直觀地感受各框架的發展趨勢,我們來看看去年和今年的這兩幅圖。上圖中紫色的Caffe和深藍色的Theano在很長一段時間內深受學界歡迎,而綠色的TensorFlow在2016年異軍突起,只用一年時間就超越了“前輩”,增長勢頭顯著。當時Andrej Karpathy曾預測Caffe和Theano的市場占有率會緩慢下降,同時TensorFlow的增長也會減緩,他更看好當時幾乎沒有存在感的PyTorch。

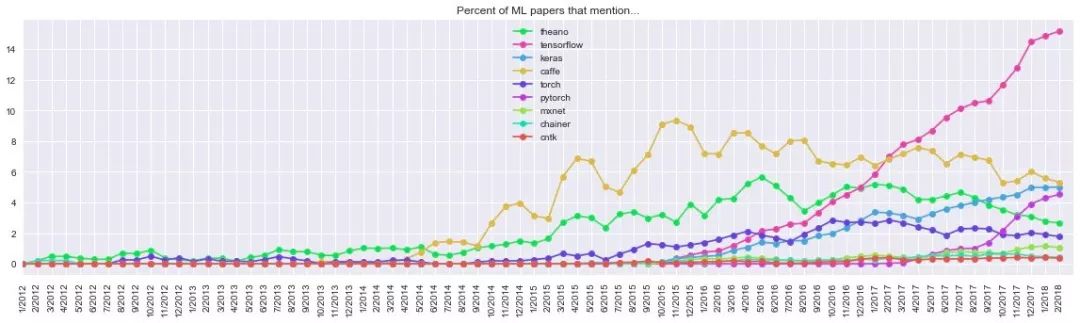

2018年3月前各框架發展情況

果不其然,最近的這幅統計圖顯示,粉色的TensorFlow經歷了兩年增長,至2017年年末開始趨向平穩,而Caffe和Theano的曲線幾乎同步下降,后者的占有率已跌至第五位,還在第二位苦苦掙扎的Caffe也被“后起之秀”Keras和PyTorch趕上。其中最亮眼的是PyTorch,這個在2017年3月不足0.2%的框架到2018年2月已經達到4.7%,考慮到近年來論文的爆炸式增長,PyTorch前景可期,拿原twitter下的留言來說,就是:

PyTorch is on fire! ( PyTorch要火!)

CNN模型

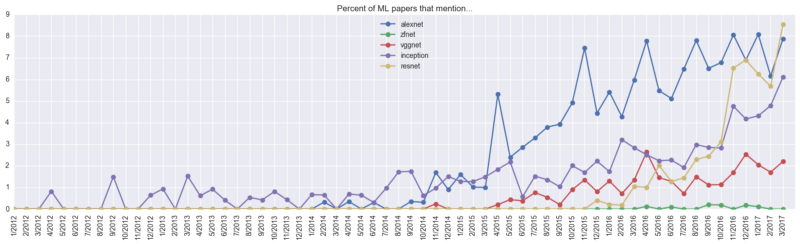

CNN最初是為解決圖像識別等問題設計的,當然其現在的應用不僅限于圖像和視頻,也可用于時間序列信號,比如音頻信號、文本數據等。在處理上述這些問題時,除了特殊情況,通常我們不會從頭新建一個CNN,而是在已有模型的基礎上調整參數。那么,哪個是最受歡迎的CNN模型呢?Andrej Karpathy沒有更新模型的相關數據,所以我們仍以去年的數據為準。

CNN有四大經典模型:AlexNet、VGGNet、Google Inception Net和ResNet。從上圖我們可以看到,在關于AlexNet的論文開始大量出現前,Inception在較長時間內一枝獨秀,2014年年末,AlexNet迎來快速增長,并長期穩定在高水平位置。而就在一年后,ResNet也迎來爆發期,到2017年3月占比9%,躍升至第一位。

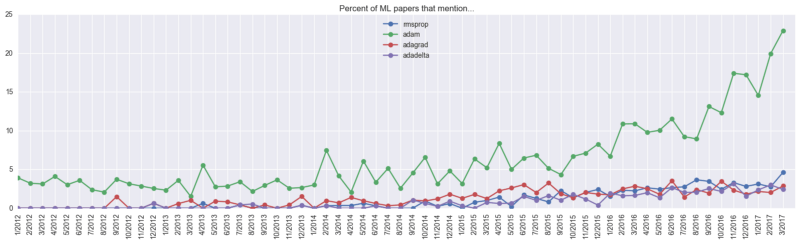

優化算法

就優化算法而言,Adam是毫無疑問的“掌門人”。截至去年4月,約23%的機器學習論文都提到了它。當然我們很難估計它的實際使用占比:它可能高于23%,因為一些論文沒有介紹使用的優化算法,其中的大部分甚至根本沒有提及神經網絡優化;它也可能需要在23%的基礎上減去5%,因為這個關鍵詞不是手動提取的,所以不排除論文里的Adam其實是個人名,而且作為一個優化算法,Adam的提出時間是2014年12月。

研究人員

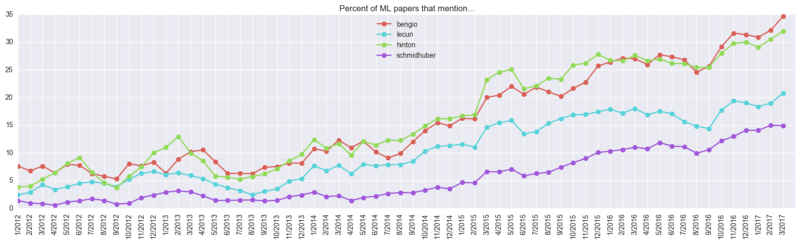

雖然現在大家對Deep Learning熱情高漲,業界也有大量被追捧的專家偶像,但這些偶像真的適合每個人嗎?你追的偶像是不是真正的專家?從論文實際引用情況來看,哪些人的論文“含金量”更高?Andrej Karpathy也用數據給了我們一點啟示。

上文中由上往下的四個人分別是Bengio、Lecun、Hinton、Schmidhuber,他們是業內公認的對深度學習貢獻最大的四名活躍學者。可以發現,Bengio在論文中的出現次數和Hinton齊頭并進,以35%位列首位,而Hinton則以30%排名第二。但考慮到Yoshua Bengio的弟弟Samy同樣在機器學習領域有不錯的成就,35%這個占比含有一定水分。

另外需要提的一位是LSTM之父Jürgen Schmidhuber,他的論文引用量也頗為可觀。Schmidhuber現任瑞士人工智能實驗室主管,因為喜歡自己獨立研究,可能國內對他的關注度不高,但這不妨礙業界對他的肯定。這里介紹一篇他的新作One Big Net For Everything,除了標題看得讓人害怕,引用的文獻都有將近一半是他參與寫的,感興趣的讀者可以參考著體會下大神的腦回路。

熱門/冷門的關鍵詞

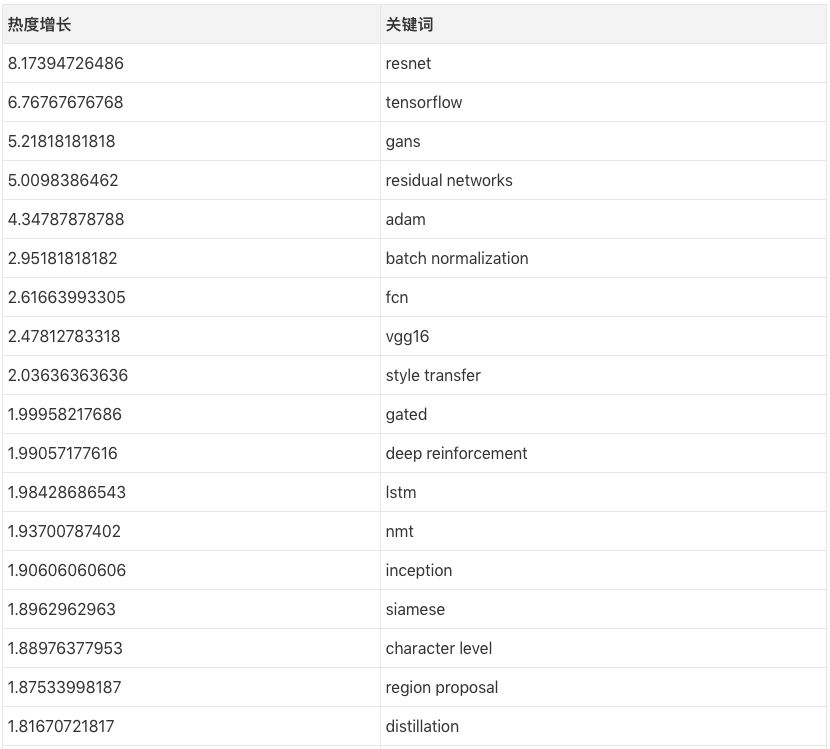

Andrej Karpathy同樣爬取了論文中的一些關鍵詞,并觀察了它們的熱度情況。

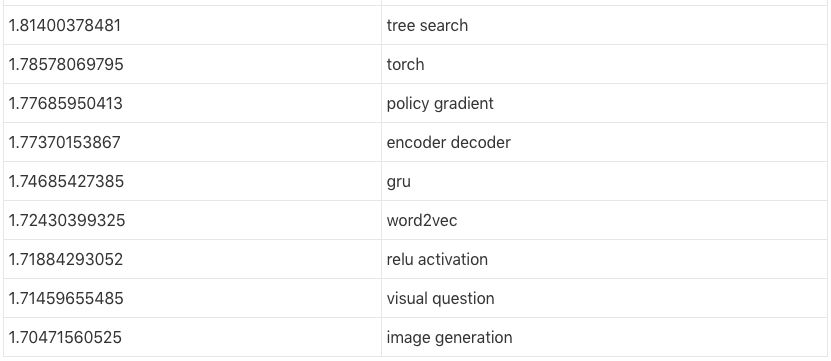

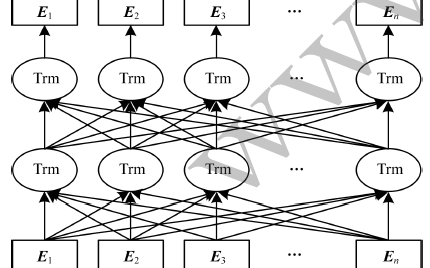

以上數值是這樣計算的:以resnet為例,2016年3月前它的出現頻率只有1.044%,而它在2017年3月的出現頻率是8.53%,因此它的熱度增長為8.53/1.044?=8.17。這樣對比下來,去年最熱門的論文關鍵詞依次是ResNets、GANs、Adam、BatchNorm,而最受歡迎的研究領域則是風格遷移、深度強化學習、神經機器翻譯、圖像生成,熱門架構的排名則是FCN、LSTM/GRU、連體網絡和編碼-解碼網絡。

另外,一些關鍵詞也被研究人員們“無情”地拋進了角落。雖然不清楚排名第一的fractal具體指什么,但估計是貝葉斯參數那一塊的內容。

小結

看完全文,你的“將基于全卷積編碼-解碼批規范化架構、經Adam優化處理的ResNet GAN用于風格遷移”這篇論文準備得怎么樣了(英文名字都幫你想好了,就叫Fully Convolutional Encoder Decoder BatchNorm ResNet GAN applied to Style Transfer, optimized with Adam),這個選題聽起來也不怎么離譜嘛:)

-

機器學習

+關注

關注

66文章

8424瀏覽量

132765 -

深度學習

+關注

關注

73文章

5507瀏覽量

121272

原文標題:PyTorch要火!Andrej Karpathy更新機器學習趨勢窺探

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

科普:12大關鍵詞讓你了解機器學習

[討論]提高網站關鍵詞排名的28個SEO小技巧

TF-IDF測量文章的關鍵詞相關性研究

亞馬遜代運營 amazon Search term 關鍵詞填寫的“神技”

HanLP關鍵詞提取算法分析詳解

關鍵詞優化有哪些實用的方法

#2023,你的 FPGA 年度關鍵詞是什么? #

IT產業2012熱點趨勢:智能化成關鍵詞

基于強度熵解決中文關鍵詞識別

基于關鍵詞的最優路徑查詢算法

基于自動關鍵詞抽取方法

三大“關鍵詞”來了解AI

2020年云計算發展六大關鍵詞,以及六大關鍵詞背后的重要趨勢

融合BERT詞向量與TextRank的關鍵詞抽取方法

根據關鍵詞了解機器學習的趨勢窺探

根據關鍵詞了解機器學習的趨勢窺探

評論