上周,Apollo美研在桑尼維爾舉行了關于Apollo 2.5的Meetup。會上,Apollo美研團隊的技術大牛與來自硅谷眾多的在校學生、車企等自動駕駛愛好者共同分享交流了Apollo 2.5相關的深度技術。沒能到達現場的國內開發者可以通過以下視頻資料回顧相關技術干貨。

Apollo 2.5 Platform Overview

Jingao Wang

首先,Apollo平臺負責人王京傲為大家做了關于Apollo 2.5平臺的Overview,讓國外開發者進一步了解Apollo 2.5。

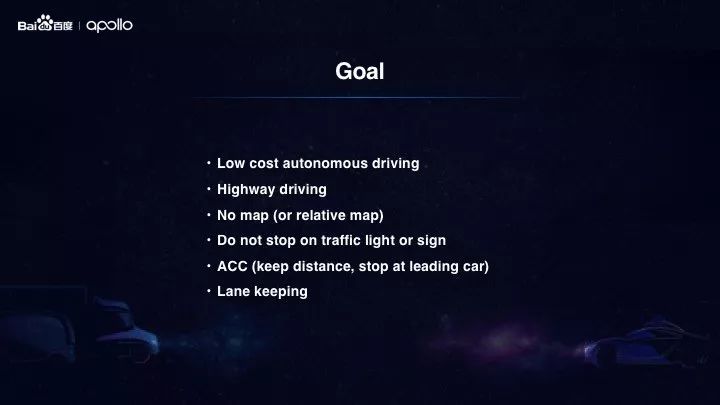

Apollo 2.5 解鎖了限定區域視覺高速自動駕駛,為開發者提供了更多場景、更低成本、更高性能的能力支持,開放了視覺感知、實時相對地圖、高速規劃與控制三大能力以及更高效的開發工具。

目前在GitHub上有9000+開發者推薦Apollo,超過2000家合作伙伴使用Apollo,開發者在Apollo上已經貢獻了20w+行代碼,越來越多的開發者通過Apollo搭建了屬于自己的自動駕駛系統。

此外,在場景應用方面,Apollo 還可支持包括乘用車、卡車、巴士、物流車、掃路車等多種車型和應用場景。

Vision-Based Perception forAutonomous Driving

Tae Eun

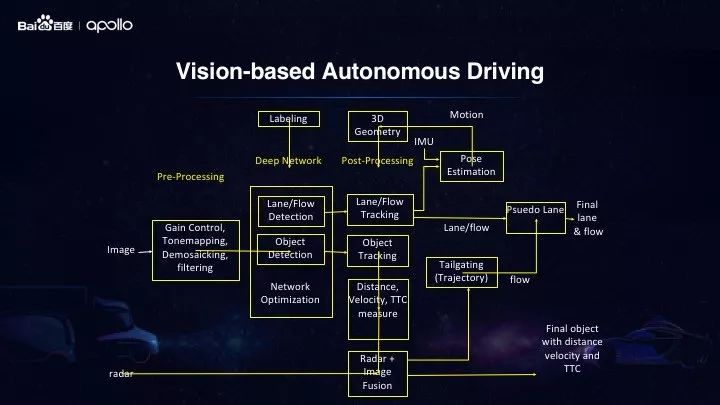

在Apollo 2.5中,基于攝像頭的感知,簡化了傳感器方案,增強了感知能力。在此次Meetup中,來自Apollo美研團隊的高級架構師Tae Eun分享了關于攝像頭的低成本視覺感知方案。

Apollo2.5 提供了多個集成式廣角攝像頭配合激光雷達,毫米波雷達的方案。其中以單目廣角攝像頭和毫米波雷達的低成本方案,相比之前2.0中64線激光雷達+廣角攝像頭+毫米波雷達的硬件配置方案,成本降低了90%。這種大幅度的成本節省,加上高效率的感知算法,將大大有助于測試有限區域的高速公路駕駛。

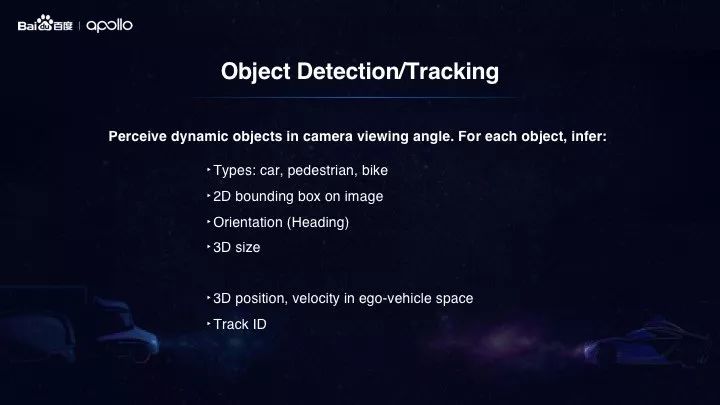

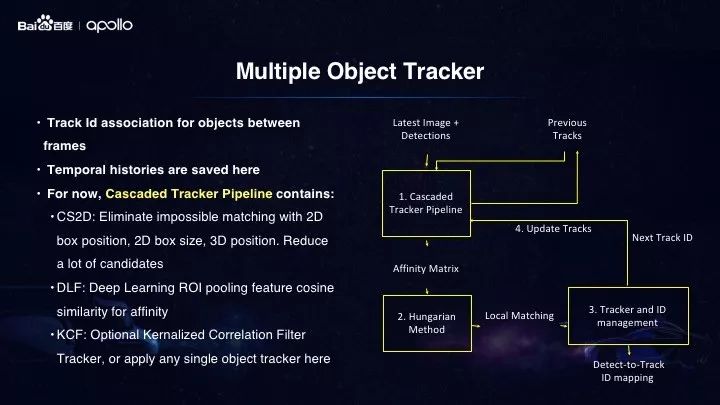

此外,傳感器的減少并不會降低感知的性能。在Apollo 2.5中我們使用了基于Yolo的多任務深度學習神經網絡來進行障礙物和車道線的檢測及分類。

感知輸入是從攝像頭捕捉的視頻幀,我們可以將其視為一系列的靜態2D圖像,所以如何從這些視圖中計算出障礙物的3D屬性便是關鍵問題。在我們的方法中,我們首先使用深度學習神經網絡來識別2D圖像中的障礙物,通過獲得的邊界框和障礙物的觀察角度。然后,我們可以使用line-segment算法,用攝像頭射線和攝像頭的校準來重建3D障礙物。整個過程可以在小于0.1毫秒內完成。

最后,我們來看看處理后的車道線邏輯。首先,用深度學習神經網絡掃描2D圖像的每個像素以確定它是否屬于行車道,以便生成像素化的車道線。然后,使用連接分析,我們可以將相鄰的車道線像素連接起來完成整個車道線段的連接,通過多項式擬合確保車道線的平滑性。根據當前車輛的位置,我們可以推導出車道線的語義含義:無論是左,右或相鄰的車道線。然后將車道線轉換到車輛坐標系中,發送給其他需要的模塊。

-

神經網絡

+關注

關注

42文章

4771瀏覽量

100718 -

自動駕駛

+關注

關注

784文章

13784瀏覽量

166394 -

Apollo

+關注

關注

5文章

342瀏覽量

18444

原文標題:Apollo Meetup | Apollo 2.5平臺解析與自動駕駛視覺感知分享

文章出處:【微信號:Apollo_Developers,微信公眾號:Apollo開發者社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

FPGA在自動駕駛領域有哪些應用?

【話題】特斯拉首起自動駕駛致命車禍,自動駕駛的冬天來了?

自動駕駛真的會來嗎?

3天造出自動駕駛汽車的百度Apollo,背后竟有50多個后臺

UWB主動定位系統在自動駕駛中的應用實踐

自動駕駛系統要完成哪些計算機視覺任務?

基于視覺的slam自動駕駛

自動駕駛系統設計及應用的相關資料分享

自動駕駛技術的實現

淺析Apollo 2.5限定場景低成本技術方案

百度Apollo完成國內首例自動駕駛上高速測試

Apollo開發套件加速自動駕駛研發

百度Apollo自動駕駛科技教育華西區域示范基地落地重慶永川

Apollo 2.5解鎖了限定區域視覺高速自動駕駛

Apollo 2.5解鎖了限定區域視覺高速自動駕駛

評論