人工智能也許已經破解了某些通常需要人類智慧的任務代碼,但是為了學習,這些算法需要海量人類產生的數據。

算法根據數據中發現的模式來進行分類或者做出預測。但這些算法的聰明程度只能跟訓練它的數據相比。這也就意味著我們的限制——我們的偏見,我們的盲點,我們的疏忽也會變成那些算法的。Danielle Groen詳細解釋了算法是如何產生偏見的,并且介紹了一些可能的解決方案。

算法的歧視

2010年秋天的一個早晨,Safiya Umoja Noble正坐在伊利諾斯州家中的餐桌上往Google里面輸入了幾個詞。她正準備給自己14歲的繼女以及5位侄女準備一次sleepover(在朋友家過夜的晚會)。既不想讓孩子們碰手機,又擔心女孩們會直奔她的筆記本,Noble決定自己先查查看她們會發現些什么。她說:“我原先想搜搜‘黑人女孩’,因為這是我喜歡一群黑人小女孩。”

但這次無傷大雅的搜索出來的東西令人警醒:結果網頁整整一頁都是明顯色情的網頁。當時任何人搜索黑人女孩都會得到一樣的東西。Noble說:“幾乎所有有色人種女孩的搜索結果都是超級色情的內容,哪怕退一步說這也非常的令人失望。”現在是南加州大學傳播學教授的Noble說:“我只好把計算機也收起來,希望女孩子們不會提出要玩電腦的要求。”

大概與此同時,在另一個地方,Joy Buolamwini也發現了另一個表示問題。這位父母來自加納、在加拿大出生的女計算機科學家意識到一些先進的熱戀識別系統,比如微軟使用的那些系統,在檢測她的黑皮膚方面有很大的困難。有時候程序根本就不知道她的存在。當時是喬治亞理工學院一名學生的她正在做一個機器人項目,結果發現本該要跟人類用戶玩躲貓貓的那個機器人沒法把她給辨認出來。后來她只有靠室友的淺膚色的臉才完成了項目。

2011年,在香港的一家初創企業那里,她又用另一個機器人去試試自己的運氣——結果還是一樣。4年后,身為MIT碩士研究生的她發現最新的計算機軟件仍然看不到她。不過當Buolamwini敷上一種萬圣節用的白色面具時,技術識別就很順利了。她靠化裝才完成了自己的項目。

臉部識別和搜索引擎只是人工智能的兩個應用而已。這是一個訓練計算機執行通常只有人腦才能處理的任務的學科,牽涉到數學、邏輯、語言、視覺以及運動技能等。(就像色情一樣,智能這東西很難定義,但是當你看到時你就會知道。)無人車可能還沒那么快可以上路,但虛擬助手,比如Alexa等已經可以幫你在喜歡的咖啡廳預定中午會議了。語言處理的改進意味著你可以在手機用英語看一張翻譯過的俄羅斯報紙。推薦系統極其擅長根據你的品味選擇音樂或者建議Netflix系列片供你度過周末。

這些評估會影響我們的生活,但這并不是AI系統介入的唯一領域。在某些情況下,要緊的只是我們的時間:比方說,當你打電話給銀行請求支持時,你在等待列表中的位置未必是順序的,而是要取決于你作為客戶對銀行的價值如何。(如果銀行認為你的投資組合更有前途的話,你的等待時間也許就只有3分鐘而不是11分鐘)但是AI也日益影響到我們的就業、我們對資源的使用以及我們的健康。

申請跟蹤系統掃描簡歷,尋找關鍵字以便為招聘經理排出一個短名單。算法還在評估誰有資格拿到貸款,數倍追究欺詐責任。風險預測模型識別哪一位病人更有可能在45天內再次入院并且能從免費照顧與延續服務中受益最大。

AI還告訴當地警方和安全部門該去哪里。2017年3月,加拿大邊境服務局宣布將在最繁忙的國際機場實現人臉識別軟件;好幾個地方的報攤現在開始用這套系統來確認護照身份,“提供自動化的旅行者風險評估”。自2014年開始卡爾加里警方已經運用人臉識別將視頻監控與面部照片進行比對,去年秋天,多倫多警察服務局宣布將用部分撥款實現類似技術。

跟傳統警方僅對已發生事件作出反應不同,預測性治安維護會依靠歷史模式和統計建模在某種程度上預測哪一個街區的犯罪風險更高,然后引導巡邏車去到那些熱點。美國的主要轄區已經推出了這一軟件,去年夏天,溫哥華成為加拿大推出類似舉措的首座城市。

這些技術因其效能、成本效益、可伸縮性以及有望帶來中立性而受到重視。AI初創企業Integrate.ai的產品副總裁Kathryn Hume說:“統計系統有一層客觀性與權威性的光環。”人類決策有可能會混亂、不可預測,并且受到情緒或者午飯過去多少小時的影響,而“數據驅動算法卻展現了一個不受主觀性或者偏見影響的未來。但情況其實沒那么簡單。”

人工智能可能已經破解了通常需要人類智慧的某些任務的代碼,但為了能學習,這些算法需要人類產生的大量數據。它們大量吸收各種信息,仔細搜查以便找出其中的共性和關聯,然后基于檢測出的模式提供分類或預測(是否癌癥,是否會拖欠還款)。但是AI的聰明程度智能跟訓練它們的數據一樣,這就意味著我們的限制——我們的偏見、盲點以及疏忽,也會變成它們的。

今年早些時候,Buolamwini跟一位同事一起發表了對三項領先的臉部識別程序(分別由微軟、IBM和Face++開發)進行測試的結果。測試要驗證的是識別不同膚色種族性別的能力。超過99%的時間內,系統哦歐能都能正確識別出淺膚色的人。但是考慮到數據集嚴重向白人男性傾斜,這個成績就不算什么了。

在另一個受到廣泛使用的數據集里,那個用于訓練識別的照片是一個78%為男性,84%為白人的照片集。當Buolamwini用黑人女性的照片測試這些程序時,算法的出錯率接近34%。而且膚色越黑,程序的表現越差,錯誤率一直都在47%左右——這幾乎跟拋硬幣差不多了。系統看到一位黑人女性時并不能死別出來。

因為這些程序都是公開的,所以Buolamwini可以計算出這些結果,然后她可以用自己的1270張照片去測試他們。她的照片集由非洲政治家和辦公室女性占比很高的北歐國家組成,為的是看看程序表現如何。這是一個評估某些情況下為什么技術會預測失敗的難得機會。

但是透明性是例外,不是規則。商用應用(我們用來找工作、評信用和貸款等服務)使用的絕大部分AI系統都是專有的,其算法和訓練數據是公眾看不到的。所以個人要想質詢機器的決定或者想了解用帶人類偏見的歷史例子訓練出來的算法何時不利于自己是極其困難的。想證明AI系統違反了人權?研究倫理、法律及技術的加拿大首席研究員Ian Kerr說:“大多數算法都是黑箱。”因為公司會利用政府或商業機密法律來保守算法的模糊。但他補充道“即便組織提供完全透明,算法或AI本身也是不可解釋或者不可理解的。”

最近出版了新書《壓迫的算法》的Noble說,大家過去也主張過自身權利,反對歧視性的貸款行為。“現在我們又遇到了類似歧視性的決策,只不過它是由難以理解的算法做出的——而且你還沒法呈堂證供。我們正日益陷入到那些系統的包圍之中——它們做出決定,給我們打分,但其實他們也是人類的產品,只不過我們越來越看不清楚那背后的人。”

從專家系統到深度學習

如果你想造一臺智能機器的話,從挖掘一位聰明人的知識開始不算壞主意。1980年代,開發者在AI方面就取得了一些早期突破,也就是所謂的專家系統,由有經驗的診斷醫生或者機械工程師幫助設計代碼去解決特定問題。可以想想看恒溫器是如何工作的:它可以按照一系列的規則將房子保持在恒定的溫度或者當有人進入時排出暖氣。聽起來似乎很不錯,但其實這只是規則和傳感器的小花招罷了——如果[溫度低于X]則[加熱到Y]。恒溫器既不識天象也也不知道你下班后的安排,它沒法適配自己的行為。

機器學習則是人工智能的另一個分支,它通過分析模式而不是系統應用規則來教計算機執行任務。這通常是通過所謂的有監督學習實現的。這個過程還需要人類的參與:程序員必須整理數據,也就是輸入,給它分配標簽,也就是輸出,這樣一來系統就知道要找什么了。

比方說我們的計算機科學家想開發一套能夠區分草莓和香蕉的水果沙拉對象識別系統。那么他就得選擇特征——姑且定為顏色和形狀——這跟水果是高度關聯的,靠這兩個機器就能識別水果。他給紅色圓形的對象的圖片打上草莓的標簽,把黃色長條的圖片打上香蕉的標簽,然后他寫了一些代碼分配一個值來表征顏色,另一個來歸納形狀。他把大量的草莓和香蕉圖片喂給機器,后者從而建立起對這些特征關系的理解,從而可以對自己要找什么樣的水果做出有根據的猜測。

一開始的時候系統表現不會太好;它需要通過一組有力的例子去學習。我們的監督者計算機科學家知道,這個特別的輸入是草莓,所以如果程序選擇了香蕉的輸出,他會因為給出錯誤答案而懲罰計算機。根據這個新信息,系統會調整自己做出的特征之間的連接從而下次改進預測。由于一對輸出并不是什么難事,很快機器就能夠正確識別出自己從未見過的草莓和香蕉了。

貴湖大學機器學習研究小組負責人GrahamTaylor說:“一些東西很容易概念化并且編程實現。”但是你可能希望系統能夠識別比水果更復雜的對象。也許你希望在海量的面孔中識別出一張臉。Taylor說:“于是就引出了深度學習。它擴展到非常龐大的數據集,迅速解決問題,并且不受定義規則的專家知識的限制。”

深度學習時機器學習的一個極其熱門的分支,它的出現其實是受到了我們人腦機制的啟發。簡而言之,大腦是一個數十億神經元用數萬億突觸連接起來的集合,而那些連接的相對強度——比如紅色與紅色水果之間,以及紅色水果與草莓之間的連接——都是通過逐漸的學習過程進行調整的。

深度學習系統依靠的是這種神經網絡的電子模型。深度學習領域的先驅之一Yoshua Bengio說:“在你的大腦里,神經元會發送信息給其他神經元。”一對神經元之間的信號強弱叫做突觸權重:當權重很大時,一個神經元就會對另一個神經元產生強大影響;而當它很小時,影響力也會很小。他說:“通過改變這些權重,不同神經元之間的連接強度也會改變。這就是AI研究人員想到的用來訓練這些人工智能網絡的點子。”

這就是AI能夠從對草莓香蕉分類進展到識別面部的辦法之一。一位計算機科學家提供標簽化的數據——所有那些跟正確名字掛鉤的臉部。但是他不是要求也是告訴機器照片中哪些特征對識別很重要,計算機就會完全靠自己來析取出那些信息。Taylor說:“在這里你的輸入是面部的照片,然后輸出就是關于這個人是誰的決定。”

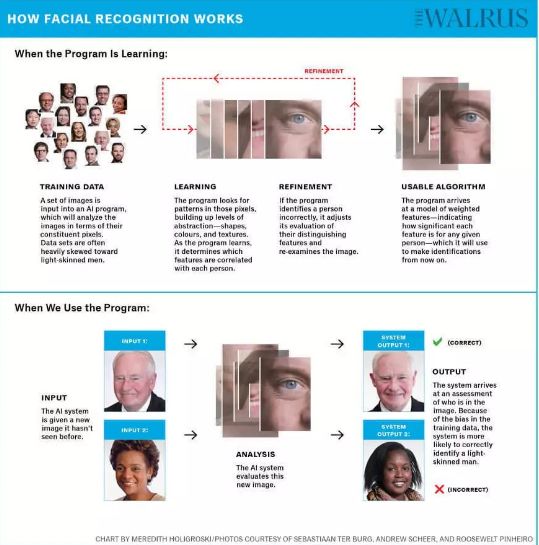

人臉識別的機制:1)機器學習時:訓練數據——學習——調整——形成有用的算法;2)使用程序時:輸入——分析——輸出

為了從輸入走到輸出,圖像要經過幾次轉換。他說:“圖像首先要轉換成非常低級的表征,只是枚舉邊的類型和位置。”接下來可能是那些邊線的邊角和交叉點,再就是形成形狀的邊線的模式。幾個圓圈可能最后會成為一只眼睛。Taylor解釋說:“在特征方面每一層的表示都是不同程度的抽象,這樣一直到你得到非常高級的特征,那些開始看起來代表著身份的東西——比如發型和下巴輪廓——或者像面部勻稱性這樣的屬性。”

這整個過程是怎么發生的呢?數字。數量多到令人難以置信的數字。比方說,一套人臉識別系統會按照像素級別來分析一張圖像。(百萬像素級攝像頭使用1000x1000像素的網格,每一個像素都有紅綠藍三基色的值,每個值的范圍在0到255之間,所以這里面的信息量有多大可想而知)系統通過這些表示層分析像素,構建抽象,直到最后自己做出識別。

不過請等一下,盡管這張臉很顯然是Christopher Plummer,但機器卻以為它是Margaret Trudeau。Taylor說:“模型一開始的時候表現非常糟糕。我們可以從給它看圖片然后問誰在里面開始,但在經過訓練或者完成任何學習之前,機器會一直給出錯誤的答案。”這是因為在算法見效之前,網絡上人工神經元之間的權重是隨機設定的。

經過一個逐步試錯的過程之后,系統調整了不同層之間的連接的強度,所以當它看到另一幅Christopher Plummer的圖片時,它表現得稍微好點了。小的調整稍微改善了一下連接,把錯誤率稍微降低了一點,直到最后系統可以用很高的準確率識別出臉部。正是因為這項技術,Facebook會在一張圖片中有你時向你發出提醒,哪怕你還沒有被打上標簽。Taylor說:“深度學習很酷的一點是,我們不需要在有人說‘哦,這些特征對識別特定的臉很有用’的情況下析取出一切。這都是自動發生的,這就是它的神奇之處。”

帶偏見的數據

這里有個小花招:往Google Images里面輸入CEO你會變出一堆幾乎難以分辨的白人男性面孔。如果你是在加拿大,你會看到剩下起到點綴作用的大部分都是白人女性,以及少數有色人種,還有神奇女俠的蓋爾·加朵。去年在加州舉行的一場機器學習會議上,一名演講者必須在一堆穿著深色西裝的白人男性中向下翻滾了很久之后才找到了第一位女俠。CEO芭比。

數據對于AI系統的運作必不可少。系統越復雜——神經網絡的層數就越多,要想翻譯語音或者識別面部或者計算某人拖欠貸款的可能性——需要收集的數據就越多。程序員可能要依靠圖庫或者危機百科條目、歸檔的新聞文章或者音頻記錄。他們可能會看大學招生的歷史和假釋記錄。它們想要臨床研究和信用評分。McGill計算機科學學院的Doina Precup教授說:“數據非常非常重要,(數據越多,)解決方案越好。”

但并不是每個人都能夠公平地得到那些數據的表示。有時候,這是由來已久的排斥的結果:2017年,女性在財富500強中的占比僅為6.4%,但這已經比上一年的數字增長了52%。

直到1997年之前加拿大衛生部都沒有明確要求女性納入到臨床試驗里面;據中風基金會的《2018心臟報告》,2/3的心臟病臨床研究仍然以男性為主,這幫助解釋了為什么最近的一項研究發現超過一半女性并沒有那些心臟病的癥狀。既然我們知道女性被排除在那些高層和試驗之外,說她們的缺席會令任何用這些數據訓練的系統的結果產生扭曲就是安全的假設了。

有時候,就算有充足的數據,那些建立訓練集的人仍然不會采取審慎的舉措去保證多樣性,這導致了人臉識別程序在面對不同人群時會出現差異很大的錯誤率。其結果就是所謂的取樣偏差,這是由于缺乏代表性數據導致的。算法優化是為了盡可能少犯錯;其目標是降低錯誤數。但是數據的構成決定了算法將注意力引導到哪里去。

多倫多大學計算機科學教授Toniann Pitassi的研究重點是機器學習的公平性,他提供了一個招生計劃的例子。Pitassi說:“比方說你有5%的黑人申請,如果這所大學95%的申請都是白人的話,則幾乎你所有的數據都將是白人的。在決定誰應該進入大學這件事情上算法試圖在整體上考慮將自己的錯誤最小化。但是它不會投入太多的努力到那5%上面,因為這對總體錯誤率的影響很小。”

猶他大學計算學院的Suresh Venkatasubramanian教授解釋說:“很多算法是通過看在訓練數據中自己得到了多少正確答案來進行訓練的。這很好,但如果你只是把答案累計的話,就會有一部分小群體總是會有問題。這么做對你的傷害不太大,但是因為你系統性的對那一小群人的全體犯錯,錯誤決定的影響就要比你的錯誤分散到多個群體的影響嚴重多了。”

正是因為這個原因,Buolamwini人肉干發現IBM的臉部識別技術準確率為87.9%。當一個系統識別淺膚色女性的準確率為92.9%,識別淺膚色男性的準確率為99.7%時,黑人女性的識別率僅為35%就無關緊要了。微軟的算法也一樣,她發現其預測性別的準確率為93.7%。但Buolamwini發現,那些性別錯誤中幾乎有同樣的比例——93.6%是發生在深膚色受試者的臉上。但是算法并不需要關心這個。

垃圾進,垃圾出

在跟人工智能專家花費了足夠多的時間進行了足夠深入的對話之后,到了一定時候,他們都會得出一條公理:垃圾進,垃圾出。繞開樣本偏差確保系統基于豐富的均衡數據而進行訓練是有可能的,但如果數據受到我們社會的偏見和歧視困擾的話,則算法也好不到哪里去。Precup說:“我們想要的是忠于現實的數據。”而當現實存在偏見時,“算法別無選擇,只有反映那種偏見。算法就是這么做出來的。”

偶爾,所反映出來的偏見在預測性方面幾乎是很滑稽的。Web搜索,聊天機器人,給圖像加字幕程序,機器翻譯等日益依賴于一種叫做詞嵌入的技術。這是通過把單詞之間的關系變成數值,然后讓系統已數學的方式表示語言的社會背景。通過這項技術,AI系統了解到了巴黎和法國之間的關系,以及東京與日本之間的關系;它能覺察到東京與巴黎之間的不同聯系。

2016年,波士頓大學和微軟研究院的研究人員把來自于Google News文字的超過300萬個英語單詞提供給一個算法,他們先是提供一段使用得最多的話,然后讓算法填空。他們問道:“男人之于計算機程序員正如女人之于什么?”機器在那堆單詞里面折騰了半天之后給出的答案是家庭主婦。

這些統計關聯就是所謂的隱含偏差:這就是為什么一所人工智能研究機構的圖像收集將烹飪與女性招聘關聯起來的可能性會增加68%的原因,這也解釋了Google Translate在使用性別中立的代詞的語言時為什么會遇到麻煩。

土耳其語的句子不會指明醫生是男性還是女性,但是英語翻譯會假定,如果屋子里有個醫生的話,那他一定是個男的。這種推測延伸到了網上到處跟蹤我們的廣告身上。2015年,研究人員發現,在許諾薪水高于20萬美元的Google工作崗位廣告里面,男性出現的機率比女性高6倍。

Kathryn Hume說,系統的威力在于其“識別性別與職業之間的關聯的能力。其不好之處在于系統背后是沒有目的性的——只是由數學來選擇關聯。它并不知道這是個敏感問題。”這種技術存在著未來主義和陳舊作風的沖突。AI的演進速度要比它要處理的數據的演進快得多,所以這注定了它不僅折射和反映出過去的偏見,而且還延長并加強了它們。

因此,當判斷被移交給機器之后,那些曾經是包括警察、法院在內的機構系統性歧視目標的群體并不能得到更好的對待。多倫多大學犯罪學和社會法學研究中心的Kelly Hannah-Moffat教授說:“那種認為可以制造出公平客觀的AI工具的看法是有問題的,因為你會把犯罪發生的背景簡化成是或否的二元性。

我們都知道種族跟盤查政策、梳理以及更嚴格的警方檢查相關,所以如果你正在研究跟警察的接觸或者之前的逮捕率時,其實你看的已經是一個帶偏見的變量。”一旦那個變量被納入到機器學習系統里面,偏見就被嵌入到算法評估之中。

兩年前,美國調查新聞機構ProPublica仔細審查了一個使用廣泛的程序,其名字叫做COMPAS,這個程序被用來確定被告再犯的風險。記著收集了超過7000名在佛羅里達州被捕的人的分數,然后評估其中有多少人在隨后2年實施了犯罪——使用的是跟COMPAS一樣的基準。他們發現,算法存在很大的缺陷:黑人被告被錯誤地標記為存在再犯的高風險的機率是實際的2倍多。相反,被標記為低風險的白人被告在隨后被指控犯罪的情況是其估計的2倍。

美國已經有5個州靠COMPAS來進行刑事司法判決,其他轄區也已經有其他的風險評估程序就位。加拿大因為仍然沿用過時的體系,所以還沒有受到有問題的算法之影響。

實現算法公平

要想實現算法的公平性,程序員可以簡單地摒棄種族和性別這樣的屬性。但根深蒂固的歷史關聯——那種將女性與廚房關聯,或者將一部分人口跟特定郵編關聯的做法,使得系統很容易就能弄清楚這些屬性,哪怕這些屬性已經被移除了。所以計算機科學家弄出的這種解決方案令人想到管弦樂世界的盲聽:為了掩飾某人的身份,他們豎起了一道幕布。

深度學習先驅Yoshua Bengio說:“假設我們考慮到種族是歧視的因素之一,如果我們在數據里面看到這個的話,我們就可以衡量它。”可以往神經網絡里面添加另一個約束,強迫它忽視有關種族的信息,不管這種信息是不是隱含的(比如郵編)。Bengio說,這種方案無法對這些受保護的特征建立完全的不敏感性,但是還是做了相當好的工作。

其實現在已經有越來越多的研究在設法用算法性解決方案來解決算法性偏見問題。其中反設事實可能是手段之一——讓算法分析如果女性獲得貸款的話會發生什么,而不是簡單地去梳理過去發生的事情。這可能意味著要給算法它增加約束,確保它在犯錯時這些錯誤是均勻分布到每一種代表群體里面的。給算法增加不同的約束來降低閾值是有可能的,比方說對特定群體的大學錄取率,從而保證達到代表性的百分比——姑且稱之為算法性平權行動。

盡管如此,算法干預也只能到此為止;解決偏見還需要訓練機器的程序員的多樣性。McGill教授Doina Precup說:“這甚至還不是說意圖不好,只是那些沒有來自特定背景的人完全就沒意識到那種背景會是什么樣的,也不了解這會如何影響著一切。”如果數據集匯編進來的時候Joy Buolamwini在場的話,她當場就能發現那尖端的臉部識別技術在黑膚色的表現太過糟糕。

《壓迫的算法》作者Safiya Noble補充說:“我們對種族主義和性別歧視的理解不夠深入時可能會出現的風險遠不止是公關混亂以及偶爾的新聞頭條。這不僅意味著公司失去了更深入更多元化的消費者參與的可能性,而且有可能他們也沒有意識到自己的產品和服務已經成為了會對社會造成破壞的權力體系的一部分。”

對算法性偏見認知的增強不僅是干預我們AI系統開發方式的一個機會。這也是一個質詢的好機會,質詢為什么我們創建的數據會像這樣,質詢還有哪些偏見在繼續塑造一個允許這些模式在數據中出現的社會。畢竟,算法只是一組指令罷了。Bengio強調:“我們使用的算法是中立的。不中立的是(神經)網絡,只要用帶偏見的數據對它進行過訓練之后,渦輪就不再中立了。我們充滿著各種偏見。”

這正是為什么我們要非常非常當心自己收集的數據的原因。今年3月,微軟領導的一群研究人員參加在舊金山舉行的一場會議時提出了一個可能的解決方案。因為識別數據集創建方式缺乏標準,也沒有警示可能存在偏見的警告標簽,他們提出做一張包含有公共數據集和商用軟件的數據表。文檔將明確說明訓練數據集是什么時候在哪里以及如何匯編出來的,并且提供使用的受試者的人口統計信息,提供必要的信息給研究人員和組織,從而確定如何利用數據集以及在和背景下加以使用。

在歐洲,已經出臺了一部全新的隱私法律,General Data Protection Regulation(GDPR,通用數據保護條例)規定要限制對敏感數據的手機,要求對算法決策進行解釋,并且保護個人不會被機器唯一來決定。

當然,還有一種優雅簡潔且公平公正的解決方案:獲得更好的數據。這就是Joy Buolamwin的發現指責IBM的人臉識別系統在性別和膚色平衡上做的不夠之后發生的事情。這家公司目前正在提高用于訓練的圖片集的廣泛性。后來拿瑞典、芬蘭、南非、塞內加爾等過議員的照片去測試這套新系統時,算法執行得很好,這一點并不奇怪。可喜的是對所有人都是。

雖然不夠完美:深膚色的女性錯誤率依然是最高的,3.46%。但這比之前已經改進了10倍——這已經遠遠足以證明改變是有可能的,只要你把它當作優先事項。哪怕是不徹底的智能機器都知道這一點。

-

人工智能

+關注

關注

1791文章

47208瀏覽量

238291 -

深度學習

+關注

關注

73文章

5500瀏覽量

121117

原文標題:本應公平公正的 AI,從數據中學會了人類的偏見

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

人類智慧水平AI即將到來,AI芯片已提前布局

AI智能體逼真模擬人類行為

AI大模型的倫理與社會影響

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創新》第二章AI for Science的技術支撐學習心得

《AI for Science:人工智能驅動科學創新》第一章人工智能驅動的科學創新學習心得

平衡創新與倫理:AI時代的隱私保護和算法公平

智謀紀 AI+Multi LED 打開人類健康新寶藏

水庫大壩安全監測系統的組成與功能

通過增強一致性訓練,有效緩解CoT中的偏見問題

富士通發布最新的人工智能(AI)戰略,聚焦深化人類與AI之間的協作

沒有10年工作經驗,我猜你都不會用電磁場來分析高速問題吧?

公平公正的AI也學會了人類的偏見

公平公正的AI也學會了人類的偏見

評論