作為AI和芯片兩大領域的交差點,AI芯片已經成了最熱門的投資領域,各種AI芯片如雨后春筍冒出來,但是AI芯片領域生存環境惡劣,能活下來的企業將是鳳毛麟角。

谷歌在I/O大會發布了其第三代TPU,并宣稱其性能比去年的TUP 2.0 提升8倍之多,達到每秒1000萬億次浮點計算,同時谷歌展示了其一系列基于TPU的AI應用。

可以說,AI已經成為科技行業除了區塊鏈之外最熱門的話題。AI芯片作為AI時代的基礎設施,也成為目前行業最熱門的領域。

可以看到,AI芯片已經成為資本追逐的最熱門領域,資本對半導體芯片的熱情被AI技術徹底點燃。在創業公司未真正打開市場的情況下,AI芯片初創企業已經誕生了不少的獨角獸,多筆融資已經超過億元。

AI技術的革新,其從計算構架到應用,都和傳統處理器與算法有巨大的差異,這給創業者和資本市場無限的遐想空間,這也是為什么資本和人才對其趨之若鶩的原因。

首先我們來分析下目前對AI芯片的需求主要集中在哪些方面。

先來講講AI目前芯片大致的分類:從應用場景角度看,AI芯片主要有兩個方向,一個是在數據中心部署的云端,一個是在消費者終端部署的終端。從功能角度看,AI芯片主要做兩個事情,一是Training(訓練),二是Inference(推理)。

目前AI芯片的大規模應用分別在云端和終端。云端的AI芯片同時做兩個事情:Training和Inference。Training即用大量標記過的數據來“訓練”相應的系統,使之可以適應特定的功能,比如給系統海量的“貓”的圖片,并告訴系統這個就是“貓”,之后系統就“知道”什么是貓了;Inference即用訓練好的系統來完成任務,接上面的例子,就是你將一張圖給之前訓練過的系統,讓他得出這張圖是不是貓這樣的結論。

Training 和 Inference 在目前大多數的AI系統中,是相對獨立的過程,其對計算能力的要求也不盡相同。

Training需要極高的計算性能,需要較高的精度,需要能處理海量的數據,需要有一定的通用性,以便完成各種各樣的學習任務。

對于芯片廠家來說,誰有數據,誰贏!

Inference相對來說對性能的要求并不高,對精度要求也要更低,在特定的場景下,對通用性要求也低,能完成特定任務即可,但因為Inference的結果直接提供給終端用戶,所以更關注用戶體驗的方面的優化。

谷歌TensorFlow團隊:深度學習的未來,在單片機的身上

Pete Warden,是谷歌TensorFlow團隊成員,也是TensorFLow Mobile的負責人。

Pete 堅定地相信,未來的深度學習能夠在微型的、低功耗的芯片上自由地奔跑。

單片機 (MCU) ,有一天會成為深度學習最肥沃的土壤。

為什么是單片機?單片機遍地都是

今年一年全球會有大約400億枚單片機 (MCU) 售出。MCU里面有個小CPU,RAM只有幾kb的那種,但醫療設備、汽車設備、工業設備,還有消費級電子產品里,都用得到。

這樣的計算機,需要的電量很小,價格也很便宜,大概不到50美分。

之所以得不到重視,是因為一般情況下,MCU都是用來取代 (如洗衣機里、遙控器里的) 那些老式的機電系統——控制機器用的邏輯沒有發生什么變化。

CPU和傳感器不太耗電,傳輸耗錢、耗電!CPU和傳感器的功耗,基本可以降到微瓦級,比如高通的Glance視覺芯片。

相比之下,顯示器和無線電,就尤其耗電了。即便是WiFi和藍牙也至少要幾十毫瓦。

因為,數據傳輸需要的能量,似乎與傳輸距離成正比。CPU和傳感器只傳幾毫米,如果每個數據都需要端管云這樣傳輸,每個算法都需要輸送到云端進行處理,自然代價就要貴得多。

傳感器的數據很多,傳輸起來很費勁!傳感器能獲取的數據,比人們能用到的數據,多得多。例如:衛星的圖片數據很多,但是傳到地球很困難。

衛星或者宇宙飛船上的宇航員可以用高清相機來拍高清視頻。但問題是,衛星的數據存儲量很小,傳輸帶寬也很有限,從地球上每小時只能下載到一點點數據。

地球上的很多傳感器也一樣,本地獲得很容易,但是傳輸到遠端的數據中心就需要很多的代價。

跟深度學習有什么關系

如果傳感器的數據可以在本地運算,又不需要很多的代價和電力。

我們需要的是,能夠在單片機上運轉的,不需要很多電量的,依賴計算不依賴無線電,并且可以把那些本來要浪費掉的傳感器數據利用起來的。

這也是機器學習,特別是深度學習,需要跨越的鴻溝。

相比之下,神經網絡大部分的時間,都是用來把那些很大很大的矩陣乘到一起,翻來覆去用相同的數字,只是組合方式不同了。

這樣的運算,當然比從DRAM里讀取大量的數值,要低碳得多。

需要的數據沒那么多的話,就可以用SRAM這樣低功耗的設備來存儲。

如此說來,深度學習最適合MCU了,尤其是在8位元計算可以代替浮點運算的時候。

1、深度學習很低碳

那么AI的計算,每次運算需要多少皮焦耳?

比如,MobileNetV2的圖像分類網絡最簡單的結構,大約要用2,200萬次運算。

如果,每次運算要5皮焦,每秒鐘一幀的話,這個網絡的功率就是110微瓦,用紐扣電池也能堅持近一年。

2、對傳感器也友好

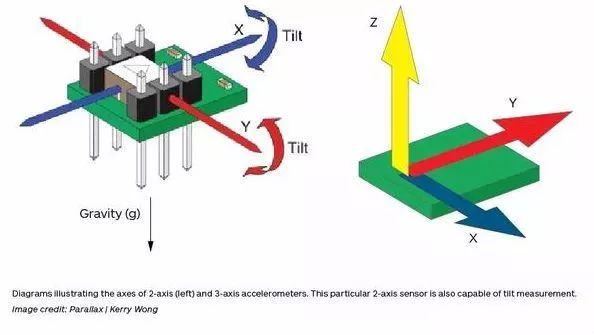

最近幾年,人們用神經網絡來處理噪音信號,比如圖像、音頻、加速度計的數據等等。

如果可以在MCU上運行神經網絡,那么更大量的傳感器數據就可以得到處理,而不是浪費。

那時,不管是語音交互,還是圖像識別功能,都會變得更加輕便。

Training將在很長一段時間里集中在云端,Inference的完成目前也主要集中在云端,但隨著越來越多廠商的努力,很多的應用將逐漸轉移到終端。

目前的市場情況:云端AI芯片市場已被巨頭瓜分殆盡,創業公司生存空間幾乎消失。

云端AI芯片無論是從硬件還是軟件,已經被傳統巨頭控制,給新公司預留的空間極小。不客氣的說,大多數AI芯片公司、希望在云端AI做文章的初創公司幾乎最后都得死。

數據越多,對應用場景越理解的公司,對算法、硬件的需求越清楚、越理解深入。

我們可以看到,芯片巨頭Nvidia(英偉達)已經牢牢占據AI芯片榜首,由于CUDA開發平臺的普及,英偉達的GPU是目前應用最廣的通用AI硬件計算平臺。除了有實力自研芯片的企業(全世界也沒幾家),如果需要做AI相關的工作,必定需要用到Nvidia的芯片。Nvidia的芯片應用普遍,現在所有的AI軟件庫都支持使用CUDA加速,包括谷歌的Tensorflow,Facebook的Caffe,亞馬遜的MXNet等。

除了一騎絕塵的英偉達,其他老牌的芯片巨頭都沒閑著,特別是Intel通過買、買、買奮力的將自己擠到了頭部玩家的位置。微軟在最新的Build大會上公布了基于英特爾FPGA的 AI 方案,而英特爾的 FPGA 業務正是通過收購Altera獲得的。

除此之外,我們可以看到像Google這樣的互聯網廠商也亂入了前五。這當然要歸功于上面提到的TPU,雖然谷歌不直接售賣芯片,但是谷歌通過云服務提供TPU的調用服務。谷歌很早就開源了Tensorflow軟件平臺,這使得Tensorflow成為最主流的機器學習軟件平臺,已經成了事實上行業的軟件平臺標準。而Tensorflow最佳的計算環境必定就是谷歌自己的云服務了,通過軟件、硬件(或者說云)環境的打通,谷歌妥妥的成為AI芯片領域的一方霸主。

現在業界爭論的焦點是AI芯片的處理器架構用哪種是最好的,有前面提及的有GPU、FPGA、DSP和ASIC,甚至還有更前沿的腦神經形態芯片。現在GPU可以認為是處于優勢地位,但其他幾種的處理器架構也各有優勢。Intel則是多方下注,不錯過任何一種處理器架構。谷歌在TPU(其實就是一種ASIC)方面的巨大投入帶來了硬件效能的極大提高,目前看來對GPU的沖擊將是最大的,原因不單單是因為專用架構帶來的效率優勢,還有商業模式方面帶來的成本優勢。在半導體行業內的普遍觀點是,一旦AI的算法相對穩定,ASIC肯定是最主流的芯片形態。看看挖礦芯片的進化歷程,這個觀點非常有說服力。

在云端,互聯網巨頭已經成為了事實上的生態主導者,因為云計算本來就是巨頭的戰場,現在所有開源AI框架也都是這些巨頭發布的。在這樣一個生態已經固化的環境中,留給創業公司的空間實際已經消失。

-

芯片

+關注

關注

456文章

50936瀏覽量

424680 -

人工智能

+關注

關注

1792文章

47409瀏覽量

238924 -

AI芯片

+關注

關注

17文章

1890瀏覽量

35098

原文標題:央視報道《人工智能芯片與傳統芯片的區別》

文章出處:【微信號:melux_net,微信公眾號:人工智能大趨勢】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

人工智能芯片與傳統芯片有何區別

人工智能芯片與傳統芯片有何區別

評論