編者按:通常我們看到的深度強(qiáng)化學(xué)習(xí)的實(shí)現(xiàn)都是在模擬環(huán)境中,例如OpenAI的Gym。但這次,迪士尼研究院的科學(xué)家們將DL應(yīng)用到了模塊化機(jī)器人上,并創(chuàng)建了一個(gè)自動學(xué)習(xí)環(huán)境,可以直接將控制策略應(yīng)用到實(shí)體機(jī)器人上。論智將原論文編譯如下。

在這篇論文中,迪士尼研究院的研究者們提出了一種自動學(xué)習(xí)環(huán)境,直接在硬件(模塊化有腿機(jī)器人)上建立控制策略。這一環(huán)境通過計(jì)算獎(jiǎng)勵(lì)促進(jìn)了強(qiáng)化學(xué)習(xí)過程,計(jì)算過程是利用基于視覺的追蹤系統(tǒng)和將機(jī)器人從新放回原位的重置系統(tǒng)進(jìn)行的。我們應(yīng)用了兩種先進(jìn)的深度學(xué)習(xí)算法——Trust Region Policy Optimization(TRPO)和Deep Deterministic Policy Gradient(DDPG),這兩種算法可以訓(xùn)練神經(jīng)網(wǎng)絡(luò)做簡單的前進(jìn)或者爬行動作。利用搭建好的環(huán)境,我們展示了上述兩種算法都能在高度隨機(jī)的硬件和環(huán)境條件下有效學(xué)習(xí)簡單的運(yùn)動策略。之后我們將這種學(xué)習(xí)遷移到了多腿機(jī)器人上。

問題概述

自然界中,很多生物都能根據(jù)環(huán)境做出適應(yīng)性動作。在最近一項(xiàng)對盲蜘蛛(也稱長腳蜘蛛)的研究發(fā)現(xiàn),當(dāng)它們遇到敵人時(shí),會自動伸出腳,過一段時(shí)間后又會恢復(fù)行走速度和轉(zhuǎn)向控制。即使不會自動變化,很多生物也會在改變身體結(jié)構(gòu)之后調(diào)整動作姿態(tài),這都是長期學(xué)習(xí)適應(yīng)的結(jié)果。那么我們能否從借鑒生物將這種學(xué)習(xí)運(yùn)動的技巧應(yīng)用到機(jī)器人身上呢?

之前有科學(xué)家依賴先驗(yàn)知識手動為機(jī)器人設(shè)計(jì)合適的步態(tài),雖然經(jīng)驗(yàn)豐富的工程師能讓機(jī)器人隨意移動,但在可以組裝的機(jī)器人身上這種方法就不切實(shí)際了。

最近,研究者又表示可以用深度強(qiáng)化學(xué)習(xí)技術(shù)提高采樣策略,從而在虛擬環(huán)境中完成很多任務(wù),例如游泳、跳躍、行走或跑步。但是對于真實(shí)的有腿機(jī)器人來說,深度強(qiáng)化學(xué)習(xí)技術(shù)卻很少應(yīng)用,因?yàn)樵谖覀兊慕?jīng)驗(yàn)中,即使一個(gè)簡單的爬行動作對真實(shí)硬件來說也是很困難的,因?yàn)樯婕暗蕉嘧兊奈唇?jīng)模式化的動作。

在這篇論文中,迪士尼研究院的科學(xué)家們提出了一種針對深度強(qiáng)化學(xué)習(xí)運(yùn)動任務(wù)的自動環(huán)境,其中包括一個(gè)視覺追蹤器和一個(gè)重置機(jī)制。在這一環(huán)境之上,科學(xué)家們在可組裝的有腿機(jī)器人上應(yīng)用了兩種學(xué)習(xí)算法——TRPO和DDPG。之后訓(xùn)練神經(jīng)網(wǎng)絡(luò)策略在單腿機(jī)器人和多腿機(jī)器人上的運(yùn)動,結(jié)果證明算法能在硬件上有效地學(xué)習(xí)控制策略。

實(shí)驗(yàn)裝置說明

實(shí)驗(yàn)所用機(jī)器人如圖所示:

這類似蜘蛛的機(jī)器人是可以靈活拆卸的,中間的本體是一個(gè)六邊形的形狀,每一面都可以利用磁鐵吸附上一條“機(jī)械腿”,不過在實(shí)驗(yàn)中研究人員最多只用了三條腿。除此之外,這三條腿也各不相同,分別可以實(shí)現(xiàn)不同的前進(jìn)方向。

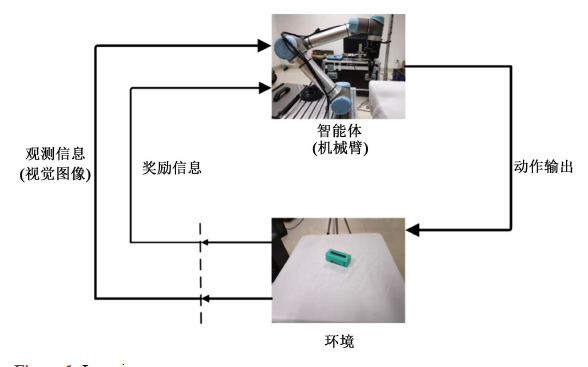

實(shí)驗(yàn)的環(huán)境布局如下圖所示:

環(huán)境主要由兩部分組成:視覺追蹤系統(tǒng)和讓機(jī)器人復(fù)位的重置裝置。視覺系統(tǒng)是用消費(fèi)級攝像頭實(shí)現(xiàn)的,距離平面約90cm,它追蹤的是機(jī)器人身上的綠色和紅色兩個(gè)點(diǎn),從而重現(xiàn)全局的位置并為機(jī)器人導(dǎo)航。

重置裝置是全自動學(xué)習(xí)環(huán)境中的重要組成部分。我們用只有一個(gè)自由度的杠桿結(jié)構(gòu)即可將機(jī)器人拉回到初始位置。該裝置距離機(jī)器人25cm,兩個(gè)1.5m長的線分別連接機(jī)器人本體上的兩點(diǎn)。

設(shè)置完畢后,研究人員將控制問題用部分可觀察馬爾科夫決策過程(POMDP)表示,它可以用無法觀察到的狀態(tài)變量來解釋決策問題。具體的數(shù)學(xué)公式可參考原論文。

學(xué)習(xí)算法

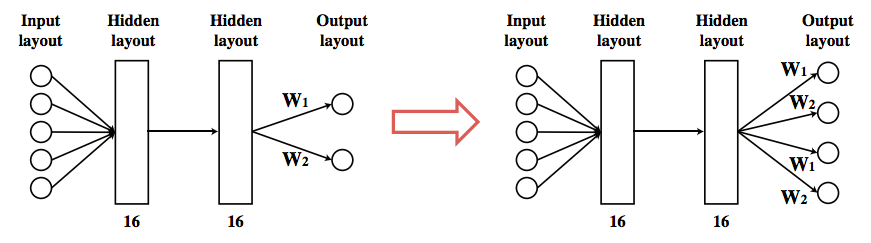

模型的策略用一個(gè)神經(jīng)網(wǎng)絡(luò)表示,該網(wǎng)絡(luò)由兩個(gè)完全連接的隱藏層組成,每層有16個(gè)tanh活動神經(jīng)元。當(dāng)在單腿機(jī)器人上訓(xùn)練好策略,我們也許能將所學(xué)到的知識轉(zhuǎn)移到多腿機(jī)器人上。假設(shè)所有的腿都有同樣的接頭形狀,我們可以通過復(fù)制輸出神經(jīng)元和對應(yīng)的鏈接進(jìn)行多腿運(yùn)動。

實(shí)驗(yàn)結(jié)果

在實(shí)驗(yàn)中,研究人員主要研究了兩個(gè)問題:

目前最先進(jìn)的深度強(qiáng)化學(xué)習(xí)算法能否直接在硬件上訓(xùn)練策略?

我們能否通過遷移策略將學(xué)習(xí)轉(zhuǎn)化到復(fù)雜場景中?

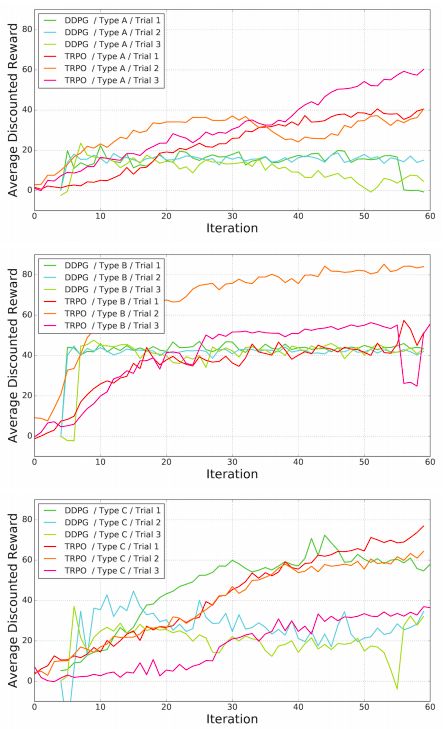

科學(xué)家們首先訓(xùn)練了一條腿的機(jī)器人,最終動作類似于爬行。A、B、C三種腿型的結(jié)果如圖:

可以看到,TRPO和DDPG兩種算法都能成功地在硬件上進(jìn)行訓(xùn)練,同時(shí)表現(xiàn)得要比其他手動設(shè)計(jì)的步態(tài)優(yōu)秀。

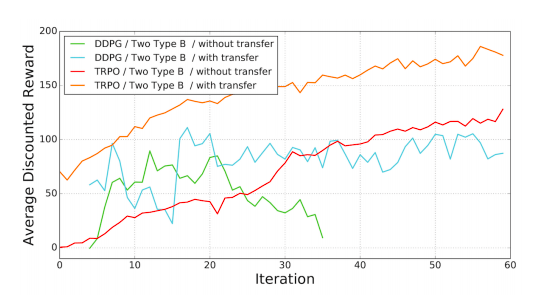

接下來科學(xué)家測試了學(xué)習(xí)框架在多腿運(yùn)動上的表現(xiàn)。首先是用兩個(gè)Type B的腿進(jìn)行爬行動作。下圖是兩種算法在遷移學(xué)習(xí)和無遷移下的表現(xiàn):

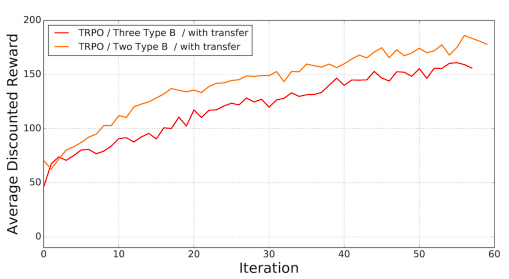

結(jié)果符合預(yù)期,遷移學(xué)習(xí)能作為一個(gè)很好地初始解決政策。接著研究人員又測試了三條腿前進(jìn)的表現(xiàn),結(jié)果顯示中間的那條腿作用并不大。

結(jié)語

由于傳感器能力有限,研究者在這項(xiàng)實(shí)驗(yàn)中僅對簡單的開環(huán)爬行運(yùn)動進(jìn)行了實(shí)驗(yàn)。如果有更復(fù)雜的控制器和獎(jiǎng)勵(lì)的話,也許會得到更復(fù)雜的行為。例如,可以用基于IMU的反饋控制器訓(xùn)練機(jī)器人走路或跑步。或者可以使用深度相機(jī)收集機(jī)器人的高度,當(dāng)它們從爬行轉(zhuǎn)變成走路時(shí)給予獎(jiǎng)勵(lì)。

除此之外,雖然研究者展示了遷移學(xué)習(xí)在初始策略上的重要作用,但都是應(yīng)用在相同種類的腿上,動作也都類似。未來,他們計(jì)劃將動作分解成不同難度水平的,應(yīng)用于不同任務(wù)上。

自動學(xué)習(xí)過程有時(shí)會生成意想不到的行為。例如,在做空翻動作時(shí),追蹤系統(tǒng)會出現(xiàn)bug,因?yàn)闄C(jī)器人會擋住標(biāo)記從而對其位置進(jìn)行誤判。雖然這不會對這次實(shí)驗(yàn)中的機(jī)器人造成損壞,但是對于體型龐大的機(jī)器人卻是致命的。所以,想在硬件系統(tǒng)上進(jìn)行直接學(xué)習(xí)可能也需要傳統(tǒng)算法的幫助,保證機(jī)器人的安全,而不是一位追求采樣的高效。

-

機(jī)器人

+關(guān)注

關(guān)注

211文章

28466瀏覽量

207313 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4772瀏覽量

100838 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5504瀏覽量

121222

原文標(biāo)題:迪士尼創(chuàng)建新框架,將深度學(xué)習(xí)直接應(yīng)用到實(shí)體機(jī)器人上

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

什么是深度強(qiáng)化學(xué)習(xí)?深度強(qiáng)化學(xué)習(xí)算法應(yīng)用分析

深度學(xué)習(xí)DeepLearning實(shí)戰(zhàn)

深度強(qiáng)化學(xué)習(xí)實(shí)戰(zhàn)

將深度學(xué)習(xí)和強(qiáng)化學(xué)習(xí)相結(jié)合的深度強(qiáng)化學(xué)習(xí)DRL

強(qiáng)化學(xué)習(xí)環(huán)境研究,智能體玩游戲?yàn)槭裁磪柡?/a>

如何使用深度強(qiáng)化學(xué)習(xí)進(jìn)行機(jī)械臂視覺抓取控制的優(yōu)化方法概述

深度強(qiáng)化學(xué)習(xí)的概念和工作原理的詳細(xì)資料說明

深度強(qiáng)化學(xué)習(xí)到底是什么?它的工作原理是怎么樣的

強(qiáng)化學(xué)習(xí)在智能對話上的應(yīng)用介紹

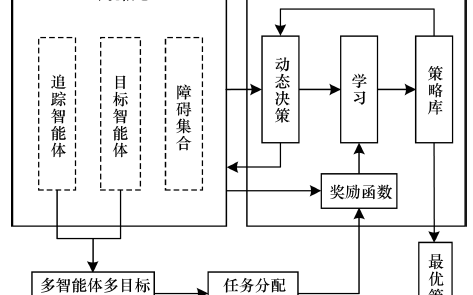

一種基于多智能體協(xié)同強(qiáng)化學(xué)習(xí)的多目標(biāo)追蹤方法

基于深度強(qiáng)化學(xué)習(xí)仿真集成的壓邊力控制模型

《自動化學(xué)報(bào)》—多Agent深度強(qiáng)化學(xué)習(xí)綜述

一種針對深度強(qiáng)化學(xué)習(xí)運(yùn)動任務(wù)的自動環(huán)境

一種針對深度強(qiáng)化學(xué)習(xí)運(yùn)動任務(wù)的自動環(huán)境

評論