IBM正在研制一種可兼顧高精度學習和低精度推理的深度學習芯片。

深度學習領域仍在不斷發展,特別地,專家們認識到如果芯片能夠使用低精度的計算方式得出近似答案,神經網絡就可以用很少的資源完成大量的計算。這在移動設備和其他功率受限的設備中尤其有用。但對某些任務,尤其是訓練神經網絡去完成某些事情的任務來說,精確性仍然是必需的。IBM最近在IEEE VLSI研討會上展示了其最新的解決方案(目前仍然是原型):一款在上述兩方面都有良好表現的芯片。

訓練神經網絡與使用該網絡執行其功能(稱為推理)的需求之間存在脫節,這對那些從事于設計芯片以加速AI功能的人來說是一個巨大的挑戰。IBM的新型AI加速器芯片能夠滿足該公司提出的所謂范圍精度(scaled precision)要求。也就是說,它可以在32位、16位,甚至1位或2位模式下進行訓練和推理。

IBM約克鎮高地(Yorktown Heights)研究中心的杰出技術人員、該項工作的領導者Kailash Gopalakrishnan解釋說:“在訓練中,你能夠使用的最好精度是16位,而在推理中可以應用的最好精度是2位。這個芯片可能涵蓋了目前已知的最佳訓練和最好推理。”

該芯片能夠獲得上述表現的原因來自于兩項創新,而這兩項創新的目標都是實現相同的結果——保持所有處理器組件能夠得到數據和工作。

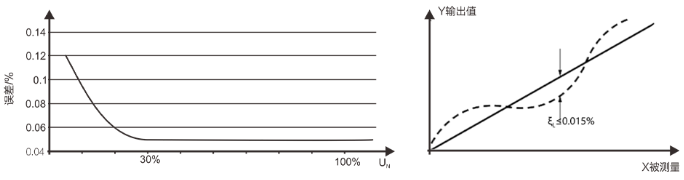

Gopalakrishnan說:“在深度學習方面,傳統芯片架構面臨的挑戰之一是利用率一般非常低。”也就是說,即使芯片可能具有非常高的峰值性能,通常只有20%到30%的資源能夠被用于解決問題。IBM始終將所有任務的目標定為90%。

利用率低通常是因為存在于芯片周圍的數據流瓶頸。為了突破這些信息障礙,Gopalakrishnan的團隊開發了一個“定制”的數據流系統。該數據流系統是一種網絡方案,可以加速數據從一個處理引擎到下一個處理引擎的傳輸過程。它還針對要處理的是學習任務還是推理任務以及不同的精度進行了優化。

第二項創新是使用專門設計的“便箋本”形式的片上存儲器,而不是CPU或GPU上的傳統高速緩沖存儲器。構建高速緩存是為了遵守某些對一般計算有意義的規則,但會導致深度學習的延遲。例如,在某些情況下,緩存會將一大塊數據推送到計算機的主存儲器(強制推送),但如果神經網絡的推理或學習過程需要用到該數據,則系統將不得不保持等待狀態,直到可以從主存儲器中檢索到該數據。

便箋本遵循不同的規則。構建它的目標是為了保持數據流經芯片的處理引擎,并確保數據在恰當的時間處于正確的位置。為了獲得90%的利用率,IBM必須使設計出的便箋本具有巨大的讀/寫帶寬(每秒192千兆字節)。

由此產生的芯片可以執行當前所有的三種主要深度學習AI:卷積神經網絡(CNN)、多層感知器(MLP)和長-短期記憶(LSTM)。Gopalakrishnan解釋說,這些技術共同主導了語言、視覺和自然語言處理。在16位精度(尤其是針對訓練)情況下,IBM的新芯片能夠在每秒鐘內執行1.5萬億次浮點運算;在2位精度下(推理的最佳設置)則躍升到每秒12萬億次運算。

Gopalakrishnan指出,由于芯片是采用先進的硅CMOS工藝(GlobalFoundries的14納米工藝)制造的,每秒鐘內發生的所有這些操作都被限制在一個相當小的區域內。為了推理出一個CNN網絡,該芯片可以在每平方毫米內每秒執行平均1.33萬億次操作。這個數字很重要,“因為在很多應用中,你的成本受到尺寸的限制,”他說。

新的架構也證明了IBM研究人員幾年來一直在探索的東西:如果以高得多的精度訓練神經網絡,真正低精度的推理就無法正常進行。Gopalakrishnan說:“當低于8位時,訓練與推理將開始直接相互影響。一個在16位模式下訓練但以1位模式部署的神經網絡系統將出現無法接受的重大錯誤。因此,以與最終部署方式類似的精度訓練網絡將帶來最好的結果。”

尚無任何消息披露這項技術什么時候可能以Watson或其他形式進行商業化,但Gopalakrishnan的領導、IBM半導體研究所的副總裁Mukesh Khare表示希望它能夠發展和改進。他說:“這只是冰山一角,我們正在進行更多創新。”

-

IBM

+關注

關注

3文章

1758瀏覽量

74727 -

深度學習

+關注

關注

73文章

5506瀏覽量

121259

原文標題:IBM正在研制通用型深度學習芯片

文章出處:【微信號:AI_News,微信公眾號:人工智能快報】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

ADS7142如果保證其高精度呢?

GPU深度學習應用案例

AI大模型與深度學習的關系

VS高精度電壓傳感器

深度學習編譯器和推理引擎的區別

深度神經網絡模型量化的基本方法

深度學習模型量化方法

什么是高精度定位平板?

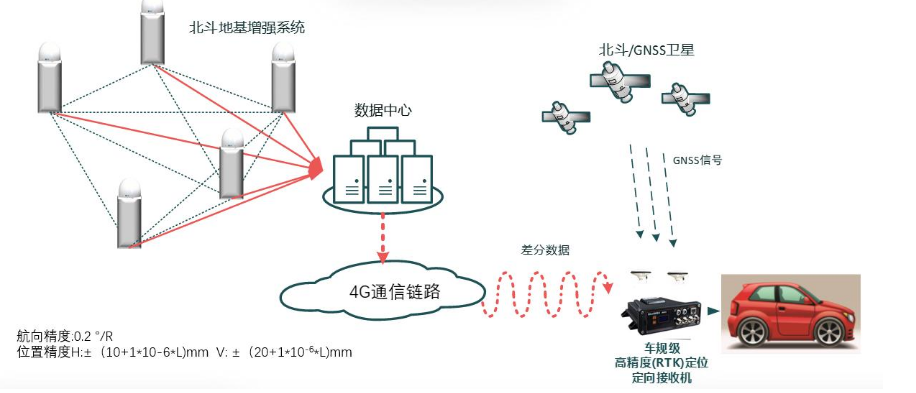

北斗高精度定位終端的工作原理和精度范圍

幾款高精度時鐘芯片的規格選型分析

深度解析深度學習下的語義SLAM

IBM研制可兼顧高精度學習和低精度推理的深度學習芯片

IBM研制可兼顧高精度學習和低精度推理的深度學習芯片

評論