第29屆IEEE國際智能車大會(huì)(IEEE IV 2018)于6月30日在江蘇常熟順利落幕,本屆大會(huì) 的Best Student Paper Awards(最佳學(xué)生論文獎(jiǎng))分別頒給了來自西安交通大學(xué)、加州大學(xué)伯克利分校、中山大學(xué)的三篇論文。

本屆IV大會(huì)共收到了來自34個(gè)國家的603篇論文,其中確認(rèn)接收的論文346篇,在所有接收的論文里,Automated Vehicles, Vision Sensing and Perception, and Autonomous / Intelligent Robotic Vehicles成為本屆論文最熱的關(guān)鍵詞。

IV會(huì)議共設(shè)有“BestPaperAwards”、 “BestStudentPaperAwards” 、 “ BestWorkshop / Special Session Paper Awards ” 、 “Best Poster Paper Awards ” 和 “BestApplication Paper Awards”五大獎(jiǎng)項(xiàng)。本文主要介紹獲得Best Student PaperAwards(最佳學(xué)生論文獎(jiǎng))的三篇論文,與之前BestPaper Awards論文不同,這三篇論文的第一作者都是在校學(xué)生。

IEEE IV 2018 Best Student Paper Awards

First Prize

在最佳學(xué)生論文中,獲得一等獎(jiǎng)的是來自西安交通大學(xué)的論文基于硬件在環(huán)的無人駕駛仿真平臺(tái)(Autonomous Vehicle Testing and Validation Platform: Integrated Simulation System with Hardware in the Loop)。該論文的作者為YU Chen,Shitao Chen等都來自鄭南寧院士團(tuán)隊(duì)。以下是論文簡述:

隨著自動(dòng)駕駛的發(fā)展,離線測試和仿真是目前用于多種交通場景中無人駕駛車輛性能驗(yàn)證的一種低成本,低風(fēng)險(xiǎn)且高效率的方法。在我們的工作中因考慮到現(xiàn)今不同仿真平臺(tái)的不足,我們提出了一種新型的,基于硬件在環(huán)系統(tǒng)的仿真平臺(tái)。該平臺(tái)支持車輛動(dòng)力學(xué)仿真,各種傳感器仿真以及多種復(fù)雜交通場景構(gòu)建。通過硬件在環(huán)的測試與驗(yàn)證方式我們能夠有效地利用仿真環(huán)境來規(guī)避路測所帶來的潛在風(fēng)險(xiǎn)并驗(yàn)證無人車多模塊算法安全性。同時(shí)通過與真車中完全相同的硬件層溝通仿真環(huán)境與現(xiàn)實(shí)場景,我們能夠準(zhǔn)確有效地完成已驗(yàn)證的算法從仿真環(huán)境到真實(shí)場景的遷移。

1.仿真平臺(tái)開發(fā)的目的

為了保證無人駕駛車輛開發(fā)的安全性,有效性和可持續(xù)性,必須進(jìn)行廣泛的開發(fā)和測試。然而傳統(tǒng)的無人駕駛路測昂貴耗時(shí),具有風(fēng)險(xiǎn)性且只能夠在有限交通場景下進(jìn)行試驗(yàn)。此外,一些特殊場景,如極端天氣,傳感器故障,道路部分路段損毀等也不能夠進(jìn)行反復(fù)的測試和復(fù)現(xiàn)。而無人駕仿真系統(tǒng)則為這個(gè)難題提供了一種安全有效的解決途徑。借助仿真環(huán)境中對車輛動(dòng)力學(xué)控制,多傳感器仿真,多交通場景模擬,我們可以極大地提高開發(fā)效率,驗(yàn)證無人駕駛環(huán)境感知,車輛定位,路徑規(guī)劃以及決策控制等多模塊算法的有效性。

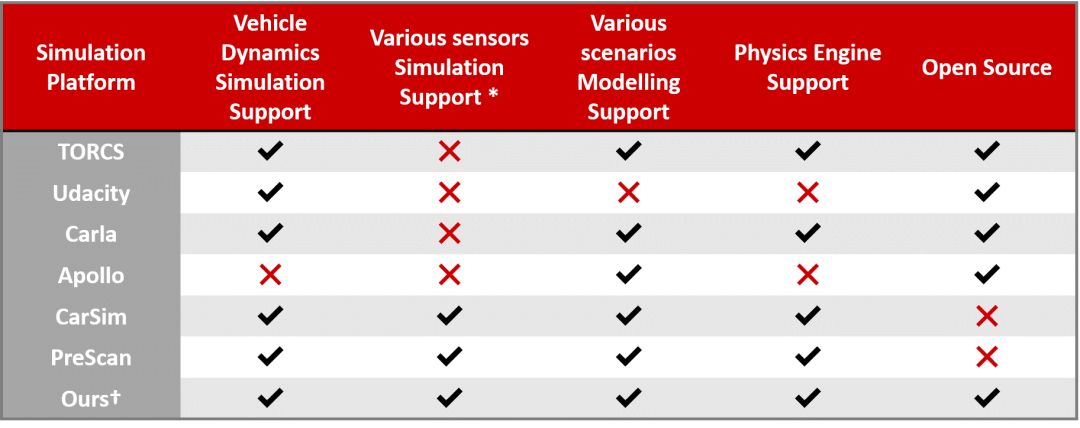

目前應(yīng)用于無人駕駛仿真領(lǐng)域仿真器多種多樣,被廣泛使用的主要有TORCS, PRESCAN, CarSim, Carla等。然而這些仿真器也并不能真正意義上全面地實(shí)現(xiàn)對無人車性能測試的多方面的要求。涉及到的問題有車輛模型和駕駛場景的逼真度,算法測試的準(zhǔn)確度,仿真流程的有效性以及仿真器自身是否對大多數(shù)開發(fā)者們友好開放等。

圖1 多仿真器對比表

實(shí)際上現(xiàn)在大多數(shù)的開源仿真器都是特別適用于無人駕駛仿真的單一或者幾個(gè)特定的模塊,并不能被應(yīng)用于所用駕駛場景中。一些商業(yè)化的仿真器的功能更為全面但價(jià)格也比較昂貴。因而在我們的工作中我們的目的就是構(gòu)建一個(gè)全面的,對開發(fā)者友好的仿真平臺(tái)。

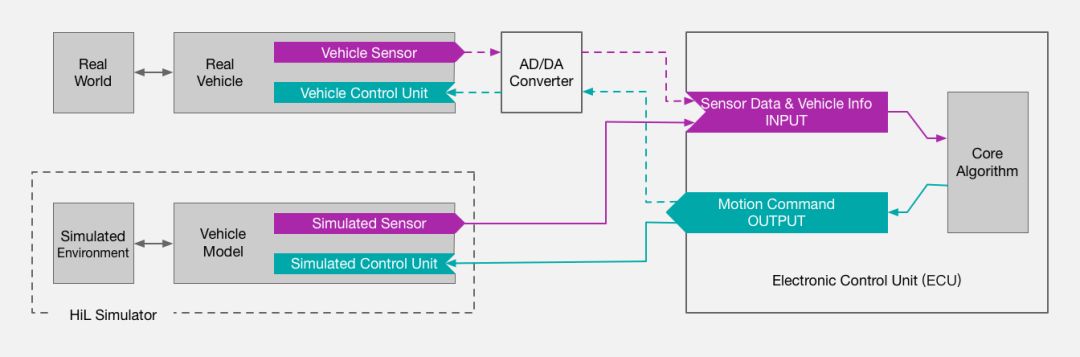

此外,采用硬件在環(huán)系統(tǒng)進(jìn)行仿真是我們平臺(tái)進(jìn)行開發(fā)驗(yàn)證的核心。在硬件在環(huán)的仿真方法中,我們將待進(jìn)行測試的控制單元硬件連接到虛擬的仿真環(huán)境中來測試核心算法的可行性和控制器的有效性。這樣不僅能夠快速有效地評(píng)估算法的性能,同時(shí)也能夠極大的提升測試安全性和算法安全性。一方面基于硬件在環(huán)的仿真避免了實(shí)際道路測試可能導(dǎo)致的風(fēng)險(xiǎn),另一方面我們能夠在模擬的仿真環(huán)境中進(jìn)行各種特殊駕駛場景的測試從而訓(xùn)練算法,不斷提高其魯棒性,最終保證對仿真車輛安全駕駛的模擬。

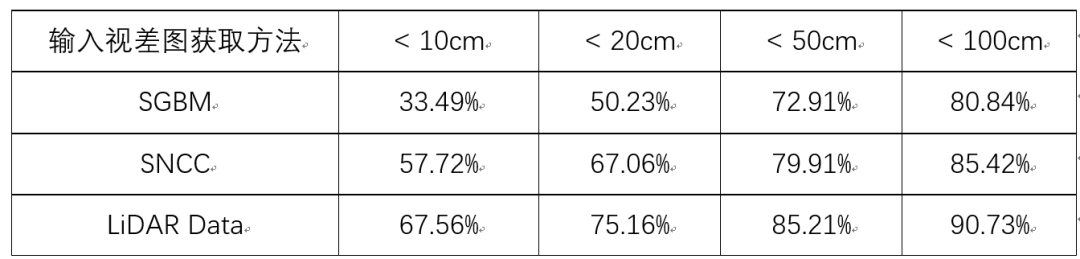

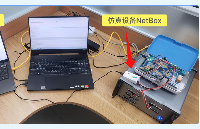

圖2 硬件在環(huán)仿真系統(tǒng)示意圖

2.仿真方法介紹

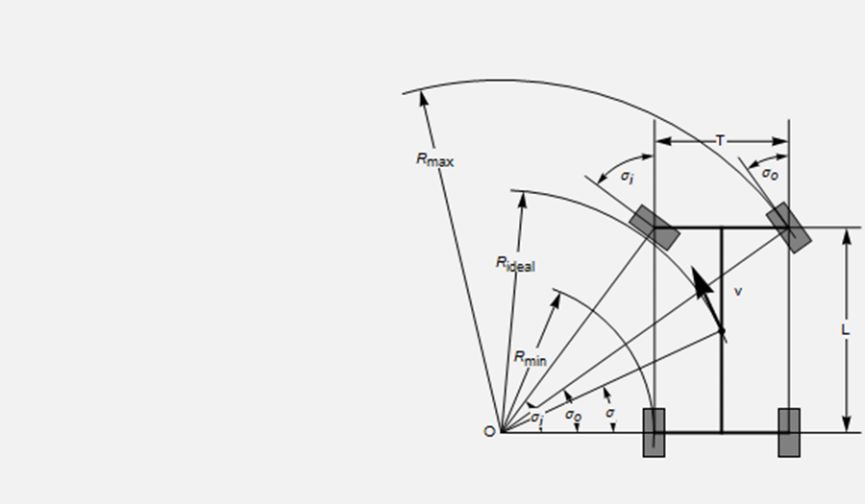

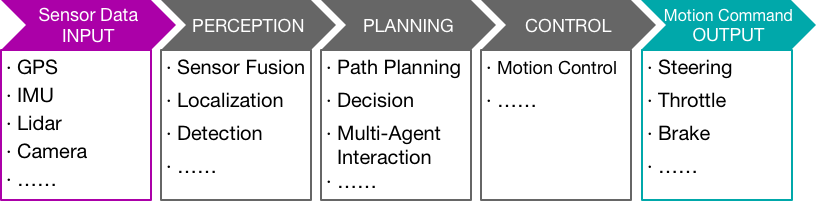

圖3 仿真框架示意圖

仿真平臺(tái)包含仿真層和硬件層兩大模塊。其中仿真層包括了仿真車輛模型設(shè)計(jì),多仿真?zhèn)鞲衅髂M以及多虛擬交通場景構(gòu)建。硬件控制層與仿真層相連接構(gòu)成閉環(huán)測試系統(tǒng),用于全面測試和驗(yàn)證硬件和算法。仿真?zhèn)鞲衅?a target="_blank">信息以及車身狀態(tài)由仿真層輸入到算法進(jìn)行相關(guān)計(jì)算后輸出結(jié)果到硬件控制單元生成相應(yīng)的控制指令,如剎車,油門、轉(zhuǎn)向指令等,再傳入到仿真層對車輛進(jìn)行相應(yīng)控制。

首先對于仿真層中車輛動(dòng)力學(xué)的模型設(shè)計(jì),我們使用3D建模軟件先進(jìn)行車輛建模,設(shè)定相關(guān)的必要參數(shù),如重量、慣性、摩擦系數(shù)、扭矩等;考慮到實(shí)際車輛的安全性,仿真車輛的最大速度,前輪最大轉(zhuǎn)角,最大扭矩和最大胎壓等參數(shù)也需要具體設(shè)定;另外為了實(shí)現(xiàn)車輛橫向與縱向的平穩(wěn)動(dòng)力學(xué)控制,我們采用了Ackermann轉(zhuǎn)向幾何模型來保證車輛的安全轉(zhuǎn)向。

圖4 Ackermann模型

其次對于多種無人駕駛所需的傳感器的仿真,我們的平臺(tái)支持對雙目/單目相機(jī),多線激光雷達(dá)(16/32/64),超聲波雷達(dá),GPS以及慣性測量單元IMU的仿真模型以及實(shí)際功能模擬。傳感器能夠被簡單快速地添加,移動(dòng)或者移除。我們也可選擇是否連接到傳感器或者隨時(shí)更新其配置參數(shù),如探測范圍,信息更新頻率,噪聲程度等。

圖5 多傳感器模擬示意圖

最后對于多種虛擬駕駛環(huán)境的構(gòu)建,主要有兩種方法。第一種是使用模型庫中提供的一些仿真模型,或者自行根據(jù)需求利用3D建模軟件構(gòu)建仿真模型,再對單個(gè)的仿真模型進(jìn)行整合從而構(gòu)建出預(yù)期的仿真場景。另一種方法是使用OpenStreetMap來直接通過地圖來導(dǎo)出大場景模型再進(jìn)行后期精細(xì)化操作。OpenStreetMap是一個(gè)強(qiáng)大的地圖編輯平臺(tái),某一局部區(qū)域甚至是某一城市的實(shí)際地圖都能夠被在線導(dǎo)出成可編輯的文件,從而方便實(shí)現(xiàn)對某一固定實(shí)際場景仿真,同時(shí)也很大程度上節(jié)約了場景構(gòu)建的時(shí)間。

圖6 利用OSM獲得場景模型示意圖

3.實(shí)驗(yàn)與驗(yàn)證

論文中提出的硬件在環(huán)仿真平臺(tái)可以被用來驗(yàn)證無人駕駛車輛環(huán)境感知,路徑規(guī)劃以及運(yùn)動(dòng)控制等重要模塊的算法有效性。我們分別對與這些模塊緊密相關(guān)的路徑跟隨算法、自動(dòng)泊車算法以及基于多智能體(multi-agent)的車輛跟隨算法進(jìn)行了測試與驗(yàn)證。

圖7 仿真驗(yàn)證模塊示意圖

首先對于仿真車輛的路徑跟隨算法, 其需要根據(jù)給定的行駛路徑計(jì)算出符合車輛動(dòng)力學(xué)的剎車,油門,轉(zhuǎn)向指令來實(shí)現(xiàn)平穩(wěn)的路徑跟隨過程。

然后對于自動(dòng)泊車算法,我們構(gòu)建了一個(gè)虛擬的停車場環(huán)境方便場景模擬。目標(biāo)車輛需要在行進(jìn)過程中依據(jù)傳感器信息找到距離自己最近的可用停車位,并選用合適的停車方式來規(guī)劃出停車路徑并實(shí)現(xiàn)平穩(wěn)泊車。

最后對于基于多智能體系統(tǒng)的車輛跟隨算法, 論文中假設(shè)每一輛車為一個(gè)智能體,其與周圍車輛以及駕駛環(huán)境進(jìn)行實(shí)時(shí)交互。這樣的多智能體系統(tǒng)可以用來進(jìn)行V2V以及V2I等方面的開發(fā)。論文中我們進(jìn)行了車輛跟隨算法的驗(yàn)證。通過基于增強(qiáng)學(xué)習(xí)的訓(xùn)練過程,跟隨車輛能夠始終與前車保持一定安全距離,穩(wěn)定地實(shí)現(xiàn)跟車換道等行為。

4.總結(jié)

論文中我們提出了一種新型的基于硬件在環(huán)的無人車仿真與測試平臺(tái)。其能夠很好的實(shí)現(xiàn)對車輛動(dòng)力學(xué)模型,多種傳感器以及不同駕駛場景的模擬。同時(shí)硬件在環(huán)的仿真方法在降低測試成本和時(shí)間的條件下,也保證了測試的安全性和驗(yàn)證了算法的安全性。

Second Prize

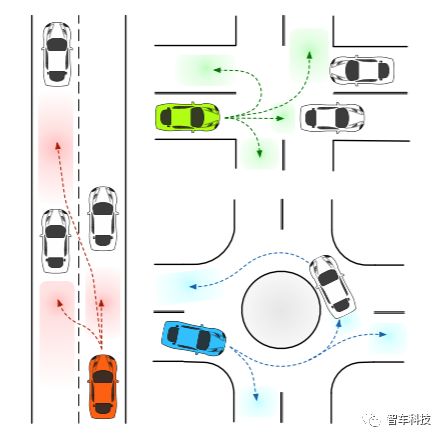

預(yù)測車輛在不同駕駛場景下的插入?yún)^(qū)域(彩色區(qū)域)

獲得最佳學(xué)生論文二等獎(jiǎng)的是來自美國加州大學(xué)伯克利分校機(jī)械工程系的Yeping Hu博士,他在論文中分享了他們在車輛語義意圖和運(yùn)動(dòng)的概率預(yù)測方面的研究論文。研究涵蓋城市自動(dòng)駕駛的決策,運(yùn)動(dòng)規(guī)劃和運(yùn)動(dòng)預(yù)測。目前正在開展一項(xiàng)BDD項(xiàng)目:“基于深度神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)的隨機(jī)政策的城市自主駕駛運(yùn)動(dòng)預(yù)測”。目前大多數(shù)研究僅通過考慮特定場景來確定駕駛意圖的數(shù)量。然而,不同的駕駛環(huán)境通常包含各種可能的駕駛操縱。因此,需要一種能夠適應(yīng)不同流量場景的意圖預(yù)測方法。在Yeping Hu博士的論文中提出了一種基于語義的意圖和運(yùn)動(dòng)預(yù)測(SIMP)方法,可以通過使用語義定義的車輛行為來適應(yīng)任何駕駛場景。它利用基于深度神經(jīng)網(wǎng)絡(luò)的概率框架來估計(jì)周圍車輛的意圖,最終位置和相應(yīng)的時(shí)間信息。

Third Prize

最佳學(xué)生論文的三等獎(jiǎng)來自中山大學(xué)數(shù)據(jù)與計(jì)算機(jī)科學(xué)學(xué)院,該論文研究了計(jì)算機(jī)視覺的內(nèi)容,同時(shí)還是國家自然科學(xué)基金項(xiàng)目。以下是論文的主要內(nèi)容:

計(jì)算機(jī)視覺因?yàn)榭梢杂行彝ㄟ^易獲得的方式獲取周邊環(huán)境的顏色信息而成為了研究廣泛的熱門領(lǐng)域。通過攝像頭來幫助機(jī)器人或無人車?yán)斫馄渌幍耐獠凯h(huán)境也成為至關(guān)重要的一步。通過雙目視覺算法可以獲得圖像中像素點(diǎn)的深度信息從而可以對周圍場景進(jìn)行三維建模。然而,當(dāng)前所存在的三維空間表達(dá)形式存在有明顯的弊端,主要的問題集中在以下兩點(diǎn):第一大規(guī)模的三維場景數(shù)據(jù)信息量非常大,如何有效的壓縮地圖大小存在一定難度;第二是如何更大程度的保存有效信息并且保障精度。

在本文中,我們關(guān)注這些問題并且提出了一種全新的三維空間表達(dá)形式并且將其命名為Planecell。通過在深度信息的監(jiān)督下的平面轉(zhuǎn)區(qū),我們可以將平面單元投影到三維空間中去。所提出的Planecell表達(dá)方式適用于大規(guī)模的人造場景中,可以在不丟失像素級(jí)別精度的情況下明顯的減少存儲(chǔ)圖像大小,并且可以拓展到更多的三維重建應(yīng)用當(dāng)中。通過實(shí)驗(yàn)檢驗(yàn),我們的三維空間表達(dá)形式相比于點(diǎn)云地圖大小在同等精度下縮小了200倍,并且我們也和當(dāng)前排名靠前的深度學(xué)習(xí)雙目匹配算法得到的點(diǎn)云地圖進(jìn)行了像素級(jí)別的精度比較,同樣達(dá)到了不錯(cuò)的結(jié)果。

圖1:Planecell方法流程圖

1.方法簡介

如圖一所示,本文所提出方法的輸入是一張色彩圖像和對應(yīng)的深度圖像。我們使用一種深度監(jiān)督的超像素分割算法通過在邊界更新方程中加入深度衡量項(xiàng)對左圖進(jìn)行切割。超像素分割過程使用了爬山法來減少不必要的計(jì)算量。同時(shí),我們還在邊界更新方程中加入規(guī)則化項(xiàng)來避免超像素邊界的復(fù)雜化(復(fù)雜的超像素邊界不利于保存和二維-三維轉(zhuǎn)化)。超像素的分層邊界更新只進(jìn)行到固定邊長的網(wǎng)格大小,不再進(jìn)行像素級(jí)別的更新。深度圖在本文中使用雙目匹配方法來得到結(jié)果。同樣的,較為稀疏的或者是通過其他傳感器得到的深度圖也可以作為我們算法的輸入,因?yàn)槲覀兊乃惴ㄔ跀M合平面時(shí)使用了隨機(jī)取樣的方式來避免錯(cuò)誤點(diǎn)對于結(jié)果的負(fù)面影響。超像素的邊界會(huì)在平面方程擬合結(jié)果出來后進(jìn)行進(jìn)一步的更新。每一個(gè)超像素都是之后進(jìn)行重建的基本元素。

為了更高效的保存每一個(gè)超像素。我們提出一種方法來抓取每一個(gè)超像素的角點(diǎn)。因?yàn)槊恳粋€(gè)超像素都是多邊形,所以只需它們的角點(diǎn)就能完整的保存他們的邊界信息。將二維超像素投影到三維空間中后,對于已存在的三維平面,我們通過最小化全局能量方程來聚合關(guān)系為共面單元。

2.實(shí)驗(yàn)驗(yàn)證

我們根據(jù)數(shù)據(jù)集的特性,分別在三個(gè)數(shù)據(jù)集上了測試了我們的算法。三個(gè)數(shù)據(jù)集分別是KITTI Stereo、KITTI Odometry和 Middlebury Stereo 數(shù)據(jù)集。KITTI Stereo 數(shù)據(jù)集將用于測試的雙目圖片分為測試集和訓(xùn)練集,其中訓(xùn)練集部分包含了通過激光雷達(dá)獲得的視差真值。每一組圖片包含前后兩幀的左右圖共四張圖片。KITTI測試榜單所提供的室外場景是具有挑戰(zhàn)性的,因?yàn)槊恳环鶊D片都包含十分明顯的視差變化。我們的算法表現(xiàn)了對于 KITTI 數(shù)據(jù)集處理的優(yōu)越性,尤其是對于包含大量幾何結(jié)構(gòu)人造場景的圖像。為了更好的表現(xiàn)我們所提出的三維空間表達(dá)方式對于大規(guī)模大尺度輸入的處理能力,我們在 KITTI Odometry 上測試了上千張雙目圖片作為輸入的結(jié)果。第三個(gè)數(shù)據(jù)集是 Middlebury Stereo 2001 數(shù)據(jù)集,其中包含了9組室內(nèi)場景。

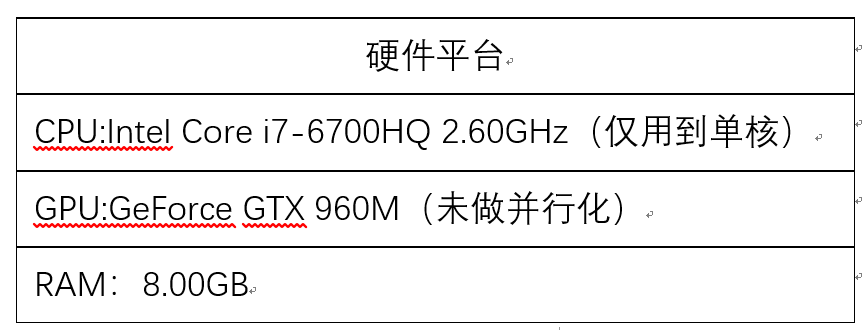

我們從結(jié)果的精度、速度、內(nèi)存需求和傳達(dá)有用信息的能力等方面對我們的算法進(jìn)行了評(píng)估。我們在精度上對比了最基本的直接將二維像素點(diǎn)投影到三維空間點(diǎn)云的方法。接下來,我們修改了我們算法的輸入視差圖算法(包括密集、半密集和稀疏)來測量我們算法的適應(yīng)性。我們同樣對比了我們算法與基于體素的三維表達(dá)方式的優(yōu)勢。

表1 測試平臺(tái)

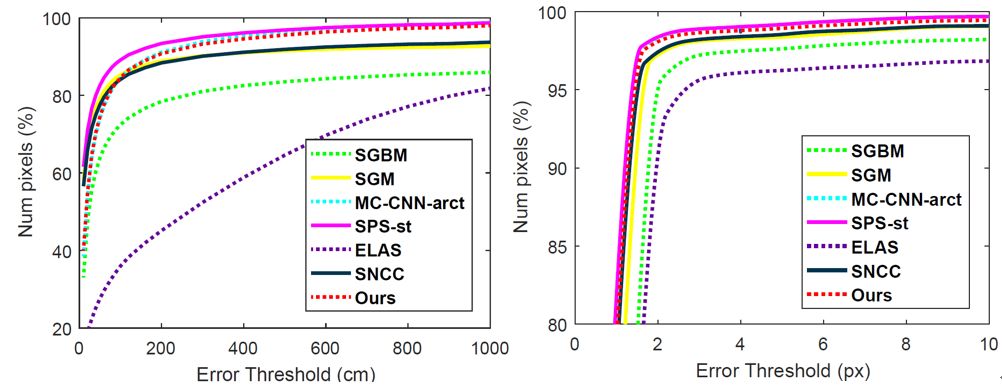

圖2:像素級(jí)別精度對比(左:KITTI stereo,右:Middlebury)

表2:修改視差圖輸入在KITTI數(shù)據(jù)集上的精度結(jié)果

圖3:單幀地圖重建結(jié)果(自上而下分別為左圖,點(diǎn)云圖,

voxel地圖和Planecell地圖)

圖4:2000幀的重建結(jié)果(89.1MB)

我們在本文中提出了一種新穎的方法,用一種名為 Panecell 的基本平面單元來表示結(jié)構(gòu)三維空間。平面單元以深度感知方式提取,并且如果它們屬于應(yīng)用所提出的CRF模型的相同表面,則可以進(jìn)一步聚合。實(shí)驗(yàn)表明,我們的方法考慮了像素級(jí)精度,同時(shí)有效地表達(dá)了相似像素的位置。結(jié)果避免了點(diǎn)云映射的冗余,并限制了輸出映射大小以用于進(jìn)一步的應(yīng)用。在我們未來的工作中,我們計(jì)劃開發(fā)更復(fù)雜的平面模型,如球體和圓柱體,以適應(yīng)更多條件。我們還相信,給每個(gè)平面單元一個(gè)語義標(biāo)簽可以更有效地?cái)U(kuò)展對環(huán)境的理解。

-

傳感器

+關(guān)注

關(guān)注

2551文章

51177瀏覽量

754281 -

無人駕駛

+關(guān)注

關(guān)注

98文章

4068瀏覽量

120593

原文標(biāo)題:IV 2018 最佳學(xué)生論文獎(jiǎng)丨西交大“基于硬件在環(huán)的無人駕駛仿真平臺(tái)”論文獲最佳

文章出處:【微信號(hào):IV_Technology,微信公眾號(hào):智車科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

相關(guān)推薦

東華軟件:多地無人駕駛項(xiàng)目成功落地

UWB模塊如何助力無人駕駛技術(shù)

特斯拉推出無人駕駛Model Y

【干貨分享】硬件在環(huán)仿真(HiL)測試

文遠(yuǎn)知行無人駕駛掃路機(jī)在廣東汕頭落地

5G賦能車聯(lián)網(wǎng),無人駕駛引領(lǐng)未來出行

EasyGo使用筆記丨分布式光伏集群并網(wǎng)控制硬件在環(huán)仿真應(yīng)用

EasyGo使用筆記丨分布式光伏集群并網(wǎng)控制硬件在環(huán)仿真應(yīng)用

中國或支持特斯拉測試無人駕駛出租

【分享】基于Easygo仿真平臺(tái)的三電機(jī)實(shí)時(shí)仿真測試應(yīng)用

32.768K晶振X1A000141000300適用于無人駕駛汽車電子設(shè)備

5G車載路由器引領(lǐng)無人駕駛車聯(lián)網(wǎng)應(yīng)用

詳解快速控制原型RCP與硬件在環(huán)仿真HIL

基于硬件在環(huán)的無人駕駛仿真平臺(tái)

基于硬件在環(huán)的無人駕駛仿真平臺(tái)

評(píng)論