YannLecun曾贊譽(yù)GAN為“近十年來(lái)機(jī)器學(xué)習(xí)領(lǐng)域最有趣的想法”,一經(jīng)提出便受萬(wàn)眾矚目。伴隨著研究的逐步深入,GAN已然衍生出了多種多樣的形態(tài)。Crazymuse AI近期在Youtube中推出一個(gè)視頻,介紹了十大GAN背后的數(shù)學(xué)原理。本文便帶領(lǐng)讀者盤點(diǎn)一下這些各具特色的GAN。

我不用監(jiān)督—InfoGANs

InfoGAN是生成對(duì)抗網(wǎng)絡(luò)信息理論的擴(kuò)展,能夠以完全非監(jiān)督的方式得到可分解的特征表示。它可以最大化隱含(latent)變量子集與觀測(cè)值之間的互信息(mutual information),并且發(fā)現(xiàn)了有效優(yōu)化互信息目標(biāo)的下界。

具體案例:

成功分解了MNIST數(shù)據(jù)集中數(shù)字形狀的手寫風(fēng)格特征;

在一個(gè)3D人臉數(shù)據(jù)集中,使用多個(gè)連續(xù)的編碼,得到一些不同的特征:人臉的轉(zhuǎn)向、人臉的仰角、人臉的寬窄以及圖片亮度;

在SVHN數(shù)據(jù)集中,得到不同特征可以分解數(shù)字在圖像中的亮度以及區(qū)分圖像中不同的數(shù)字;

在CelebA數(shù)據(jù)集中,同樣的可以通過(guò)不同的編碼獲取一些特征,比如人臉不同的轉(zhuǎn)向角度,是否帶了眼鏡,發(fā)型的不同,情緒的變化。

InfoGANs最大的好處就是不需要監(jiān)督學(xué)習(xí)以及大量額外的計(jì)算花銷就能得到可解釋的特征。

相對(duì)的力量—Relativistic GANs

Relativistic GANs是在Standard GAN的基礎(chǔ)上使用一個(gè)relativistic判別器(用來(lái)估計(jì)“給定的真實(shí)數(shù)據(jù)”比“隨機(jī)抽樣的假數(shù)據(jù)”更真實(shí)的概率)。同時(shí)該方法也證明了Standard GAN缺失了一個(gè)重要的基本特性,并且使用relativeistic判別器能夠讓任何都變得GAN更加穩(wěn)定。

具體案例:

在含有2011張(256x256)圖片的小樣本集上進(jìn)行實(shí)驗(yàn),SGAN和LSGAN根本無(wú)法完成訓(xùn)練(它們?cè)诋a(chǎn)生噪聲的時(shí)候就停滯了),Spectral GAN和WGAN-GP的表現(xiàn)性能也是較差。而Relativistic GANs的實(shí)驗(yàn)結(jié)果是非常理想的。

因此relativism不僅能夠提高GAN的穩(wěn)定性,還能輸出更高質(zhì)量的數(shù)據(jù)樣本。

看我七十二變—CycleGANs

Image-to-image問題是一類視覺和圖像領(lǐng)域中的問題,其目標(biāo)是使用對(duì)齊圖像對(duì)(aligned image pairs)的訓(xùn)練集來(lái)學(xué)習(xí)輸入圖像和輸出圖像之間的映射。但是很多方法是無(wú)法使用成對(duì)的訓(xùn)練數(shù)據(jù)的。而CycleGANs就能解決這個(gè)問題。其大致思路是:學(xué)習(xí)一個(gè)映射G:X→Y,使用對(duì)抗性損失(adversarial loss)讓來(lái)自G(X)的圖像分布與分布Y無(wú)法區(qū)分。因此這個(gè)映射是高度無(wú)約束的(under-constrained),將它與它的逆映射F:Y→X耦合,并引入一個(gè)循環(huán)一致性損失(cycle consistency loss)來(lái)推動(dòng)F(G(X))≈X(反之亦然)。

具體案例:

將莫奈的畫作轉(zhuǎn)換為照片;

將照片轉(zhuǎn)換為名家(莫奈、梵高、塞尚、浮世繪)風(fēng)格圖片;

目標(biāo)物體紋理互換;

圖像季節(jié)轉(zhuǎn)換;

照片增強(qiáng):景深狹窄。

最后與以往的幾種方法做了比較,證明了CycleGANs的優(yōu)越性。

你需要“注意力”—SAGANs

SAGANs全稱Self-Attention Generative Adversarial Network,在GAN生成中加入了attention的機(jī)制,同時(shí)將光譜歸一化(spectral normalization)應(yīng)用到生成器當(dāng)中。

具體案例:

將目前最好的Inception分?jǐn)?shù)從36.8分提高到了52.52分;將ImageNet數(shù)據(jù)集的Frechet Inception距離從27.62降低到18.65。

SAGANs將實(shí)驗(yàn)結(jié)果提到了一個(gè)新高度。

一步一個(gè)腳印—Progressive GANs

Progressive GANs是一種生成器和判別器逐層增長(zhǎng)的訓(xùn)練方法,從低分辨率圖像逐步生成高清圖。為了解決訓(xùn)練不穩(wěn)定的問題和不良競(jìng)爭(zhēng)問題,提出兩個(gè)trick:判別器加入一個(gè)minibatch stddev層、對(duì)生成器和判別器進(jìn)行歸一化。

具體案例:

在無(wú)人監(jiān)督的CIFAR10數(shù)據(jù)集中實(shí)現(xiàn)8.80的記錄初始得分。

該方法加速了訓(xùn)練速度,并且提高了穩(wěn)定性。

我用CNN—DCGANs

DCGANs采用CNN作為生成器和判別器的實(shí)現(xiàn)。更加強(qiáng)調(diào)在無(wú)監(jiān)督學(xué)習(xí)方面的應(yīng)用,或者更確切地,更關(guān)心在未標(biāo)注的大數(shù)據(jù)集上學(xué)習(xí)可用的特征表示。在圖片分類問題上展示了GAN方法可以取得和其他無(wú)監(jiān)督方法相同的性能。

具體案例:

在Large-scale Scene Understanding (LSUN)臥室數(shù)據(jù)集上訓(xùn)練了一個(gè)包含300多萬(wàn)個(gè)訓(xùn)練樣例的模型。展示了一個(gè)訓(xùn)練期間、模擬在線學(xué)習(xí)以及收斂后的樣本,證明模型不是通過(guò)簡(jiǎn)單過(guò)度擬合/記憶訓(xùn)練來(lái)產(chǎn)生高質(zhì)量樣本的。

在人臉數(shù)據(jù)集(包含10K個(gè)人,3M張圖像)上進(jìn)行實(shí)驗(yàn),運(yùn)行OpenCV人臉檢測(cè)器,并保持足夠高分辨率。

使用Imagenet-1k作為無(wú)人監(jiān)督訓(xùn)練的自然圖像的來(lái)源。 用32×32min-resized crps進(jìn)行訓(xùn)練。

利用DCGANs對(duì)上述各種圖像數(shù)據(jù)集進(jìn)行訓(xùn)練,并展示了數(shù)據(jù),證明我們的深度卷積對(duì)抗可以替代生成器和判別器。此外,將學(xué)習(xí)的特征用于其它新任務(wù),結(jié)果證明該方法具有適用性。

我很穩(wěn)定—WGANs

WGANs是傳統(tǒng)GAN訓(xùn)練的替代方案。 這個(gè)新模型可以提高學(xué)習(xí)的穩(wěn)定性,擺脫模式崩潰等問題,并提供對(duì)調(diào)試和超參數(shù)搜索有重要意義的學(xué)習(xí)曲線(learning curves)。 此外,相應(yīng)的優(yōu)化問題是合理的,進(jìn)一步顯示對(duì)應(yīng)的優(yōu)化問題合理性,并為分布間其它距離的深入關(guān)聯(lián)性提供理論工作。

具體案例:

生成圖像實(shí)驗(yàn)。學(xué)習(xí)的目標(biāo)分布是LSUN臥室數(shù)據(jù)集。用DCGAN作為基準(zhǔn)進(jìn)行比較。生成的圖像是64x64的3-channel圖像。

實(shí)驗(yàn)證明,“損失”對(duì)WGANs是非常重要的,并且WGANs能夠提高穩(wěn)定性。

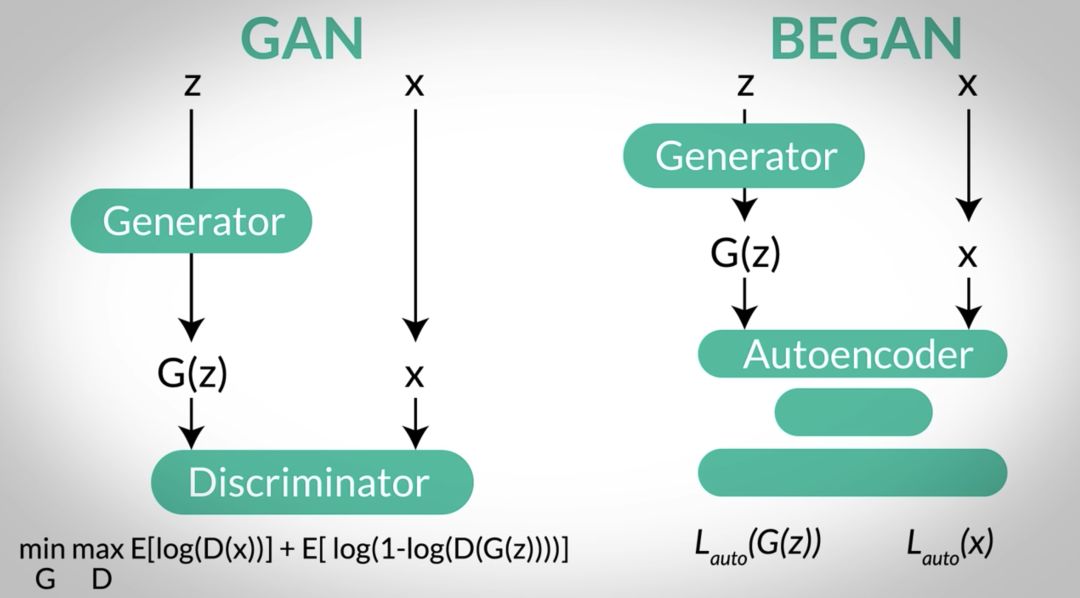

再創(chuàng)新高—BEGANs

BEGANs是一種新的均衡執(zhí)行的方法,該方法與從Wasserstein距離導(dǎo)出的損失相匹配,用于訓(xùn)練基于自動(dòng)編碼器的生成對(duì)抗網(wǎng)絡(luò)。 該方法在訓(xùn)練期間平衡發(fā)生器和判別器。 此外,它提供了一種新的近似收斂措施,快速穩(wěn)定訓(xùn)練和高視覺質(zhì)量。 并且還衍生出一種控制圖像多樣性和視覺質(zhì)量之間權(quán)重的方法。 即使在更高的分辨率下也能創(chuàng)造視覺質(zhì)量的新里程碑。

具體案例:

實(shí)驗(yàn)采用360K個(gè)名人的面部圖像數(shù)據(jù)集代替CelebA數(shù)據(jù)集。使用Adam訓(xùn)練我們的模型,初始學(xué)習(xí)率(learning rate)為0.0001,當(dāng)收斂的度量停止時(shí),衰減2倍。 實(shí)驗(yàn)訓(xùn)練了從32到256的不同分辨率的模型,并添加或刪除卷積層以調(diào)整圖像大小,保持恒定的最終下采樣圖像大小為8×8。

該方法至少部分地解決了一些突出的GAN問題,例如測(cè)量收斂、控制分布多樣性以及維持判別器和發(fā)生器之間的平衡等。

自動(dòng)編碼大法好—VAEGANs

我們提出了一個(gè)自動(dòng)編碼器,它利用學(xué)習(xí)的表示來(lái)更好地測(cè)量數(shù)據(jù)空間中的相似性。 通過(guò)將變分自動(dòng)編碼器(variational autoencoder)與生成對(duì)抗網(wǎng)絡(luò)相結(jié)合,可以使用GAN判別器中的學(xué)習(xí)特征表示作為VAE重建目標(biāo)的基礎(chǔ)。 因此,用feature-wise誤差替換element-wise誤差,以更好地捕獲數(shù)據(jù)分布。

具體案例:

將的方法應(yīng)用于面部圖像,并用VAEGANs在CelebA的面部圖像上進(jìn)行訓(xùn)練。該數(shù)據(jù)集由202,599個(gè)圖像組成,注釋有40個(gè)二進(jìn)制屬性,如眼鏡,劉海,蒼白皮膚等。

訓(xùn)練后的結(jié)果表明,普通的VAE能夠清晰地繪制臉部的正面部分,但偏離中心的圖像變得模糊;VAEDisl甚至偏離中心產(chǎn)生更清晰的圖像,因?yàn)橹亟ㄕ`差被提升到像素之外。相比之下,VAE / GAN可以產(chǎn)生更清晰的圖像。表明它在視覺保真度方面較優(yōu),具有元素相似性度量。此外,該方法可以使用簡(jiǎn)單的算法來(lái)修改高級(jí)抽象視覺特征(例如,佩戴眼鏡)。

處理序列我最強(qiáng)—SeqGANs

SeqGAN的提出是用來(lái)解決過(guò)去的GAN方法面對(duì)離散表征(discrete token)的生成序列時(shí),具有一定的局限性的問題。將數(shù)據(jù)生成器建模為強(qiáng)化學(xué)習(xí)(RL)中的隨機(jī)策略,SeqGAN通過(guò)直接執(zhí)行梯度策略更新來(lái)繞過(guò)生成器區(qū)分問題。 RL的reward信號(hào)來(lái)自在完整序列上判斷的GAN判別器,并且使用蒙特卡羅搜索(Monte Carlo search)傳遞回中間狀態(tài)。

具體案例:

分別與一種隨機(jī)表征生成模型、MLE、scheduled sampling以及Policy Gradient with BLEU (PG-BLEU)四種方法做比較。

文本生成:使用了16,394個(gè)中文絕句的語(yǔ)料庫(kù)(每個(gè)絕句包含四行,共20個(gè)字符),創(chuàng)作詩(shī)歌;使用了一個(gè)奧巴馬政治演說(shuō)的語(yǔ)料庫(kù)(11,092段),來(lái)生成政治演講。

音樂創(chuàng)作:使用諾丁漢(Nottingham)數(shù)據(jù)集作為訓(xùn)練數(shù)據(jù)(695個(gè)midi文件格式的民間音樂集合)。使用88個(gè)數(shù)字來(lái)表示88個(gè)音高(對(duì)應(yīng)于鋼琴上的88個(gè)音符)。 通過(guò)每0.4s的音高采樣,我們將midi文件轉(zhuǎn)換為1到88的數(shù)字序列,長(zhǎng)度為32。

根據(jù)對(duì)合成數(shù)據(jù)和實(shí)際廣泛的實(shí)驗(yàn)證明,Seq GANs與強(qiáng)基線(strong base-line)相比有了顯著的改進(jìn)。

以上就是十款各具特色的GANs,若需深入了解其數(shù)學(xué)原理,可點(diǎn)擊訪問下方鏈接:

1. InfoGANs

https://arxiv.org/abs/1606.03657

2. RelativisticGANs

https://arxiv.org/abs/1807.00734

3. CycleGANs

https://arxiv.org/abs/1703.10593

4. SAGANs

https://arxiv.org/abs/1805.08318

5. ProgressiveGANs

https://arxiv.org/abs/1710.10196

6. DCGANs

https://arxiv.org/abs/1511.06434

7. WGANs

https://arxiv.org/abs/1701.07875

8. BEGANs

https://arxiv.org/abs/1703.10717

9. VAEGANs

https://arxiv.org/abs/1512.09300

10. SeqGANs

https://arxiv.org/abs/1609.05473

-

GaN

+關(guān)注

關(guān)注

19文章

1933瀏覽量

73288 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8406瀏覽量

132567 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24689

原文標(biāo)題:【GAN大盤點(diǎn)】十款神奇的GAN,總有一個(gè)適合你!

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

深入了解DSP

GraphSAGEGNN算法的數(shù)學(xué)原理是什么?

變壓變頻調(diào)速的數(shù)學(xué)原理是什么

示波器的深入了解

是十款各具特色的GANs,深入了解其數(shù)學(xué)原理

是十款各具特色的GANs,深入了解其數(shù)學(xué)原理

評(píng)論