本文主要是回答激活函數(shù)的使用

我們認(rèn)識(shí)的激活函數(shù)中sigmoid、ReLU等,今天就是要講解一下這些函數(shù)的一些性質(zhì)

激活函數(shù)通常有一些性質(zhì):

非線性:當(dāng)激活函數(shù)是線性的時(shí)候,一個(gè)兩層的神經(jīng)網(wǎng)絡(luò)就可以基本逼近所有的函數(shù),但是,如果激活函數(shù)是恒等激活函數(shù)的時(shí)候,就不滿足這個(gè)性質(zhì)了,而且如果MLP使用的是恒等激活函數(shù),那么其實(shí)整個(gè)網(wǎng)絡(luò)跟單層神經(jīng)網(wǎng)絡(luò)是等價(jià)的

可微性:當(dāng)優(yōu)化方法是基于梯度的時(shí)候,這個(gè)性質(zhì)是必須的

單調(diào)性:當(dāng)激活函數(shù)是單調(diào)的時(shí)候,這個(gè)性質(zhì)是必須的

f(x)≈x:當(dāng)激活函數(shù)滿足這個(gè)性質(zhì)的時(shí)候,如果參數(shù)的初始化是random的很小的值,那么神經(jīng)網(wǎng)絡(luò)的訓(xùn)練將會(huì)很高效;如果不滿足這個(gè)性質(zhì),那么就需要很用心的去設(shè)置初始值

輸出值的范圍:當(dāng)激活函數(shù)輸出值是有限的時(shí)候,基于梯度的優(yōu)化方法會(huì)更加穩(wěn)定,因?yàn)樘卣鞯谋硎荆?dāng)激活函數(shù)的輸出是無(wú)限的時(shí)候,模型訓(xùn)練會(huì)更加的高效,不過(guò)在這種情況很小,一般需要一個(gè)更小的學(xué)習(xí)率

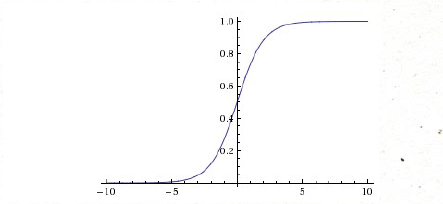

Sigmoid函數(shù)

Sigmoid是常用的激活函數(shù),它的數(shù)學(xué)形式是這樣,

當(dāng)如果是非常大的負(fù)數(shù)或者正數(shù)的時(shí)候,梯度非常小,接近為0,如果你的初始值是很大的話,大部分神經(jīng)元都出在飽和的情況,會(huì)導(dǎo)致很難學(xué)習(xí)

還有就是Sigmoid的輸出,不是均值為0為的平均數(shù),如果數(shù)據(jù)進(jìn)入神經(jīng)元的時(shí)候是正的(e.g.x>0elementwise inf=wTx+b),那么w計(jì)算出的梯度也會(huì)始終都是正的。

當(dāng)然了,如果你是按batch去訓(xùn)練,那么那個(gè)batch可能得到不同的信號(hào),所以這個(gè)問(wèn)題還是可以緩解一下的。因此,非0均值這個(gè)問(wèn)題雖然會(huì)產(chǎn)生一些不好的影響

tanh

和Sigmoid函數(shù)很像,不同的是均值為0,實(shí)際上是Sigmoid的變形

數(shù)學(xué)形式

與Sigmoid不同的是,tanh是均值為0

ReLU

今年來(lái),ReLU貌似用的很多

數(shù)學(xué)形式

ReLU的優(yōu)點(diǎn)

相比較其他的,ReLU的收斂速度會(huì)比其他的方法收斂速度快的多

ReLU只需要一個(gè)閾值就可以得到激活值,而不用去算一大堆復(fù)雜的運(yùn)算

也有一個(gè)很不好的缺點(diǎn):就是當(dāng)非常大的梯度流過(guò)一個(gè) ReLU 神經(jīng)元,更新過(guò)參數(shù)之后,這個(gè)神經(jīng)元再也不會(huì)對(duì)任何數(shù)據(jù)有激活現(xiàn)象了,所以我們?cè)谟?xùn)練的時(shí)候都需要設(shè)置一個(gè)比較合適的較小的學(xué)習(xí)率

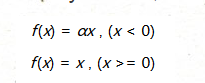

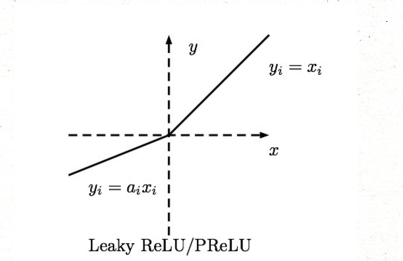

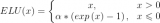

Leaky-ReLU、P-ReLU、R-ReLU

數(shù)學(xué)形式

f(x)=x,(x>=0)

這里的α是一個(gè)很小的常數(shù)。這樣,即修正了數(shù)據(jù)分布,又保留了一些負(fù)軸的值,使得負(fù)軸信息不會(huì)全部丟失

自己在寫(xiě)神經(jīng)網(wǎng)絡(luò)算法的時(shí)候還沒(méi)嘗試過(guò)這個(gè)激活函數(shù),有興趣的同學(xué)可以試試效果

對(duì)于 Leaky ReLU 中的α,通常都是通過(guò)先驗(yàn)知識(shí)人工賦值的。

然而可以觀察到,損失函數(shù)對(duì)α的導(dǎo)數(shù)我們是可以求得的,可不可以將它作為一個(gè)參數(shù)進(jìn)行訓(xùn)練呢?

不僅可以訓(xùn)練,而且效果更好。

如何去選擇

目前業(yè)界人都比較流行ReLU,

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4771瀏覽量

100714 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4327瀏覽量

62573

原文標(biāo)題:BP神經(jīng)網(wǎng)絡(luò)常用激活函數(shù)

文章出處:【微信號(hào):AI_shequ,微信公眾號(hào):人工智能愛(ài)好者社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

sigmoid函數(shù)波形

多輸出Plateaued函數(shù)的密碼學(xué)性質(zhì)

Sigmoid函數(shù)的擬合法分析及其高效處理

ReLU到Sinc的26種神經(jīng)網(wǎng)絡(luò)激活函數(shù)可視化大盤(pán)點(diǎn)

13種神經(jīng)網(wǎng)絡(luò)激活函數(shù)

一些人會(huì)懷疑:難道神經(jīng)網(wǎng)絡(luò)不是最先進(jìn)的技術(shù)?

PyTorch已為我們實(shí)現(xiàn)了大多數(shù)常用的非線性激活函數(shù)

在PyTorch中使用ReLU激活函數(shù)的例子

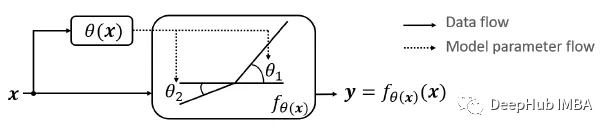

Dynamic ReLU:根據(jù)輸入動(dòng)態(tài)確定的ReLU

激活函數(shù)中sigmoid、ReLU等函數(shù)的一些性質(zhì)

激活函數(shù)中sigmoid、ReLU等函數(shù)的一些性質(zhì)

評(píng)論