編者按:UW-Madison統計學助理教授Sebastian Raschka簡明扼要地概述了他的最新研究SAN(半對抗神經網絡)。SAN基于卷積自動編碼器進行受限優化:最大化某一分類器表現的同時最小化另一分類器表現。

簡要總結手頭的項目,和包括同事、學生在內的更一般的受眾分享,我覺得這是一個不錯的主意。因此,我給自己的挑戰是用不到1000個單詞完成總結,避免讓具體細節和技術術語分散注意力。

本文主要討論了我最近和iPRoBe實驗室合作的研究項目,研發隱藏面部圖像的特定信息的技術。本文談論的是關于“保持可用性的同時最大化隱私”的研究(這一目標和差分隱私研究的目標有些類似)。

如果你對本文討論的研究項目感興趣,可以參考以下兩篇論文獲取更多信息:

Semi-Adversarial Networks: Convolutional Autoencoders for Imparting Privacy to Face Images(半對抗網絡:賦予面部圖像隱私的卷積自動編碼器,ICB 2018,arXiv:1712.00321)

Gender Privacy: An Ensemble of Semi Adversarial Networks for Confounding Arbitrary Gender Classifiers(性別隱私:對抗任意性別分類器的半對抗網絡集成,BTAS 2018,arXiv:1807.11936)

保持可用性的同時改善隱私

我們處理的研究問題可以看成一個更一般的受限優化問題:我們希望在保持計量生物學可用性的同時隱藏面部圖像的特定信息。具體來說,我們有三個目標:

擾亂性別信息

確保面部圖像看起來真實

保留計量生物學識別可用性

計量生物學識別包括兩種子任務:在一對多匹配中識別未知人物的身份(A)和在一對一匹配中驗證某人的身份(B):

這里,“擾亂”性別信息意思是給定的性別分類器不再能夠可靠地預測某人的性別。我們可以設想很多為什么需要防止自動提取個人屬性的理由。這里給出三個典型的例子:

基于性別的畫像

竊取身份(通過結合眾多可以公開獲取的資源)

在用戶不知情的情況下提取數據

無論何時,只要拍攝、上傳、(在中央數據庫中)儲存面部圖像,就可能引起上面提到的問題。作為反制措施,在銷售給第三方前,系統(例如,超市監控攝像頭)可以預配性別擾亂技術,使得最終用戶更難侵犯用戶的隱私,防止出于未經許可的目的收集數據。比如,隱藏面部圖像數據庫中的信息可能同時有助于確保GDPR合規。

半對抗網絡的一般用途

當然,我們輕而易舉就能隱藏性別數據,只需增加圖像噪聲或加擾到一定程度。然而,我們需要牢記的是顯著改動圖像可能同時讓面部圖像變得無用(計量生物學識別)。

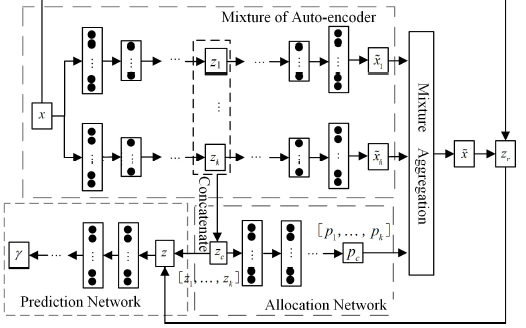

盡管我在上一節中突出了研發SAN的主要動機(保持可用性的同時改善隱私),SAN背后的主要思路可以看成更一般的方法,受限優化任意損失函數。這意味著SAN可以用于任何我們希望在最大化某一分類器的表現的同時最小化另一分類器的表現的問題。因此,即使你處理的不是面部識別問題,SAN同樣可能有助于解決你面臨的受限優化任務。

下一節將描述我們在ICB 2018提交的論文中的SAN總體架構。

半對抗網絡架構

根據我們在論文中提供的圖像,SAN的架構可能看起來有點晦澀,不過,如果我們將它分成三個主要部分,就比較直截了當:

擾亂輸入圖像的自動編碼器,確保圖像看起來接近原圖

能夠給出精確預測的面部匹配器

不能給出精確預測的性別分類器

SAN的訓練過程可以總結為以下的PyTorch(偽)代碼:

ae = AutoEncoder()

gc = GenderClassifier()

fm = FaceMatcher()

gc.load_state_dict(torch.load('saved_fm_model.pkl'))

fm.load_state_dict(torch.load('saved_gc_model.pkl'))

for fixed_model in (gc, fm):

for param in fixed_model.parameters():

param.requires_grad = False

optimizer = torch.optim.Adam(ae.parameters(), lr=learning_rate)

for epoch in range(num_total_epochs):

# ...

cost = loss_reconstruction + loss_gender_classification + loss_face_matching

cost.backward()

optimizer.step()

(完整代碼發布在GitHub倉庫iPRoBe-lab/semi-adversarial-networks) 注意,在評估SAN模型時,不僅使用了未見面部圖像數據集,同時還丟棄了訓練中使用的性別分類器和面部匹配器,使用了一組未見面部匹配器和性別分類器。

致好奇名字由來的讀者,下圖解釋了為何我們將這一配置稱為半對抗:

多樣性和概括性

正如我們的BTAS 2018論文提到的,我們最近致力于通過增強數據集等措施改善原SAN模型的概括性表現。例如,為了避免Buolamwini等在Gender shades: Intersectional accuracy disparities in commercial gender classification(性別陰影:商業性別分類器的區際差異)中討論的偏差,我們過采樣了深膚色個體的隨機樣本(在大多數面部數據集中為少數類別),以緩解潛在的偏差。此外,我們擴展了評估組合,引入了更多的未見性別分類器和面部匹配器。

后續

正如論文中提到的,目前還有很多方面有待探索,比如不同的集成方案,多屬性擴展等。

本文大致介紹了我們在SAN和差分隱私方面的一些研究。更多研究成果即將發表。同時,我們很興奮,能在今年秋季的BTAS 2018(10月22日-25日,洛杉磯)會議上呈現我們的最新結果,以及在ODSC West 2018(10月31日-11月3日)上報告我們的研究。

-

編碼器

+關注

關注

45文章

3649瀏覽量

134745 -

神經網絡

+關注

關注

42文章

4773瀏覽量

100890 -

分類器

+關注

關注

0文章

152瀏覽量

13200

原文標題:安能辨我是雄雌:半對抗神經網絡如何迷惑性別分類器

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

[轉]LabVIEW實現窗口最大化和最小化

如何用labview實現最大化最小化關閉菜單

labview獲取【顯示器分辨率】并實時設置界面【最大化】和【最小化居中】

HDMI一分二,一分四;DVI一分二,一分四

如何才能將網線一分為二?

如何使用深度神經網絡技術實現機器學習的全噪聲自動編碼器

一種混合自動編碼器高斯混合模型MAGMM

SAN基于卷積自動編碼器進行受限優化:最大化某一分類器表現的同時最小化另一分類器表現

SAN基于卷積自動編碼器進行受限優化:最大化某一分類器表現的同時最小化另一分類器表現

評論